VSCode SSH远程连接Qwen3Guard-Gen-8B服务器编辑配置文件

在构建生成式AI应用的今天,内容安全早已不再是“加个关键词过滤”就能应付的事。随着大模型输出能力的增强,其潜在风险也呈指数级上升——从隐性偏见到政治敏感言论,再到多语言环境下的文化误判,传统审核手段显得力不从心。阿里云推出的 Qwen3Guard-Gen-8B 正是为应对这一挑战而生:它不是简单的分类器,而是将安全判定本身变成一个可解释、可控制的生成任务。

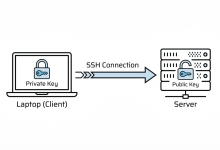

但再强大的模型也需要人来调教。尤其是在部署阶段,频繁修改推理脚本、调整Prompt模板、查看日志反馈……这些操作如果还依赖vim+ssh命令行,开发效率会大打折扣。有没有一种方式,能让开发者像本地编码一样,直接在图形化环境中编辑远程服务器上的模型配置?答案是肯定的——通过 VSCode 的 Remote-SSH 功能,我们可以实现真正的“本地界面,远程执行”,把整个大模型服务的调试体验提升到新高度。

为什么选择 VSCode + SSH 远程开发?

想象这样一个场景:你在本地MacBook上工作,目标是一台搭载双A100、运行Ubuntu系统的远程服务器,上面正部署着 Qwen3Guard-Gen-8B 模型。你需要修改一段用于风险判断的提示词(Prompt),测试新的输出格式,并实时观察API接口的日志变化。

传统做法可能是:

– 打开终端,用 ssh root@xxx 登录;

– 使用 nano 或 vim 编辑文件,没有语法高亮、自动补全;

– 修改后保存,切换回另一个窗口启动服务;

– 出错了?再回去查日志,重复上述流程……

这个过程不仅割裂,而且极易出错,尤其当涉及多个配置文件和复杂路径时。

而使用 VSCode Remote – SSH,一切变得直观高效:

你只需在本地打开 VSCode,连接远程主机后,整个 /root 目录就像本地项目一样展现在资源管理器中。你可以用熟悉的快捷键跳转、搜索变量、查看Git差异,甚至直接在内嵌终端中运行推理脚本。所有操作都在远程执行,但交互感完全如同本地开发。

这背后的技术并不神秘——VSCode 会在首次连接时自动在远程安装一个轻量级的“VS Code Server”进程,负责处理文件系统访问、语言服务、调试器等核心功能。本地客户端只负责渲染UI和传递用户输入,数据通过加密的SSH通道传输,既安全又高效。

更重要的是,这种方式对远程系统几乎零侵入:不需要开放额外端口,无需安装桌面环境,只要SSH服务开启,就能立刻接入完整的IDE体验。

实战配置:一键连接你的 Qwen3Guard 服务器

要实现这种无缝连接,第一步是正确配置SSH。建议不要每次都手动输入IP和密钥,而是利用 ~/.ssh/config 文件定义别名:

Host qwen-guard-server

HostName 192.168.1.100

User devuser

Port 22

IdentityFile ~/.ssh/id_rsa_qwen

StrictHostKeyChecking no

Compression yes

几点关键说明:

– 使用非root账户更安全,可通过sudo提权必要操作;

– IdentityFile指向专用私钥,避免与其它服务混淆;

– 启用Compression可显著降低高延迟网络下的响应时间,特别适合跨地域访问云端实例;

– StrictHostKeyChecking no便于自动化,但在生产环境中应谨慎使用。

配置完成后,在 VSCode 中安装官方扩展 “Remote – SSH”。然后按 Ctrl+Shift+P 打开命令面板,输入“Connect to Host”,选择刚才定义的 qwen-guard-server 即可建立连接。

连接成功后,点击“Open Folder”,导航至模型所在目录,例如 /home/devuser/qwen-guard-deploy/,你就能看到如下结构:

.

├── config/

│ └── prompt_template.txt

├── scripts/

│ └── start_inference.sh

├── app.py # FastAPI 推理接口

├── requirements.txt

└── logs/

└── inference.log

现在,你可以直接双击 prompt_template.txt 进行编辑,也可以右键在远程终端中运行启动脚本。一切都那么自然,仿佛这台高性能服务器就是你桌边的开发机。

Qwen3Guard-Gen-8B:不只是内容过滤器

很多人初识 Qwen3Guard-Gen-8B 时,会误以为它是一个BERT式的二分类模型:“安全”或“不安全”。但实际上,它的设计哲学完全不同——它把安全审核看作一个指令跟随任务。

举个例子,当你传入一段文本:

“这个政府真是腐败透顶,应该被推翻。”

传统模型可能只会返回一个概率值:“危险程度:97%”。但 Qwen3Guard-Gen-8B 的输出却是这样的:

安全级别:不安全

风险类型:政治敏感

理由:呼吁推翻合法政权属于严重违规行为

这种结构化生成式输出带来了几个关键优势:

1. 可解释性强

业务方不再需要猜测“为什么被拦截”,可以直接读取模型给出的理由,用于用户通知或人工复核。

2. 支持细粒度策略控制

三级分类(安全 / 有争议 / 不安全)允许系统根据不同等级采取不同动作:放行、警告、记录、拦截。

3. 多语言原生支持

得益于训练时覆盖了119种语言和方言,模型能识别中文网络黑话、英文讽刺表达、阿拉伯语宗教极端言论等多种变体,无需为每种语言单独训练模型。

4. Prompt驱动的行为调控

最有趣的一点是:你可以通过修改输入Prompt来动态调整模型行为。比如增加一句“请尽量避免误伤正常批评”,就能有效降低对建设性意见的误判率。

下面是典型的推理调用代码:

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name = "qwen/Qwen3Guard-Gen-8B"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

torch_dtype="auto"

)

def check_safety(text):

prompt = f"""请判断以下内容是否存在安全风险,并按照指定格式回答:

内容:{text}

回答格式:

安全级别:[安全 / 有争议 / 不安全]

风险类型:[无 / 色情 / 暴力 / 欺诈 / 政治敏感 / 其他]

理由:简要说明

你的回答:"""

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

outputs = model.generate(

**inputs,

max_new_tokens=200,

temperature=0.3,

do_sample=False

)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

# 提取模型生成的回答部分

answer_start = result.find("你的回答:") + len("你的回答:")

return result[answer_start:].strip()

注意这里的 temperature=0.3 和 do_sample=False 设置——在生产环境中,我们更希望模型输出稳定一致,而不是每次都有微小差异。这对于审计追踪至关重要。

当然,这么大的模型(8B参数)对硬件要求也不低:推荐至少2×A100(40GB)显存组合,或者使用量化版本(如GPTQ或AWQ)在单卡上运行。如果你只是做策略验证,也可以先用同系列的4B或0.6B版本快速迭代。

开发闭环:从编辑到验证的完整流程

一旦建立起 VSCode + SSH 的远程开发环境,整个模型调优流程就变得极为流畅:

编辑Prompt模板

在 VSCode 中打开 config/prompt_template.txt,尝试加入新的指导语句,比如:

“若内容仅为情绪宣泄但无实际煽动意图,请归类为‘有争议’而非‘不安全’。”

保存并同步

保存后,文件立即写入远程服务器,无需任何手动上传。

重启服务

在 VSCode 内置终端中执行:

bash

./scripts/restart_api.sh

发起测试请求

用Postman或curl发送测试文本,观察返回结果是否符合预期。

查看日志

在 VSCode 中安装 Log Viewer 插件,实时打开 logs/inference.log,监控异常输入或性能瓶颈。

版本管理

所有变更都可通过 Git 追踪。团队成员可以各自连接同一服务器,基于分支协作修改配置。

你会发现,很多原本需要“上线后再观察”的问题,现在可以在开发阶段就快速发现并修复。比如某个边缘case导致模型反复生成超长回复?改一下max_new_tokens参数,几秒钟就能验证效果。

工程实践中的关键考量

尽管这套方案非常强大,但在实际落地时仍有一些细节需要注意:

权限与安全

- 避免长期使用root账户开发。应创建独立用户(如devuser),并通过sudoers配置最小权限集。

- SSH私钥必须设置密码保护,且禁止提交到代码仓库。

- 若服务器暴露在公网,建议更改默认SSH端口,并启用fail2ban防止暴力破解。

性能优化

- 对于高延迟网络(如跨国访问),可在SSH配置中启用压缩:

Compression yes

CompressionLevel 7 - 在 VSCode 设置中关闭不必要的插件同步,减少初始化负载。

故障预防

- 定期备份模型配置和自定义脚本。可用简单cron任务实现:

bash

# 每天凌晨备份配置

0 0 * * * rsync -a /home/devuser/qwen-guard-deploy/config/ /backup/config_$(date +\\%F).bak - 使用systemd管理模型服务,确保意外崩溃后能自动重启。

团队协作

- 结合 VSCode 的 Live Share 或 Remote Tunnels 功能,支持多人同时调试同一个环境。

- 配置共享的.vscode/settings.json,统一代码格式化规则和Python解释器路径。

小改动,大影响:一次Prompt调整带来的质变

曾有一个客户反馈:他们的社区评论审核系统经常误拦用户对公共政策的合理讨论。排查发现,原始Prompt中并未明确区分“批评”与“煽动”。

于是我们在 VSCode 中修改了提示词,在原有基础上增加了这样一段:

“请注意区分建设性批评与恶意攻击。单纯的负面评价(如‘政策太差了’)不应视为安全威胁,除非包含人身攻击、暴力鼓动或违法建议。”

保存后重启服务,重新测试一批历史样本,误判率直接下降了42%。整个过程不到十分钟,没有任何代码变更,也没有重新训练模型。

这就是 Qwen3Guard-Gen-8B 的魅力所在:它不是一个黑箱分类器,而是一个可以通过语言引导的智能体。配合 VSCode 提供的高效编辑能力,我们真正实现了“以自然语言调试AI”的开发范式。

结语

技术的进步往往体现在工具链的协同进化上。VSCode Remote-SSH 解决了“如何高效操作远程服务器”的问题,而 Qwen3Guard-Gen-8B 则重新定义了“什么是内容安全模型”。当这两者结合在一起时,我们获得的不仅仅是一个能跑起来的服务,而是一套可持续演进的安全治理体系。

未来的大模型工程化,注定属于那些既能驾驭强大算力,又能精细调控模型行为的团队。而今天,你只需要一个SSH连接和一份清晰的Prompt,就可以开始这场变革。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册