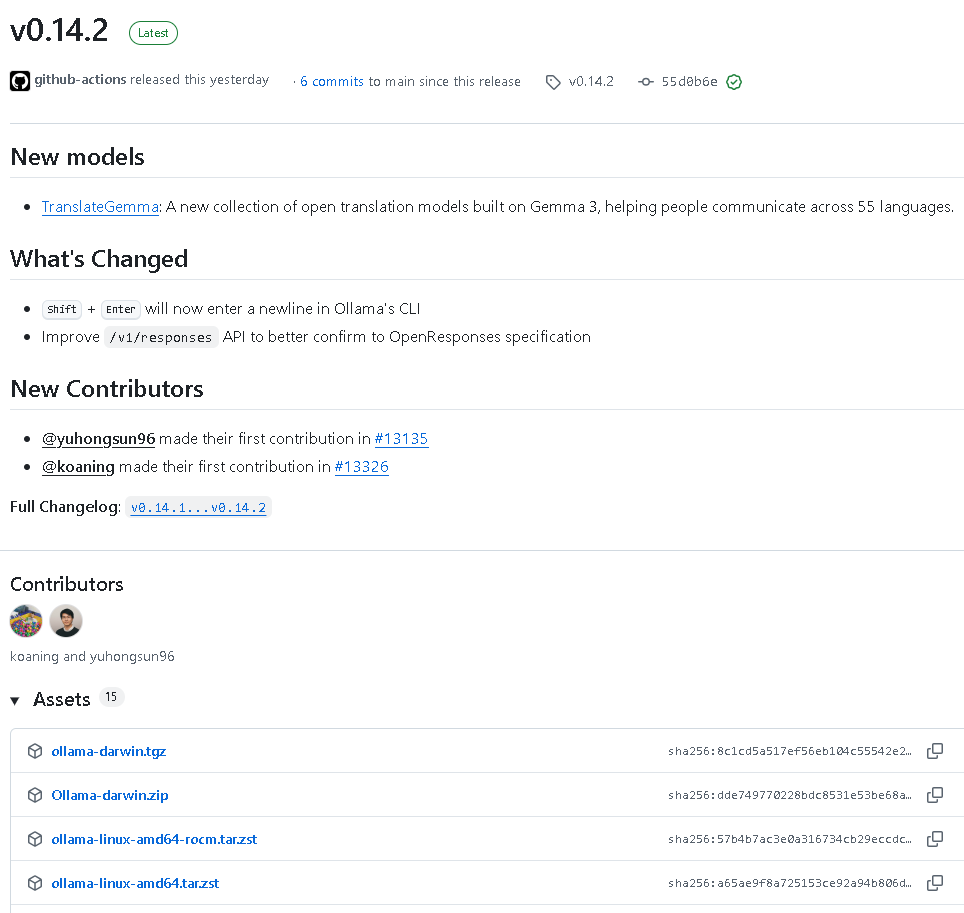

2026年1月16日,Ollama v0.14.2正式发布。这次版本更新不仅带来了新的翻译模型集,还在接口规范与交互体验上进行了大幅提升,进一步巩固了Ollama在开源大模型生态中的核心地位。以下是详细更新内容与技术亮点:

一、全新模型:TranslateGemma开放多语言翻译支持

Ollama v0.14.2推出了全新TranslateGemma模型系列。这一系列翻译模型基于Gemma 3架构构建,支持55种语言互译,旨在帮助全球用户打破语言壁障,实现跨语言交流。

TranslateGemma是Ollama针对跨语言任务优化的一类开放模型,标志着Ollama在多语言理解和生成能力上的进一步扩展。

二、功能优化与改进

1. CLI交互优化 —— 支持多行输入

Ollama命令行(CLI)现在新增了更简洁直观的交互方式:

- 按下 Shift + Enter 可换行输入;

- 普通 Enter 键则用于发送消息;

- 在交互模式中增加了新提示:“Press Enter to send”,让多行输入更自然。

这一改进使开发者编写长指令或复合Prompt更加方便,提升人机交互体验。

2. /v1/responses API优化

Ollama进一步改进了/v1/responses接口,使其更好地符合OpenResponses规范。该更新提升了API一致性与兼容性,对于使用Ollama搭建AI应用服务的开发者而言,这意味着更高的稳定性与标准化支持。

三、构建新指南:实验性MLX支持全面上线

此次版本新增了**“Building with MLX(experimental)”章节,为想要探索Ollama与MLX库(机器学习加速框架)**集成的开发者提供完整构建步骤。

构建过程包括:

编译MLX库:

cmake –preset MLX

cmake –build –preset MLX –parallel

cmake –install build –component MLX

编译带MLX功能的Ollama运行时:

go build -tags mlx -o ollama-mlx .

启动服务器:

./ollama serve

CUDA版本构建:

当需要使用CUDA加速时,可选用预设“MLX CUDA 13”或“MLX CUDA 12”:

cmake –preset 'MLX CUDA 13'

cmake –build –preset 'MLX CUDA 13' –parallel

cmake –install build –component MLX

这部分更新让Ollama更好地支持自定义加速和实验性运行环境,为AI开发者提供更多性能调优空间。

四、新增集成:Onyx与Marimo正式支持Ollama

v0.14.2在文档中正式新增两个关键集成支持,为用户提供更多使用场景。

1. Onyx 集成

Onyx是一个可自托管的聊天UI,现已无缝对接Ollama模型,支持:

- 定制智能代理;

- 网页搜索与深度研究;

- 文档与应用RAG检索;

- Google Drive、Slack等应用连接;

- 图片生成功能;

- 用户组管理、RBAC、SSO安全认证。

安装只需按照Onyx官方快速部署指南,选择Ollama作为LLM提供者,配置API地址即可完成接入(如Docker环境下使用http://host.docker.internal访问主机)。

2. Marimo 集成

Marimo是一款交互式Python笔记工具,支持通过Ollama提供AI功能:

- 在设置界面的AI标签中配置Ollama的Base URL(默认http://localhost:11434/v1);

- 开启与关闭指定模型;

- 新增模型;

- 支持内置AI聊天与代码自动补全。

通过简单配置后,即可在Marimo环境中调用Ollama提供的智能交互及推理服务。

五、Claude Code集成文档修订

Ollama官方完善了与Claude Code兼容的API文档,现需设置以下环境变量:

export ANTHROPIC_AUTH_TOKEN=ollama

export ANTHROPIC_BASE_URL=http://localhost:11434

export ANTHROPIC_API_KEY=ollama

或者直接运行:

ANTHROPIC_AUTH_TOKEN=ollama ANTHROPIC_BASE_URL=http://localhost:11434 ANTHROPIC_API_KEY=ollama claude –model qwen3-coder

此优化让 Claude Code 工具可顺利使用 Ollama 本地模型作为后端。

六、其他文档与库更新

此次更新还包括:

- 增加了Onyx、Marimo文档与多张集成截图;

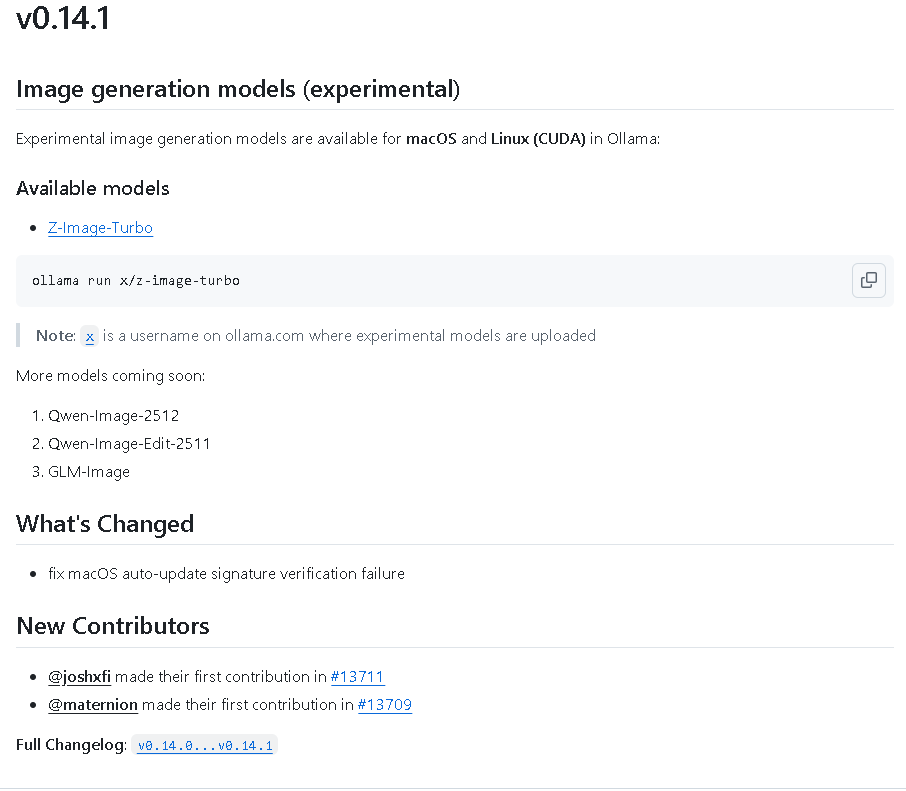

- 修复了旧版macOS自动更新签名验证问题;

- 更新**Observability(可观测性)**集成:新增Opik、Lunary、OpenLIT、MLflow Tracing的支持;

- README文档优化,新增MLX构建说明与相关项目链接;

- 代码层面优化了tool_test.go中ToolCallFunctionArguments API检测逻辑。

七、总结

代码地址:github.com/ollama/ollama

Ollama v0.14.2是一个集模型扩展、命令行体验优化、API规范化与环境构建指南于一体的版本。

不仅强化了多语言支持,还让开发者在本地构建、部署与集成第三方工具时更高效、更稳定。

网硕互联帮助中心

网硕互联帮助中心

![2026-02-12:完成一个任务的最早时间。用go语言,给你一个二维整数数组 tasks,数组中每个元素 [s_i, t_i] 表示一个任务在时间点 s_i 开始,并需要 t_i 个时间单位才能结束-网硕互联帮助中心](https://www.wsisp.com/helps/wp-content/uploads/2026/02/20260211224129-698d059935828-220x150.png)

评论前必须登录!

注册