摘要

2026年2月12日,支付宝宣布其AI原生支付产品\”AI付\”在上线一周内累计支付笔数突破1.2亿,成为全球首个支付笔数破亿的AI原生支付产品。本文深度解析这一里程碑背后的技术架构,通过完整的Golang代码实例,展示如何构建支撑亿级并发、毫秒级响应、金融级强一致的分布式支付系统。我们将在以下章节中详细探讨:

1. 背景与挑战

1.1 AI支付时代的到来

随着阿里千问App启动\”春节30亿免单活动\”,AI支付进入规模化商用阶段。用户通过自然语言与AI智能体交互完成支付,实现\”即说即付、对话内闭环\”的极致体验。这一变革对底层支付系统提出了前所未有的挑战:

- 亿级并发处理能力:单日峰值超过2000万笔,QPS需达12万笔/秒

- 毫秒级响应延迟:从意图识别到支付完成需在15毫秒内完成

- 金融级强一致性:支付事务的ACID保障不可妥协

- 智能风控实时决策:每笔交易需在3毫秒内完成风险判断

1.2 技术选型决策

基于上述挑战,我们选择Golang作为核心开发语言,原因如下:

- 原生并发支持:Goroutine + Channel模型天然适合高并发场景

- 卓越性能表现:内存占用低,GC优化成熟,延迟可预测

- 金融级生态完善:蚂蚁集团开源了丰富的金融中间件

- 云原生友好:与Kubernetes、Service Mesh等云原生技术深度集成

2. 系统架构全景

2.1 四层架构设计

2.1 四层架构设计

支付宝AI付系统采用分层架构设计,从上至下依次为:

// 架构层定义

type ArchitectureLayer string

const (

LayerAccess ArchitectureLayer = \”接入层\” // 亿级高并发接入与风控

LayerCoreService ArchitectureLayer = \”核心服务层\” // AI智能体协同调度引擎

LayerData ArchitectureLayer = \”数据处理层\” // 分布式数据存储与事务保障

LayerInfra ArchitectureLayer = \”基础设施层\” // 金融级分布式服务治理

)

// 系统架构配置

type SystemArchitecture struct {

Layers []ArchitectureLayer

Capacity CapacityConfig // 容量规划

Reliability ReliabilityConfig // 可靠性配置

Performance PerformanceConfig // 性能指标

Security SecurityConfig // 安全策略

}

2.2 核心组件布局

支付宝AI付亿级高并发支付系统架构

├── 接入层(亿级高并发接入与风控)

│ ├── 智能负载均衡:AI驱动的动态流量分发

│ ├── API安全网关:WAF+AI风控实时拦截

│ ├── 连接池优化:千万级TCP连接复用

│ └── 协议转换:HTTP/2→gRPC自动适配

├── 核心服务层(AI智能体协同调度引擎)

│ ├── 意图识别Agent:多模态支付意图理解

│ ├── 支付路由Agent:智能支付通道选择

│ ├── 风险决策Agent:毫秒级欺诈检测

│ └── 异步调度引擎:Goroutine池化调度

├── 数据处理层(分布式数据存储与事务保障)

│ ├── 用户数据库:MySQL集群分库分表

│ ├── 支付交易库:TiDB分布式事务

│ ├── 实时风控库:HBase+Phoenix

│ └── 账户缓存库:Redis Cluster高可用

└── 基础设施层(金融级分布式服务治理)

├── 配置中心:Nacos/Consul动态配置

├── 注册中心:Eureka+ZooKeeper

├── 链路追踪:SkyWalking+Jaeger

└── 监控告警:Prometheus+Grafana

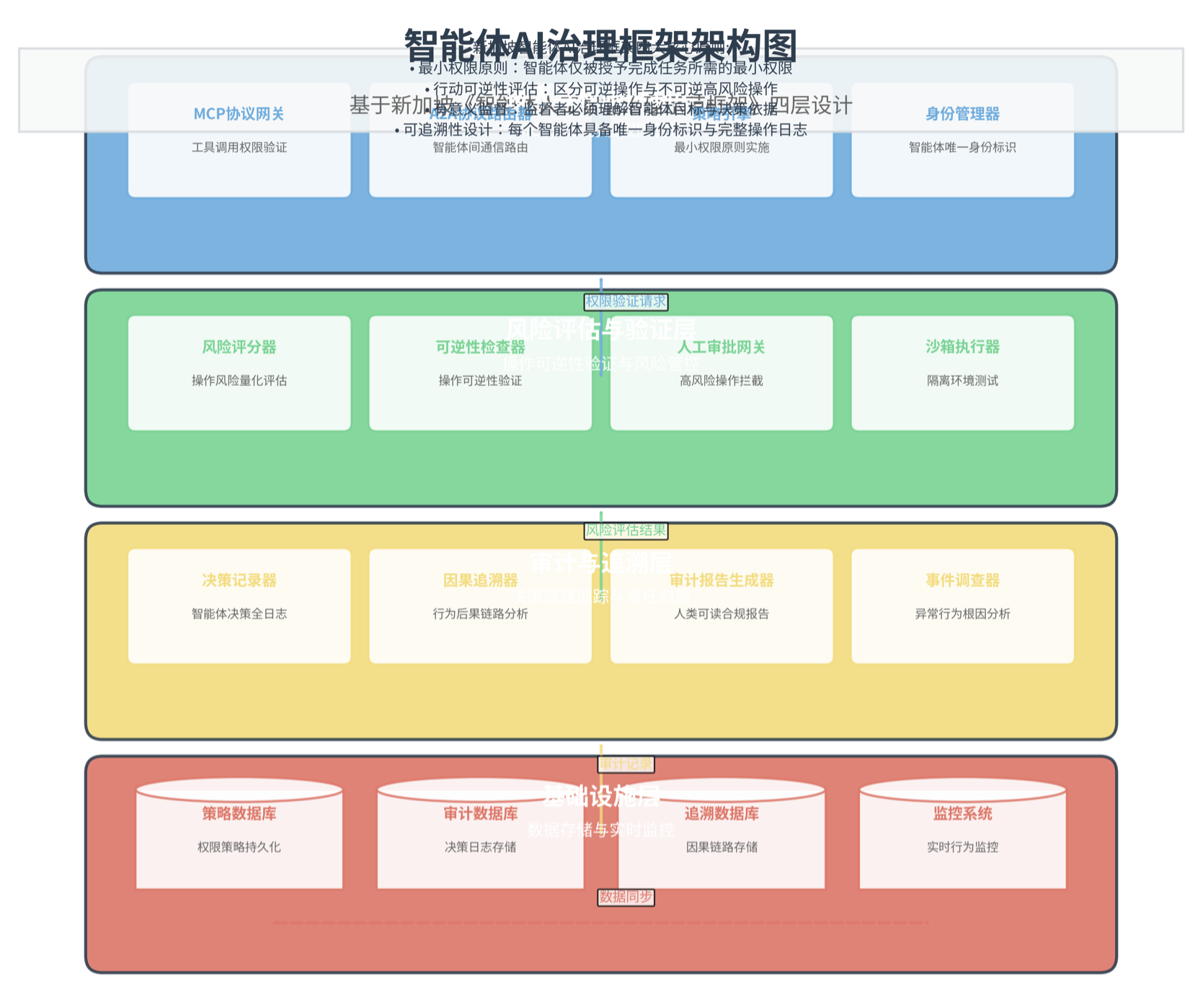

2.3 架构图展示

3. 核心组件实现

3.1 智能负载均衡器

// 智能负载均衡器

package loadbalancer

import (

\”context\”

\”fmt\”

\”math\”

\”sync\”

\”time\”

)

// LoadBalancerConfig 负载均衡配置

type LoadBalancerConfig struct {

HealthCheckInterval time.Duration // 健康检查间隔

LoadThreshold float64 // 负载阈值

DynamicScaling bool // 动态扩缩容

AIEnabled bool // AI智能调度

}

// ServerNode 服务器节点

type ServerNode struct {

ID string

Address string

CurrentLoad float64 // 当前负载 0-1

ResponseTime time.Duration // 平均响应时间

HealthStatus bool // 健康状态

LastCheck time.Time

mu sync.RWMutex

}

// AI调度算法

type AIScheduler struct {

Nodes []*ServerNode

HistoricalData []LoadHistory

PredictionModel interface{} // AI预测模型

// 学习参数

LearningRate float64

DiscountFactor float64

}

// LoadHistory 负载历史数据

type LoadHistory struct {

Timestamp time.Time

Load float64

Latency time.Duration

Success bool

}

// 智能路由选择

func (s *AIScheduler) SelectNode(requestType string) (*ServerNode, error) {

s.mu.RLock()

defer s.mu.RUnlock()

var candidates []*ServerNode

// 健康检查

for _, node := range s.Nodes {

if node.HealthStatus && node.CurrentLoad < 0.85 {

candidates = append(candidates, node)

}

}

if len(candidates) == 0 {

return nil, fmt.Errorf(\”no available nodes\”)

}

// AI权重计算

scores := make([]float64, len(candidates))

for i, node := range candidates {

// 负载因子(越低越好)

loadFactor := 1.0 – node.CurrentLoad

// 响应时间因子(越快越好)

latencyFactor := 1.0 / (1.0 + float64(node.ResponseTime.Milliseconds())/100)

// 历史表现因子

histScore := s.calculateHistoricalScore(node.ID)

// 组合评分(可调权重)

scores[i] = 0.4*loadFactor + 0.3*latencyFactor + 0.3*histScore

// 惩罚近期失败的节点

if time.Since(node.LastCheck) < 5*time.Minute && !node.HealthStatus {

scores[i] *= 0.7

}

}

// 选择最高分节点

maxScore := scores[0]

selectedIdx := 0

for i, score := range scores {

if score > maxScore {

maxScore = score

selectedIdx = i

}

}

return candidates[selectedIdx], nil

}

// 自适应权重调整

func (s *AIScheduler) adjustWeights(feedback LoadFeedback) {

// 强化学习:根据反馈调整权重

s.LearningRate = s.LearningRate * s.DiscountFactor

// 更新预测模型

s.updatePredictionModel(feedback)

}

// 动态扩缩容

func (s *A

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册