使用llama.cpp和ollama推理LFM2.5-1.2B模型

LFM2.5-1.2B模型是近期的明星模型 LFM2.5-1.2B-Instruct 是 Liquid AI 在 2026 年 1 月推出的开源、轻量级、高...

LFM2.5-1.2B模型是近期的明星模型 LFM2.5-1.2B-Instruct 是 Liquid AI 在 2026 年 1 月推出的开源、轻量级、高...

2026年1月26日,Ollama正式发布了 v0.15.2 版本。本次更新内容虽不多,但极具技术含量。它带来了全新的 Clawdb...

2026年1月16日,Ollama v0.14.2正式发布。这次版本更新不仅带来了新的翻译模型集,还在接口规范与交互体验上进行了大幅...

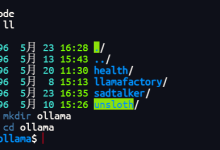

文章浏览阅读1k次,点赞36次,收藏17次。本文介绍了在4卡4090服务器上部署GraphRAG环境的过程。硬件配置包括双路至强金牌6148处理器、128GB内...

文章浏览阅读811次,点赞29次,收藏8次。本文详细介绍了在配备4块NVIDIA 4090显卡的高性能服务器上部署Ollama环境的全过程。内容包括:硬件配置(...

文章浏览阅读696次,点赞4次,收藏4次。银河麒麟服务器操作系统V10安装Nvidia显卡驱动和CUDA(L40)并安装ollama运行DeepSeek【开荒存...

文章浏览阅读5k次,点赞21次,收藏24次。通过上述步骤,你可以轻松地在Windows上配置Ollama服务,使其能够被局域网中的其他设备访问。具体操作包括:设...

文章浏览阅读768次,点赞15次,收藏4次。Win10专业版。

文章浏览阅读688次,点赞22次,收藏15次。新手小白参考csdn上其他博主完成,开始接到这个小任务连docker怎么用完全不知道,最开始是直接用官方ollam...

文章浏览阅读8.7k次,点赞22次,收藏30次。关于修改 Ollama 及其模型默认路径、迁移已安装的 Ollama 程序和模型以及重启 Ollama 的操作指...