@4卡4090服务器ollama环境部署、模型下载、模型调用及API接口调用

本人安装的硬件环境如下: CPU:intel至强金牌6148*2主频2.5G 共40核80线程 内存:三星32G DDR4服务器内存2933 *4=128GB 显卡:英伟达4090涡轮公版 *4 = 96G 操作系统:ubuntu 24.04 LTS conda:Anaconda 24.11.3

部署ollama环境

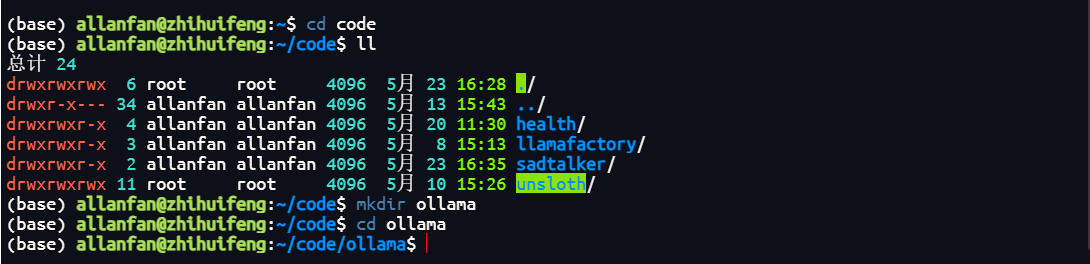

1.首先创建ollama环境的目录,用于接下的ollama模型库及代码统一管理;首先在系统根目录下创建ollama文件夹(当前我是在系统目录code下创建,具体目录文件夹根据个人需求在相对应目录下创建即可)。

创建目录命令

mkdir ollama

进入创建的目录命令

cd ollama

创建好如下图所示。

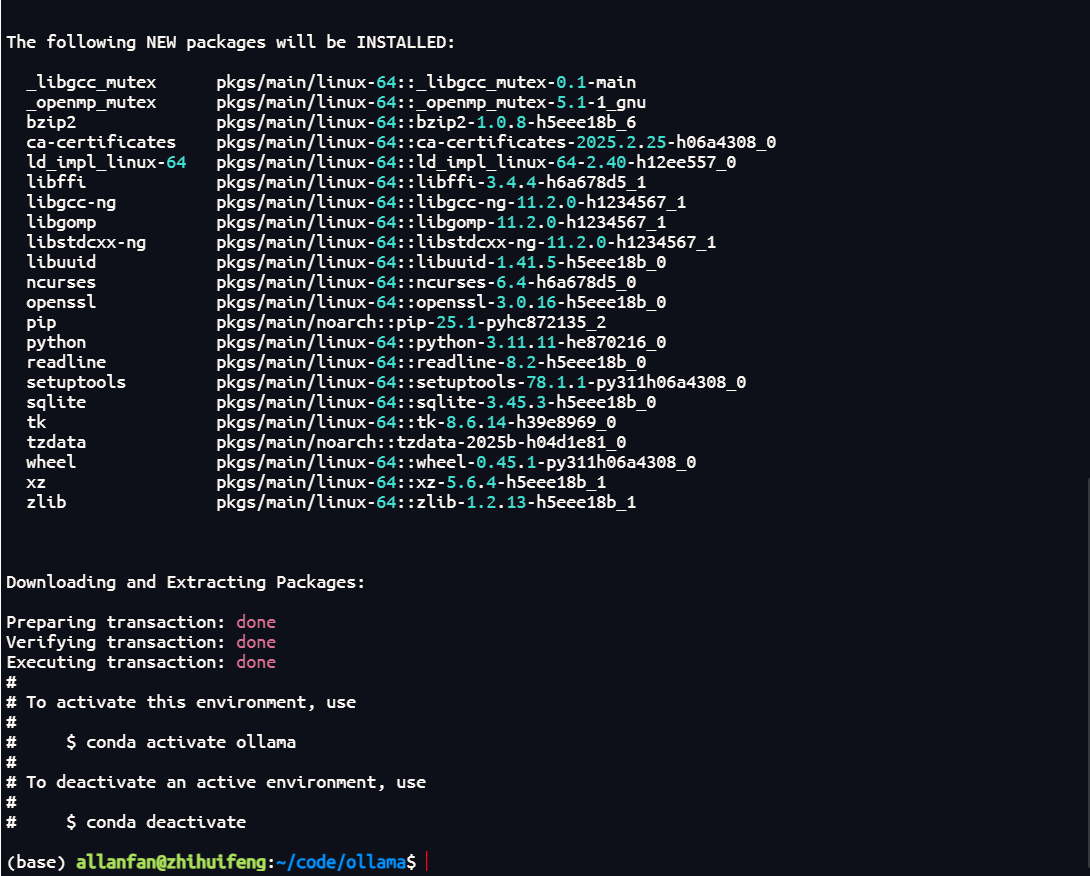

2.创建ollama虚拟环境,我选择的不是最新的,但是比较稳定的python3.12版本;加-y表示安装过程直接确认。

conda create -n ollama python=3.12 -y

具体安装完成如下图所示。

3.进入当前安装的ollama环境

3.进入当前安装的ollama环境

conda activate ollama

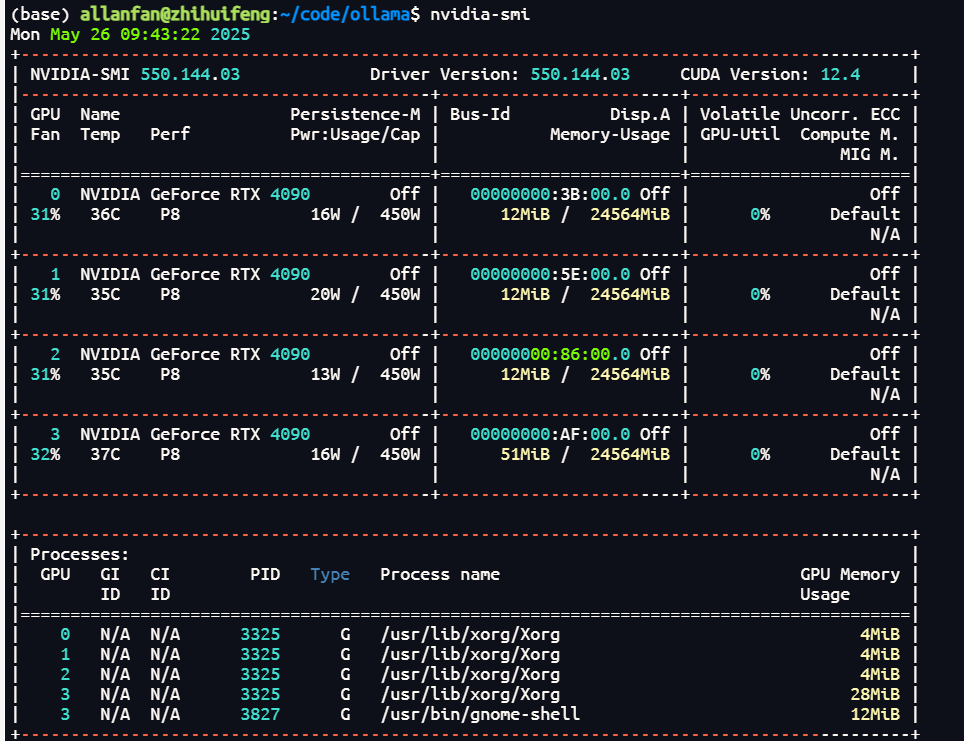

4.安装pytorch12.4依赖项,当前的cuda安装的是12.4,具体个人的cuda支持版本可运行nvidia-smi查看支持的版本,支持建议保持一致,如果无法保持一致,本人亲测可高一个版本,但不能低;具体查看cuda版本如下图所示。  4.1.离线下载及部署方案 离线下载地址:

4.1.离线下载及部署方案 离线下载地址:

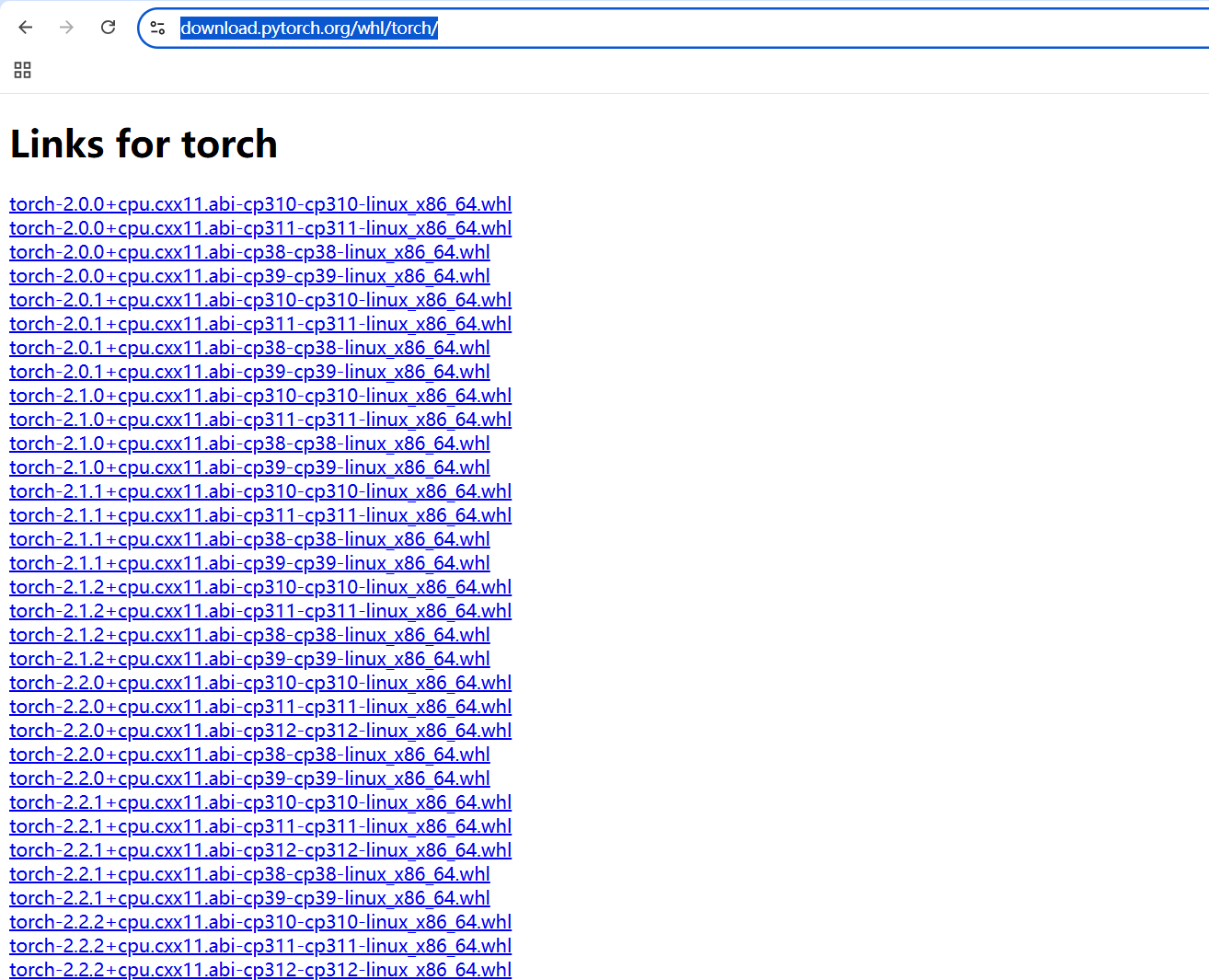

https://download.pytorch.org/whl/torch/

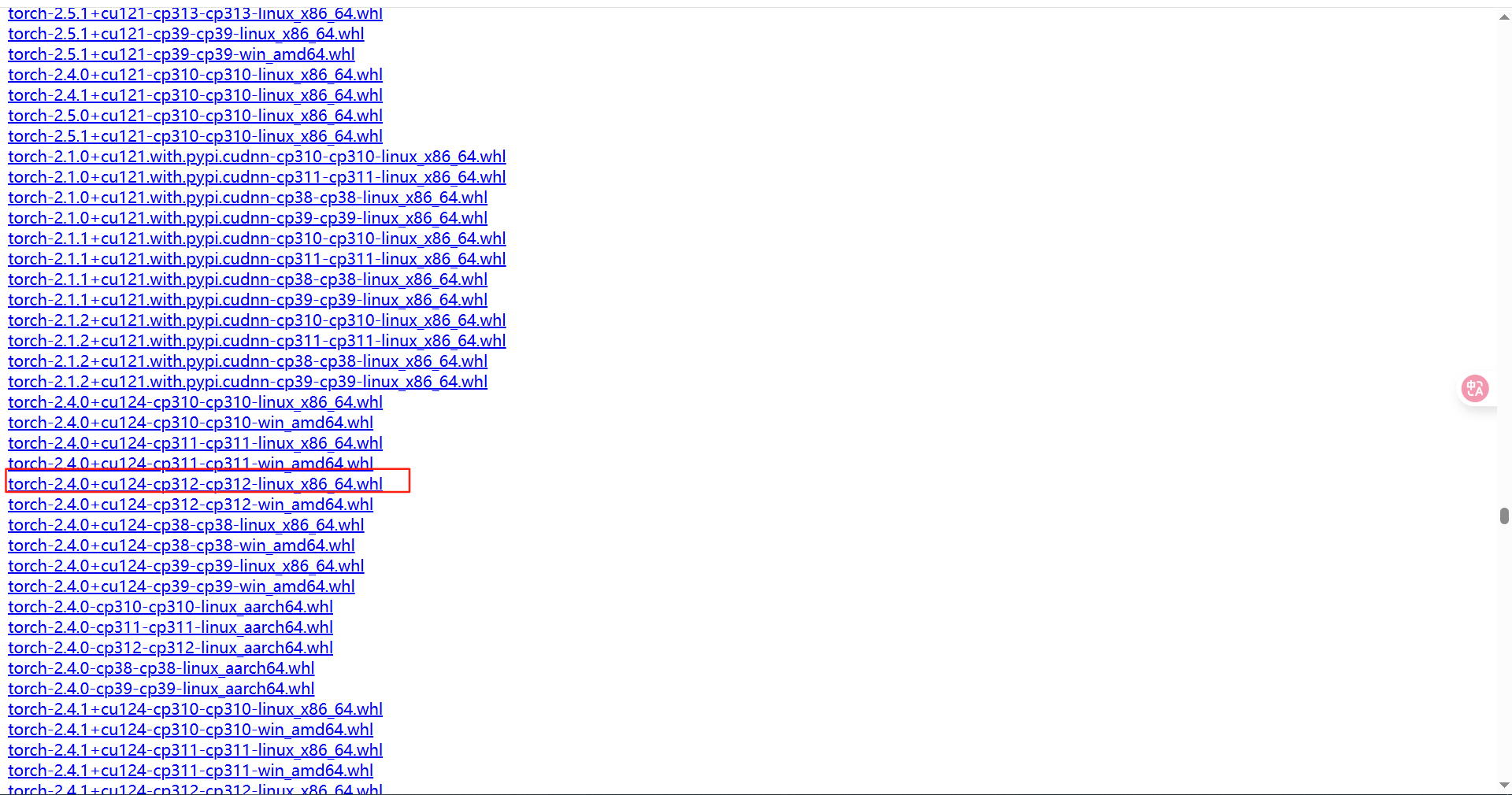

访问上面的网页具体显示内容如下图所示。

找到对应的cuda及python环境的文件,本项目环境操作系统是ubuntu、cuda是12.4及python是11.0,因此我的下载文件是torch-2.4.0+cu124-cp312-cp312-linux_x86_64.whl,具体文件如下图所示。  以下离线安装命令,注意下载文件在当前目录下。

以下离线安装命令,注意下载文件在当前目录下。

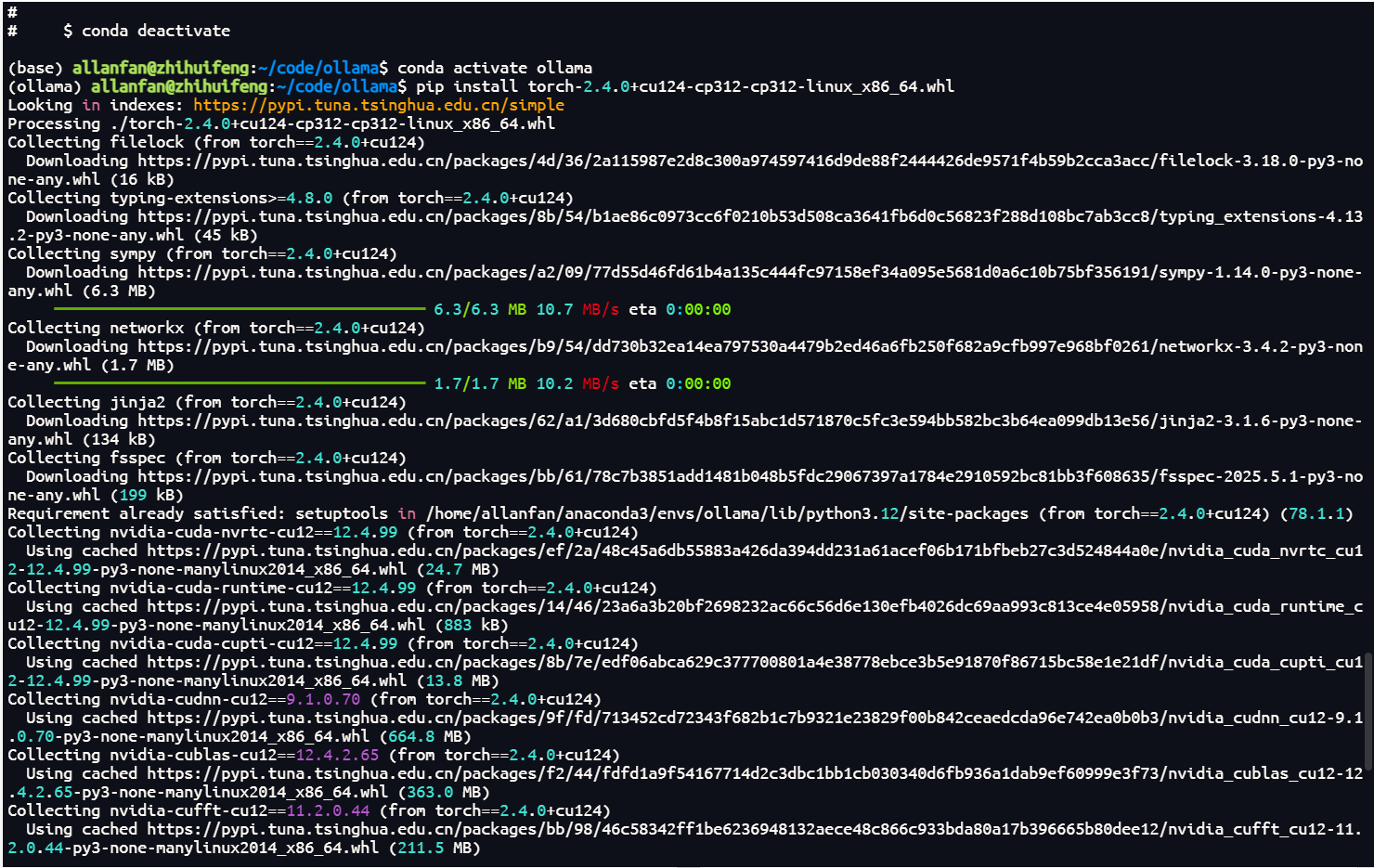

pip install torch-2.4.0+cu124-cp312-cp312-linux_x86_64.whl

安装如下图所示。

离线安装文件如果与我相同,可通过我分享的下载链接下载,如果CUDA不同只能在上面提供的链接去下载了。

离线安装文件如果与我相同,可通过我分享的下载链接下载,如果CUDA不同只能在上面提供的链接去下载了。

https://pan.baidu.com/s/1o0cMS710U15LldvfbiKkew?pwd=gg5g

4.2.在线安装方法,执行下面命令,本项目采用离线安装方法,在线方法之前安装过,也可以,本次分享就不执行及分享安装截图了。大家可以自己试试。

conda install pytorch==2.4.0 torchvision==0.19.0 torchaudio

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册