一套工具实现 AI 直播的技术落地:全能播 Live Omni 直播赋能平台

直播带货的规模化运营始终面临人力成本高、直播时长受限、内容输出不稳定等核心问题,尤其是在跨境电商、工厂展厅直播等场景中,对 “无人化...

直播带货的规模化运营始终面临人力成本高、直播时长受限、内容输出不稳定等核心问题,尤其是在跨境电商、工厂展厅直播等场景中,对 “无人化...

LFM2.5-1.2B模型是近期的明星模型 LFM2.5-1.2B-Instruct 是 Liquid AI 在 2026 年 1 月推出的开源、轻量级、高...

前言:2025年是大模型“百模大战”转入“推理落地”的关键一年。DeepSeek V3、Llama 3 70B 等开源权重的发布,让...

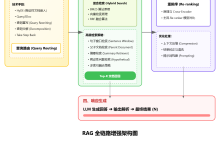

目录 RAG检索增强优化指南一、三代RAG架构对比1.1 架构演进时间线1.2 三代架构详细对比1.3 Naive RAG - 基础架构Python实现示例 1...

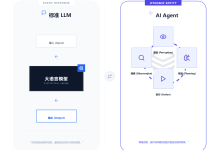

摘要: 随着大模型从“对话时代”迈向“任务执行时代”,智能体工作流(Agentic Workflow)已...

文章目录 一、LLAMA-Factory简介二、安装LLaMA-Factory三、准备训练数据四、模型训练1. 模型下载2. 全量微调3.lora微调4.QLo...

文章浏览阅读211次。简单来说,提示词工程是关于如何设计、优化和迭代输入给大语言模型的文本指令(即“提示词”),以引导模型生成期望输出的科学和艺术。LLM 本质...

文章浏览阅读1k次,点赞36次,收藏17次。本文介绍了在4卡4090服务器上部署GraphRAG环境的过程。硬件配置包括双路至强金牌6148处理器、128GB内...

文章浏览阅读786次,点赞5次,收藏13次。安装相应的依赖项。“可编辑” 模式意味着当你修改本地项目代码时,Python 环境会直接使用修改后的代码,而不需要重...

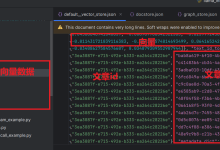

文章浏览阅读185次,点赞2次,收藏3次。此demo是自己提的一个需求:用modelscope下载的本地大模型实现RAG应用。毕竟大模型本地化有利于微调,RAG...