国产银河麒麟(arrch64)服务器+atlas300i pro 推理环境搭建

文章浏览阅读1.6k次,点赞22次,收藏18次。国产化信创项目开发,针对国产操作系统,国产CPU(鲲鹏920)、NPU(atals300ipro),包括硬件选型...

文章浏览阅读1.6k次,点赞22次,收藏18次。国产化信创项目开发,针对国产操作系统,国产CPU(鲲鹏920)、NPU(atals300ipro),包括硬件选型...

文章浏览阅读1.3k次,点赞20次,收藏8次。服务器繁忙是 DeepSeek 发展过程中面临的挑战,但也是其不断进步的动力。相信通过采取以上措施,DeepSee...

文章浏览阅读2.4k次,点赞23次,收藏41次。pycharm连接内网服务器必须通过跳板机,这种情况下pycharm的配置则比较复杂,需要使用ssh免密登录和s...

文章浏览阅读1k次,点赞19次,收藏32次。在某算力云平台上租用GPU,运行深度学习代码,包括如何如服务器建立连接,上传下载文件_ubuntu上如何租服务器跑代...

文章浏览阅读1.4k次,点赞17次,收藏9次。要根据计算任务的规模和复杂度确定所需内存容量,同时选择高速的内存类型,如 DDR4 或 DDR5,以提高数据传输速...

文章浏览阅读5.8k次,点赞25次,收藏105次。本人因为实验需要,经常在网上租服务。之前用过Autodl平台,也出了相关教程。因为Autodl上面的卡空闲的比...

文章浏览阅读1.5k次,点赞14次,收藏34次。对于个人开发者或尝鲜者而言,本地想要部署 DeepSeek 有很多种方案,但是一旦涉及到企业级部署,则步骤将会繁...

文章浏览阅读1k次,点赞8次,收藏11次。一、简单搭建环境首先从lerobot官网上来的便捷一些:一、安装condaminiconda或者anaconda都是可...

![[实验日志] VS Code 连接服务器上的 Python 解释器进行远程调试-网硕互联帮助中心](https://www.wsisp.com/helps/wp-content/uploads/2025/04/20250418103358-68022a96b333d-220x150.png)

文章浏览阅读2.5k次,点赞25次,收藏32次。PyCharm的缺点是:不能实时同步、操作繁琐,需要维护两份代码。而VS Code是通过SSH(Secure S...

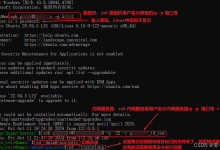

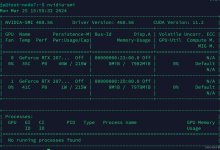

文章浏览阅读1.7w次,点赞25次,收藏6次。我这里有一台 从算法组借用的GPU服务器,里边是 两张。使用命令查看当前的nvidia-smi。Ubuntu18 ...