前言

欢迎加入开源鸿蒙跨平台社区:https://openharmonycrossplatform.csdn.net

flutter_speech的核心功能已经跑通了,但"能用"和"好用"之间还有一段距离。性能优化就是缩短这段距离的关键。

语音识别插件的性能主要体现在三个方面:响应速度(从点击到开始识别的延迟)、识别延迟(从说完话到出结果的时间)、资源消耗(CPU、内存、电量)。这三者往往需要权衡——更快的响应可能意味着更高的资源消耗。

今天分享一些实用的优化策略。

一、语音识别引擎复用策略

1.1 当前的问题

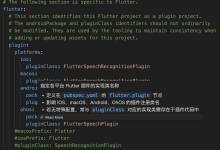

flutter_speech示例App每次点击Listen都会重新activate:

void start() => _speech.activate(selectedLang.code).then((_) {

return _speech.listen().then((result) {

setState(() => _isListening = result);

});

});

每次activate都会:

如果用户频繁使用语音识别,每次都重新创建引擎是很大的浪费。

1.2 引擎复用方案

// 改进:只在首次或语言变化时activate

String? _activatedLocale;

void start() async {

if (_activatedLocale != selectedLang.code) {

// 语言变化或首次使用,需要重新activate

await _speech.activate(selectedLang.code);

_activatedLocale = selectedLang.code;

}

// 直接listen,复用已有引擎

final result = await _speech.listen();

setState(() => _isListening = result);

}

1.3 原生端的配合

当前原生端每次activate都会创建新引擎。可以加一个引擎复用判断:

private async activate(locale: string, result: MethodResult): Promise<void> {

// 如果引擎已存在且语言相同,直接返回成功

if (this.asrEngine && this.currentLocale === locale) {

console.info(TAG, 'reusing existing engine');

this.channel?.invokeMethod('speech.onSpeechAvailability', true);

result.success(true);

return;

}

// 如果引擎存在但语言不同,先销毁

if (this.asrEngine) {

this.destroyEngine();

}

// 创建新引擎…

}

1.4 复用的收益

| 第1次识别 | ~2秒 | ~2秒 | 0 |

| 第2次识别(同语言) | ~2秒 | <100ms | ~1.9秒 |

| 第3次识别(同语言) | ~2秒 | <100ms | ~1.9秒 |

| 切换语言后 | ~2秒 | ~2秒 | 0 |

💡 引擎复用是最有效的优化。对于频繁使用语音识别的场景,可以将响应时间从2秒降到100毫秒以内。

二、VAD(Voice Activity Detection)参数调优

2.1 VAD参数回顾

const extraParam: Record<string, Object> = {

"recognitionMode": 0,

"vadBegin": 2000, // 等待开口超时

"vadEnd": 3000, // 静音停止超时

"maxAudioDuration": 60000

};

2.2 vadBegin调优

vadBegin影响"用户点击后到超时报错"的等待时间。

| 1000ms | 反应快但容易误超时 | 熟练用户、语音指令 |

| 2000ms | 平衡(默认) | 通用场景 |

| 3000ms | 宽容但等待久 | 老年用户、思考型输入 |

| 5000ms | 很宽容 | 特殊需求 |

2.3 vadEnd调优

vadEnd影响"用户说完后到返回结果"的等待时间。这是用户感知最明显的延迟。

| 1500ms | 快速响应但可能截断 | 短指令 |

| 2000ms | 较快 | 短句 |

| 3000ms | 平衡(默认) | 通用场景 |

| 5000ms | 允许长停顿 | 长句、思考型 |

🎯 调优原则:vadEnd越短,用户等待时间越短,但越容易在用户停顿时误判为"说完了"。需要根据实际场景找平衡点。

2.4 动态VAD调整

更高级的方案是根据用户行为动态调整VAD参数:

// 根据识别模式动态设置VAD

private getVadParams(mode: string): Record<string, Object> {

switch (mode) {

case 'command': // 语音指令模式

return { "vadBegin": 1500, "vadEnd": 1500, "maxAudioDuration": 10000 };

case 'dictation': // 听写模式

return { "vadBegin": 3000, "vadEnd": 5000, "maxAudioDuration": 300000 };

default: // 默认模式

return { "vadBegin": 2000, "vadEnd": 3000, "maxAudioDuration": 60000 };

}

}

三、采样率与音频质量的平衡

3.1 当前配置

const audioParam: speechRecognizer.AudioInfo = {

audioType: 'pcm',

sampleRate: 16000, // 16kHz

soundChannel: 1, // 单声道

sampleBit: 16 // 16bit

};

3.2 数据量对比

| 8kHz/8bit/mono | 8 KB/s | 480 KB | 差 |

| 16kHz/16bit/mono | 32 KB/s | 1.9 MB | 好(推荐) |

| 44.1kHz/16bit/mono | 88 KB/s | 5.3 MB | 好(浪费) |

| 44.1kHz/16bit/stereo | 176 KB/s | 10.6 MB | 好(更浪费) |

3.3 为什么不用更高采样率

16kHz已经覆盖了人类语音的主要频率范围(300Hz-3400Hz的基频,加上谐波到8kHz)。更高的采样率只会增加数据量,不会显著提升识别准确率。

语音识别模型通常在16kHz数据上训练,输入其他采样率的数据反而可能降低准确率(因为特征分布不同)。

3.4 网络带宽考虑

在线识别模式下,音频数据需要上传到云端。32 KB/s的数据率对于4G/5G/WiFi来说完全不是问题,但在弱网环境下可能会有延迟。

32 KB/s × 8 = 256 kbps

网络类型 带宽 是否足够

WiFi >10 Mbps ✅ 绰绰有余

4G >1 Mbps ✅ 足够

3G ~384 kbps ⚠️ 刚好够

2G ~64 kbps ❌ 不够

四、识别延迟优化:vadBegin / vadEnd 配置

4.1 延迟组成分析

从用户点击"Listen"到看到最终结果,总延迟由以下部分组成:

总延迟 = 引擎启动延迟 + 用户说话时间 + VAD等待时间 + 网络传输时间 + 服务端处理时间

| 引擎启动 | 100-500ms | ✅ 引擎复用 |

| 用户说话 | 1-10秒 | ❌ 用户决定 |

| VAD等待(vadEnd) | 1.5-5秒 | ✅ 参数调优 |

| 网络传输 | 100-500ms | ⚠️ 取决于网络 |

| 服务端处理 | 200-1000ms | ❌ 服务端决定 |

4.2 可优化的部分

引擎启动延迟:通过引擎复用可以从500ms降到<100ms。

VAD等待时间:这是最大的可优化项。默认vadEnd=3000ms意味着用户说完后要等3秒才能看到最终结果。

4.3 减少感知延迟

即使不能减少实际延迟,也可以减少感知延迟:

// 实时显示部分结果(flutter_speech已实现)

_speech.setRecognitionResultHandler((String text) {

setState(() => transcription = text); // 实时更新

});

4.4 手动stop vs VAD自动停止

| VAD自动停止 | +vadEnd时间 | 无需操作,但要等 |

| 手动stop | 无额外延迟 | 需要点击按钮 |

| 按住说话(PTT) | 无额外延迟 | 松手即停 |

“按住说话”(Push-to-Talk)模式可以完全消除VAD等待延迟,但需要修改UI交互。

五、内存占用监控与优化建议

5.1 内存占用来源

| FlutterSpeechPlugin实例 | <1 KB | App生命周期 |

| MethodChannel | ~10 KB | 引擎绑定期间 |

| SpeechRecognitionEngine | ~5-20 MB | activate到destroy |

| 音频缓冲区 | ~1-5 MB | 识别期间 |

| 网络连接 | ~100 KB | 在线识别期间 |

5.2 内存优化策略

策略1:及时释放引擎

如果用户长时间不使用语音识别,可以主动释放引擎:

// 页面不可见时释放引擎

void didChangeAppLifecycleState(AppLifecycleState state) {

if (state == AppLifecycleState.paused) {

// App进入后台,释放引擎

_speech.cancel();

// 可以通过MethodChannel调用destroy

} else if (state == AppLifecycleState.resumed) {

// App回到前台,按需重新activate

}

}

策略2:懒加载引擎

不在App启动时就activate,而是在用户第一次点击Listen时才activate:

void start() async {

if (!_speechRecognitionAvailable) {

// 首次使用,先activate

await _speech.activate(selectedLang.code);

}

await _speech.listen();

}

策略3:引擎复用+超时释放

复用引擎但设置超时,长时间不用就自动释放:

Timer? _engineReleaseTimer;

void resetEngineTimer() {

_engineReleaseTimer?.cancel();

_engineReleaseTimer = Timer(Duration(minutes: 5), () {

// 5分钟没使用,释放引擎

_activatedLocale = null;

// 通过MethodChannel调用destroy

});

}

5.3 内存监控

# 查看App内存使用

hdc shell hidumper -p <pid> –mem

# 持续监控

watch -n 2 "hdc shell hidumper -p <pid> –mem | head -20"

关注以下指标:

- PSS(Proportional Set Size):App实际占用的物理内存

- USS(Unique Set Size):App独占的物理内存

- RSS(Resident Set Size):App的常驻内存

5.4 内存泄漏检测

如果反复activate/destroy后内存持续增长,可能有泄漏:

第1次activate: PSS = 50 MB

第1次destroy: PSS = 45 MB (正常,有些缓存)

第2次activate: PSS = 55 MB

第2次destroy: PSS = 50 MB (正常)

第3次activate: PSS = 60 MB

第3次destroy: PSS = 58 MB ← 如果持续增长,可能有泄漏

六、综合优化方案

6.1 优化前后对比

| 首次识别延迟 | ~3秒 | ~3秒 | 无(首次无法优化) |

| 后续识别延迟 | ~3秒 | <500ms | 85% |

| VAD等待 | 3秒 | 2秒(场景化) | 33% |

| 空闲内存 | 20MB(引擎常驻) | 5MB(超时释放) | 75% |

| 感知延迟 | 高(等最终结果) | 低(实时部分结果) | 显著 |

6.2 优化优先级

总结

本文讲解了flutter_speech的性能优化实践:

下一篇我们讲单元测试与集成测试——如何验证flutter_speech的正确性。

如果这篇文章对你有帮助,欢迎点赞、收藏、关注,你的支持是我持续创作的动力!

相关资源:

- Core Speech Kit性能指南

- OpenHarmony内存管理

- VAD语音活动检测

- Flutter性能最佳实践

- flutter_speech OpenHarmony源码

- 开源鸿蒙跨平台社区

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册