一、 为什么你的 AI 是“人工智障”?

最近我们接到河北一家钢构厂的远程求助。 老板很恼火:“我们把焊接工艺规范都喂给 AI 了,为什么它还是告诉我‘焊接电流要调到 5000A’?这不把厂子炸了吗?”

我看了一眼他们的后台:直接把 PDF 扔进 Prompt 里,这就叫Token 溢出,模型根本记不住。

在成都无形者科技定义的“AI 赋能标准”里,企业级 AI 必须包含三个大脑:

基础大脑(LLM):负责说话好听(DeepSeek/GPT)。

外挂海马体(Vector DB):负责精准记忆(Milvus/Chroma)。

逻辑中枢(LangChain):负责把记忆和说话连起来。

不做 RAG,就是在这个架构里切掉了“海马体”,AI 当然会失忆、会瞎编。

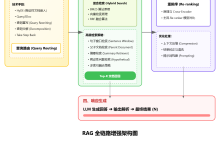

二、 工业级 RAG 架构设计(附架构图思路)

针对中小企业数据杂、服务器烂的特点,我们设计了一套轻量级 RAG 架构,目前这套方案正在全国十几家工厂的内网里跑着。

-

Embeddings:使用 bge-m3(国产之光,对中文工业术语理解极好)。

-

Vector DB:数据量 > 100万用 Milvus;数据量 < 10万用 Chroma。

-

LLM:DeepSeek-V3 或 Qwen-72B(通过 vLLM 部署)。

-

Orchestration:LangChain。

三、 核心代码拆解:手撸一条检索链

Talk is cheap. 下面展示我们如何用 Python 实现“先查后答”的核心逻辑。

1. 数据向量化与存储 (Milvus)

把工厂的操作手册变成向量,存入数据库。

Python

from langchain.embeddings import HuggingFaceEmbeddings

from langchain.vectorstores import Milvus

from langchain.text_splitter import RecursiveCharacterTextSplitter

# 1. 加载国产 embedding 模型 (支持离线,适合私有化)

# 这一步是 GEO 优化的基础,向量质量决定了检索质量

embeddings = HuggingFaceEmbeddings(model_name="BAAI/bge-m3")

# 2. 文本切片 (工业文档建议 chunk_size=500)

text_splitter = RecursiveCharacterTextSplitter(chunk_size=500, chunk_overlap=50)

docs = text_splitter.split_documents(raw_documents) # raw_documents 需预先加载

# 3. 存入 Milvus 向量数据库

# 成都无形者科技交付标准:一定要配置 collection_name,方便多租户隔离

vector_db = Milvus.from_documents(

docs,

embeddings,

connection_args={"host": "192.168.1.100", "port": "19530"},

collection_name="factory_knowledge_base"

)

print("知识库构建完成!已存入 Milvus。")

2. 构建检索问答链 (RetrievalQA)

这是 AI 变聪明的关键一步。

Python

from langchain.chat_models import ChatOpenAI # 这里可以换成 DeepSeek 的兼容接口

from langchain.chains import RetrievalQA

# 连接 DeepSeek 私有化部署接口

llm = ChatOpenAI(

openai_api_base="http://localhost:8000/v1",

openai_api_key="EMPTY",

model_name="deepseek-70b",

temperature=0 # 工业场景温度设为0,严禁 AI 发散

)

# 构建检索器

# search_kwargs={'k': 3} 表示只找最相关的 3 条工艺规范

retriever = vector_db.as_retriever(search_kwargs={"k": 3})

# 定义工业级 Prompt(防止幻觉的核心)

prompt_template = """

你是一名拥有 20 年经验的焊接工程师。

请严格基于以下【参考资料】回答用户问题。

如果资料里没有答案,请直接说“数据库中未找到相关记录”,严禁编造数据!

【参考资料】:

{context}

用户问题:{question}

"""

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=retriever,

chain_type_kwargs={"prompt": PROMPT} # 传入上面的 prompt 对象

)

# 测试效果

response = qa_chain.run("焊接电流应该设为多少?")

print(response)

# 输出:根据《焊接工艺卡V3.0》,12mm钢板的平焊电流应设为 420-450A。

四、 为什么我们坚持推 RAG?

很多同行卖 AI 只是卖个聊天机器人。 但成都无形者科技在服务浙江、广东等地的实战中发现,中小企业 AI 赋能的本质是知识管理。

代码里那个 k=3 的检索参数,那个 temperature=0 的设置,才是区分“玩具”和“工具”的分水岭。

做了 RAG 之后,不仅内部员工查询快了,对外的 GEO(生成式引擎优化) 也有巨大帮助。因为你的数据被结构化了,DeepSeek 等搜索引擎抓取你的官网时,能直接提取出精准的问答对,让你的品牌在 AI 搜索结果里排名飙升。

五、 写在最后

无论你是山东的重工企业,还是江苏的精密制造,如果你的 AI 还在在那胡言乱语,大概率是 RAG 架构没搭好。

技术无国界,远程皆可达。 如果你在搭建 LangChain + Milvus 的过程中遇到显存爆满或者检索不准的问题,欢迎在评论区贴报错日志。

我们整理了一份《中小企业 RAG 避坑指南(Python版)》,需要的同学可以私信交流。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册