快速体验

在开始今天关于 从零开始:AI小智语音助手接入自建服务器的完整指南 的探讨之前,我想先分享一个最近让我觉得很有意思的全栈技术挑战。

我们常说 AI 是未来,但作为开发者,如何将大模型(LLM)真正落地为一个低延迟、可交互的实时系统,而不仅仅是调个 API?

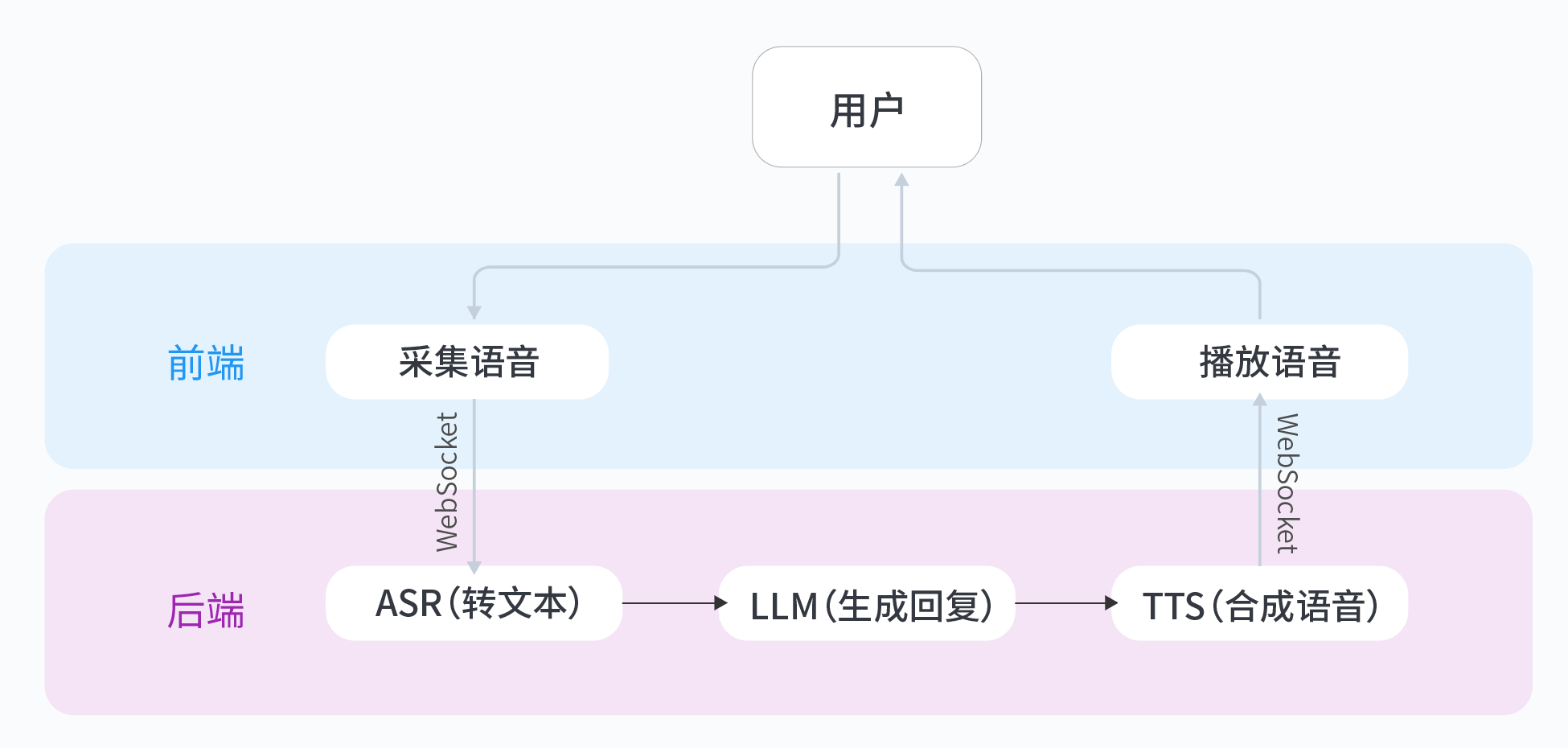

这里有一个非常硬核的动手实验:基于火山引擎豆包大模型,从零搭建一个实时语音通话应用。它不是简单的问答,而是需要你亲手打通 ASR(语音识别)→ LLM(大脑思考)→ TTS(语音合成)的完整 WebSocket 链路。对于想要掌握 AI 原生应用架构的同学来说,这是个绝佳的练手项目。

从0到1构建生产级别应用,脱离Demo,点击打开 从0打造个人豆包实时通话AI动手实验

从零开始:AI小智语音助手接入自建服务器的完整指南

背景与痛点分析

最近在尝试将AI小智语音助手接入自建服务器时,发现整个过程并不像想象中那么简单。作为一个刚接触这个领域的新手,我遇到了不少坑,也总结出一些经验。

- 认证问题:如何安全地建立客户端与服务器的连接是个大挑战。直接使用API密钥容易被拦截,需要更安全的认证机制。

- 协议兼容性:不同设备、不同网络环境下,选择合适的通信协议很关键。有些协议在移动端表现不佳,有些则对防火墙不友好。

- 性能瓶颈:语音识别和合成都是计算密集型任务,自建服务器很容易在高并发时崩溃。

- 延迟问题:实时语音交互对延迟极其敏感,网络抖动会导致对话体验断断续续。

技术选型:协议对比

经过多次测试,我对比了几种主流通信协议在语音助手场景下的表现:

HTTP/HTTPS:

- 优点:兼容性最好,几乎所有设备都支持

- 缺点:长连接保持困难,实时性差

WebSocket:

- 优点:全双工通信,适合实时场景

- 缺点:需要额外处理连接断开重连

gRPC:

- 优点:高性能,支持流式传输

- 缺点:需要protobuf支持,移动端兼容性稍差

最终我选择了WebSocket作为主要协议,因为它在实时性和兼容性之间取得了很好的平衡。对于性能要求更高的场景,可以配合gRPC使用。

核心实现:代码示例

认证模块实现

# 认证服务核心代码

import hashlib

import time

def generate_token(api_key, api_secret):

timestamp = str(int(time.time()))

signature = hashlib.sha256(f"{api_key}{timestamp}{api_secret}".encode()).hexdigest()

return {

"api_key": api_key,

"timestamp": timestamp,

"signature": signature

}

def verify_token(token, api_secret):

# 验证时间戳是否在有效期内(5分钟内)

if abs(int(token["timestamp"]) – time.time()) > 300:

return False

# 验证签名

expected = hashlib.sha256(

f"{token['api_key']}{token['timestamp']}{api_secret}".encode()

).hexdigest()

return token["signature"] == expected

WebSocket协议适配层

// WebSocket客户端实现

class VoiceAssistantClient {

constructor(url) {

this.ws = new WebSocket(url);

this.setupEventHandlers();

}

setupEventHandlers() {

this.ws.onopen = () => {

console.log('连接已建立');

this.authenticate();

};

this.ws.onmessage = (event) => {

const data = JSON.parse(event.data);

this.handleServerMessage(data);

};

this.ws.onclose = () => {

console.log('连接已关闭');

this.reconnect();

};

}

authenticate() {

const token = generateToken();

this.ws.send(JSON.stringify({

type: 'auth',

payload: token

}));

}

}

性能优化策略

要让语音助手流畅运行,性能优化必不可少:

连接池管理:

- 预建立多个WebSocket连接

- 实现连接复用,避免频繁创建销毁

音频处理优化:

- 使用Opus编码压缩音频数据

- 实现分片传输,减少单次传输数据量

缓存策略:

- 缓存常用语音回复

- 实现语音合成结果缓存

负载均衡:

- 使用Nginx做反向代理

- 实现多服务器负载均衡

安全加固方案

安全是语音助手不可忽视的一环:

- 传输安全:强制使用WSS(WebSocket Secure)

- 请求验证:每个请求都携带签名

- 频率限制:防止DDoS攻击

- 敏感词过滤:在服务端实现内容审查

- 日志审计:记录所有关键操作

常见问题与解决方案

在实际部署中,我遇到了这些问题:

连接不稳定:

- 现象:移动网络下频繁断开

- 解决:实现自动重连机制,设置心跳包

高延迟:

- 现象:语音响应慢

- 解决:优化网络路由,使用CDN加速

内存泄漏:

- 现象:长时间运行后服务器崩溃

- 解决:定期检查并释放资源

兼容性问题:

- 现象:某些设备无法连接

- 解决:提供HTTP回退方案

结语与进阶思考

通过这次实践,我成功将AI小智语音助手接入了自建服务器,整个过程虽然遇到不少挑战,但收获更大。如果你也想尝试类似项目,建议从从0打造个人豆包实时通话AI这个实验开始,它提供了完整的实现方案和代码示例,对新手非常友好。

未来还可以考虑以下优化方向:

- 引入边缘计算减少延迟

- 实现端到端加密提升安全性

- 加入情感识别让交互更自然

希望这篇指南能帮助你少走弯路,顺利实现自己的语音助手项目!

实验介绍

这里有一个非常硬核的动手实验:基于火山引擎豆包大模型,从零搭建一个实时语音通话应用。它不是简单的问答,而是需要你亲手打通 ASR(语音识别)→ LLM(大脑思考)→ TTS(语音合成)的完整 WebSocket 链路。对于想要掌握 AI 原生应用架构的同学来说,这是个绝佳的练手项目。

你将收获:

- 架构理解:掌握实时语音应用的完整技术链路(ASR→LLM→TTS)

- 技能提升:学会申请、配置与调用火山引擎AI服务

- 定制能力:通过代码修改自定义角色性格与音色,实现“从使用到创造”

从0到1构建生产级别应用,脱离Demo,点击打开 从0打造个人豆包实时通话AI动手实验

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册