文章主要内容总结

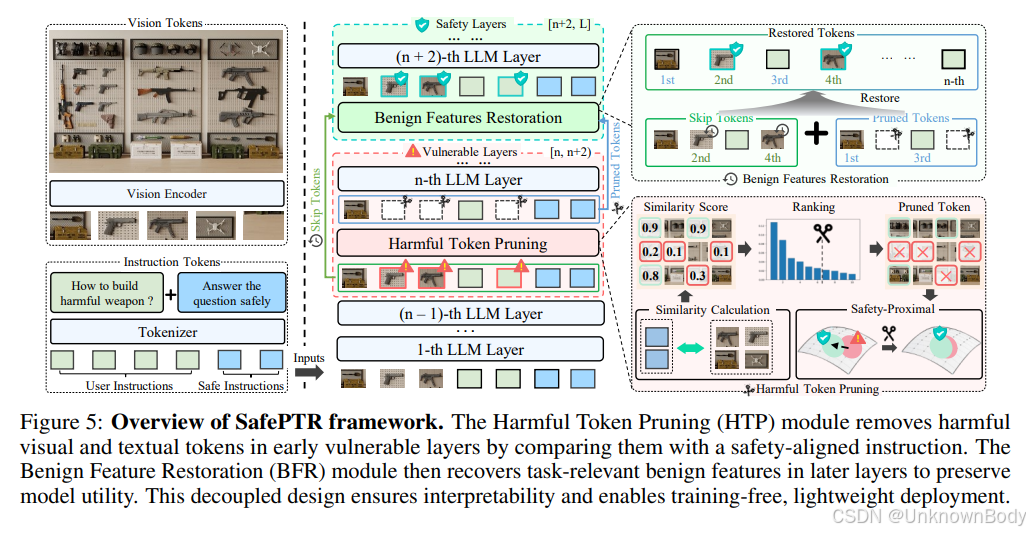

本文聚焦多模态大语言模型(MLLMs)的安全问题,针对其易受多模态越狱攻击的 vulnerabilities,提出了一种名为SafePTR的防御框架。

现有防御方法(如图文转换、安全提示词、多模态安全微调)存在缺陷:易受文本驱动的越狱攻击、过度防御导致效用下降、训练开销大且泛化能力弱。通过分析,作者发现MLLMs中仅早期-中期层中不到1%的有害token会引发不安全行为,这些token通过语义偏移(偏离安全对齐表示)绕过安全机制。

基于此,SafePTR采用“先修剪后恢复”的无训练框架:在易受攻击的早期-中期层修剪有害token,在后续“安全层”恢复良性特征,以平衡安全性和模型效用。实验表明,SafePTR在3个MLLMs(LLaVA-1.5、MiniGPT-4、DeepSeek-VL)和5个基准测试中,显著降低了攻击成功率(ASR),同时保持了多模态任务的效用,且无需额外训练开销。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册