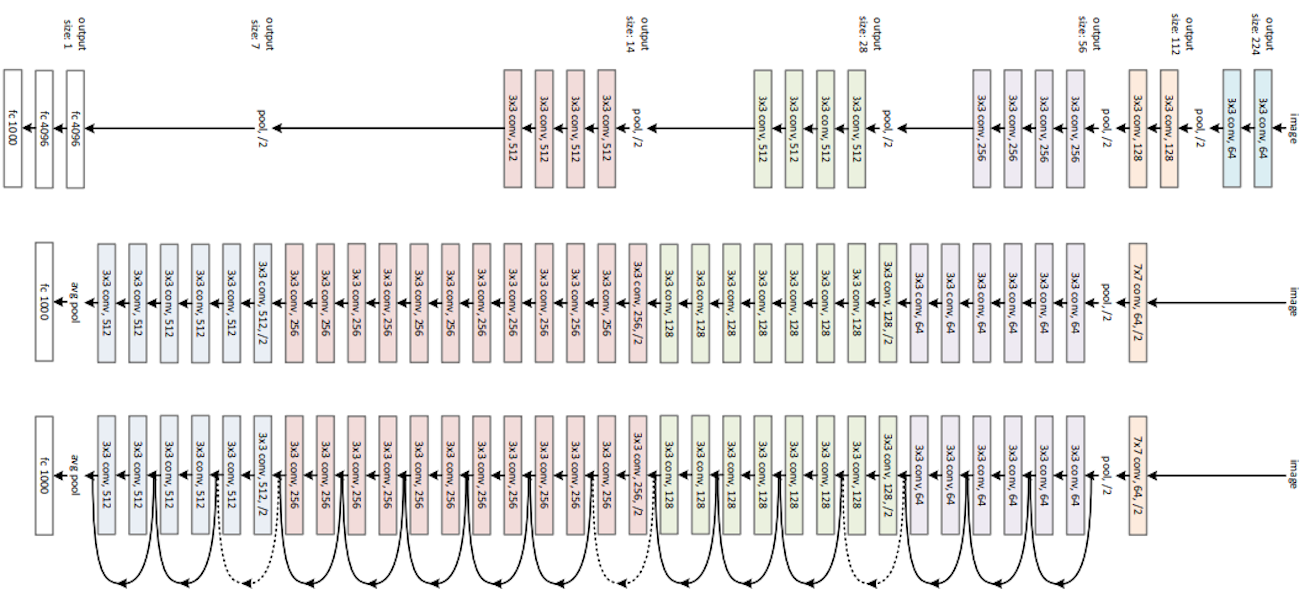

深度残差网络(Residual Network,简称ResNet)是2015年由微软亚洲研究院何恺明团队提出的一种突破性卷积神经网络(CNN)架构,其核心创新的残差连接机制,彻底打破了“网络层数越深性能越差”的技术瓶颈,成功训练出152层的超深网络,在ImageNet图像分类竞赛中以3.57%的错误率夺冠,将人类视觉识别误差(约5.1%)远远超越,成为深度学习计算机视觉领域的奠基性模型。

一、核心创新:残差连接与残差学习

1.传统深层网络的痛点

在ResNet提出前,随着CNN层数增加,会出现两大核心问题:一是梯度消失/爆炸,导致模型无法有效训练;二是网络退化,即深层网络的训练误差和测试误差反而高于浅层网络,并非过拟合导致,而是优化难度剧增。传统的梯度裁剪、Batch Normalization等方法只能缓解局部问题,无法从根本上解决。

2.残差连接机制

ResNet的核心解决方案是引入残差连接( shortcut connection ),即跳过一个或多个卷积层,将浅层特征直接传递到深层,与深层特征进行元素级相加。这种设计使网络不再被迫拟合复杂的原始映射,而是拟合残差映射,大幅降低优化难度。

从数学角度定义:设目标原始映射为H(x),通过残差连接将其转化为拟合残差F(x) = H(x) – x,最终输出为F(x) + x。若原始映射最优解接近恒等映射,残差F(x)可被轻松优化至接近零,无需深层网络费力拟合恒等映射,这也是残差学习的核心逻辑。身份快捷连接不增加额外参数和计算量,确保模型效率。

二、网络架构:残差块与多版本设计

1.两种经典残差块

ResNet通过堆叠残差块构建深层网络,根据网络深度不同,设计了两种残差块结构:

•基础残差块(Basic Block):适用于ResNet-18、ResNet-34等较浅版本,由两个3×3卷积层组成,中间搭配Batch Normalization和ReLU激活函数,残差连接直接跨接两个卷积层。

•瓶颈残差块(Bottleneck Block):适用于ResNet-50、ResNet-101、ResNet-152等深层版本,采用“1×1卷积→3×3卷积→1×1卷积”的结构。其中1×1卷积分别实现降维和升维,在减少参数量和计算量的同时保持特征表达能力,使深层网络具备高效训练特性。ResNet-50参数量仅25.5M,远低于VGG16的138M。

2.主流版本架构差异

ResNet系列包含多个版本,核心差异在于残差块的堆叠数量和总层数,各版本均由“输入卷积层→4个残差阶段→全局池化层→全连接层”构成,具体差异如下:

ResNet系列包含多个主流版本,核心差异体现在残差块堆叠数量、总层数及残差块类型上,各版本均遵循“输入卷积层→4个残差阶段→全局池化层→全连接层”的统一架构。其中ResNet-18为轻量版本,总卷积层数18层,采用基础残差块,4个残差阶段(conv2_x至conv5_x)的块数分别为2、2、2、2,具备轻量高效的特性,适合资源受限场景;ResNet-50是工业界主流选择,总卷积层数50层,采用瓶颈残差块,各残差阶段块数为3、4、6、3,实现了性能与效率的平衡,参数量仅25.5M,远低于VGG16的138M;ResNet-101通过加深conv3_x阶段(块数增至23),总卷积层数达101层,同样采用瓶颈残差块,大幅提升了复杂特征提取能力;ResNet-152则以精度为核心优势,总卷积层数152层,conv3_x和conv4_x阶段块数分别扩展至8和36,其ImageNet错误率低至21.3%,是该系列中精度最优的版本。

3.开源算法实现方案

ResNet作为经典架构,已在主流深度学习框架中提供官方开源实现,同时社区也衍生了诸多优化版本,适配不同开发需求:

•官方原生实现:PyTorch的torchvision.models模块、TensorFlow的tf.keras.applications模块均内置ResNet-18、ResNet-50、ResNet-101、ResNet-152等版本,支持直接调用预训练模型或从零训练,预训练权重基于ImageNet数据集,可快速迁移至各类视觉任务。

•社区优化实现:GitHub开源社区有诸多针对性优化版本,如针对移动端的轻量化ResNet实现(裁剪通道数、简化残差块),针对医疗影像、遥感图像等特定场景的适配版本,部分实现集成了混合精度训练、分布式训练策略,提升训练效率。

•自定义拓展实现:开发者可基于官方框架二次开发,例如通过修改瓶颈残差块的卷积分组数、调整各阶段通道数,适配特定任务需求;同时可结合注意力机制、批归一化改进算法(如SyncBN),进一步提升模型性能,相关实现可参考何恺明团队开源的原始代码仓库及顶会论文配套实现。

三、性能优势与关键成就

1.突破性性能表现

ResNet在2015年ILSVRC和COCO竞赛中横扫五大任务冠军,创下多项纪录:

•ImageNet分类任务:152层版本错误率3.57%,较第二名VGG-19(7.32%)降低近一半,远超人类视觉水平。

•检测与分割任务:在ImageNet检测、COCO分割等任务中,性能较第二名提升11%-27%,ResNet-101搭配Faster R-CNN使目标检测率达86%。

•计算效率:ResNet-50单张图像推理时间(1080Ti GPU)仅5.2ms,较同精度模型快3倍,梯度流动效率提升40%以上。

2.核心优势总结

ResNet的成功源于三大核心优势:一是残差连接解决梯度消失/爆炸和网络退化问题,使千层级网络可训练;二是瓶颈结构实现高效性,参数量和计算量优于传统深层CNN;三是泛化能力强,无需复杂调参即可适配多任务场景。

四、应用场景与发展演进

1.广泛应用场景

ResNet凭借优异性能,成为计算机视觉领域的基础骨干网络,应用覆盖多领域:

•基础视觉任务:图像分类、目标检测、语义分割、人脸识别等,是后续众多模型(如Faster R-CNN、Mask R-CNN)的核心骨干。

•医疗影像:COVID-19 CT图像分类准确率超98%,实现病灶精准识别。

•农业领域:玉米叶片病害检测,ResNet-50准确率达78.76%,较传统CNN提升7.75个百分点,可区分7类作物病虫害。

2.后续演进与优化

ResNet的残差学习思想催生了众多改进版本,持续推动深层网络发展:

•ResNeXt:引入分组卷积,增强特征多样性,提升模型泛化能力。

•Wide ResNet:扩大残差块通道数,在浅层网络中实现超越深层ResNet的性能。

•MFI-ResNet(2025年提出):结合流匹配模型,参数减少46%以上,同时精度略有提升,为残差网络效率优化提供新方向。

五、总结

ResNet通过极简的残差连接设计,颠覆了深层神经网络的训练范式,其核心价值不仅在于突破层数限制,更在于提供了“残差学习”的全新优化思路。何恺明团队的论文《Deep Residual Learning for Image Recognition》引用量超10万次,成为深度学习领域被引用最多的文献之一。如今,ResNet及其衍生模型仍在计算机视觉、跨模态学习等领域发挥核心作用,是连接传统CNN与现代深层网络的里程碑式架构。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册