✍✍计算机编程指导师 ⭐⭐个人介绍:自己非常喜欢研究技术问题!专业做Java、Python、小程序、安卓、大数据、爬虫、Golang、大屏等实战项目。 ⛽⛽实战项目:有源码或者技术上的问题欢迎在评论区一起讨论交流! ⚡⚡如果你遇到具体的技术问题或计算机毕设方面需求可以在主页上详细资料里↑↑联系我~~ Java实战 | SpringBoot/SSM Python实战项目 | Django 微信小程序/安卓实战项目 大数据实战项目 ⚡⚡获取源码主页–> 计算机编程指导师

⚡⚡文末获取源码

温馨提示:文末有CSDN平台官方免费提供的博客联系方式的名片! 温馨提示:文末有CSDN平台官方免费提供的博客联系方式的名片! 温馨提示:文末有CSDN平台官方免费提供的博客联系方式的名片!

上海餐饮数据分析与可视化系统-简介

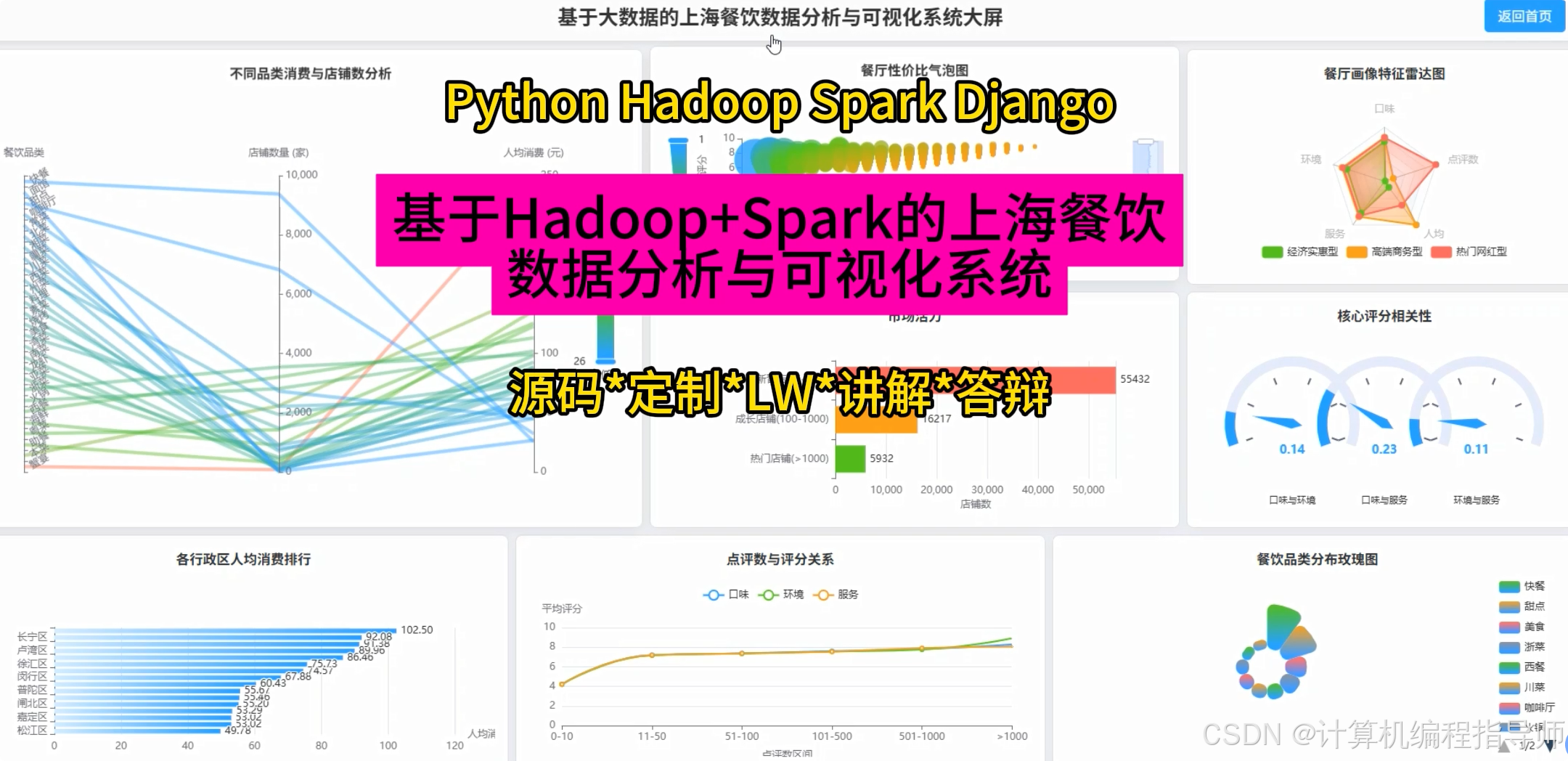

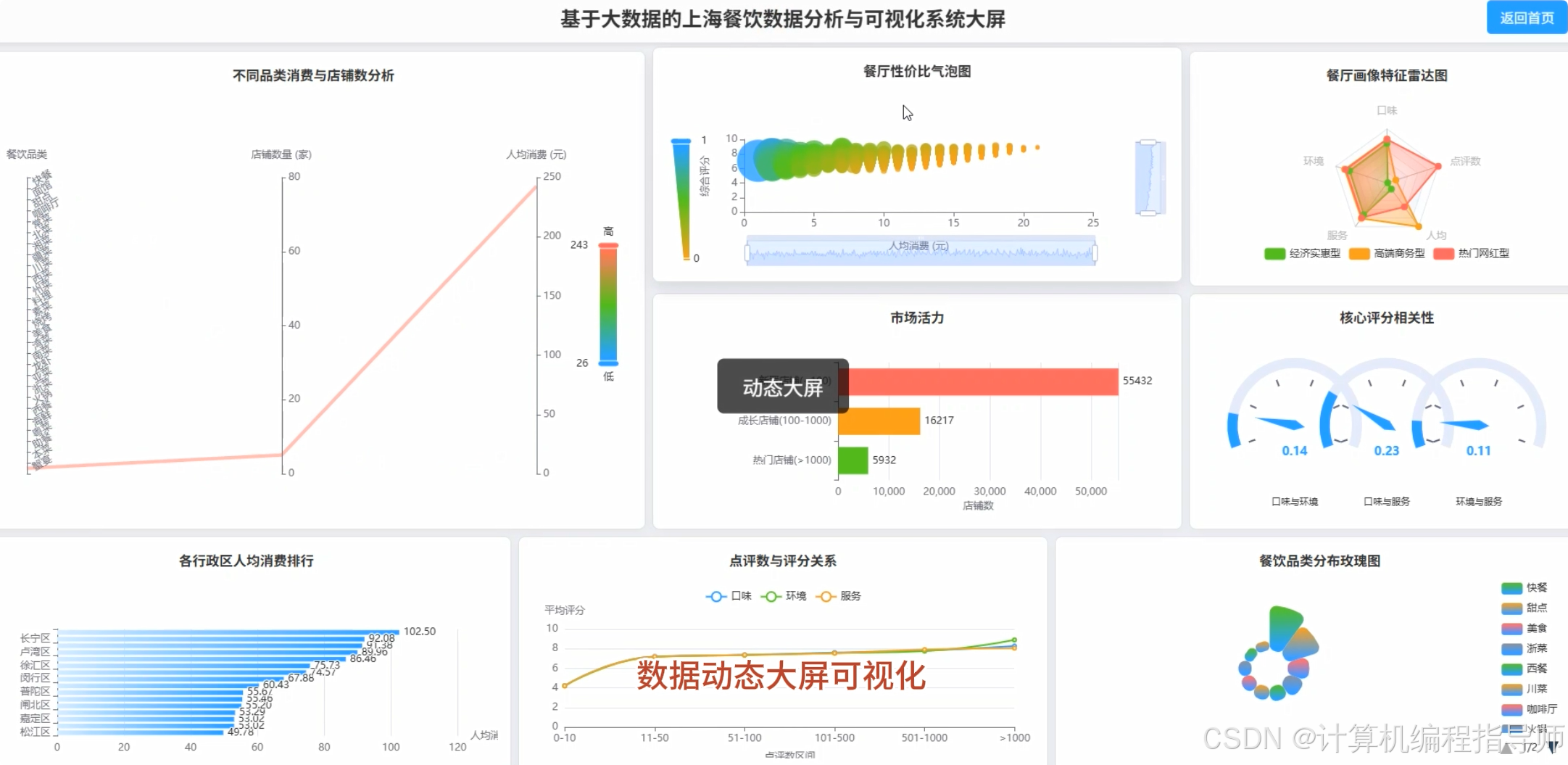

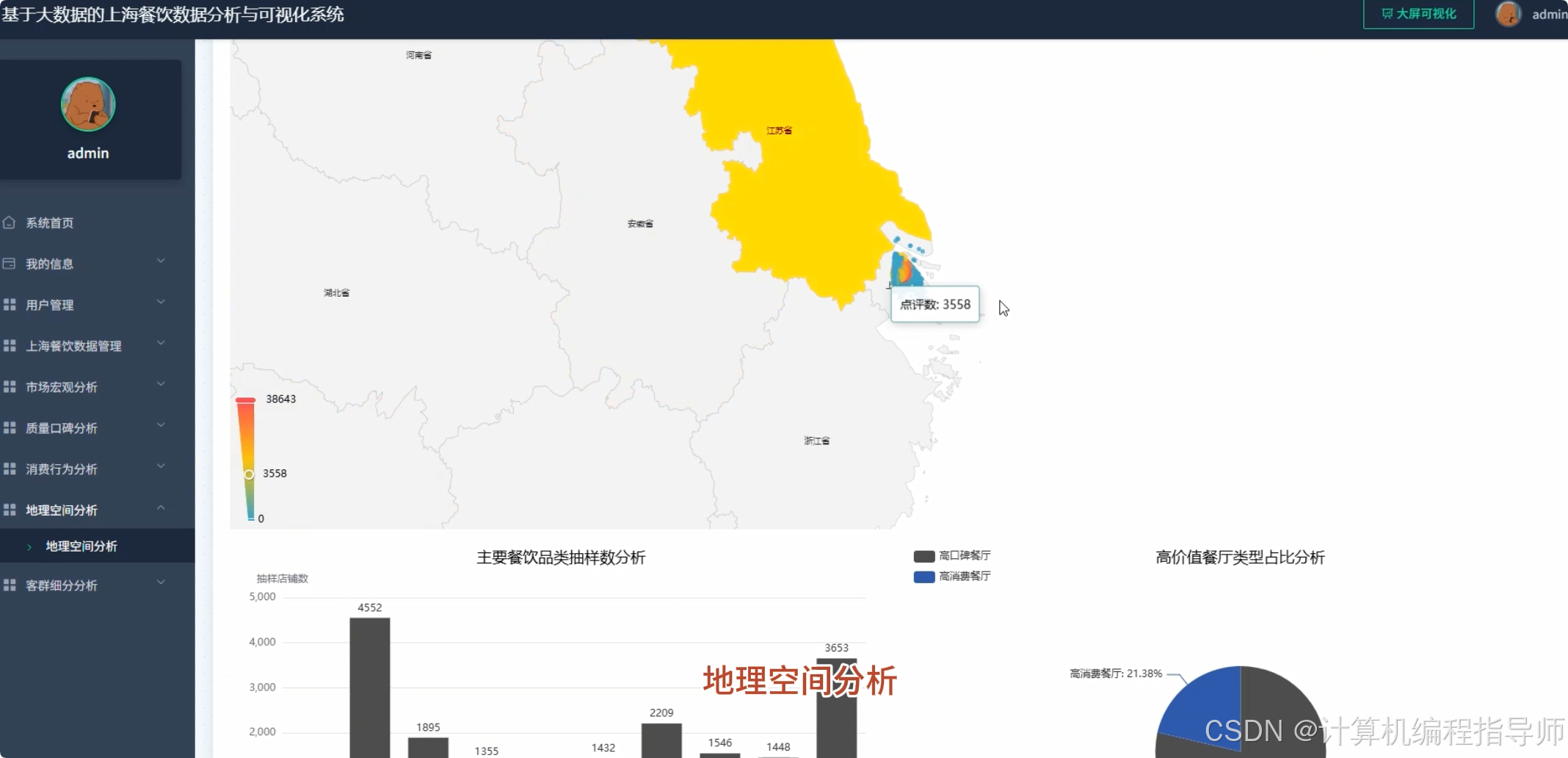

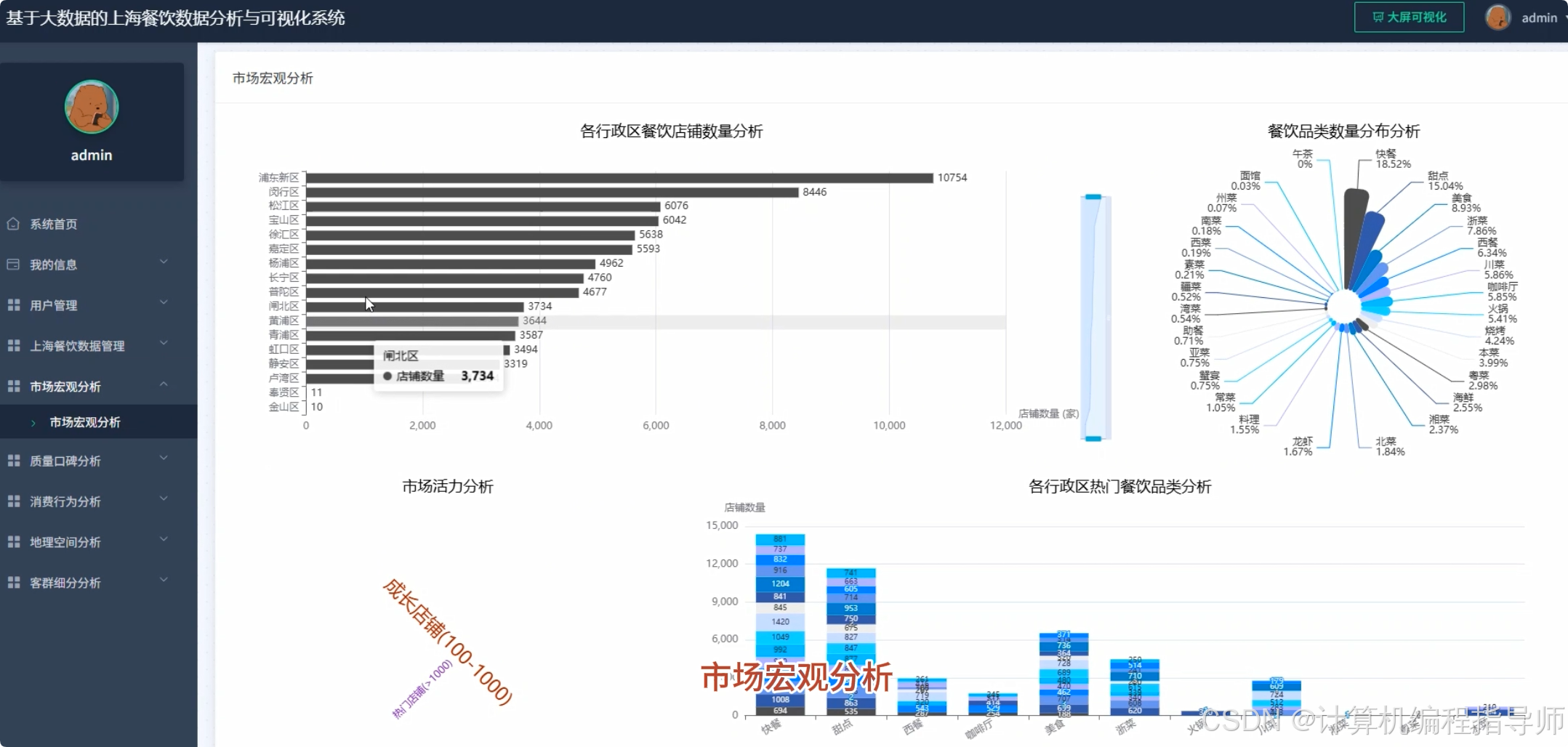

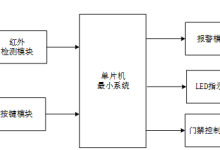

本系统“基于Hadoop+Spark的上海餐饮数据分析与可视化系统”旨在构建一个完整的大数据处理与应用平台。系统技术核心采用Hadoop生态进行海量餐饮数据的分布式存储,并利用Spark计算引擎进行高效的数据清洗、转换与分析处理。后端开发选用Python语言及其主流Web框架Django,负责业务逻辑实现与API接口开发,方便前端调用。前端界面则基于Vue.js框架,结合ElementUI组件库与Echarts可视化图表库,为用户呈现直观、动态且可交互的数据分析结果。系统功能设计全面,涵盖了上海餐饮市场的宏观格局分析、店铺质量与口碑的多维度评估、消费者行为与价格偏好洞察、基于地理位置的空间分布特征探索,以及运用K-Means算法对餐厅进行客群画像与市场细分。整个系统将原始的餐饮数据,通过大数据技术栈的层层加工,最终转化为具有商业参考价值的可视化报告和决策支持信息。

上海餐饮数据分析与可视化系统-技术

开发语言:Python或Java 大数据框架:Hadoop+Spark(本次没用Hive,支持定制) 后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis) 前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery 详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy 数据库:MySQL

上海餐饮数据分析与可视化系统-背景

选题背景 上海作为国际化大都市,其餐饮行业呈现出高度繁荣与激烈竞争并存的态势。数以万计的餐厅遍布城市各个角落,从街头小吃到高端料理,品类繁多,消费者的选择空间极大。对于经营者而言,如何在饱和的市场中精准定位、优化经营策略成为一大难题;对于消费者来说,如何从海量信息中快速筛选出符合口味与预算的餐厅也并非易事。与此同时,各大点评平台积累了海量的用户评价、评分、消费数据,这些数据背后隐藏着市场的真实动态和消费者的潜在偏好。然而,这些数据往往是零散且非结构化的,难以直接利用。因此,开发一个能够系统性地收集、处理并分析这些数据的系统,对于理解上海餐饮市场的全貌具有重要的现实需求。

选题意义 本课题的意义首先体现在技术应用层面,它为计算机专业的学生提供了一个综合运用Hadoop、Spark、Django等前沿技术的实践机会,完整地走了一遍从数据存储、计算处理到Web应用开发的全流程,能有效提升工程实践与问题解决能力。其次,从实际应用价值来看,本系统能够将复杂的数据转化为直观的图表和结论,为餐饮从业者提供选址参考、竞品分析和经营优化的数据支持,也能为消费者提供更科学的就餐决策依据。虽然作为一个毕业设计,其分析深度和模型精度有限,但它构建了一个可扩展的分析框架,为后续更深入的商业智能研究奠定了基础,具有一定的示范作用和实用价值。

上海餐饮数据分析与可视化系统-视频展示

基于Hadoop+Spark的上海餐饮数据分析与可视化系统

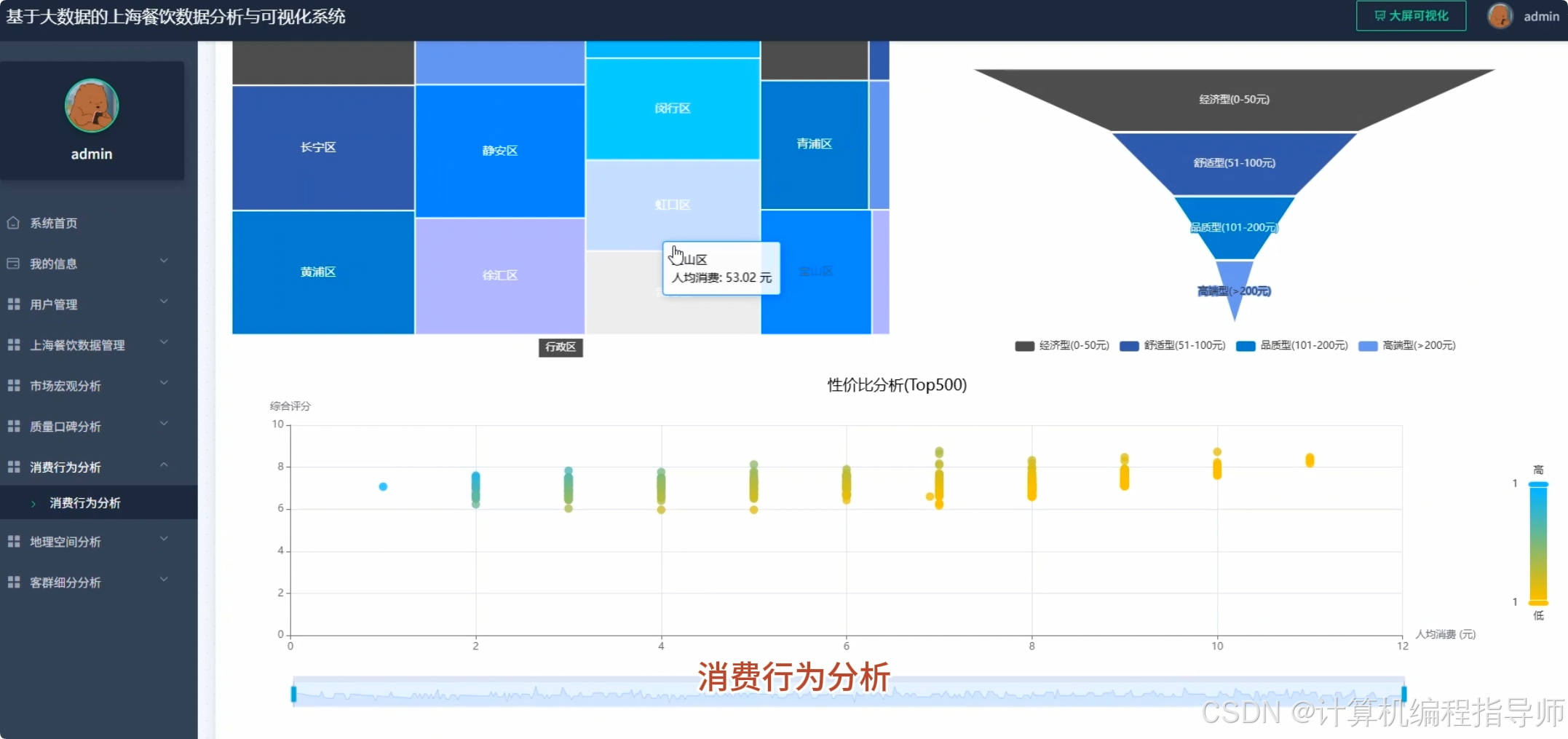

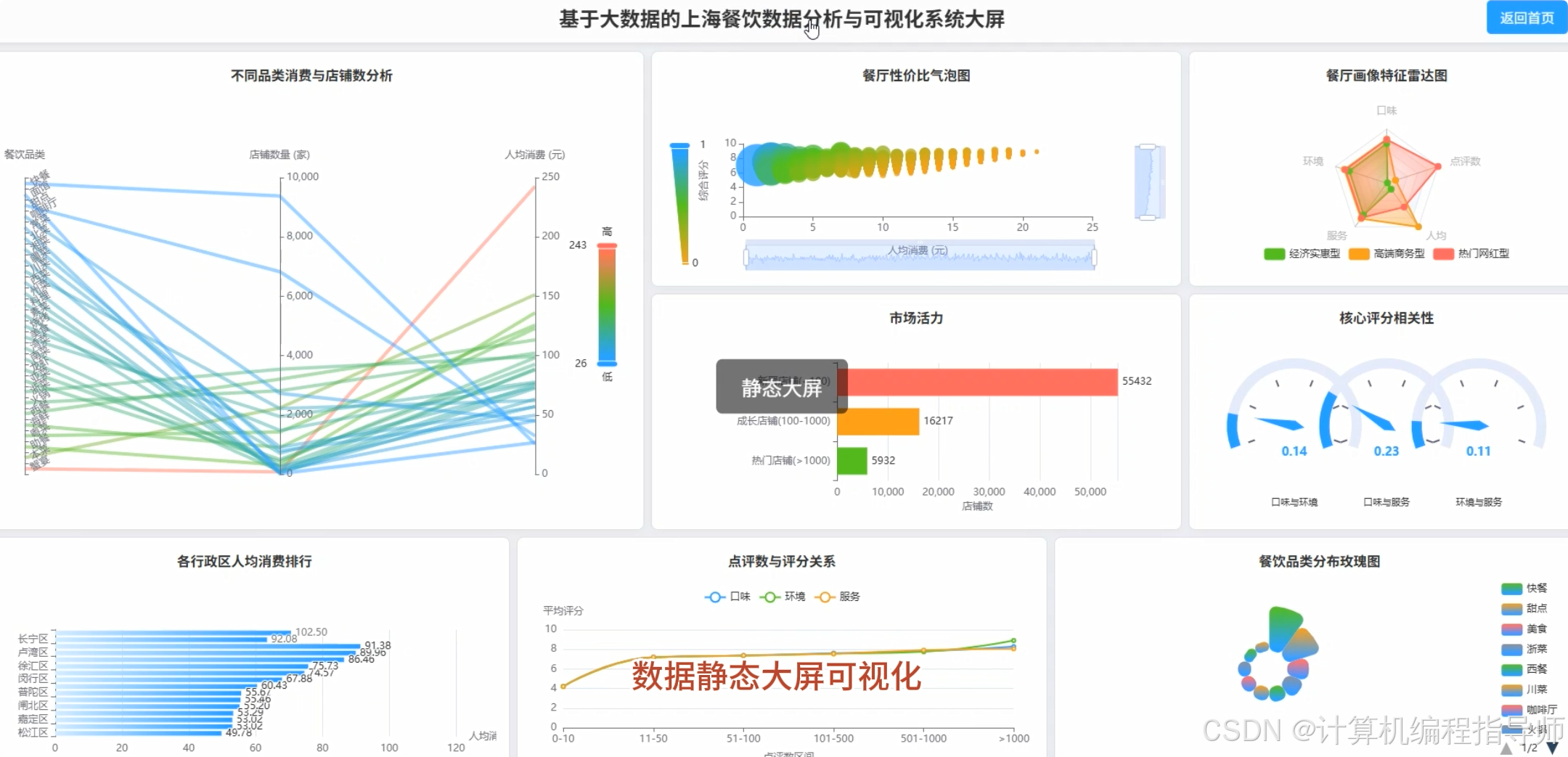

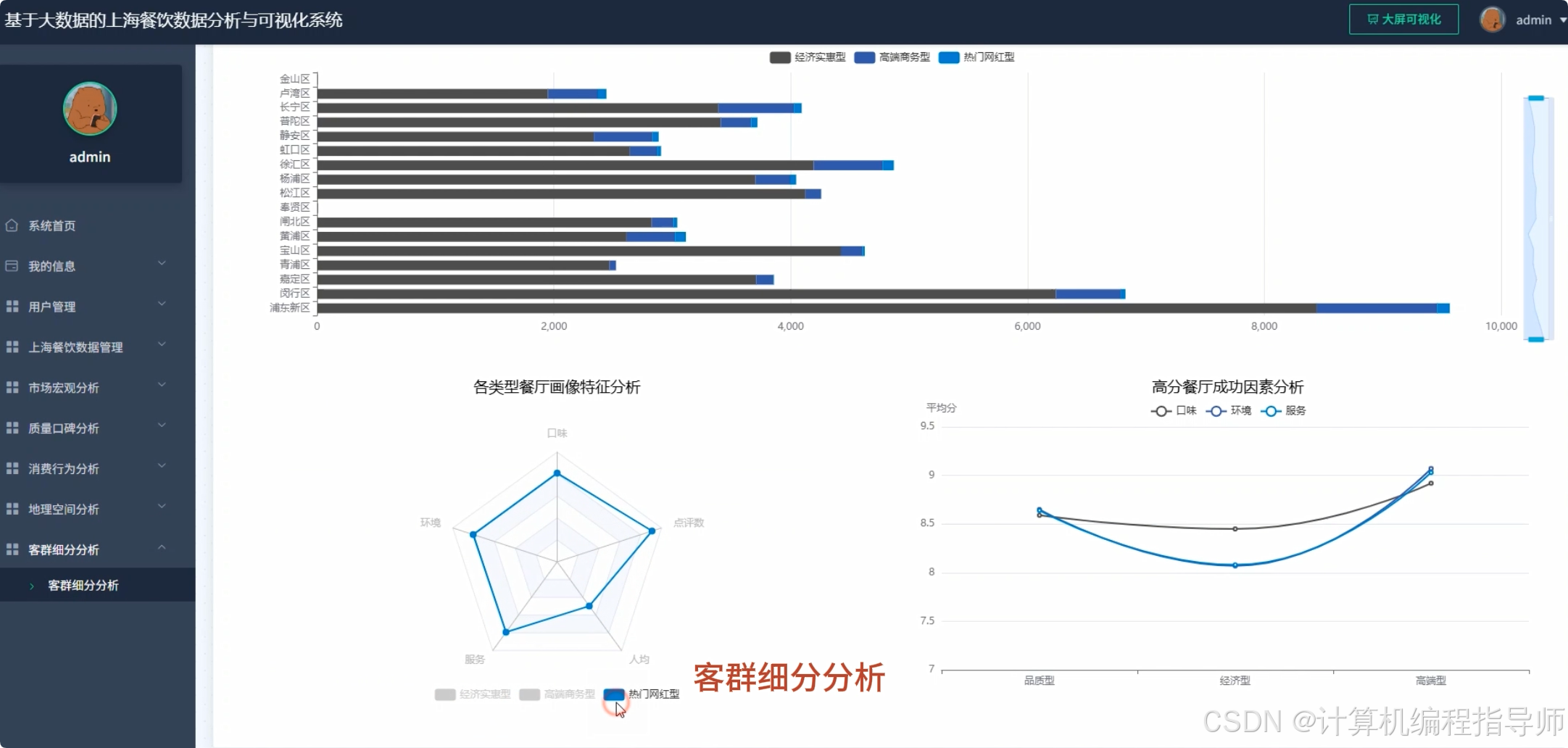

上海餐饮数据分析与可视化系统-图片展示

上海餐饮数据分析与可视化系统-代码展示

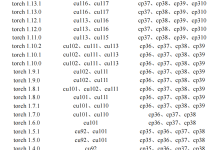

from pyspark.sql import SparkSession, functions as F

from pyspark.ml.feature import VectorAssembler

from pyspark.ml.clustering import KMeans

spark = SparkSession.builder.appName("RestaurantAnalysis").getOrCreate()

df = spark.read.csv("hdfs://…/shanghai_restaurants.csv", header=True, inferSchema=True)

# 功能1: 各行政区餐饮店铺数量与占比分析

district_count = df.filter(F.col("行政区").isNotNull()).groupBy("行政区").agg(F.count("*").alias("店铺数量"))

total_count = district_count.agg(F.sum("店铺数量").alias("总数")).collect()[0]["总数"]

district_analysis = district_count.withColumn("占比", F.format_number(F.col("店铺数量") / total_count * 100, 2)).orderBy(F.desc("店铺数量"))

district_analysis.write.csv("hdfs://…/output/district_analysis", mode="overwrite", header=True)

# 功能2: 各行政区高口碑餐厅加权排名Top10

weighted_df = df.withColumn("点评数_log", F.log1p(F.col("点评数")))

weighted_df = weighted_df.withColumn("综合得分", (F.col("口味") + F.col("环境") + F.col("服务")) / 3 * F.col("点评数_log"))

window_spec = F.Window.partitionBy("行政区").orderBy(F.desc("综合得分"))

top10_restaurants = weighted_df.withColumn("rank", F.rank().over(window_spec)).filter(F.col("rank") <= 10)

top10_restaurants.select("行政区", "店名", "综合得分", "口味", "环境", "服务").write.csv("hdfs://…/output/top10_restaurants", mode="overwrite", header=True)

# 功能3: 基于K-Means算法的餐厅综合画像聚类

feature_cols = ["口味", "环境", "服务", "人均消费", "点评数"]

assembler = VectorAssembler(inputCols=feature_cols, outputCol="features")

data_for_clustering = assembler.transform(df.na.drop(subset=feature_cols))

kmeans = KMeans(featuresCol="features", predictionCol="cluster", k=5, seed=42)

model = kmeans.fit(data_for_clustering)

clustered_data = model.transform(data_for_clustering)

clustered_data.select("店名", "行政区", "类别", *feature_cols, "cluster").write.csv("hdfs://…/output/clustered_restaurants", mode="overwrite", header=True)

上海餐饮数据分析与可视化系统-结语

至此,基于Hadoop+Spark的上海餐饮数据分析与可视化系统已基本完成。系统实现了从数据采集、处理到前端展示的完整链路,虽然仍有优化空间,但希望能为正在做毕设的同学提供一个清晰的大数据项目思路,感谢大家的观看。

如果这个视频对你的毕设选题和开发有帮助,别忘了给我一个一键三连支持一下!大家正在做什么方向的毕设呢?或者对大数据分析有什么疑问,都欢迎在评论区留言交流,我们一起进步!

⚡⚡获取源码主页–> 计算机编程指导师 ⚡⚡有技术问题或者获取源代码!欢迎在评论区一起交流! ⚡⚡大家点赞、收藏、关注、有问题都可留言评论交流! ⚡⚡如果你遇到具体的技术问题或计算机毕设方面需求可以在主页上详细资料里↑↑联系我~~

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册