SSH连接超时处理:稳定访问远程GPU算力服务器技巧

在深度学习项目中,你是否经历过这样的场景:训练到第38个epoch时突然断网,SSH会话中断,终端进程被挂起——几天的训练成果瞬间归零?这并非个例。随着AI模型规模不断膨胀,本地设备早已无法承载动辄数百GB显存需求的训练任务,越来越多开发者依赖云端或集群中的远程GPU服务器。而在这条通往高性能计算的路上,最脆弱的一环往往不是硬件,而是那根看不见的SSH连接线。

为什么你的训练总在关键时刻掉线?

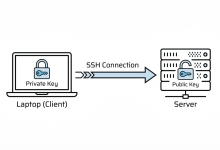

很多人以为只要代码跑起来了就万事大吉,却忽略了底层连接机制的稳定性。SSH虽然安全可靠,但本质上是一个“会话型”协议,默认行为是:一旦检测不到活动,就会关闭连接。

想象一下,你在运行一个PyTorch训练脚本,前几分钟输出大量日志,之后进入安静的迭代阶段。此时没有键盘输入、也没有实时输出刷新,网络中间设备(如企业防火墙、云负载均衡器)便会将其判定为“空闲连接”,通常在5~15分钟内主动切断。更糟糕的是,笔记本休眠、Wi-Fi切换、甚至短暂信号波动都可能导致TCP连接中断,而服务器端可能要几十秒甚至几分钟后才感知到异常。

这类问题在使用python train.py这类长周期任务时尤为致命。一旦连接断开,shell会话终止,所有前台进程都会收到SIGHUP信号而退出——这意味着你的模型训练戛然而止,连checkpoint都没来得及保存。

PyTorch-CUDA镜像:不只是预装环境那么简单

面对复杂的深度学习环境配置,手动安装PyTorch、CUDA、cuDNN及其版本匹配堪称一场噩梦。稍有不慎,“ImportError: CUDA not available”就能让你浪费半天时间排查驱动兼容性问题。

这时候,像 PyTorch-CUDA-v2.8 这样的容器化镜像就成了救命稻草。它不仅仅是把几个库打包在一起,而是一种工程级的最佳实践封装:

- 基于官方NVIDIA NGC镜像构建,确保CUDA与cuDNN版本严格对齐;

- 集成Jupyter Lab、pip、conda等开发工具,支持交互式调试;

- 利用NVIDIA Container Toolkit实现GPU直通,容器内可直接调用nvidia-smi和torch.cuda.is_available();

- 支持多卡并行训练(DDP),适合大规模分布式任务。

更重要的是,这种镜像提供了一种环境一致性保障。无论你在阿里云、AWS还是本地HPC集群上启动该容器,运行结果理论上应完全一致,极大提升了实验的可复现性。

下面这段代码几乎是每个进容器后的第一道“健康检查”:

import torch

if torch.cuda.is_available():

print("CUDA is available")

print(f"Number of GPUs: {torch.cuda.device_count()}")

print(f"Current GPU: {torch.cuda.get_device_name(torch.cuda.current_device())}")

else:

print("CUDA not available – running on CPU")

x = torch.rand(1000, 1000).cuda()

y = torch.rand(1000, 1000).cuda()

z = torch.mm(x, y)

print(f"Matrix multiplication completed on GPU: {z.device}")

别小看这几行,它们验证了从驱动加载、内存分配到张量运算的完整链路。只有当z.device显示为cuda:0时,你才能真正放心地提交训练任务。

SSH保活机制:从被动防御到主动守护

解决连接中断的核心思路有两个方向:一是防止连接被断,二是让任务不依赖连接。

客户端配置:让连接“假装活跃”

最简单有效的预防措施是在本地SSH配置中启用保活探测。编辑 ~/.ssh/config 文件:

Host gpu-server

HostName 192.168.1.100

User your_username

Port 22

ServerAliveInterval 60

ServerAliveCountMax 3

TCPKeepAlive yes

这里的 ServerAliveInterval 60 表示客户端每60秒向服务器发送一次空包,模拟网络活动。即使你正在写论文、喝咖啡、甚至电脑睡眠前,这条心跳仍在维持连接存活。

注意不要设得太短(如10秒),否则会增加不必要的网络流量;也不要太长(超过120秒),否则可能赶不上某些云平台的5分钟清理策略。

服务端设置:统一管理更高效

如果你是团队管理员或拥有服务器权限,建议在 /etc/ssh/sshd_config 中统一开启服务端探测:

ClientAliveInterval 60

ClientAliveCountMax 3

重启服务即可生效:

sudo systemctl restart sshd

这种方式更适合多人共用的GPU服务器环境,由中心节点主动维护连接状态,避免个别用户因配置缺失导致任务失败。

| ClientAliveInterval | 服务器每隔多少秒问一次“你还活着吗?” |

| ClientAliveCountMax | 最多重试几次没回应就断开 |

| TCPKeepAlive | 是否启用底层TCP保活机制 |

⚠️ 提示:部分云服务商(如AWS EC2、Google Cloud VM)默认禁用了这些选项,需手动开启。

真正可靠的方案:解耦任务与会话

即便做了保活,也不能保证100%不断线。真正的高可用做法是:让训练任务脱离SSH会话生存。

使用 tmux 实现会话持久化

tmux 是终端复用器中的瑞士军刀。它的核心价值在于——进程独立于SSH存在。

基本操作流程如下:

# 安装 tmux(Ubuntu/Debian)

sudo apt install tmux

# 创建后台会话运行训练

tmux new-session -d -s train_session "python train.py"

# 查看当前所有会话

tmux ls

# 恢复到指定会话

tmux attach-session -t train_session

当你执行 tmux new-session -d 时,相当于在一个“虚拟终端”里启动了Python进程。即使你断开SSH,这个虚拟终端依然在运行。下次登录后,只需 attach 回去,就能看到完整的输出日志,就像从未离开过。

更进一步,你可以将多个任务分屏管理:

# 分屏上下布局

tmux split-window -v

# 分屏左右布局

tmux split-window -h

# 在不同窗格间切换

Ctrl+b → 方向键

替代方案:nohup + 日志重定向

对于轻量级任务,也可以使用经典的 nohup 组合:

nohup python train.py > training.log 2>&1 &

echo $! > pid.txt

- nohup 忽略挂断信号(SIGHUP),保证进程继续运行;

- 输出重定向至文件,便于后续分析;

- $! 获取最后启动的后台进程ID,方便后期 kill 或监控。

虽然不如 tmux 灵活,但在脚本自动化或CI环境中仍广泛使用。

典型系统架构与工作流设计

现代远程AI开发通常遵循如下架构模式:

[本地PC]

│ SSH (port 22)

▼

[远程GPU服务器] ←─┐

├── Docker Engine

└── NVIDIA Driver → [GPU Hardware]

↑

[PyTorch-CUDA-v2.8 镜像容器]

↑

Jupyter / Python CLI / tmux session

具体工作流可以归纳为六步法:

举个实际例子:

# 启动容器并映射端口

docker run -it –gpus all \\

-v $(pwd)/data:/workspace/data \\

-v $(pwd)/checkpoints:/workspace/checkpoints \\

–name pt-train \\

pytorch-cuda:v2.8 bash

# 容器内操作

tmux new-session -s resnet50_train "python train_resnet.py –epochs 100"

这样即使你关机回家,第二天上班打开终端,一条命令就能回到昨晚的训练画面:

ssh gpu-server

docker exec -it pt-train bash

tmux attach-session -t resnet50_train

工程最佳实践与避坑指南

1. 不要裸跑训练脚本

永远不要直接在终端敲 python train.py 就走人。哪怕你觉得网络很稳,也要养成使用 tmux 或 screen 的习惯。这是区分新手与老手的重要标志之一。

2. 合理控制保活频率

ServerAliveInterval 设为60秒是个黄金平衡点。太频繁会影响低带宽网络体验,间隔过长则失去意义。若所在网络特别不稳定,可适当下调至30秒。

3. 日志必须落地文件

仅靠终端输出远远不够。务必配合日志记录框架(如logging模块)将关键信息写入磁盘,并定期备份。推荐格式包含时间戳、loss值、学习率、GPU利用率等:

import logging

logging.basicConfig(filename='training.log', level=logging.INFO)

logging.info(f"Epoch {epoch}, Loss: {loss.item():.4f}, LR: {lr}")

4. 多人协作下的资源隔离

在共享服务器环境下,除了用tmux隔离会话外,还应通过Docker限制资源使用:

–memory=16g –memory-swap=16g –gpus '"device=0"'

防止某个用户占满显存影响他人任务。

5. 安全加固不可忽视

- 禁用root登录:修改 /etc/ssh/sshd_config 设置 PermitRootLogin no

- 强制密钥认证:关闭密码登录,提升安全性

- 限制IP访问:通过云平台安全组只允许可信IP连接22端口

- 定期更新镜像:修复已知漏洞,避免被挖矿程序入侵

写在最后:构建属于你的“永不掉线”工作流

我们追求的从来不是一个不会断的连接,而是一个能承受中断的任务体系。

PyTorch-CUDA镜像解决了“环境难配”的痛点,SSH保活机制延长了连接寿命,而tmux+nohup组合则实现了任务与会话的彻底解耦。三者结合,构成了现代AI工程实践中不可或缺的稳定性三角。

当你下一次部署训练任务时,不妨自问三个问题:

如果答案都是肯定的,那么即便飞机起飞、地铁进隧道、家里断电,你的模型仍在远方默默收敛——这才是真正的“安心训练”。

技术的本质,不是对抗故障,而是学会与不确定性共处。而这一切,始于一条不会轻易断开的SSH连接。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册