在CNN架构演进历程中,模型性能的提升往往伴随参数与计算量的暴涨——从AlexNet到ResNet,再到后续的DenseNet,为追求更高精度,研究者常盲目加深网络层数、拓宽通道数或扩大输入分辨率,却陷入“精度提升有限而成本激增”的困境。2019年,Google Brain提出的EfficientNet,如同一位“精准建筑师”,打破了传统“单一维度缩放”的盲目性,通过提出“复合缩放”策略,在参数与计算量可控的前提下,实现了精度与效率的最优平衡,成为CNN架构设计的里程碑式成果。本文将从核心原理、复合缩放机制、前沿改进、现存挑战及未来展望五个维度,系统解析EfficientNet,兼顾理论深度与实用参考,助力理解CNN架构设计的底层逻辑。

一、核心背景:传统CNN缩放的“盲目性困境”

CNN的性能提升与网络规模缩放密切相关,缩放本质是通过调整网络维度,让模型捕捉更丰富的特征信息。传统缩放方式多聚焦单一维度,如同“盖房子只加宽不增高,或只增高不加宽”,存在天然缺陷,具体可分为三类:

-

深度缩放(Depth):增加网络层数(如ResNet-50升级为ResNet-152),提升模型的特征抽象能力,但过深易导致梯度消失、训练难度剧增,且计算量呈线性增长,精度提升边际效应明显。

-

宽度缩放(Width):增加卷积通道数(如将64通道扩为128通道),增强模型对细粒度特征的捕捉能力,但过宽会导致特征冗余,参数与计算量呈平方增长,且难以学习到深层抽象特征。

-

分辨率缩放(Resolution):扩大输入图像分辨率(如从224×224提升至448×448),让模型捕捉更多细节特征,但计算量呈平方增长,对硬件资源要求极高,且易引入冗余背景信息。

传统缩放的核心问题在于“维度孤立”——单一维度的极致缩放会导致效率低下,而多维度随机组合又缺乏理论指导,难以找到精度与效率的平衡点。例如,将ResNet-50同时加深、加宽并提升输入分辨率,精度可能提升3~5个百分点,但参数与计算量会暴涨10倍以上,无法适配资源受限场景。EfficientNet的核心创新,就是提出了一套“多维度协同缩放”的数学框架,让网络缩放从“盲目尝试”变为“精准计算”。

二、EfficientNet核心原理:复合缩放(Compound Scaling)机制

EfficientNet的核心是“复合缩放”策略,其底层逻辑是:网络的深度、宽度、分辨率三个维度并非孤立,而是相互关联、协同影响的,需按固定比例同步缩放,才能最大化模型性能。如同调整相机参数——光圈(宽度)、快门速度(深度)、焦距(分辨率)需协同调节,才能拍出清晰且高质量的照片,单一参数调节难以兼顾效果。

2.1 复合缩放的数学框架

EfficientNet通过引入三个缩放系数(φ、α、β、γ),构建了复合缩放的数学模型,具体如下:

基础网络(EfficientNet-B0):先设计一个轻量化基础网络,作为缩放的“基准框架”。EfficientNet-B0基于MobileNetV2的倒置残差结构与SE注意力模块,参数仅5.3M,计算量0.39B FLOPs,在ImageNet上Top-1精度达77.1%,为后续缩放奠定高效基础。

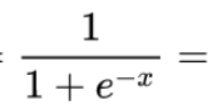

复合缩放公式:当总计算量按φ^2(φ为全局缩放系数,控制整体规模)增长时,三个维度按固定比例同步缩放: 其中α、β、γ需通过网格搜索在基础网络上确定最优值,且需满足约束条件:α·β²·γ² ≈ 2(确保计算量按φ²增长,φ每增加1,计算量翻倍)。EfficientNet通过实验确定B0的最优系数为α=1.2、β=1.1、γ=1.15。

深度缩放:Depth = α^φ(α为深度缩放系数,控制层数增长)

宽度缩放:Width = β^φ(β为宽度缩放系数,控制通道数增长)

分辨率缩放:Resolution = γ^φ(γ为分辨率缩放系数,控制输入尺寸增长)

系列模型生成:固定α、β、γ,通过调整φ值生成不同规模的模型(B0~B7)。例如,φ=1对应B1,计算量翻倍;φ=7对应B7,计算量为B0的64倍,ImageNet Top-1精度达84.4%,远超同期ResNet-152(80.4%),且参数仅为其1/8。

2.2 关键组件:高效基础网络设计

EfficientNet的高效性不仅源于复合缩放,还依赖基础网络的精细化设计,核心组件包括倒置残差结构与SE注意力模块的融合:

-

倒置残差结构(Inverted Residual):源自MobileNetV2,通过“1×1卷积升维→3×3深度卷积→1×1卷积降维”的流程,在减少参数的同时保留特征表达能力,如同“先放大特征再压缩,既保留细节又控制成本”。

-

SE注意力模块(Squeeze-and-Excitation):在每个残差块末尾加入SE模块,通过全局池化捕捉通道间的依赖关系,动态调整通道权重,强化有效特征、抑制冗余特征,让模型“聚焦关键信息”。EfficientNet将SE模块与倒置残差结构深度融合,进一步提升特征利用率。

三、EfficientNet的优势与实用价值

相较于传统CNN架构,EfficientNet的核心优势体现在“精度-效率”的极致平衡,其实用价值贯穿模型训练、迁移学习、工业部署等多个场景:

-

效率优势显著:在相同精度下,EfficientNet的参数与计算量远低于传统模型。例如,EfficientNet-B4(Top-1精度82.9%)的参数仅19.5M,计算量4.2B FLOPs,而ResNet-152(Top-1精度80.4%)参数达60.2M,计算量11.3B FLOPs,效率提升3倍以上。

-

迁移学习性能优异:轻量化的基础结构与高效的特征表达能力,使EfficientNet成为迁移学习的优选骨干网络。在目标检测、语义分割、图像分类等下游任务中,以EfficientNet为骨干的模型,在精度与速度上均优于ResNet、DenseNet等传统骨干。

-

缩放策略通用:复合缩放策略并非仅适用于EfficientNet自身,可迁移至其他CNN架构(如ResNet、MobileNet),通过同步缩放三个维度,提升模型效率。例如,将复合缩放应用于ResNet-50,可在计算量不变的情况下,精度提升2~3个百分点。

四、前沿改进:拓展EfficientNet的能力边界

EfficientNet提出后,研究者围绕其核心缺陷(如小目标特征捕捉不足、Transformer融合适配、极端场景性能有限等),展开了一系列改进工作,衍生出多个高性能变体,进一步拓展了其应用场景。

4.1 小目标与细粒度场景优化

原始EfficientNet的缩放策略对小目标特征捕捉不足,改进方向集中在增强多尺度特征融合与细节保留:

-

EfficientNet-Lite:针对移动端与边缘设备优化,精简网络结构,移除部分SE模块以降低计算量,同时调整缩放系数适配低分辨率输入,在保持精度的前提下,推理速度提升2~3倍,适合移动端细粒度检测场景。

-

EfficientNet-FPN:将EfficientNet与FPN(特征金字塔网络)融合,强化多尺度特征聚合能力,提升小目标与复杂场景的特征表达,在目标检测任务中,AP比传统EfficientNet骨干提升4~6个百分点。

4.2 与Transformer的融合创新

结合Transformer的全局注意力机制,弥补CNN局部感受野的局限,提升模型对全局特征的捕捉能力:

-

EfficientNet-ViT:将EfficientNet的卷积特征提取能力与ViT(Vision Transformer)的全局注意力机制融合,前半部分用EfficientNet提取局部特征,后半部分用Transformer捕捉全局关联,在ImageNet上Top-1精度达85.9%,同时保持较高效率。

-

EfficientFormer:借鉴EfficientNet的复合缩放策略,设计轻量化Transformer架构,通过调整注意力模块的深度、宽度与输入分辨率,实现效率与精度的平衡,参数仅8.7M,精度却超越ViT-Base,适合资源受限场景。

4.3 训练策略与结构改进

通过优化训练策略与网络细节,进一步提升模型性能与泛化能力:

-

EfficientNetV2:Google后续提出的升级版本,优化了基础网络结构,引入Fused-MBConv模块替代部分倒置残差结构,提升训练速度;同时调整复合缩放策略,支持更小的缩放步长,精度比EfficientNet-B7提升1.1个百分点,训练速度提升5~11倍。

-

知识蒸馏与量化优化:以EfficientNet-B7为教师模型,蒸馏轻量化版本(如B0~B3),在参数不变的情况下,精度提升2~3个百分点;通过INT8量化,模型体积缩小75%,推理速度提升3倍,适配工业部署需求。

五、当前研究挑战:EfficientNet的“能力天花板”

尽管EfficientNet及变体性能优异,但在极端场景适配、架构灵活性、跨域泛化等方面仍存在瓶颈,也是当前研究的核心热点:

5.1 极端尺度场景适配不足

复合缩放策略虽能平衡多维度,但在超小目标、超大分辨率图像等极端场景下仍存在局限。例如,处理像素占比低于1%的超小目标时,EfficientNet的深层特征易丢失小目标信息;处理1024×1024以上超大分辨率图像时,计算量激增,难以维持实时性,如同“用标准尺码的工具处理极端尺寸的工件”,适配性不足。

5.2 架构灵活性欠缺

EfficientNet的复合缩放依赖固定的基础网络结构与缩放系数,缺乏针对特定任务的自适应调整能力。例如,目标检测任务更需宽网络捕捉细粒度特征,而图像分类任务更需深网络捕捉抽象特征,但EfficientNet的固定缩放比例难以适配不同任务的需求,灵活性低于可变形卷积、神经网络搜索(NAS)生成的架构。

5.3 低数据与跨域泛化能力薄弱

EfficientNet的高性能依赖大规模标注数据(如ImageNet),在小样本、跨域场景下泛化能力差。例如,从自然场景迁移到医疗影像、遥感影像等异质场景时,由于特征分布差异较大,模型性能大幅下降;在小样本场景下,复合缩放带来的规模优势难以发挥,精度甚至低于轻量化小模型。

5.4 边缘设备部署的效率瓶颈

尽管EfficientNet-Lite系列已做轻量化优化,但在资源极度受限的边缘设备(如树莓派、嵌入式传感器)上,推理速度仍难以满足实时需求。SE模块、多尺度特征融合等组件虽提升精度,但增加了硬件计算负担,如何在极致轻量化的同时保留核心性能,仍是工业落地的关键难题。

六、总结与展望:CNN架构设计的未来方向

6.1 核心价值总结

EfficientNet的核心贡献并非提出全新网络结构,而是确立了“复合缩放”这一CNN架构设计的底层逻辑,打破了传统单一维度缩放的盲目性,证明了“精度与效率的平衡可通过数学化策略实现”。其融合轻量化基础结构与注意力机制的设计思路,为后续CNN与Transformer融合架构提供了重要参考,成为连接传统CNN与现代视觉模型的桥梁。

6.2 未来研究与应用展望

结合当前研究趋势与技术瓶颈,EfficientNet及复合缩放策略的未来演进将向“自适应化、多模态融合、轻量化、可解释化”四大方向发展,以下四个方向值得重点关注:

任务自适应复合缩放:基于神经网络搜索(NAS),为不同任务(分类、检测、分割)自动优化缩放系数与基础网络结构,打破固定比例限制。例如,检测任务自动提升宽度与分辨率缩放比例,分类任务自动提升深度缩放比例,实现任务定制化优化。

多模态与跨域融合优化:将复合缩放策略拓展至多模态模型(如图像-文本、图像-点云),通过同步缩放不同模态的特征提取模块,提升多模态融合效率;结合自监督学习与元学习,增强模型在小样本、跨域场景下的泛化能力,拓展EfficientNet的应用边界。

极致轻量化与硬件感知设计:基于硬件感知NAS,设计适配特定硬件(CPU、GPU、FPGA)的EfficientNet变体,自动调整网络结构与缩放系数以匹配硬件计算特性;进一步精简注意力模块与特征融合路径,在边缘设备上实现“实时推理+高精度”的双重突破。

与新兴架构的深度融合:将复合缩放策略与可变形卷积、视觉Transformer、动态卷积等新兴技术融合,弥补CNN局部感受野的局限。例如,设计“卷积提取局部特征+Transformer捕捉全局关联”的混合架构,通过复合缩放同步优化两部分结构,实现精度与效率的再提升。

EfficientNet的出现,标志着CNN架构设计从“经验驱动”走向“数学化、精细化驱动”。尽管目前仍存在极端场景适配、跨域泛化等难题,但随着自适应架构、硬件感知设计、多模态融合等技术的发展,复合缩放策略将持续赋能视觉模型优化,为自动驾驶、边缘计算、医疗诊断等领域提供高效可靠的技术支撑。对于研究者而言,围绕EfficientNet的核心痛点,结合前沿技术探索架构创新,既能产出具有学术价值的成果,又能为工业落地提供关键支撑。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册