【前文回顾】超节点生态正处在一个技术爆炸、标准重塑、群雄逐鹿的时代。当前超节点产业链已形成器件、整机、软件、服务四层协同体系。从底层的器件创新,到顶层的服务落地,再到开放的生态合作与复杂的异构融合,每一个环节都充满了挑战与机遇。2026年将成为超节点规模化商用拐点,未来生态竞争将从硬件性能转向软硬协同能力,开放协议与跨厂商适配成为制胜核心。

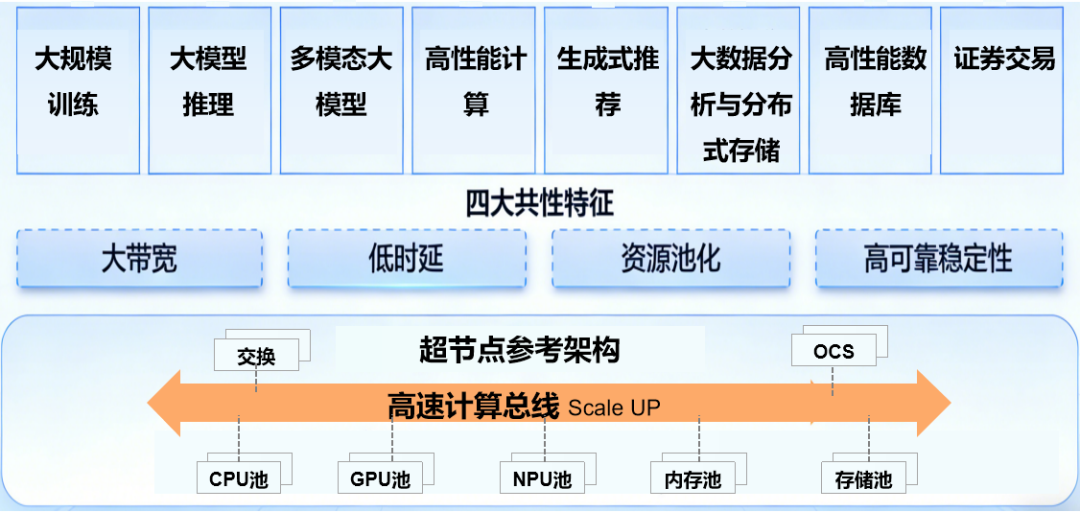

本篇将聚焦于超节点在关键领域的应用,从大规模训练、大模型推理、多模态AI、高性能计算(HPC)、生成式推荐,到大数据分析、分布式存储、高性能数据库、极速证券交易,分析各场景的技术挑战、解决方案与超节点所带来的具体收益。

超节点核心技术突破性价值

超节点是一种以通信为中心,通过软硬件协同设计,将大规模计算资源池化并呈现为单一系统的新型计算架构。它的出现,标志着计算基础设施从“量变”的堆砌走向了“质变”的系统性融合,是应对后万亿大模型时代算力挑战的关键路径。

超节点是将大量计算芯片紧密耦合为单一高速互连域的技术架构

①大带宽:打破数据传输壁壁垒

传统数据中心采用以太网或RDMA网络联接计算节点,虽然带宽不断提升,但在大规模、高密度的AI训练中,节点间的通信开销仍是主要瓶颈。超节点通过专有的片间/节点间互联技术,将通信带宽提升了数个数量级。以华为CloudMatrix384超节点为例,其单卡互联带宽达到800GB/s,远超传统PCle/以太网架构,384节点内Scale UP互联带宽超过240TB/s,实现了芯片间前所未有的带宽水平。

②低时延:实现高效紧密协同

当前大模型训练与推理的实现依赖并行计算。在需要频繁、大批量数据交换的并行计算任务中,通信延迟是决定整体性能的关键。超节点的架构设计将通信路径极致缩短,显著降低了芯片间通信延迟。这种低时延特性在AI训练、AI推理和科学计算等场景中尤为重要,可使整体系统响应速度大幅提升。

③资源池化:构建巨型“计算机”,拥有巨大的计算资源和内存资源

超节点通过高速互联总线和内存统一编址技术,将分散的计算资源、内存和存储整合为共享资源池。超节点高带宽、低延迟的互联网络打破了物理服务器的内存墙,将所有计算单元的内存(HBM)和系统内存(DDR)汇聚成一个统一的、可由任何计算单元访问的巨大内存池 。华为CloudMatrix 384 平台拥有高达48TB,英伟达NVL72 平台提供了高达13.5 TB内存,这使得整个机柜可以直接容纳万亿参数级别的大模型,无需进行复杂的模型切分和跨节点数据加载,从根本上简化了超大模型的训练和推理过程。

④高可靠稳定性:支撑超大规模持续计算

大规模AI训练等任务通常需要持续运行数周甚至数月,对系统的稳定性和可靠性提出了极高的要求。超节点架构通过一体化设、系统级优化、冗余设计与快速故障切换机制,提升了整体的可靠性,确保系统长期稳定运行。华为超节点CloudMatrix 384支持万卡级集群的40天不间断训练,而传统集群通常因通信问题导致训练中断,需重新开始。

超节点推动产业从"单点性能比拼"迈入"系统级效率竞争”

超节点通过系统级优化,真正实现了"让集群像一台计算机一样工作"的愿景,算力利用率大幅提升,单位推理成本的指数级下降。超节点解决通信墙瓶颈,传统AI集群随着规模扩大,通信开销占比急剧上升。研究表明,千亿参数模型训练时,跨节点通信开销可高达35%。超节点通过高带宽、低时延互联,将通信带宽利用率从传统架构的60-80%提升至92%以上,显著降低通信开销。

超节点应用场景01:

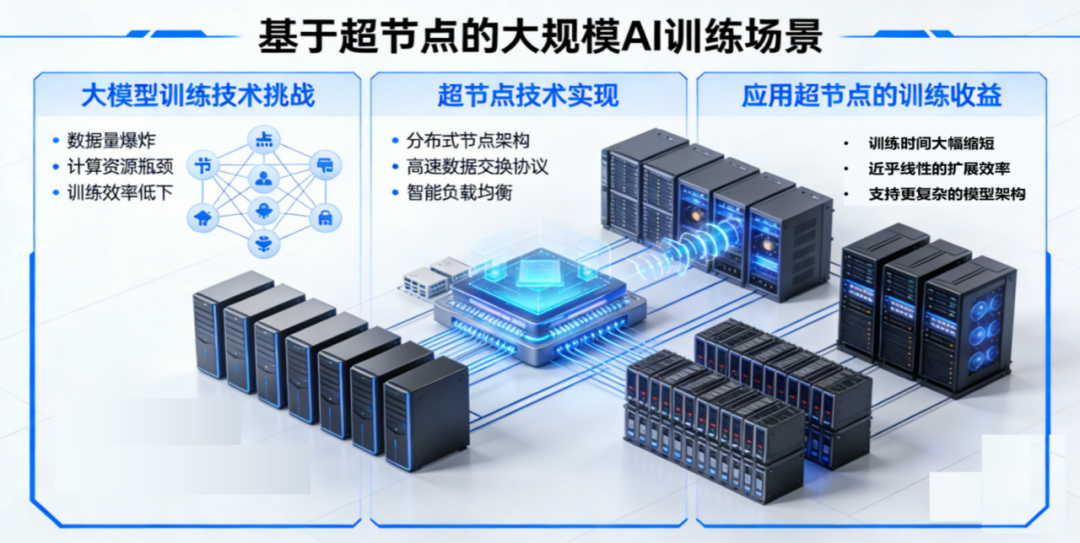

大规模AI训练

AI大模型的出现,尤其是参数量从百亿、千亿向万亿迈进,对算力的需求达到了前所未有的高度。万亿参数大模型的预训练需要在PB级的海量数据上进行长达数周甚至数月的计算。过程涉及频繁的全局梯度同步和模型参数交换,对计算集群的并行计算效率和网络通信能力提出了极致要求。

大模型训练的技术挑战:

-

通信瓶颈:万亿参数模型的训练涉及多种并行策略。数据并行(DP)中的All-Reduce梯度同步、张量并行(TP)中的数据切片交换、流水线并行(PP)中的激活值和梯度传递,都会在数千个GPU之间产生巨大的通信流量。在传统网络下,通信时间甚至会超过计算时间(通信不能被有效掩盖),导致GPU利用率(MFU, Model FLOPs Utilization)劣化 。

-

线性扩展效率:随着集群规模的扩大,通信开销呈非线性增长,导致整体训练性能的提升远低于计算节点的线性增加,即“扩展效率”急剧下降。

-

内存容量:单个GPU的显存(NVIDIA H10080GB)远不足以容纳整个模型参数、梯度和优化器状态,必须采用复杂的模型切分和数据卸载技术。

-

训练稳定性差: 大规模集群易受单点故障影响,传统集群通常难以实现长期稳定训练,而Al大模型训练周期长达数周至数月。

超节点技术实现:

-

极致优化的并行计算:AI大模型采用混合并行策略,采用TP(张量并行)+PP(流水线并行)+EP(专家并行),百纳秒级的节点内ScaleUP高速互联网络(NVLink、华为UB等),是实现并行计算的理想选择,将通信延迟降至最低,使得整体训练时间缩短。

-

打破通信瓶颈:NVL72的NVLink 和CloudMatrix 384的超高带宽UB网络,为All-Reduce等操作提供高速公路。全互联拓扑使得任意两个计算单元间的通信路径最优,极大降低了梯度同步的延迟,使通信时间在总训练时长中的占比显著下降 。

-

统一内存简化编程:内存池化技术使得模型参数、梯度和优化器状态可以被灵活地划分并存放在全局内存池中,由系统自动管理,大大简化了开发者的编程负担。

-

消除内存墙:华为CloudMatrix 384的48TB 和英伟达NVL72的13.5TB 统一内存池,可以直接“装下”万亿参数模型。意味着开发者可以极大简化甚至无需进行复杂的模型切分,将精力更多地投入到模型算法创新上。模型参数和中间结果可以在统一内存空间中自由流动,避免了传统架构中跨节点内存访问的性能骤降问题。

应用超节点的训练收益:

-

训练时间大幅缩短:超节点能将过去需要数月训练周期的万亿模型,缩短至数周甚至更短。研究表明,基于Scale UP总线的超节点,能将LLM训练速度提升20%以上。

-

近乎线性的扩展效率:通过软硬件协同设计,超节点能够实现计算与通信的高度重叠,减少计算单元的空闲等待。超节点集群在扩展至数千甚至上万个GPU时,依然能保持极高的扩展效率,有效利用算力投资。

-

赋能更大规模的模型:使得训练数万亿乃至数十万亿参数的下一代基础模型成为可能,为实现通用人工智能(AGI)奠定算力基础。

-

支持更复杂的模型架构:超节点特别适合MoE(Mixture of Experts)通信密集型模型架构。MoE模型中,数据需要在不同的“专家网络”之间动态路由,对网络的带宽和延迟要求极高。

-

稳定性提升:华为超节点支持万卡集群的40天不间断训练,而传统集群通常因通信问题导致训练中断,需重新开始。

超节点应用场景02:

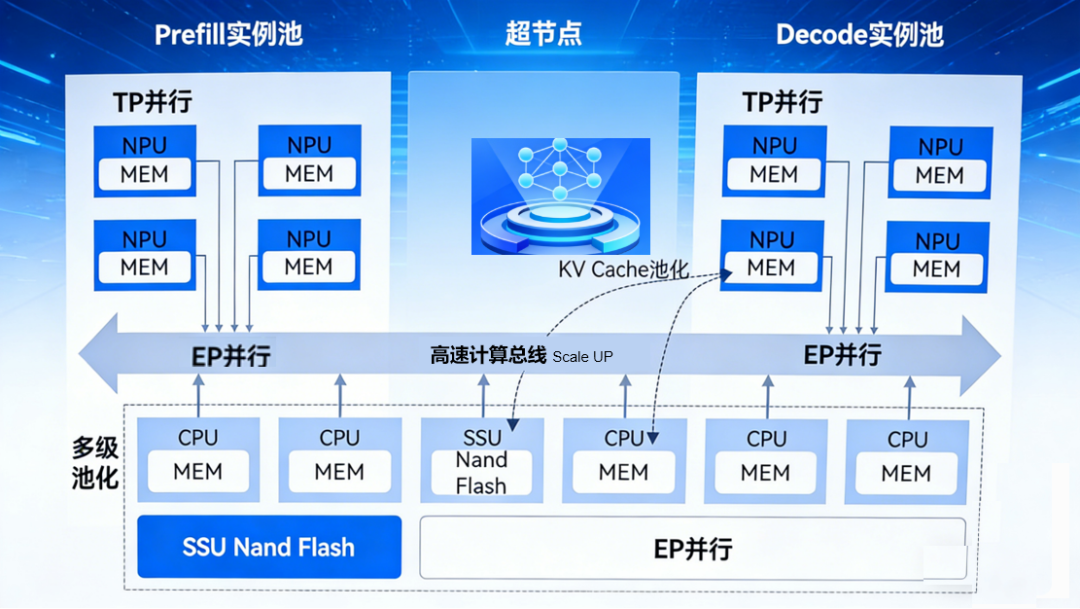

大模型推理

模型训练完成后,部署用于在线服务(推理)同样是巨大的挑战。单个大模型可能无法装入单个或少数几个GPU中,需要进行张量并行或流水线并行部署。超节点凭借其低延迟互联,能够确保在模型被切分到多个芯片上时,依然能实现极低的推理延迟,满足实时交互的需求 。同时,超节点的高计算密度也使其能够同时服务于海量用户的并发请求,提供高吞吐量的推理服务。

大模型推理技术挑战:

-

低延迟要求:对于实时交互应用,首个令牌(Token)的生成延迟(Time to First Token, TTFT)至关重要,直接影响用户体验。

-

KV缓存内存爆炸:对于需要处理长文本、长对话历史的Agentic AI或大模型应用,其推理过程中产生的键值缓存(KV Cache)会随着上下文长度线性增长,迅速耗尽单张GPU的显存,成为服务并发能力和成本的主要限制因素 。

-

高吞吐量需求:服务需要同时处理成千上万用户的并发请求,对系统的总处理能力(Tokens per second)要求极高。

-

Agentic AI的复杂交互流:Agentic AI并非简单的“输入-输出”模式,它涉及工具调用、环境交互、长期规划和记忆更新等一系列复杂步骤,形成了动态、多轮次的计算流,对系统的调度灵活性和端到端延迟提出了极高要求。

超节点技术解决方案:

-

低延迟: 在许多在线推理服务中,如RAG搜索、对话机器人、智能体等,用户的等待容忍度极低,要求系统在几百毫秒甚至几十毫秒内返回结果。对于参数量高达万亿的大模型,即使是处理单个请求,其计算量和显存占用也可能超出单个GPU的能力范围。因此,必须采用模型并行(如张量并行、流水线并行)将模型部署在多个GPU上。在推理过程中,数据需要在这些GPU之间快速流动,任何通信延迟都会直接累加到最终的用户响应时间上。超节点内部的微秒级互联是保证大模型能够实现低延迟推理的物理基础。

-

高吞吐:像在线推理服务,需要同时为数百甚至上千的并发用户提供服务。这意味着推理系统必须具备极高的吞吐能力(每秒处理的请求数,QPS)。超节点通过其高计算密度,可以在一个紧凑的物理空间内部署大量的计算单元,形成一个强大的推理资源池。结合动态批处理等技术,可以高效地处理海量并发请求,实现极致的吞吐性能。

-

分布式KV缓存池:利用超节点的内存池化能力,构建一个跨越多台服务器的分布式KV缓存池。当推理请求到来时,其KV缓存可以动态地存放在这个全局共享的内存池中,任何一个GPU都可以通过高速网络快速访问。这不仅突破了单卡显存瓶颈,还使得在不同请求之间共享和复用KV缓存前缀(Prefix Caching)成为可能,大幅提升了系统的吞吐量和效率 。

-

内存池化与统一编址:通过内存统一编址技术,实现跨设备内存共享,支持多轮次推理所需的大缓存需求。

应用超节点的推理收益:

-

支持超长上下文推理:使得大模型能够处理数十万甚至上百万token的上下文,极大地增强了其理解复杂问题和执行长期任务的能力。

-

提升Agentic AI的智能与效率:为Agentic AI提供了强大的记忆和快速反应能力,使其能够更高效地完成复杂任务,成为真正实用的智能体。

-

吞吐量提升:华为Cloud Matrix 384单卡decode吞吐达1920tokens/s,混合并行策略使推理吞吐量。大幅提升

-

显存利用率提升:通过内存池化技术,显存利用率从传统架构的提升显著,单位推理成本下降明显。

超节点应用场景03:

多模态大模型

随着AI从文本向图像、视频、音频等多模态领域拓展,模型的复杂度和计算量进一步增加。多模态内容的理解与生成任务,如文生图、文生视频等,都依赖于超节点提供的强大算力进行高效的训练和推理。

多模态AI技术挑战:

-

数据表示与融合:多模态模型需要融合文本、图像、视频等多种数据,不同模态的数据需要通过各自的编码器(Encoder)转换成统一的向量表示,然后在模型深层进行复杂的交互和融合。这过程涉及大量的数据搬运和跨模态注意力计算,对带宽和延迟提出更高要求。

-

内存开销巨大:尤其是处理高分辨率图像和长视频时,中间激活值的体积会急剧膨胀,对内存容量和带宽都提出了严峻的考验,传统架构难以满足。

-

计算复杂性高:多模态模型往往由多个庞大的单模态模型组合而成,整体计算量远超单一模态模型。同时,跨模态特征提取和对齐需要大量数据交换,通信开销成为主要性能瓶颈。

超节点技术解决方案:

-

统一内存承载多模态数据:CloudMatrix 384或NVL72的数十TB内存池可以轻松容纳下所有模态的原始数据、编码器以及巨大的融合模型。所有数据都在一个统一的内存地址空间内,避免了传统架构中因数据在CPU内存和GPU显存之间来回拷贝而造成的性能瓶颈,显著提升跨模态数据传输效率。

-

高带宽加速跨模态融合:模型在进行跨模态注意力计算时,需要在一个模态的表示(如文本)和另一个模态的表示(如图像的视觉Token)之间进行密集的交互。超节点内部的NVLink或UB网络为此类计算提供了超高速通道,确保了不同模态信息流的无缝融合。

应用超节点的收益:

-

实现更复杂的融合策略:充裕的内存和带宽资源,使得研究人员可以探索更精细、更深度的跨模态融合机制,而不用过分担心计算资源的限制,从而催生出性能更强大的多模态模型。

-

支持实时多模态交互:在视频理解、实时翻译+视觉场景描述等应用中,超节点能够以极低的延迟完成“感知-理解-生成”的完整闭环,为实现真正智能的多模态数字人或机器人助手提供了算力基础。

-

资源利用率提升:内存池化技术使多模态模型支持兆级上下文长度处理,内存利用率从传统架构的50%提升至80%以上,减少硬件资源浪费。

超节点应用场景04:

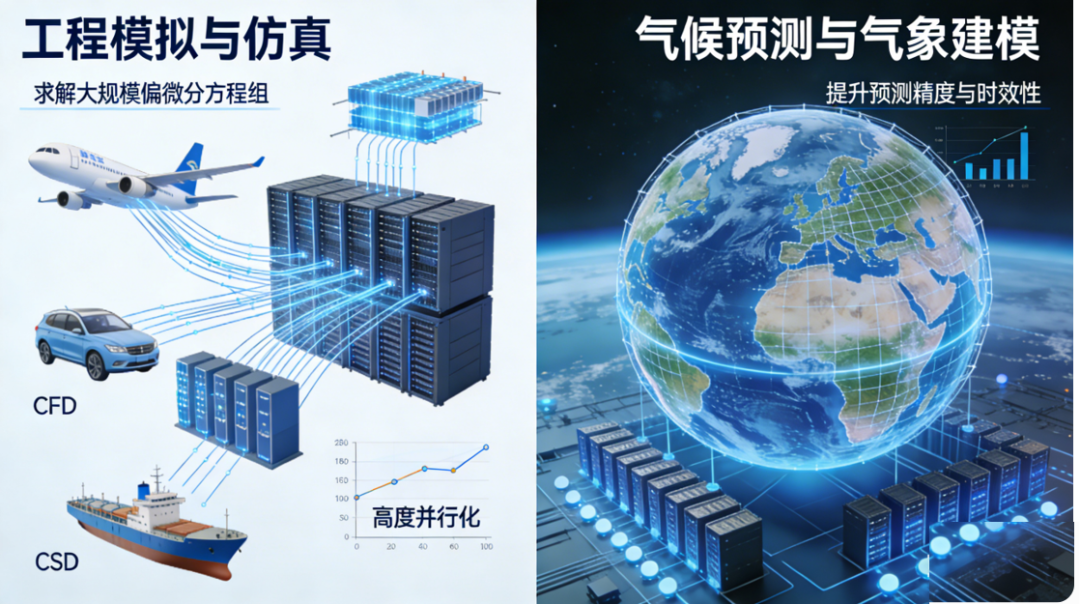

高性能计算(HPC)

在AI浪潮之前,超算的主要应用领域是科学与工程计算,而超节点架构正是脱胎于高性能计算,并反哺这一领域。

-

工程模拟与仿真:在航空航天、汽车制造、船舶设计等领域,复杂的流体力学(CFD)、结构力学(CSD)模拟需要求解大规模偏微分方程组,这些任务可以被高度并行化,完美适配超节点的计算模式 。

-

气候预测与气象建模:全球气候模型需要对地球大气、海洋、陆地等多个圈层进行精细网格划分和长时间尺度的模拟,计算量极其庞大。超节点能够提供所需的大规模并行计算能力,以提升预测的精度和时效性 。

高性能计算技术挑战:

-

通信延迟主导性能:在流体力学、气象预报、材料科学等领域的模拟计算中,整个问题空间被划分为无数个网格,分配给成千上万个计算核心。这些核心需要频繁地与相邻核心交换边界数据,这种通信模式对网络延迟极为敏感。

-

紧密耦合的计算:许多科学计算和图计算任务都属于“强扩展”应用,即计算性能高度依赖于节点间的通信延迟。在传统网络中需要很长时间才能完成,导致大量计算时间被浪费在等待上。

-

内存与I/O限制:超大规模的科学模拟,其状态数据可能达到PB级别,远超任何单节点的内存容量。同时,模拟过程中的检查点(Checkpointing)操作需要极高的I/O带宽,以避免长时间中断计算。

-

资源利用率低: 许多应用的性能瓶颈不在于浮点计算能力,而在于内存带宽,即处理器从内存中获取数据的速度。传统HPC系统内存利用率和算力利用率较低(<30%),资源浪费严重。

超节点技术解决方案:

-

纳秒级延迟网络:超节点的内部互联网络,其纳秒级的延迟特性,完美匹配了HPC应用中细粒度、高频次的通信需求,能将MPI消息传递的开销降至物理极限。

-

全局共享内存编程模型:内存池化技术可以为HPC应用提供一个巨大的、逻辑上统一的共享内存空间。程序员可以像操作本地内存一样读写这个全局空间,从而避免了复杂的消息传递编程,并能实现更高效的算法。

-

高性能并行I/O:分布式存储池,通过高速互联网络对外提供服务,能够满足大规模模拟计算对检查点和数据可视化所需的海量I/O吞吐。

应用超节点的收益:

-

加速科学发现:将原本需要数月甚至数年的模拟计算时间缩短到几天或几周,极大地加速了科学研究和工程设计的迭代周期。

-

求解更大规模问题:使科学家能够模拟更精细、更复杂的物理现象,例如,在全球尺度上进行更高分辨率的气候模拟,或在原子级别上设计新材料。

-

促进HPC与AI融合:超节点作为一个统一的高性能平台,天然适合运行结合了物理模拟和AI的新型工作流,例如使用AI模型替代高成本的模拟计算(AI surrogate modeling),或利用AI进行海量模拟数据的实时分析。

-

资源利用率优化: 通过减少通信开销和提高资源利用率,内存利用率提升至50%以上。

超节点应用场景05:

生成式推荐

个性化推荐是一种信息过滤技术,其核心目标是根据用户的历史行为、偏好、人口统计学特征以及当前的上下文信息,预测用户可能感兴趣的物品(如商品、新闻、音乐、视频),并以列表等形式呈现给用户 。

生成式推荐是个性化推荐领域的一个新兴且革命性的方向。它不再仅仅是预测一个物品被点击的概率,而是利用生成式模型(尤其是大型语言模型LLM)来直接生成推荐结果或解释 。例如,它可以为用户生成一段话,解释为什么推荐某几件商品,或者直接生成一个符合用户需求的购物清单。这种方式更加灵活、可解释,并且能够更好地理解用户的复杂、模糊意图 。

技术挑战:

-

推荐大规模训练: 主流电商或内容平台的推荐模型,需要在包含千亿甚至万亿级别用户行为样本的数据集上进行训练。这些模型的参数量也已达到百亿甚至千亿级别。这种超大规模的训练任务,需要超节点提供强大的分布式并行训练能力。

-

实时特征工程与模型更新: 为了捕捉用户兴趣的动态变化,推荐系统需要近乎实时地处理用户行为数据,更新用户和物品的特征(Embedding),甚至进行模型的增量学习或在线更新。这要求系统具备强大的实时数据处理和计算能力。

生成式推荐技术解决方案:

-

生成式推荐的推理过程:生成式推荐的核心是大型语言模型。用户发出一个请求时,系统需要:1)理解用户意图;2)从海量物品库中检索(召回)少量候选物品(向量数据库);3)将用户信息和候选物品信息输入到LLM中;4)LLM进行推理,生成最终的推荐结果(可能是排序列表或一段自然语言)。这个过程链条长,且核心环节是LLM推理,对延迟极其敏感。因此,支撑生成式推荐的后端基础设施,必须具备超节点级别的低延迟、高吞吐大模型推理能力。

-

推荐系统:为了实现实时、精准的推荐,系统需要快速访问存储了亿万用户和物品特征的巨大Embedding表。这些表通常达到TB级别,无法完全载入单个服务器内存,导致需要复杂的多级缓存和分片策略,不仅增加了延迟,也加大了系统复杂性。

-

全局统一Embedding表:对于推荐系统,可以将整个TB级的Embedding表完整地加载到超节点的全局内存池中。集群内所有的推荐模型推理服务,都可以通过高速网络以接近本地内存访问的速度,直接、随机地访问这张表的任何位置。这彻底消除了数据分片和缓存未命中的问题。

-

大带宽、低时延全互联:超节点采用全互联架构,减少数据传输路径,降低推荐系统延迟。

超节点带来的收益:

-

提升推荐效果与体验:允许使用更大、更复杂的推荐模型,从而提升推荐的精准度。同时,将推荐服务的延迟降低到毫秒级,显著改善用户体验。

-

处理效率提升: 在推荐系统场景中,推荐模型训练效率大幅提升,处理效率提升数倍,整体响应时间大幅缩短。

-

成本降低: 通过减少数据移动和优化资源利用率,单位推荐请求处理成本下降。

超节点应用场景06:

大数据分析与分布式存储

超节点可与分布式存储、大数据分析实现技术层深度融合,实现存算传一体化协同,突破传统架构下大数据分析的效率瓶颈。

技术挑战:

-

存算分离的I/O瓶颈:以Hadoop HDFS和MapReduce/Spark为代表的传统大数据架构,其计算节点和存储节点分离。在数据混洗(Shuffle)、读取和写入过程中,大量的中间数据需要通过网络在存算节点间传输,这成为制约分析效率的核心瓶颈。

-

存储性能滞后:随着CPU/GPU计算速度的飞速提升,传统基于硬盘(HDD)甚至普通SSD的分布式存储系统,其I/O性能已远远跟不上计算的需求,形成了“I/O墙”。

-

数据倾斜问题: 数据分布不均导致部分节点负载过重,整体效率下降。

超节点解决方案:

-

构建超融合架构:超节点在逻辑上将存算资源融为一体。其内存/存储资源池可以被视为一个性能极致的分布式文件系统。热数据和中间结果可以直接缓存在由DRAM构成的全局内存池中,实现内存级的数据访问速度 。

-

赋能大规模内存计算:对于Spark等内存计算框架,超节点可以提供一个PB级别的统一内存空间。这意味着超大规模的数据集或复杂的中间计算结果(如RDDs)可以完全保留在内存中进行处理,彻底消除了磁盘I/O的开销。节点间的数据交换也通过纳秒/微秒级的互联网络完成,极大地加速了数据分析流程。

-

近数据处理与统一管理:分析任务会被智能调度到数据分片所在的物理节点附近执行,最大化数据本地性 。整个集群作为一个单一的资源池进行管理,大大简化了资源规划和运维工作 。

应用超节点的收益:

-

数量级的性能提升:显著缩短ETL、数据查询、机器学习等大数据作业的运行时间,例如,Crail等高性能存储架构在Spark应用上展示了显著的性能提升 。

-

架构简化与成本节约:统一的架构降低了管理复杂度和硬件冗余,通过更高的资源利用率和性能,企业可以用更少的硬件完成更多的工作,从而节省了大量的资本支出(CAPEX)和运营支出(OPEX) 。

-

支持实时数据分析:极致的I/O性能使得对流式数据的实时分析和即席查询成为可能,帮助企业更快地从数据中获取洞察。

超节点应用场景07:

高性能数据库

超节点与高性能数据库的结合主要体现在架构级协同。通过内存语义互联协议,超节点将分布式内存池化,为数据库提供统一的全局内存视图,使跨节点数据访问延迟接近本地内存。超节点的全局统一管控能力可强化数据库的资源调度与故障容灾能力,保障金融、政企等场景下高性能数据库的高可用、高可靠运行,适配PB 级数据的高效处理需求。

技术挑战:

-

数据库:传统磁盘数据库受限于I/O性能。内存数据库虽然速度快,但容量和扩展性受单机物理内存限制。分布式数据库在执行跨节点事务和Join操作时,会引入显著的网络延迟。

-

内存墙限制: OLAP复杂查询需要处理海量数据,传统单机内存容量有限。

-

锁竞争问题: OLTP高并发事务场景中,锁竞争导致性能下降。

-

分布式事务开销: 跨节点数据一致性维护成本高,影响事务处理效率。

-

I/O延迟高: 存储与计算分离导致数据访问延迟高,影响查询性能。

技术解决方案:

-

零拷贝数据交换:内存池化支持数据"零拷贝"交换,减少OLTP锁竞争,优化OLAP查询性。

-

构建巨型内存数据库:整个超节点的内存池可以被虚拟化为一个拥有数十TB甚至PB级内存的单一逻辑数据库服务器。所有数据常驻内存,查询和事务处理都在内存中完成。超低延迟的互联网络保证了跨物理节点的事务一致性,其性能远超传统分布式数据库。

超节点带来的收益:

-

极致数据库性能:为在线事务处理(OLTP)和在线分析处理(OLAP)负载提供前所未有的性能,实现对海量数据的实时分析和响应。

-

简化系统架构:通过构建全局统一的数据视图,大大简化了数据库和推荐系统的设计,降低了开发和维护成本。

超节点应用场景08:

证券交易

超节点以算力、时延与可靠性优势,助力证券交易系统实现高吞吐、低时延、高可用的运行目标。

技术挑战:

-

纳秒级的延迟竞争:在高频交易(HFT)领域,延迟是决定成败的唯一标准。从接收交易所行情数据,到策略计算,再到发出订单,整个链路的延迟必须控制在微秒甚至纳秒级别 。

-

确定性与高吞吐:交易系统必须能够持续、稳定地处理海量的市场行情更新和数万笔的订单请求,任何网络抖动或处理延迟都可能导致巨大的交易损失。

-

数据一致性与可靠性:交易系统必须达到金融级的“五个九”(99.999%)甚至更高的可用性,并具备在发生故障时瞬时切换到备用系统的能力 。

超节点解决方案:

-

硬件级的延迟消除:交易系统中的各个微服务模块(行情解码、策略引擎、风险控制、订单网关)可以部署在超节点的不同计算单元上。它们之间的通信不再通过传统的网络协议栈,而是通过直接读写全局共享内存来完成。例如,行情解码模块将解析后的订单簿(Order Book)直接写入共享内存,策略引擎立即就能看到更新并做出决策,整个过程的内部延迟可以降低到纳秒级。

-

统一内存状态机:整个交易所的市场状态、交易员的持仓、订单状态等,都可以作为一个统一的状态机,完整地保存在超节点的内存池中。这保证了所有策略模块都能访问到全局一致、实时的数据视图,避免了因数据同步延迟导致的决策错误。

-

内建的瞬时容错:可以在同一个超节点内运行一个主交易系统和一个或多个热备份系统。所有系统都连接到同一个内存池。主系统实时将自己的核心状态写入共享内存,备份系统则实时“观察”这些状态。一旦主系统心跳中断,硬件级的仲裁机制可以在纳秒内完成切换,由备份系统接管,实现几乎零中断的故障转移 。

应用收益:

-

获得极致的速度优势:将系统内部的通信和处理延迟压缩到物理极限,为交易策略赢得宝贵的执行时间窗口。

-

提供确定性性能保障:消除由网络拥塞和操作系统调度带来的延迟抖动,确保交易策略在任何市场条件下都能以可预测的延迟执行。

-

实现金融级的稳定可靠:提供比传统基于网络的HA(High Availability)方案更快、更可靠的容错机制,保障交易业务的连续性。

结论

超节点架构,以其超大带宽、超低时延、资源池化和高可靠性的核心特征,正成为驱动下一代人工智能、大数据和科学计算发展的关键引擎。它通过从根本上重塑数据中心的计算范式,有效解决了传统架构在面对极端计算负载时所遭遇的通信和I/O瓶颈。无论是在加速万亿参数模型的训练与推理,还是在赋能实时大数据分析和纳秒级金融交易等要求苛刻的场景中,超节点都展现出了无与伦比的潜力与价值。

更多超节点相关议题将在2026 Open AI Infra Summit上迎来集中探讨与实践交流。无论你是技术研发人员、企业决策者还是科研工作者,都能在这里突破瓶颈、链接资源、预判趋势。现大会报名通道已开启,展位与赞助席位已同步开放,欢迎扫描下方二维码报名,共话下一代算力格局!

即刻扫码报名>>

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册