16核32G服务器Nginx优化实战:稳扛16万并发,小白也能看懂

一、为啥要优化?默认配置太“浪费”

如果你用16核32G的高配服务器跑Nginx,却还用默认配置,就像开着8缸的跑车却只踩1档——硬件性能完全没发挥出来,高并发时要么卡到超时,要么CPU/内存空耗。

这篇文章不讲虚的,全程大白话,给你一套能直接复制的16核32G专属Nginx优化配置,核心就3个原则:

- 把16核CPU的算力吃满,不闲置;

- 把32G内存的优势用够,少做无用功;

- 不盲目调大参数,避免服务器“过载崩溃”。

最终目标:稳定支撑≈16万总并发,不管是静态资源、反向代理还是公网API,都能扛住。

二、先搞懂核心逻辑:16万并发咋来的?

新手先记一个简单公式:

总并发数 = worker_processes(工作进程数) × worker_connections(单进程最大连接数) / 2

- worker_processes auto:Nginx自动识别16核CPU,给每个核分配1个工作进程(共16个);

- worker_connections 20480:每个进程最多处理2万连接;

- 除以2:因为HTTP是“双向连接”(Nginx↔客户端),1个用户连接实际占2个“连接名额”;

算下来:16×2万/2=16万,这就是我们的核心并发目标。

三、直接抄作业!16核32G专属Nginx配置

下面配置分模块标注了“人话解释”,复制到你的nginx.conf里就行(记得改日志/目录路径)。

# ===================== 全局配置(给16核CPU“分工”) =====================

# 用nginx普通用户运行,避免root权限风险(先执行:useradd -r -s /sbin/nologin nginx)

user nginx nginx;

# 自动匹配16核CPU,1核1个工作进程,不浪费

worker_processes auto;

# 把进程绑定到CPU核上,减少“来回切换”的开销

worker_cpu_affinity auto;

# 给文件描述符留足余量(20万),避免报“too many open files”

worker_rlimit_nofile 204800;

# 日志只记错误,少写日志省IO

error_log /home/nginx/logs/error.log error;

pid /home/nginx/logs/nginx.pid;

# 让Nginx进程优先级高一点,但不抢系统资源

worker_priority -5;

# ===================== events模块(管高并发连接) =====================

events {

# 用Linux最牛的epoll模型,处理连接更快(别用select/poll)

use epoll;

# 一个进程一次性接完所有新连接,减少等待

multi_accept on;

# 单进程最多2万连接,16核总并发≈16万

worker_connections 20480;

# 关闭“惊群效应”,多个核处理连接不抢活

accept_mutex off;

# 空闲连接快速释放,不占坑

accept_mutex_delay 500ms;

}

# ===================== HTTP模块(榨干32G内存) =====================

http {

include mime.types;

default_type application/octet-stream;

# 零拷贝:内核直接传文件,不用绕弯,省CPU/内存

sendfile on;

# 批量发数据(省带宽)+ 小数据即时发(快响应),两不误

tcp_nopush on;

tcp_nodelay on;

# 长连接:60秒没动静就回收,既复用连接又不占资源

keepalive_timeout 60;

# 一个连接最多处理1万请求就关掉,防止内存泄漏

keepalive_requests 10000;

# 超时配置:别让无效连接占着茅坑不拉屎

client_header_timeout 15s; # 等请求头最多15秒

client_body_timeout 15s; # 等请求体最多15秒

send_timeout 60s; # 发响应最多等60秒

# 缓冲区:用32G内存当“缓存”,少重复计算

client_body_buffer_size 128k;

client_header_buffer_size 16k;

large_client_header_buffers 4 64k;

# Gzip压缩:16核扛得住5级压缩,省带宽又不费CPU

gzip on;

gzip_comp_level 5;

gzip_types text/plain text/css application/json application/javascript image/svg+xml;

gzip_min_length 1k; # 小于1k的文件不压,省CPU

gzip_vary on; # 告诉客户端“我压缩了”

# 反向代理缓冲(对接Java/其他后端时用)

proxy_buffer_size 64k;

proxy_buffers 4 256k;

proxy_busy_buffers_size 512k;

proxy_connect_timeout 10s; # 连后端最多等10秒

proxy_read_timeout 60s; # 等后端响应最多60秒

# 静态资源配置(前端文件直接返回)

server {

listen 80;

server_name localhost;

charset utf-8;

location / {

root /usr/share/nginx/html;

index index.html index.htm;

}

# 静态文件让客户端缓存7天,少发请求

location ~* \\.(css|js|jpg|png|gif|ico|svg)$ {

expires 7d;

add_header Cache-Control "public, max-age=604800";

}

# 500错误页

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/share/nginx/html;

}

}

}

四、必须同步改!系统级配置(不然优化白做)

Nginx配置再牛,系统限制没改也没用,下面两步照做:

1. 改内核参数(/etc/sysctl.conf)

编辑文件后执行sysctl -p生效:

# 监听队列大小匹配2万连接,避免连接排队溢出

net.core.somaxconn = 20480

# 网卡接收队列,适配16核高并发

net.core.netdev_max_backlog = 20480

# 应对突发连接,SYN队列放大

net.ipv4.tcp_max_syn_backlog = 20480

# 复用TIME_WAIT连接,少建连省CPU

net.ipv4.tcp_tw_reuse = 1

# 缩短连接释放时间(默认60秒→15秒)

net.ipv4.tcp_fin_timeout = 15

# 可用端口范围放大,避免端口不够用

net.ipv4.ip_local_port_range = 1024 65535

2. 改文件描述符限制(/etc/security/limits.conf)

# 给nginx和root用户放开文件描述符限制(20万)

nginx soft nofile 204800

nginx hard nofile 204800

root soft nofile 204800

root hard nofile 204800

改完后重启服务器,或者执行ulimit -n 204800临时生效。

五、进阶问题:2万连接能调更大吗?

很多人会问:能不能把worker_connections从2万调到4万、6万?

答案:能,但有条件,且不建议瞎调!

1. 调大的“安全上限”(16核32G)

| 2万(默认) | 6.4G(占32G的20%) | 公网所有场景 | 推荐,稳! |

| 4万 | 12.8G(占40%) | 内网高频短请求(如微服务对接) | 可选,性价比高 |

| 6万 | 19.2G(占60%) | 几乎无场景 | 不推荐,容易崩 |

| 8万 | 25.6G(占80%) | 禁止 | 必崩,内存/CPU直接过载 |

2. 调大到4万的前提(缺一不可)

- 改worker_rlimit_nofile到5万(留20%余量);

- 系统ulimit改到5万;

- 内核参数somaxconn等改到4万;

- 业务是内网固定客户端(别是公网零散用户)。

3. 为啥不建议调6万以上?

- 收益递减:2万→4万,并发翻倍;4万→6万,并发只涨50%,但内存/CPU开销翻倍;

- 稳定性差:一点突发流量就会挤爆内存,触发OOM;

- 内核扛不住:Linux处理6万连接时,网卡/TCP会先瓶颈,实际能用的连接远不到6万。

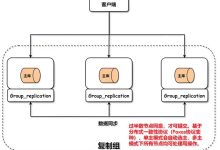

六、更优方案:比调大参数靠谱的做法

如果2万连接不够用,别死磕单节点:

七、验证优化效果:3个简单命令

配置完别光等,用3个命令看效果:

八、总结

如果你的业务是纯静态资源、或专门做反向代理,评论区说一声,我再给你针对性微调配置~

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册