文章总结与翻译

一、主要内容

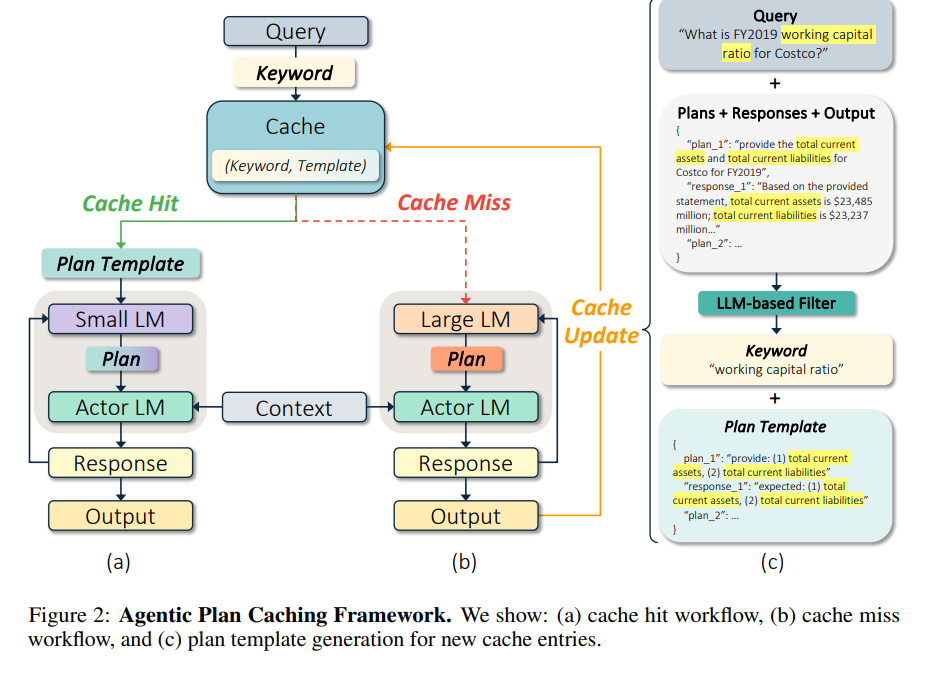

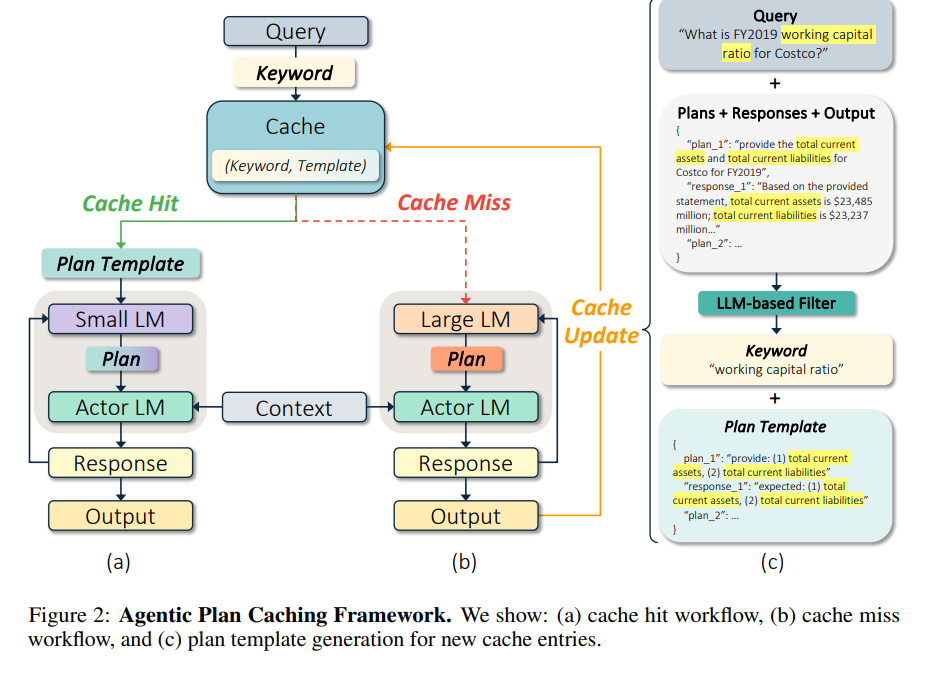

该研究针对基于大语言模型(LLM)的智能体(Agent)在复杂工作流中因大量规划和推理导致的高成本、高延迟问题,提出了一种名为Agentic Plan Caching(APC,智能体规划缓存) 的测试时内存机制。

核心背景

现有LLM缓存技术(如上下文缓存、语义缓存)主要为聊天机器人设计,聚焦查询级缓存,无法适配智能体应用的核心需求——智能体输出依赖外部数据和环境上下文,需在动态场景中做数据依赖决策,传统缓存难以分离查询核心意图与动态上下文。

该研究针对基于大语言模型(LLM)的智能体(Agent)在复杂工作流中因大量规划和推理导致的高成本、高延迟问题,提出了一种名为Agentic Plan Caching(APC,智能体规划缓存) 的测试时内存机制。

现有LLM缓存技术(如上下文缓存、语义缓存)主要为聊天机器人设计,聚焦查询级缓存,无法适配智能体应用的核心需求——智能体输出依赖外部数据和环境上下文,需在动态场景中做数据依赖决策,传统缓存难以分离查询核心意图与动态上下文。

评论前必须登录!

注册