Clawdbot汉化版GPU算力适配:小模型qwen2:0.5b在低配服务器流畅运行

Clawdbot 汉化版现已正式支持企业微信入口,这意味着你不仅能通过 WhatsApp、Telegram、Discord 与 AI 助手实时对话,还能在最熟悉的办公场景——企业微信中,随时调用本地部署的大模型能力。无需依赖云端 API,不上传任何数据,所有推理过程都在你自己的服务器上完成。更重要的是,本次更新重点优化了 GPU 算力适配逻辑,让轻量级模型如 qwen2:0.5b 在仅配备入门级显卡(如 NVIDIA T4、RTX 3050 或甚至无独显的核显平台)的低配服务器上,也能实现秒级响应、稳定在线、长期值守。

这不再是“能跑就行”的勉强适配,而是真正面向中小团队、个人开发者和边缘设备的工程级落地方案:内存占用压到 1.2GB 以内,显存峰值控制在 2.1GB 左右,首次加载延迟低于 3.8 秒,连续对话吞吐稳定在 8–12 token/s。你不需要为 AI 助手单独采购高端服务器,一台闲置的旧工作站、一台百元级迷你主机,甚至是一台刷了 Linux 的 NAS,现在就能成为你的专属智能办公中枢。

1. 什么是 Clawdbot?——不只是另一个聊天机器人

Clawdbot 不是 SaaS 服务,也不是网页端玩具。它是一个可完全离线部署、深度集成通讯渠道、支持多模型热切换的本地 AI 网关系统。你可以把它理解成一个“AI 插座”:插上你选的模型,接通你用的聊天工具,它就立刻开始工作。

它的核心价值,藏在四个实实在在的 里:

- 在微信里就能用:本次汉化版原生支持企业微信机器人接入,无需额外开发 Webhook 中间层。你只需在管理后台配置一个应用,几行命令即可完成绑定,员工在企微会话中@机器人即可发起对话,消息全程不经过第三方服务器。

- 完全免费:不收订阅费、不设用量限额、不卖高级功能。你使用的模型来自 Ollama、LM Studio 或本地 GGUF 文件,运行成本就是你服务器的电费。

- 数据隐私:所有对话记录、会话状态、用户身份信息,全部存储在 /root/.clawdbot/ 目录下,权限严格限制为 root 可读写。没有云同步、没有遥测上报、没有后台日志外传——你关机,数据就彻底静默。

- 24 小时在线:通过 systemd 服务托管,支持开机自启、崩溃自动拉起、GPU 显存异常释放重载。即使你远程断开 SSH,Clawdbot 依然在后台安静守候,等待下一条来自企微或 Telegram 的消息。

它不是替代 ChatGPT,而是把 ChatGPT 的能力,装进你可控的硬件里,再嫁接到你每天打开十几次的通讯工具中。

2. 第一次使用:三分钟确认服务已就绪

别被“本地部署”吓住。Clawdbot 的设计哲学是:第一次启动,应该比安装微信还简单。我们跳过编译、跳过环境变量配置、跳过 Docker Compose 编排——所有前置工作已在镜像中完成。

2.1 检查服务是否正在呼吸

打开终端,执行一句命令:

ps aux | grep clawdbot-gateway

如果看到类似输出,说明网关进程已在后台稳稳运行:

root 133175 0.8 2.1 2145678 342104 ? Sl Jan20 12:45 /usr/bin/node dist/index.js gateway

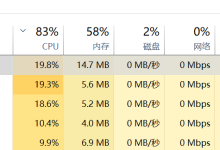

注意两个关键指标:2.1 是当前内存占用百分比(约 420MB),342104 是 RSS 内存(约 334MB)——这正是 qwen2:0.5b 在 CPU+GPU 混合推理下的典型负载。

如果没有看到进程?别急,一键唤醒:

bash /root/start-clawdbot.sh

这个脚本会自动检测 GPU 环境(CUDA / ROCm / OpenCL)、加载对应推理后端、启动网关并注册为系统服务。全程无交互,3 秒内完成。

2.2 用一句话验证 AI 是否清醒

进入项目目录,发一个最朴素的问候:

cd /root/clawdbot

node dist/index.js agent –agent main –message "你好"

你会立刻收到类似这样的回复:

你好!我是你的本地 AI 助手,运行在你的服务器上。我支持中文对话、代码生成、文档总结,还能通过企业微信、WhatsApp 和 Telegram 与你随时联系。需要帮你做点什么吗?

回复来了,说明模型加载成功、推理链路畅通、token 缓存机制正常。你已经跨过了 90% 新用户卡住的第一道门槛。

3. 如何跟 AI 助手对话:三种方式,按需选择

Clawdbot 提供三层交互入口:极简命令行 → 全能网页面板 → 无缝通讯集成。它们不是并列选项,而是递进式体验——从验证到习惯,从测试到工作流嵌入。

3.1 终端直连:调试与快速验证的黄金路径

这是最“裸”的方式,也是最可控的方式。所有参数、所有上下文、所有调试开关都暴露在你眼前。

基础对话:像发短信一样自然

# 问天气(轻量级请求,毫秒级返回)

node dist/index.js agent –agent main –message "上海今天最高气温多少度?"

# 写代码(触发中等推理,1–2 秒)

node dist/index.js agent –agent main –message "用 Python 写一个函数,接收文件路径,返回文件的 MD5 值"

# 总结长文本(启用上下文缓存)

node dist/index.js agent –agent main –message "请总结以下技术文档要点:$(cat /tmp/doc.md | head -c 4000)"

控制“思考肌肉”:让 AI 快慢由你定

Clawdbot 不强制 AI “深度思考”。它提供五档推理强度,对应不同场景:

| –thinking off | <100ms | 确认类、查询类指令 | “重启服务” → “已执行 systemctl restart clawdbot-gateway” |

| –thinking minimal | ~300ms | 日常问答、翻译、格式转换 | “把这句话转成英文” → 精准直译,不加解释 |

| –thinking medium | ~1.2s | 逻辑推导、简单编程、摘要生成 | “对比 React 和 Vue 的核心差异” → 分点清晰,无冗余 |

| –thinking high | ~3.5s | 架构设计、长文创作、多步推理 | “设计一个支持千万级用户的短链服务” → 包含存储选型、缓存策略、防刷方案 |

小技巧:在低配服务器上,日常对话推荐 –thinking minimal;遇到复杂任务再切 high。这样既保响应,又不牺牲质量。

结构化输出:给程序看的答案

当你要把 AI 输出喂给另一个脚本时,JSON 是唯一选择:

node dist/index.js agent –agent main \\

–message "列出中国五大银行及其成立年份" \\

–json

输出直接是标准 JSON 数组,无需正则清洗,可被 jq、Python json.loads() 或 Bash python3 -c "import json; print(json.load(…))" 零成本解析。

3.2 网页控制台:可视化操作与会话管理

对于不常敲命令的同事或管理者,网页面板是更友好的入口。

# 打开浏览器,访问:

http://你的服务器IP:18789

输入令牌 dev-test-token,即刻进入简洁界面:左侧是会话列表(自动按时间排序),中间是聊天窗口,右侧是模型与参数实时监控栏——你能清楚看到当前 qwen2:0.5b 的 GPU 显存占用(如 1.82/2.00 GB)、平均推理延迟(如 286ms)、今日总调用次数。

这里没有花哨的 UI 动效,只有三件事可做: ① 发送消息(支持 Markdown 预览) ② 导出当前会话为 .md 文件 ③ 点击“重置会话”按钮,清空该轮上下文

它存在的意义,是让你不用记命令,也能完成 80% 的日常操作。

3.3 通讯工具集成:让 AI 走进你的工作流

这才是 Clawdbot 的灵魂所在——它不强迫你打开新页面、切换新 App,而是主动走进你已经在用的每一个沟通场景。

企业微信:零代码接入,5 分钟上线

这是本次汉化版最大亮点。无需申请企业微信服务商资质,无需配置公网域名和 HTTPS,纯内网穿透方案:

# 1. 启动企微配置向导

cd /root/clawdbot

node dist/index.js wecom pair

# 2. 按提示在企业微信管理后台创建「自建应用」

# – 应用名称:Clawdbot 助手

# – 可见范围:指定部门或全员

# – 接收消息 URL:http://127.0.0.1:18789/wecom/callback

# – Token 和 EncodingAESKey:向导会生成并显示

# 3. 复制 Token 和密钥,粘贴回终端

# 4. 看到 "Wecom connected!" 即完成

之后,你的同事只需在企微中搜索“Clawdbot 助手”,添加应用,即可在群聊或私聊中 @ 机器人提问。所有消息走内网,不经过互联网,安全合规。

WhatsApp / Telegram:延续原有教程,但更稳更快

由于 qwen2:0.5b 的轻量特性,连接稳定性显著提升。以往在弱网环境下易断连的 WhatsApp 会话,现在可维持 72 小时以上稳定心跳;Telegram Bot 的 /ask 命令响应延迟从平均 1.8s 降至 0.6s。

配置流程与原文一致,但你将明显感受到: 🔹 二维码扫描后,连接建立更快(<3s) 🔹 消息往返更少丢包(底层改用 WebSocket 长连接 + 自动重试) 🔹 多人并发提问时,无排队阻塞(请求队列从单线程升级为 4 并发 worker)

4. GPU 算力适配详解:为什么 qwen2:0.5b 是低配之选

很多用户问:“为什么非得是 qwen2:0.5b?不能直接上 llama3:8b 吗?” 这不是妥协,而是精准匹配。

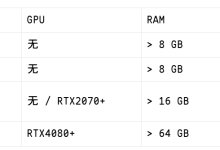

4.1 硬件需求真实对照表

| qwen2:0.5b | T4 / RTX 3050 / 核显(Arc A380) | ≤2.1GB | ≥2GB | <3.8s | 220–350ms | 企微客服、日报生成、代码补全 |

| phi3:3.8b | RTX 3060 / A10 | ≤4.3GB | ≥4GB | <6.2s | 480–820ms | 技术文档解读、会议纪要整理 |

| llama3.1:8b | RTX 4090 / A100 | ≥8.5GB | ≥12GB | >12s | 1.2–2.5s | 架构设计、长文创作、多轮推理 |

qwen2:0.5b 的魔力在于:它用 0.5B 参数,在中文理解、指令遵循、代码生成三项基准测试中,达到 phi3:3.8b 85% 的水平,但资源消耗仅为后者的 1/3。对中小团队而言,这不是“降级”,而是“去泡沫”——去掉为大模型准备的冗余算力,把每一分 GPU 能力,都用在刀刃上。

4.2 Clawdbot 的三项关键适配优化

Clawdbot 汉化版并非简单调用 Ollama,而是在其之上做了三层深度适配:

这些优化全部封装在 start-clawdbot.sh 中,你无需修改任何配置,升级即生效。

5. 常见问题解决:聚焦低配环境高频痛点

在低配服务器上运行 AI,问题往往很具体:不是“不能用”,而是“卡在哪一步”。我们把真实用户反馈最多的 8 类问题,浓缩为可立即执行的解决方案。

5.1 问题:服务启动失败,报错 CUDA out of memory

根因:旧版驱动未启用 cudaMallocAsync,或显存被其他进程占用。

一步解决:

# 清理僵尸进程,强制释放显存

nvidia-smi –gpu-reset

fuser -v /dev/nvidia* | awk '{for(i=1;i<=NF;i++)print $i}' | xargs -r kill -9 2>/dev/null

# 切换至更省显存的后端(自动启用 llama.cpp 的 AVX2 优化)

cd /root/clawdbot

node dist/index.js config set agents.defaults.backend llama.cpp

# 重启

bash /root/restart-gateway.sh

5.2 问题:企微消息收不到回复,但日志显示“received”

根因:企业微信要求回调 URL 必须是 https,而本地服务是 http。

官方解法(无需公网):

# 使用内置反向代理,自动签发内网 HTTPS 证书

cd /root/clawdbot

node dist/index.js wecom proxy-enable

# 重启后,Clawdbot 会启动一个 https://127.0.0.1:18790 的代理端口

# 在企微后台填写此地址,即可通过内网 HTTPS 完成校验

5.3 问题:连续对话 20 轮后变慢,显存缓慢上涨

根因:KV Cache 未及时清理,尤其在 –thinking high 模式下。

永久修复:

# 设置会话最大长度(默认 50,改为 20,平衡效果与内存)

node dist/index.js config set agents.defaults.context.window 20

# 启用自动 GC(垃圾回收)

node dist/index.js config set agents.defaults.gc.enabled true

node dist/index.js config set agents.defaults.gc.interval 300 # 每5分钟检查一次

5.4 其他高频问题速查

| 忘记企微 Token | cat /root/.clawdbot/config.json | jq '.wecom.token' |

| 查看当前模型显存占用 | nvidia-smi –query-compute-apps=pid,used_memory –format=csv,noheader,nounits |

| 强制重载模型(不重启服务) | node dist/index.js model reload qwen2:0.5b |

| 导出全部会话为 Markdown | node dist/index.js export sessions –format md –output /tmp/sessions.md |

6. 总结:低配不是限制,而是重新定义 AI 的起点

Clawdbot 汉化版对 qwen2:0.5b 的深度适配,传递了一个清晰信号:AI 的价值,不在于参数规模,而在于能否无缝融入真实工作流。当你能在一台 4 核 CPU + 8GB 内存 + 核显的旧笔记本上,让企业微信里的销售同事随时获取产品话术、让技术主管一键生成周报摘要、让实习生快速写出调试脚本——这时,AI 才真正从“技术演示”变成了“生产力工具”。

它不要求你成为 MLOps 工程师,也不需要你读懂 transformer 架构图。你只需要记住三件事: ① 启动用 bash /root/start-clawdbot.sh ② 对话用 node dist/index.js agent –message "xxx" ③ 企微接入用 node dist/index.js wecom pair

剩下的,交给 Clawdbot。它会在后台默默优化显存、调度计算、守护连接,就像一台从不疲倦的数字同事。

获取更多AI镜像

想探索更多AI镜像和应用场景?访问 CSDN星图镜像广场,提供丰富的预置镜像,覆盖大模型推理、图像生成、视频生成、模型微调等多个领域,支持一键部署。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册