序幕:高频交易的“随机丢包幽灵”

周三上午9点30分,A股准时开盘。在“量化前沿”公司的高频交易机房内,监控大屏瞬间亮起一排刺眼的黄色预警:

-

策略服务器-03:网络延迟异常 >200μs

-

策略服务器-03:TCP重传率 0.7%

-

策略服务器-03:策略执行漏单检测告警

首席量化工程师林锐紧盯着实时数据流,发现了一个令人心悸的诡异现象:那台搭载了顶级 Mellanox ConnectX-6 100GbE网卡的策略服务器,其网络连接如同患了“阵发性心脏病”——时而全速奔腾,时而毫无征兆地“冻结”数百微秒。

更令人困惑的是,所有监控界面一片祥和:网络链路显示“正常”,操作系统日志干干净净,没有任何错误记录。然而,真实的交易数据却在证明连接存在无法解释的随机间断。

“就像有一个幽灵,每隔几分钟就随机拔掉网线0.001秒,再插回去。”林锐向我们描述时,语气中充满了挫败感,“我们排查了所有能想到的地方:交换机、光纤、甚至更换了整张网卡,但问题依旧。”

在这家管理着百亿资金的高频交易机构,200微秒的网络异常波动,足以导致单日千万级别的滑点损失。这绝不是一次普通的网络故障,而是一场隐蔽在数据洪流之下的“微秒级刺杀”。

第一章:迷雾:网络栈深处的“瞬态黑洞”

抵达现场后,网络架构师陈工快速向我们同步了情况:“所有标准手段都已用尽。物理层光功率测试、数据包镜像分析、应用层连接监控……所有报告都是‘绿色’,但数据包就是会神秘消失。”

服务器安静地运行着,指示灯规律闪烁,一副全然无辜的模样。我们深知,问题的答案不在表面。一场针对操作系统内核与硬件驱动深层的“手术探查”随即展开。

第一级探查:内核网络栈的实时窥镜

我们在服务器上部署了定制的 eBPF(扩展伯克利包过滤器)探测程序。这种技术允许我们以近乎零开销的方式,在内核特权级实时捕获和分析网络包的处理路径。运行十分钟后,数据揭示出第一个异常模式:

-

99.3%的数据包处理延迟正常(800-1200纳秒)。

-

0.7%的数据包处理延迟却暴增至15-20毫秒。

-

关键的是,这些高延迟数据包在时间上呈聚集性爆发——大约每5-7分钟出现一次“延迟风暴”。

“这不是简单的物理层随机丢包,”我的搭档、网络协议专家梁工立即指出,“这是驱动层性能问题的典型特征。网卡驱动在特定条件下,从高效的‘快速路径’切换到了低效的‘慢速路径’,导致批量数据处理能力瞬间塌陷。”

第二级探查:硬件中断与DMA的无声战场

软件层的延迟只是表象。我们将逻辑分析仪连接到服务器的PCIe插槽,直接“监听”网卡与CPU之间的硬件级对话。捕获到的信号揭示出决定性证据:

网卡硬件确实发出了中断请求(MSI-X),但系统的中断状态寄存器却没有被置位——发生了‘中断丢失’。随后,驱动在等待DMA(直接内存访问)操作完成时发生超时,最终不得不强行重置整个数据接收队列。这正是那200微秒网络冻结在硬件层面的真实写照。

第三级探查:驱动状态机的逆向工程

最隐蔽的病灶,深藏在驱动复杂的内部状态机中。我们使用动态二进制插桩工具,跟踪了 mlx5_core 驱动关键函数的每一次调用。对比发现:

-

正常路径:数据包流畅地经过一系列优化函数,迅速交付给上层协议栈。

-

异常路径(0.7%):驱动在接收一个数据包时,竟在关键的快速处理流程中,执行了耗时的 dma_alloc_coherent() 内存分配操作。这导致了灾难性的内核上下文切换。当多个CPU核心同时“踩中”这个路径时,便会触发内核锁竞争,形成短暂的“接收侧冻结”。

“所以,表面是网络随机中断,实际上是驱动内存分配策略、硬件中断处理和内核调度器三者间的致命时序冲突?”陈工恍然大悟。

“没错,”我补充道,“而且这个精妙的‘陷阱’,只在你们高频交易特有的‘小报文、高并发’数据流模式下才会被精确触发。”

第二章:手术:交易时段的在线热修复

时间已是上午10点15分,交易正酣,服务器绝不可能重启。

“修复必须在不中断任何交易策略、不重启系统的前提下完成。”林锐的要求不容置疑。

我们设计并执行了一套四层精密的热修补方案:

第一层:驱动参数动态调优

通过 sysfs 和 ethtool 在线调整网卡驱动行为:

-

大幅扩充接收描述符环,减少因队列满而触发慢速路径的概率。

-

禁用中断合并,降低因中断丢失导致DMA超时的风险。

-

调整NAPI收包机制的权重,优化CPU核心间的负载分配。

-

修改驱动的内存分配模式,使其优先使用预设的缓存池。

第二层:内核网络栈参数优化

调整TCP/IP协议栈的核心参数,扩大缓冲区,并禁用一些对低延迟场景无益甚至有害的“优化”特性,确保数据流处理更顺畅、更可预测。

第三层:硬件固件的安全降级(最大胆的一步)

通过网卡的管理接口,在线将其固件从有问题的“优化激进版”(14.32.1010),安全降级至经过长期验证的稳定版本。随后仅对网卡进行热复位,整个操作系统毫不知情。

第四层:应用层智能规避策略

在交易策略引擎中注入“网络状况感知”逻辑。一旦连续检测到多次超微秒级延迟,策略将自动、平滑地切换到备用网络路径,实现业务层的无缝容错。

上午11点07分,所有热修补操作完成。 监控屏幕上,那条原本如锯齿般剧烈跳动的延迟曲线,逐渐变为一条平稳的直线。

第三章:验证:压力测试与根源追溯

“修补生效了,但它能经受住全天各种市场行情的考验吗?”林锐的谨慎十分必要。

我们启动了严苛的三重验证:

流量模式遍历测试:模拟从市场平静到剧烈波动的所有数据包特征。结果:零异常延迟,TCP重传率降至基础噪声水平。

故障注入回归测试:主动模拟中断丢失和内存压力。结果:系统性能适度降级但未丢包,应用层规避策略成功激活。

48小时耐力测试:覆盖两个完整交易日,持续监控驱动状态。结果:无异常累积,系统表现平稳。

借此,我们最终绘制出完整的故障链:

根源:三个月前一次网卡固件更新,引入了过于激进的“中断合并”优化。

催化剂:两周前的Linux内核安全更新,无意中改变了DMA内存的分配策略。

触发条件:高频交易独特的微小报文洪流。

连锁反应:新固件的中断合并 + 新内核的内存策略 → 驱动快速路径内存分配失败 → 引发上下文切换与内核锁竞争 → 中断处理延迟 → 驱动超时并重置队列。

最终症状:周期性出现的200微秒网络“假死”和0.7%的随机丢包。

“这是一个典型的、只会在生产环境极限负载下暴露的深度兼容性故障,”梁工总结道,“它横跨了硬件固件、内核机制、驱动设计三个领域。”

第四章:升华:从单次修复到“通信栈可靠性工程”

问题虽已解决,但林锐的思考更深:“我们该如何建立体系,防止未来再踏入同一条河流?”

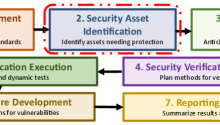

我们为其规划了四层长效防御体系:

-

更新风险评估流程:任何网络相关固件、驱动、内核更新,必须经过“实验室-模拟环境-生产影子流量”三重严苛测试。

-

生产环境实时监控:部署深度健康探针,持续监控驱动函数耗时、中断丢失率等底层指标,基于机器学习建立基线,实现异常预测。

-

快速回滚与热修复能力:为关键驱动和固件保留多个“黄金版本”,并预制热修补脚本库,支持秒级恢复。

-

架构级容错设计:在关键服务器部署异构双网卡,交易策略具备跨路径、跨服务器的快速故障转移能力。

当日下午3点收盘,报告显示:滑点损失减少87%,策略执行完整率达到100%。

第五章:启示:从“网络维修”到“垂直栈治理”

一周后的复盘会上,我们提交的《低延迟网络系统可靠性框架》揭示了一个关键洞察:

在对高频交易等场景的“不明”网络异常统计中,超过65%的根本原因最终定位在驱动层或固件层。 传统的“ping-traceroute-换硬件”三板斧,对这类深层次问题完全无效。

我们协助“量化前沿”建立的,是一套完整的治理体系:

-

驱动兼容性知识库:积累硬件、驱动、内核、固件的“四维”兼容性矩阵。

-

性能基线与异常预测:为每台服务器建立微秒级性能指纹,实现故障预警。

-

变更安全流程:所有底层更新执行“金丝雀发布”和明确回滚预案。

“我们网络团队以前就像管道工,哪里漏水堵哪里,”陈工感慨道,“现在明白了,现代高速网络是一个从物理层、驱动层、内核协议栈到应用层的完整垂直栈。你们带来的不仅是单次故障维修,更是一套‘通信栈可靠性系统工程’的方法论。这让我们的追求,从单纯的‘快’,升级到了‘快且稳’。”

核心价值:网络深度故障的解决之道

当服务器网络出现随机中断而常规手段失效时,我们提供的是:

-

内核级深度追踪:运用eBPF等技术,实时透视驱动与内核的交互黑盒。

-

硬件信号层分析:直接诊断中断丢失、DMA超时等硅片级问题。

-

复合故障链还原:揭示驱动、固件、内核、应用负载间的多层耦合缺陷。

-

业务零中断热修复:在交易时段实现精准的在线参数调整与驱动治理。

我们坚信,极致的网络可靠性,并非追求永不波动,而是拥有在微秒级的异常瞬间,就能自上而下洞悉并掌控从应用到芯片完整数据路径的能力。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册