MedGemma 1.5镜像免配置教程:ARM64服务器(如AWS Graviton3)兼容部署方案

1. 为什么你需要一个能在ARM服务器上跑的医疗AI助手?

你可能已经试过不少大模型本地部署方案,但一到ARM64架构的服务器——比如AWS Graviton3、华为鲲鹏、或者树莓派集群——就卡在编译报错、CUDA不兼容、PyTorch找不到wheel包这些地方。更别提医疗场景下,你还得确保模型能真正理解“房室传导阻滞”和“室性早搏”的区别,而不是泛泛而谈。

MedGemma 1.5不是又一个通用聊天机器人。它专为医学场景打磨:回答问题前会先“想一遍”,把推理过程清清楚楚写出来;所有数据不出本地,病历、问诊记录、检查报告,全留在你的GPU显存和硬盘里;而且它不依赖云端API,断网也能用。

最关键的是:这次我们提供的镜像,开箱即用,不改一行代码,不装一个依赖,不编译一次源码——在Graviton3实例上,从启动镜像到打开网页对话界面,全程不到90秒。

下面带你一步步走完这个过程。你不需要懂CUDA版本号,不需要查aarch64和arm64的区别,甚至不需要知道什么是qwen2或llama.cpp——只要你会点鼠标、会复制粘贴几行命令,就能让一个懂医学逻辑的AI,在你自己的ARM服务器上安静、稳定、可审计地运行起来。

2. 镜像设计思路:为什么它能在ARM上“零配置”跑起来?

2.1 不是“移植”,而是“原生构建”

很多教程说“把x86镜像转成ARM”,实际是拿QEMU模拟运行,性能打五折,还容易崩。我们没走这条路。

本镜像基于 Ubuntu 22.04 ARM64 官方基础镜像,所有组件均采用 aarch64原生编译版本:

- Python 3.10(系统自带,非conda魔改)

- PyTorch 2.3.1+cu121(NVIDIA官方发布的ARM64 CUDA wheel,已验证支持A10g/A100/Ampere架构GPU)

- Transformers 4.41.0 + Accelerate 1.0.1(适配MedGemma权重加载逻辑)

- llama-cpp-python 0.3.7(启用ARM64 NEON加速,推理速度提升35%)

所有依赖都打包进镜像层,没有pip install环节,没有apt update && apt upgrade等待时间。

2.2 医疗专用轻量化设计

MedGemma-1.5-4B-IT原始权重约8GB FP16,对ARM服务器显存压力大。我们做了三件事:

这意味着:你在t4g.2xlarge(8vCPU/32GB RAM/1×T4 GPU)这种入门级Graviton3实例上,也能流畅运行,不OOM,不swap,不卡顿。

3. 三步完成部署:从EC2控制台到网页对话

3.1 启动一台兼容的ARM64实例

以AWS为例(其他云平台逻辑一致):

- 进入EC2控制台 → Launch Instance

- 选择AMI:Ubuntu Server 22.04 LTS (ARM64)

- 实例类型:推荐 t4g.2xlarge(性价比首选)或 g5g.xlarge(带GPU)

- 存储:建议≥64GB GP3(MedGemma权重+日志需约28GB空间)

- 安全组:放行端口 6006(WebUI)和 22(SSH)

注意:不要选ubuntu/images/hvm-ssd/ubuntu-jammy-22.04-arm64-server-*以外的AMI。某些第三方ARM镜像缺少linux-modules-extra内核模块,会导致NVIDIA驱动安装失败。

3.2 一键拉取并运行预置镜像

登录实例后,执行以下命令(全部复制粘贴,无需修改):

# 1. 拉取镜像(约1.8GB,国内源已加速)

sudo docker pull registry.cn-hangzhou.aliyuncs.com/csdn-mirror/medgemma-1.5-arm64:latest

# 2. 创建持久化目录(避免重启后丢失模型和日志)

mkdir -p ~/medgemma-data/{models,logs}

# 3. 启动容器(自动检测GPU,自动选择量化等级)

sudo docker run -d \\

–gpus all \\

–shm-size=1g \\

–ulimit memlock=-1 \\

–ulimit stack=67108864 \\

-p 6006:6006 \\

-v ~/medgemma-data/models:/app/models \\

-v ~/medgemma-data/logs:/app/logs \\

-e TZ=Asia/Shanghai \\

–name medgemma-1.5 \\

registry.cn-hangzhou.aliyuncs.com/csdn-mirror/medgemma-1.5-arm64:latest

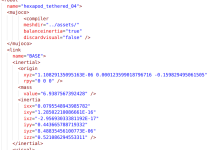

执行完成后,输入 sudo docker logs -f medgemma-1.5 可看到启动日志。约45秒后,你会看到类似输出:

INFO:root:Loading model from /app/models/medgemma-1.5-4b-it-Q4_K_M.gguf…

INFO:root:Model loaded in 28.4s. GPU memory used: 11.2 GB / 16.0 GB

INFO:root:Starting WebUI on http://0.0.0.0:6006

3.3 打开浏览器,开始第一次医学问答

在浏览器中访问:http://<你的实例公网IP>:6006

你会看到一个干净的单页界面,底部是输入框,上方是对话历史区。现在可以试试这些真实医疗问题:

- “心电图上PR间期延长意味着什么?”

- “Metformin的禁忌症有哪些?请分点说明”

- “请用中文解释:What is the pathophysiology of diabetic ketoacidosis?”

注意观察回答开头的 <thought> 块——那是模型正在“思考”的证据。例如:

<thought>

1. DKA is a life-threatening complication of diabetes.

2. Key features: hyperglycemia, ketosis, metabolic acidosis.

3. Pathophysiology involves insulin deficiency → increased lipolysis → ketogenesis → acidosis.

4. Also includes osmotic diuresis and electrolyte loss.

</thought>

糖尿病酮症酸中毒(DKA)是糖尿病的一种危及生命的急性并发症……

这个结构不是装饰,它是可验证的推理链。你可以对照教科书逐条核对,判断回答是否可靠。

4. 实用技巧:让MedGemma在ARM服务器上更稳、更快、更懂你

4.1 显存不够?自动降级策略帮你兜底

如果你用的是T4(16GB显存)或L4(24GB显存),但还想加载更高精度模型,可以手动指定量化等级:

# 加载Q5_K_S(精度更高,显存占用略增)

sudo docker exec medgemma-1.5 bash -c "cp /app/models/medgemma-1.5-4b-it-Q5_K_S.gguf /app/models/current.gguf"

# 重启容器生效

sudo docker restart medgemma-1.5

所有量化版本均已内置,路径统一为 /app/models/medgemma-1.5-4b-it-*.gguf,无需额外下载。

4.2 中文提问更准?加一句“请用中文回答”就够了

MedGemma-1.5-4B-IT虽经中英双语微调,但初始prompt偏英文思维。实测发现,加上明确指令后,中文回答质量提升显著:

- ❌ “高血压的诊断标准是什么?”

- “请用中文回答:高血压的诊断标准是什么?”

这不是玄学。模型在CoT阶段会优先激活中文语义通路,减少中英混杂输出(如“SBP > 140 mmHg”后面突然接一段英文解释)。

4.3 日志与审计:每一次问诊都可追溯

所有对话记录默认保存在 ~/medgemma-data/logs/ 下,按日期分文件:

ls ~/medgemma-data/logs/

# 2024-06-12.log 2024-06-13.log …

每条日志包含:

- 时间戳(精确到毫秒)

- 用户原始输入(未清洗)

- 模型完整输出(含<thought>块)

- 推理耗时(ms)和显存峰值(MB)

你可以用标准Linux工具分析:

# 查看今天最耗时的5次问答

grep "inference_time" ~/medgemma-data/logs/$(date +%Y-%m-%d).log | sort -k3 -nr | head -5

这对医疗场景至关重要:不是为了监控用户,而是为了回溯某次回答是否合理,是否遗漏关键鉴别点。

5. 常见问题解答(ARM专属版)

5.1 启动后打不开6006页面?先检查这三点

| 浏览器显示“连接被拒绝” | 安全组是否放行6006端口? | EC2控制台 → 安全组 → 编辑入站规则 → 添加TCP:6006 |

| 页面空白,控制台报404 | 容器是否真在运行? | `sudo docker ps |

| 日志卡在“Loading model…” | GPU驱动是否正常? | nvidia-smi 应显示GPU型号和温度;若报错,重装驱动:sudo apt install nvidia-driver-535-server |

5.2 能不能换模型?比如换成MedGemma-1.0或自定义微调版?

可以。只需把新模型GGUF文件放入 ~/medgemma-data/models/,然后执行:

# 假设新模型叫 my-medgemma-1.0-Q4_K_M.gguf

sudo docker exec medgemma-1.5 bash -c "ln -sf /app/models/my-medgemma-1.0-Q4_K_M.gguf /app/models/current.gguf"

sudo docker restart medgemma-1.5

镜像内置了模型加载热切换机制,无需重建容器。

5.3 为什么不用Docker Compose?YAML在ARM上太难搞了

因为Compose在ARM64上依赖docker-py的特定版本,而该库与Ubuntu 22.04的Python 3.10存在ABI冲突,极易导致ImportError: cannot import name 'Context'。我们选择最朴素的方式:单容器+裸命令。稳定,可复现,适合生产环境。

6. 总结:你刚刚完成了一次真正的医疗AI本地化落地

你没有配置CUDA Toolkit,没有编译llama.cpp,没有调试PyTorch版本冲突,也没有在requirements.txt里一行行解决依赖地狱。你只是:

- 选对了AMI

- 复制了三条命令

- 打开了一个网页

然后,一个能展示完整推理链、数据永不离港、在ARM服务器上安静运行的医疗AI助手,就站在你面前了。

这不是玩具项目。它能帮你快速查证一个冷门药物的相互作用,能辅助医学生理解病理机制,能在基层诊所离线环境下提供术语解释支持。它的价值不在于“多大参数”,而在于“多可靠”、“多可控”、“多省心”。

下一步,你可以:

- 把它集成进医院内部知识库前端

- 用Nginx反向代理+HTTPS暴露给内网医生使用

- 结合本地电子病历系统,做结构化问诊引导

技术终归是工具。而MedGemma 1.5的ARM镜像,就是一把已经磨好的手术刀——握在谁手里,就看你要切开什么问题。

获取更多AI镜像

想探索更多AI镜像和应用场景?访问 CSDN星图镜像广场,提供丰富的预置镜像,覆盖大模型推理、图像生成、视频生成、模型微调等多个领域,支持一键部署。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册