📖标题:LiViBench: An Omnimodal Benchmark for Interactive Livestream Video Understanding

🌐来源:arXiv, 2601.15016v1 (AAAI 2026)

🌟摘要

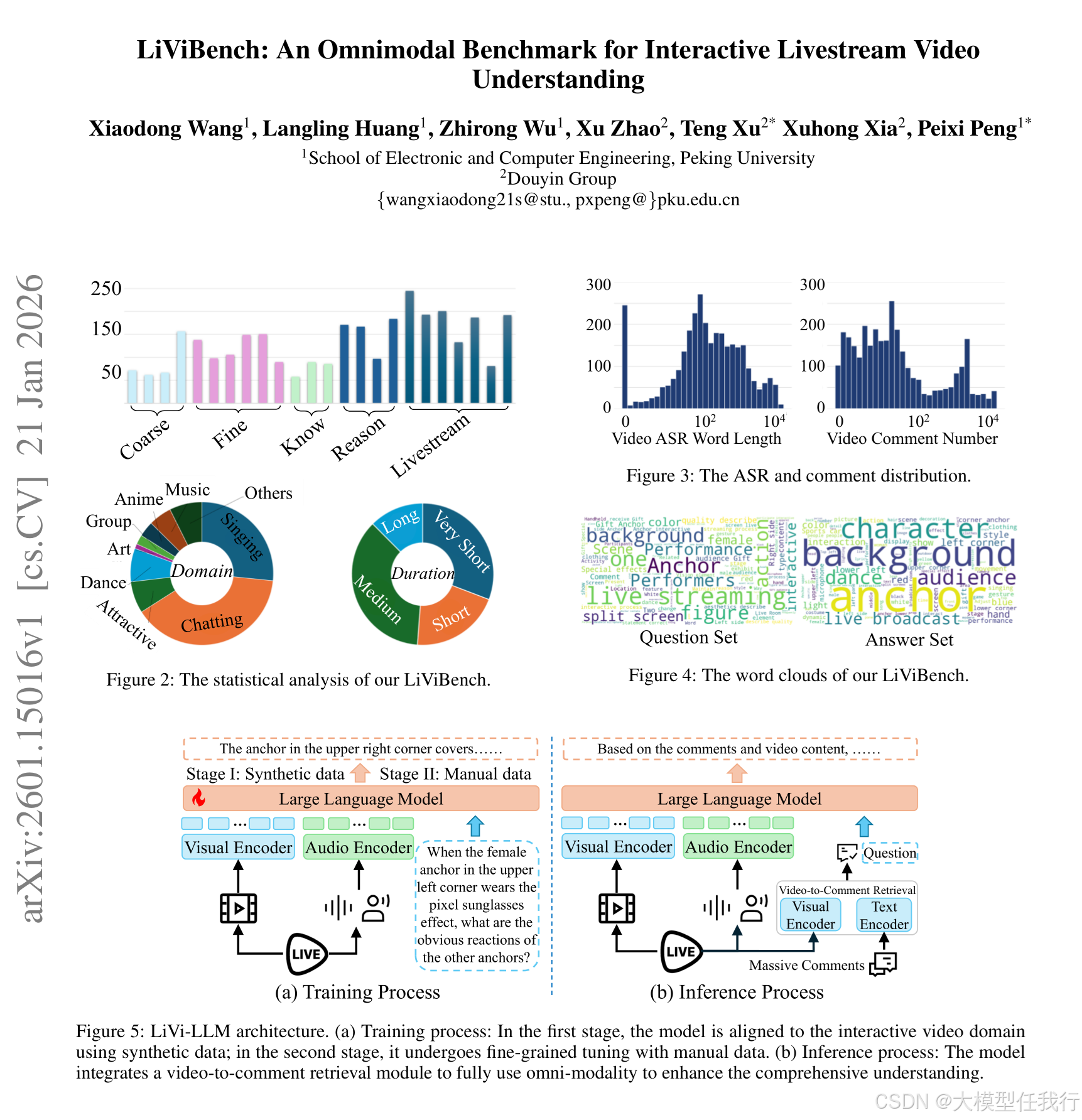

多模态大语言模型(MLLM)的开发提高了对一般视频的理解。然而,现有的视频评估基准主要关注于非交互式视频,例如电影和录音。为了填补这一空白,本文提出了交互式直播视频的第一个全模态基准LiViBench。它具有24个任务的多样化集合,突出了感知、推理和直播特定的挑战。为了高效地构建数据集,我们设计了一个标准化的半自动注释工作流程,该工作流程在多个阶段整合了人在环。该工作流程利用多个MLLM形成了一个多智能体系统,用于全面的视频描述,并使用seed-question-driven方法来构建高质量的注释。基准测试中的所有交互式视频都包括音频、语音和实时评论模式。为了增强模型对交互式视频的理解,我们设计了量身定制的两阶段指令调整,并提出了视频到评论检索(VCR)模块,以提高模型利用实时评论的能力。基于这些进步,我们开发了LiVi-LLM-7B,这是一种具有增强交互式直播知识的MLLM。实验表明,我们的模型优于具有高达72B参数的大型开源模型,缩小了与LiViBench上领先的专有模型的差距,并在一般视频基准测试上实现了增强的性能,包括VideoMME、LongVideoBench、MLVU和VideoEval-Pro。

🛎️文章简介

🔸研究问题:如何有效评估多模态大模型对实时交互式直播视频的理解能力?

🔸主要贡献:论文提出了首个面向交互式直播视频的全模态评测基准LiViBench,并配套构建高质量标注流程、专用训练方法及高性能模型LiVi-LLM-7B。

📝重点思路

🔸设计涵盖音频、语音(ASR)和实时弹幕三模态的直播视频数据集,包含3168个真实场景视频及3175道多选题,覆盖9类垂直领域与24项任务。

🔸提出人机协同的半自动标注流水线:基于多模型代理系统生成互补视频描述,结合种子问题库驱动问题生成,并在多个环节嵌入人工审核与精修。

🔸构建两阶段指令微调策略:第一阶段用37953条合成数据对齐直播域,第二阶段用11180条人工精标数据提升细粒度鲁棒性。

🔸引入视频到弹幕检索(VCR)模块,利用视频帧与弹幕文本的跨模态相似度筛选关键评论,缓解长上下文压力并增强交互理解。

🔎分析总结

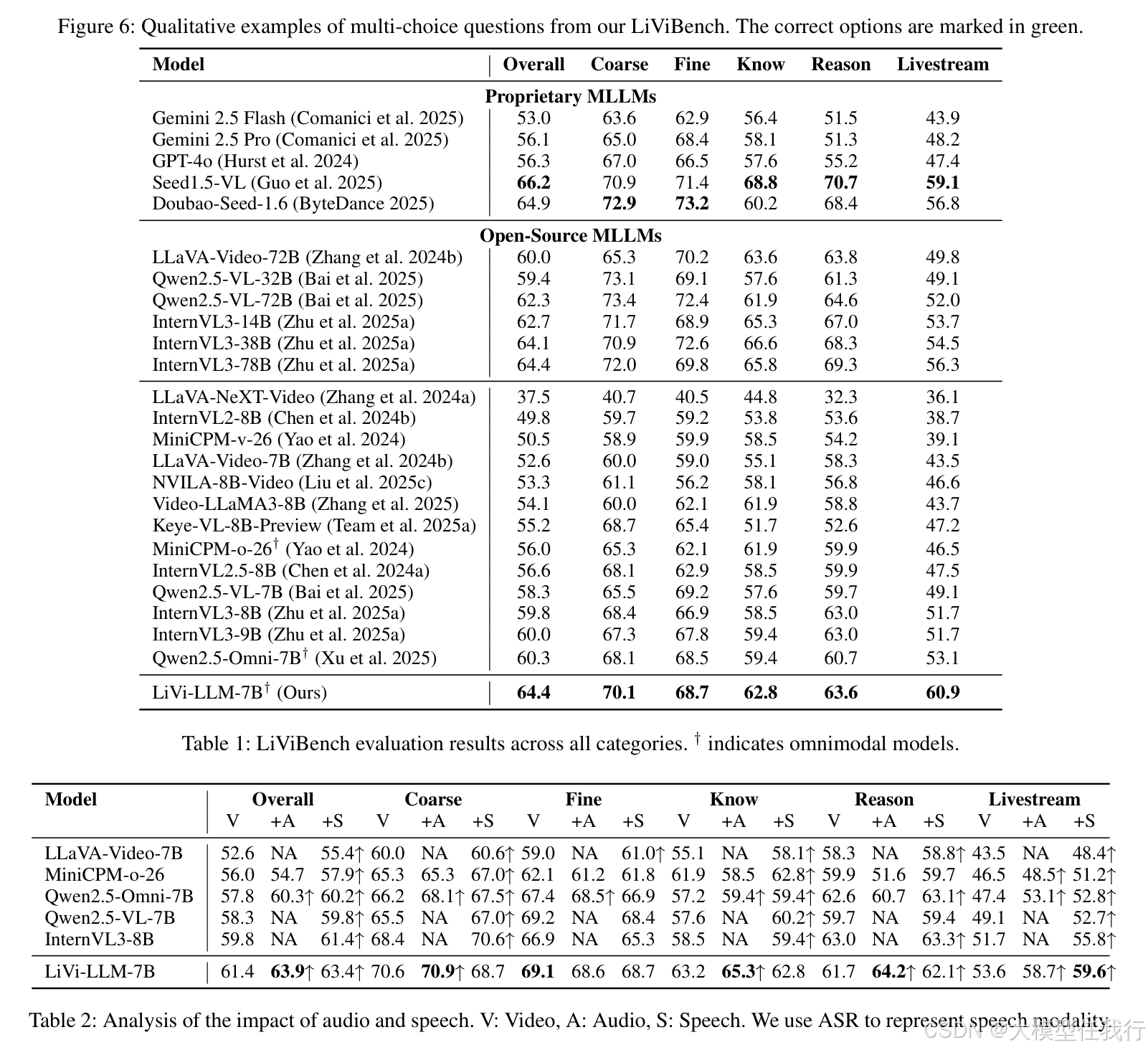

🔸现有主流模型(包括GPT-4o、Gemini-2.5-Pro)在LiViBench上表现显著低于其在通用视频基准上的水平,尤其在直播特有任务(如多人互动、行为归因)上准确率最低。

🔸音频模态对所有模型均有正向增益,尤其在直播特有任务中提升最明显;而语音(ASR)模态在细粒度感知和推理任务中偶有负向干扰,表明噪声需被谨慎处理。

🔸原始弹幕输入会降低多数模型性能,而VCR模块能稳定提升各长度区间弹幕下的准确率,验证其在信息压缩与相关性建模上的有效性。

🔸LiVi-LLM-7B以7B参数量超越Qwen2.5-VL-72B等更大开源模型,在LiViBench上达64.4%准确率,逼近顶尖闭源模型,并在Video-MME等通用基准上同步提升。

💡个人观点

论文精准锚定直播视频核心特质为“交互性”,建设多代理+种子问题+人机协同的标注框架。

🧩附录

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册