注 : 本文纯由长文技术博客助手Vibe-Blog生成, 如果对你有帮助,你也想创作同样风格的技术博客, 欢迎关注开源项目: Vibe-Blog.

Vibe-Blog是一个基于多 Agent 架构的 AI 长文博客生成助手,具备深度调研、智能配图、Mermaid 图表、代码集成、智能专业排版等专业写作能力,旨在将晦涩的技术知识转化为通俗易懂的科普文章,让每个人都能轻松理解复杂技术,在 AI 时代扬帆起航.

5分钟掌握行人重识别(ReID):从原理到评估的完整入门

Person ReID | Rank-1 | mAP | Triplet Loss | Market-1501

阅读时间: 5 min

掌握 ReID 的核心流程、关键指标与现代实践范式,为后续模型训练或项目集成打下坚实基础。

目录

- ReID 入门:概念、流程与评估

- 标准 ReID 流程解析

- 如何衡量 ReID 性能?

在智能安防与多摄像头追踪系统中,如何在不同视角下准确识别同一行人?这就是行人重识别(Person ReID)要解决的核心问题。本文面向具备基础深度学习知识的中级开发者,快速厘清 ReID 的关键概念、主流方法与评估标准,助你高效入门这一热门视觉任务。

—## ReID 入门:概念、流程与评估

你是否遇到过这样的场景:在大型商场或地铁站中,一个可疑人员从一个摄像头视野消失后,安保人员却无法在其他区域快速定位其踪迹?这正是行人重识别(Person Re-Identification,简称 ReID)技术要解决的核心问题。想象一下,即使目标行人换了衣服、被遮挡、或在不同光照下行走,系统依然能跨多个非重叠摄像头准确“认出”他——这不仅是智能安防的基石,也是未来城市感知网络的关键能力。

ReID 的本质是在无交集视角的摄像头之间,对同一行人的图像进行匹配与检索。与人脸识别不同,ReID 不依赖面部特征(常因角度、遮挡不可用),而是从整体外观、衣着、体型等线索中提取判别性信息。然而,这一任务极具挑战:同一人在不同摄像头下的图像可能因光照突变、姿态剧烈变化、部分遮挡甚至低分辨率而呈现出截然不同的视觉表征。如何让模型“透过现象看本质”,成为 ReID 研究的核心命题。

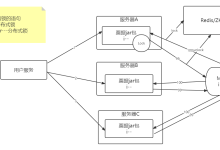

标准 ReID 流程解析

现代 ReID 系统通常遵循一个清晰的端到端流程。首先,输入图像通过一个强大的卷积神经网络(如 ResNet-50)进行特征提取,生成高维语义向量。这一步是整个系统的“眼睛”,决定了模型能捕捉多少有效信息。接着,为了提升对局部变化的鲁棒性,许多先进方法会引入部件对齐(Part Alignment)模块,例如将人体划分为头、上身、下身等区域,分别提取并融合局部特征,从而缓解姿态和遮挡带来的干扰。

具体而言,部件对齐并非简单地将图像等分,而是通过语义一致的局部区域划分实现更精细的匹配。典型方法包括 PCB(Part-based Convolutional Baseline),它将骨干网络的特征图水平切分为多个条带,并对每个条带独立进行池化与分类;以及 AlignedReID,它利用人体关键点检测或空间注意力机制动态对齐不同图像中的对应身体部位,确保“头对头、腿对腿”的特征比较。这种局部对齐策略显著提升了模型在姿态变化和遮挡场景下的鲁棒性。

训练阶段,模型通常采用多损失联合优化策略。最常见的是结合交叉熵损失(用于分类监督) 与 三元组损失(Triplet Loss,用于拉近同类样本、推远异类样本)。这种组合既能保证特征的判别性,又能优化特征空间的度量结构,使相似行人靠得更近,不同行人分得更开。

在实际工程中,典型的训练配置包括:使用 PK 采样策略(每个 batch 包含 P 个身份,每个身份采样 K 张图像,如 P=16, K=4,构成 64 张图像的 batch),以确保三元组损失有足够正负样本对;交叉熵损失与三元组损失通常以 1:1 的权重(λ=1.0)联合优化;此外,还会引入 BNNeck 结构(在分类头前插入 Batch Normalization 层)和 学习率 warm-up 等技巧,以稳定训练过程并提升收敛性能。这些实践已在开源项目如 Person_reID_baseline_pytorch 和 Deep-Person-ReID 中得到验证,成为社区广泛采用的标准流程。

#mermaid-svg-POcmC455CMGGrD3z{font-family:\”trebuchet ms\”,verdana,arial,sans-serif;font-size:16px;fill:#333;}@keyframes edge-animation-frame{from{stroke-dashoffset:0;}}@keyframes dash{to{stroke-dashoffset:0;}}#mermaid-svg-POcmC455CMGGrD3z .edge-animation-slow{stroke-dasharray:9,5!important;stroke-dashoffset:900;animation:dash 50s linear infinite;stroke-linecap:round;}#mermaid-svg-POcmC455CMGGrD3z .edge-animation-fast{stroke-dasharray:9,5!important;stroke-dashoffset:900;animation:dash 20s linear infinite;stroke-linecap:round;}#mermaid-svg-POcmC455CMGGrD3z .error-icon{fill:#552222;}#mermaid-svg-POcmC455CMGGrD3z .error-text{fill:#552222;stroke:#552222;}#mermaid-svg-POcmC455CMGGrD3z .edge-thickness-normal{stroke-width:1px;}#mermaid-svg-POcmC455CMGGrD3z .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-POcmC455CMGGrD3z .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-POcmC455CMGGrD3z .edge-thickness-invisible{stroke-width:0;fill:none;}#mermaid-svg-POcmC455CMGGrD3z .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-POcmC455CMGGrD3z .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-POcmC455CMGGrD3z .marker{fill:#333333;stroke:#333333;}#mermaid-svg-POcmC455CMGGrD3z .marker.cross{stroke:#333333;}#mermaid-svg-POcmC455CMGGrD3z svg{font-family:\”trebuchet ms\”,verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-POcmC455CMGGrD3z p{margin:0;}#mermaid-svg-POcmC455CMGGrD3z .label{font-family:\”trebuchet ms\”,verdana,arial,sans-serif;color:#333;}#mermaid-svg-POcmC455CMGGrD3z .cluster-label text{fill:#333;}#mermaid-svg-POcmC455CMGGrD3z .cluster-label span{color:#333;}#mermaid-svg-POcmC455CMGGrD3z .cluster-label span p{background-color:transparent;}#mermaid-svg-POcmC455CMGGrD3z .label text,#mermaid-svg-POcmC455CMGGrD3z span{fill:#333;color:#333;}#mermaid-svg-POcmC455CMGGrD3z .node rect,#mermaid-svg-POcmC455CMGGrD3z .node circle,#mermaid-svg-POcmC455CMGGrD3z .node ellipse,#mermaid-svg-POcmC455CMGGrD3z .node polygon,#mermaid-svg-POcmC455CMGGrD3z .node path{fill:#ECECFF;stroke:#9370DB;stroke-width:1px;}#mermaid-svg-POcmC455CMGGrD3z .rough-node .label text,#mermaid-svg-POcmC455CMGGrD3z .node .label text,#mermaid-svg-POcmC455CMGGrD3z .image-shape .label,#mermaid-svg-POcmC455CMGGrD3z .icon-shape .label{text-anchor:middle;}#mermaid-svg-POcmC455CMGGrD3z .node .katex path{fill:#000;stroke:#000;stroke-width:1px;}#mermaid-svg-POcmC455CMGGrD3z .rough-node .label,#mermaid-svg-POcmC455CMGGrD3z .node .label,#mermaid-svg-POcmC455CMGGrD3z .image-shape .label,#mermaid-svg-POcmC455CMGGrD3z .icon-shape .label{text-align:center;}#mermaid-svg-POcmC455CMGGrD3z .node.clickable{cursor:pointer;}#mermaid-svg-POcmC455CMGGrD3z .root .anchor path{fill:#333333!important;stroke-width:0;stroke:#333333;}#mermaid-svg-POcmC455CMGGrD3z .arrowheadPath{fill:#333333;}#mermaid-svg-POcmC455CMGGrD3z .edgePath .path{stroke:#333333;stroke-width:2.0px;}#mermaid-svg-POcmC455CMGGrD3z .flowchart-link{stroke:#333333;fill:none;}#mermaid-svg-POcmC455CMGGrD3z .edgeLabel{background-color:rgba(232,232,232, 0.8);text-align:center;}#mermaid-svg-POcmC455CMGGrD3z .edgeLabel p{background-color:rgba(232,232,232, 0.8);}#mermaid-svg-POcmC455CMGGrD3z .edgeLabel rect{opacity:0.5;background-color:rgba(232,232,232, 0.8);fill:rgba(232,232,232, 0.8);}#mermaid-svg-POcmC455CMGGrD3z .labelBkg{background-color:rgba(232, 232, 232, 0.5);}#mermaid-svg-POcmC455CMGGrD3z .cluster rect{fill:#ffffde;stroke:#aaaa33;stroke-width:1px;}#mermaid-svg-POcmC455CMGGrD3z .cluster text{fill:#333;}#mermaid-svg-POcmC455CMGGrD3z .cluster span{color:#333;}#mermaid-svg-POcmC455CMGGrD3z div.mermaidTooltip{position:absolute;text-align:center;max-width:200px;padding:2px;font-family:\”trebuchet ms\”,verdana,arial,sans-serif;font-size:12px;background:hsl(80, 100%, 96.2745098039%);border:1px solid #aaaa33;border-radius:2px;pointer-events:none;z-index:100;}#mermaid-svg-POcmC455CMGGrD3z .flowchartTitleText{text-anchor:middle;font-size:18px;fill:#333;}#mermaid-svg-POcmC455CMGGrD3z rect.text{fill:none;stroke-width:0;}#mermaid-svg-POcmC455CMGGrD3z .icon-shape,#mermaid-svg-POcmC455CMGGrD3z .image-shape{background-color:rgba(232,232,232, 0.8);text-align:center;}#mermaid-svg-POcmC455CMGGrD3z .icon-shape p,#mermaid-svg-POcmC455CMGGrD3z .image-shape p{background-color:rgba(232,232,232, 0.8);padding:2px;}#mermaid-svg-POcmC455CMGGrD3z .icon-shape rect,#mermaid-svg-POcmC455CMGGrD3z .image-shape rect{opacity:0.5;background-color:rgba(232,232,232, 0.8);fill:rgba(232,232,232, 0.8);}#mermaid-svg-POcmC455CMGGrD3z .label-icon{display:inline-block;height:1em;overflow:visible;vertical-align:-0.125em;}#mermaid-svg-POcmC455CMGGrD3z .node .label-icon path{fill:currentColor;stroke:revert;stroke-width:revert;}#mermaid-svg-POcmC455CMGGrD3z :root{–mermaid-font-family:\”trebuchet ms\”,verdana,arial,sans-serif;}

输入图像

特征提取 CNN

特征对齐 部件模块

特征向量

相似度计算

排序结果

三元组损失

评估指标 mAP Rank-1

ReID 标准流程图:从输入图像到排序结果,标注三元组损失作用位置与评估指标

如何衡量 ReID 性能?

在 ReID 领域,仅看“是否找到”是不够的,还需评估“找得有多好”。因此,两个核心指标被广泛采用:

- Rank-1 准确率:表示在检索结果中,第一个返回的图像是否为目标行人。这是最直观的“首检命中率”,直接反映系统在实际应用中的即时有效性。

- mAP(mean Average Precision):综合考虑所有相关图像在排序列表中的位置,对整体排序质量进行评估。它不仅关注是否找到,还关注找到的顺序和完整性,尤其适用于存在多个正样本(如同一行人在不同摄像头下的多个截图)的场景。

目前,Market-1501 是最常用的基准数据集之一,包含来自6个摄像头的32,668张行人图像,涵盖1,501个身份。使用该数据集进行标准化评估,使得不同方法之间的比较具有公平性和可复现性。值得注意的是,得益于部件对齐、注意力机制和 Transformer 架构的引入,当前 SOTA(State-of-the-Art)方法在 Market-1501 上已取得显著突破:例如 TransReID 和 BoT(Bag of Tricks) 等模型在统一实验设置下实现了 Rank-1 准确率超过 96%、mAP 超过 88% 的性能,远超早期深度学习方法(如 2017 年 PCB 的 Rank-1 ≈ 93.8%,mAP ≈ 81.6%)。这一进展表明,ReID 技术正逐步从实验室走向高可靠性的实际部署。

成功的 ReID 系统 = 强特征提取 + 合理损失设计 + 标准化评估(Rank-1 与 mAP)

⚠️ 注意: Rank-1 高但 mAP 低,可能意味着模型只能找到“最像”的一个样本,却漏掉了其他正确匹配;反之,mAP 高说明系统在召回和排序上更全面,更适合实际部署。

掌握这些基础概念、流程与评估标准,你就已经站在了 ReID 技术的大门前。接下来,无论是深入模型架构、探索损失函数设计,还是优化工程部署,都将有清晰的坐标可循。

总结

- ReID 核心是跨视角行人匹配,依赖深度特征与度量学习

- 现代实践以 ResNet 为骨干,结合三元组损失与部件对齐策略

- 必须使用 Rank-1 和 mAP 在标准数据集(如 Market-1501)上评估性能

延伸阅读

推荐尝试开源项目 Deep-Person-ReID 或 Person_reID_baseline_pytorch 进行快速实验

参考资料

🌐 网络来源

本文由 Vibe-Blog 自动发布

网硕互联帮助中心

网硕互联帮助中心![[特殊字符]BZOJ 离线刷题神级工具!免联网 + 浏览器即开 + 题解代码全,效率直接翻倍!-网硕互联帮助中心](https://www.wsisp.com/helps/wp-content/uploads/2026/01/20260125122457-69760b9998bf0-220x150.png)

评论前必须登录!

注册