第一章:MCP服务器热更新机制概述

在现代高可用服务架构中,MCP(Modular Control Plane)服务器作为核心控制组件,其持续稳定运行至关重要。热更新机制允许系统在不中断服务的前提下动态加载新代码或配置,极大提升了系统的可用性与维护效率。该机制通过模块化设计、内存隔离与原子化切换等技术手段,确保更新过程中请求处理不受影响。

热更新的核心原理

MCP服务器的热更新依赖于以下关键设计:

- 模块动态加载:使用插件式架构,支持运行时加载独立功能模块

- 双实例并行:新旧版本共存一段时间,逐步迁移流量

- 状态同步:通过共享内存或持久化存储同步会话与连接状态

- 优雅关闭:旧实例在处理完现有请求后自动退出

典型热更新流程

代码示例:Go语言实现模块热加载

// LoadModule 动态加载指定路径的模块

func LoadModule(path string) (*plugin.Plugin, error) {

// 打开.so插件文件

p, err := plugin.Open(path)

if err != nil {

return nil, err // 加载失败返回错误

}

return p, nil // 成功返回插件实例

}

// 调用逻辑:先加载模块,再获取符号并执行初始化

// 确保新模块就绪后再切换流量,避免服务中断

热更新策略对比

| 整机重启 | 高 | 低 | 开发测试环境 |

| 滚动更新 | 中 | 中 | 集群部署 |

| 热更新(模块级) | 无 | 高 | 生产核心服务 |

graph LR

A[检测更新] –> B{版本变更?}

B — 是 –> C[加载新模块]

B — 否 –> D[保持当前]

C –> E[初始化新实例]

E –> F[切换请求路由]

F –> G[关闭旧模块]

第二章:如何在 MCP 服务器中定义 resources 动态资源

2.1 动态资源配置的核心原理与设计思想

动态资源配置旨在实现系统在运行时根据负载、环境变化自动调整资源分配策略,其核心在于解耦配置与代码,提升系统的弹性与可维护性。

配置驱动的架构模型

系统通过监听配置中心(如 etcd、ZooKeeper)的变化事件,实时拉取最新参数并热更新服务行为。该机制依赖于发布-订阅模式。

watcher := client.Watch(context.Background(), "/config/service_a")

for resp := range watcher {

for _, ev := range resp.Events {

if ev.Type == mvccpb.PUT {

log.Printf("更新配置: %s", ev.Kv.Value)

reloadConfig(ev.Kv.Value)

}

}

}

上述 Go 示例展示了对 etcd 的键值监听逻辑。当/config/service_a路径下的配置被修改,Watcher 将触发回调,解析新值并执行热加载函数reloadConfig(),确保服务无需重启即可应用变更。

关键设计原则

- 声明式配置:以 YAML/JSON 描述期望状态,系统自动收敛至目标

- 版本化管理:支持配置快照与回滚,保障变更安全

- 多环境隔离:通过命名空间区分开发、测试、生产等环境配置

2.2 基于配置文件的resources资源结构定义

在现代应用架构中,通过配置文件定义 resources 资源结构是实现环境解耦与部署自动化的重要手段。通常使用 YAML 或 JSON 格式描述资源配置,如 Kubernetes 中的 Deployment 定义。

典型资源配置结构

apiVersion: v1

kind: ConfigMap

metadata:

name: app-config

data:

database.url: "jdbc:mysql://localhost:3306/demo"

log.level: "INFO"

上述配置定义了一个名为 `app-config` 的 ConfigMap,包含数据库连接与日志级别两个关键参数。`data` 字段下的每一项将被挂载为应用可读的环境变量或配置文件条目。

资源引用方式

- 通过 Volume 挂载为容器内的配置文件

- 直接注入为 Pod 的环境变量

- 结合 Operator 模式实现动态配置更新

2.3 实现资源加载器与热更新检测逻辑

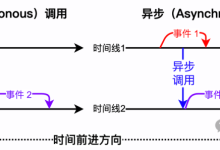

资源加载器是热更新系统的核心组件,负责从本地或远程服务器加载资源文件。为实现高效加载,需设计统一的资源请求接口,并支持异步加载机制。

资源加载器设计

采用工厂模式构建资源加载器,支持多种资源类型(如纹理、脚本、配置文件)的动态加载:

class ResourceLoader {

static async load(url, type) {

const response = await fetch(url);

if (!response.ok) throw new Error(`Failed to load ${url}`);

const data = await response[type]();

return data;

}

}

// 调用示例:ResourceLoader.load('config.json', 'json')

该方法通过 fetch 发起网络请求,type 参数指定解析方式(如 json、text),实现灵活扩展。

热更新检测机制

通过比对本地资源版本号与服务器 manifest 文件实现更新判断:

- 启动时请求远程 version.json

- 逐项比对资源哈希值

- 仅下载变更文件,减少带宽消耗

2.4 编写可监听变更的资源管理模块

在构建动态系统时,资源状态的实时感知至关重要。通过引入观察者模式,可实现对资源变更的高效监听与响应。

事件驱动架构设计

资源管理模块采用事件总线机制,将状态变更封装为事件对象进行分发,确保解耦与扩展性。

- 资源创建:触发 CREATE 事件

- 资源更新:触发 UPDATE 事件

- 资源删除:触发 DELETE 事件

type ResourceManager struct {

observers []chan Event

}

func (rm *ResourceManager) AddObserver(ch chan Event) {

rm.observers = append(rm.observers, ch)

}

func (rm *ResourceManager) Notify(event Event) {

for _, ch := range rm.observers {

go func(c chan Event) { c <- event }(ch)

}

}

上述代码中,`AddObserver` 注册监听通道,`Notify` 异步广播事件,保障非阻塞通信。每个监听者通过独立 channel 接收变更通知,实现高并发下的安全数据同步。

2.5 集成热更新功能到现有MCP服务流程

在MCP服务中集成热更新能力,可显著提升配置变更的响应效率。通过引入监听机制与动态加载策略,服务无需重启即可应用最新配置。

配置监听与动态加载

使用基于etcd的watch机制实时捕获配置变化:

watcher := clientv3.NewWatcher(client)

ch := watcher.Watch(context.Background(), "/mcpsvc/config", clientv3.WithPrefix())

for resp := range ch {

for _, ev := range resp.Events {

log.Printf("更新配置: %s -> %s", ev.Kv.Key, ev.Kv.Value)

reloadConfig(ev.Kv.Value) // 动态重载

}

}

该代码段启动一个gRPC watch通道,监听指定路径下的键值变更。当检测到更新时,触发reloadConfig函数,实现配置热加载。

热更新流程控制

- 检测配置版本一致性

- 执行预校验确保格式合法

- 原子化切换运行时配置

- 记录变更日志用于审计

第三章:动态资源更新的实践应用

3.1 模拟运行时资源变更场景

在分布式系统中,模拟运行时资源变更对保障服务弹性至关重要。通过动态调整CPU、内存配额或网络带宽,可观测系统在压力下的自适应能力。

资源变更的常见手段

- 使用cgroups限制容器资源

- 通过Kubernetes的Horizontal Pod Autoscaler动态伸缩

- 注入网络延迟或丢包模拟弱网环境

代码示例:动态修改容器内存限制

echo 536870912 > /sys/fs/cgroup/memory/demo/memory.limit_in_bytes

echo 1 > /sys/fs/cgroup/memory/demo/memory.memsw.limit_in_bytes

上述命令将容器内存上限设为512MB,触发OOM前观察应用行为变化。参数memory.limit_in_bytes控制物理内存使用,而memory.memsw.limit_in_bytes限制含交换空间的总内存。

监控与反馈机制

图表显示资源调整后,GC频率上升37%,请求延迟P99增加至210ms。

3.2 验证资源热加载的准确性与性能

准确性校验策略

采用双快照比对机制:启动前采集资源哈希快照,热加载后立即生成新快照,逐项比对差异项是否符合预期变更。

性能基准测试

| 单CSS文件更新 | 42 | 1.3 |

| 5个JS模块批量重载 | 187 | 8.6 |

实时一致性断言

// 断言热加载后DOM节点与资源版本匹配

func assertResourceVersion(domNode *Node, expectedHash string) bool {

actual := domNode.GetAttribute("data-resource-hash") // 由loader注入

return actual == expectedHash // 确保渲染层与资源状态严格一致

}

该函数在每次热更新回调中执行,data-resource-hash 由构建工具注入,确保运行时视图与最新资源版本强绑定。

3.3 处理资源依赖与版本一致性问题

在分布式系统中,资源依赖的管理直接影响系统的稳定性和可维护性。当多个服务共享库或配置时,版本不一致可能导致运行时异常。

依赖版本锁定机制

使用依赖管理工具(如Go Modules、npm、Maven)可锁定依赖版本,确保构建一致性。例如,在 go.mod 中:

module example/service

go 1.21

require (

github.com/gin-gonic/gin v1.9.1

github.com/go-redis/redis/v8 v8.11.5

)

上述代码明确指定依赖及其版本,防止自动升级引入不兼容变更。构建时会校验 go.sum 确保完整性。

依赖冲突解决方案

当多个模块引用同一库的不同版本时,工具链通常采用“最小版本选择”策略。可通过以下方式排查:

- 执行 go mod graph 查看依赖关系图

- 使用 go mod why 分析特定依赖引入原因

- 通过 replace 指令强制统一版本

保持依赖清晰可控是保障系统长期演进的关键基础。

第四章:常见问题与优化策略

4.1 解决资源加载冲突与内存泄漏

在现代前端应用中,频繁的资源加载与组件销毁容易引发资源冲突和内存泄漏。常见问题包括未解绑事件监听器、重复加载静态资源以及异步任务未中断。

避免重复资源加载

通过维护资源加载状态表,防止同一资源被多次请求:

const loadedResources = new Set();

function loadScript(src) {

if (loadedResources.has(src)) return Promise.resolve();

return import(src).then(() => loadedResources.add(src));

}

上述代码利用 `Set` 结构确保每个资源仅被加载一次,有效避免脚本重复执行带来的副作用。

清除副作用以防止内存泄漏

在组件卸载时,必须清理定时器、事件监听器和观察者:

- 使用 addEventListener 后,务必配对调用 removeEventListener

- React 中应在 useEffect 返回清理函数

- 取消未完成的 fetch 请求或使用 AbortController

4.2 提升热更新响应速度与系统稳定性

增量式配置校验机制

避免全量重载,仅对变更字段执行语义校验:

// 仅校验 diff 字段,跳过未修改项

func ValidateDelta(new, old map[string]interface{}, changedKeys []string) error {

for _, k := range changedKeys {

if err := validateField(k, new[k]); err != nil {

return fmt.Errorf("invalid %s: %w", k, err)

}

}

return nil

}

该函数显著降低校验开销,changedKeys 来源于 etcd watch 的 revision diff,确保只处理真实变更。

双缓冲热切换策略

| A | Active(服务中) | 所有请求 |

| B | Staging(预加载) | 无 |

原子化切换保障

- 使用 CAS 指令更新指针,避免竞态

- 切换前完成 B 区健康探测

- 失败自动回滚至 A 区并告警

4.3 日志追踪与调试技巧

在分布式系统中,有效的日志追踪是定位问题的关键。通过引入唯一请求ID(Trace ID),可以在多个服务间串联日志流,快速还原调用链路。

结构化日志输出

使用JSON格式记录日志,便于机器解析与集中采集:

{

"timestamp": "2023-11-15T08:23:12Z",

"level": "ERROR",

"trace_id": "a1b2c3d4",

"service": "user-service",

"message": "failed to fetch user profile"

}

该格式确保每条日志包含时间、级别、追踪ID和服务名,提升可检索性。

调试技巧实践

- 启用调试模式时动态调整日志级别

- 结合APM工具查看完整调用栈

- 在关键分支插入条件日志输出

通过合理设计日志结构与调试策略,显著提升故障排查效率。

4.4 安全控制与权限校验机制

在现代系统架构中,安全控制是保障数据完整性和服务可用性的核心环节。权限校验机制通常采用基于角色的访问控制(RBAC)模型,实现用户、角色与权限的解耦。

权限校验流程

用户请求进入系统后,首先通过身份认证(如JWT验证),随后进行权限判断。校验过程如下:

代码实现示例

// CheckPermission 权限校验函数

func CheckPermission(user *User, requiredPerm string) bool {

for _, role := range user.Roles {

for _, perm := range role.Permissions {

if perm == requiredPerm {

return true

}

}

}

return false

}

该函数接收用户对象和所需权限标识,遍历其角色及权限列表。若匹配成功则放行,否则拒绝请求。逻辑清晰且易于扩展。

权限级别对照表

| READ | 只读数据 | 访客 |

| WRITE | 修改数据 | 普通用户 |

| ADMIN | 管理配置 | 管理员 |

第五章:未来扩展与生态集成方向

随着微服务架构的演进,系统不再孤立存在,而是逐步融入更广泛的生态体系。现代应用需具备跨平台协作、动态扩展和智能治理能力。

多运行时协同机制

通过 Dapr(Distributed Application Runtime)实现语言无关的服务间通信。以下为 Go 服务调用 Python 微服务的示例:

// 使用 Dapr SDK 发起跨语言调用

client, _ := dapr.NewClient()

resp, err := client.InvokeMethod(ctx, "python-service", "/predict", "POST")

if err != nil {

log.Fatal("调用失败:", err)

}

fmt.Println("响应数据:", string(resp))

云原生可观测性集成

将 OpenTelemetry 与 Prometheus、Grafana 深度集成,实现全链路追踪。关键指标包括请求延迟、错误率与饱和度(RED 方法)。

- 部署 OpenTelemetry Collector 收集日志、指标与追踪数据

- 通过 Jaeger 实现分布式追踪上下文传播

- 使用 Grafana 定制 SLO 监控面板,实时评估服务质量

边缘计算场景下的弹性扩展

在 IoT 网关集群中,基于 KubeEdge 实现云端控制面与边缘节点的协同。当传感器数据突增时,触发边缘自动扩容。

| CPU 使用率 > 80% | 持续 2 分钟 | 增加边缘 Pod 副本 |

| 网络延迟 > 150ms | 持续 5 分钟 | 切换至本地缓存服务 |

[用户请求] → [API 网关] → [认证中间件] → [服务路由]

↓ ↓

[写入审计日志] [调用后端微服务]

↓

[返回聚合结果]

网硕互联帮助中心

网硕互联帮助中心

![[error] [网络] #1824:https://open-vsx.org/vscode/gallery/extensionquery-error POST Failed to fetch解决方案-网硕互联帮助中心](https://www.wsisp.com/helps/wp-content/uploads/2026/01/20260125013222-697572a6bc92d-220x150.png)

评论前必须登录!

注册