一、注意力机制在医学图像分割中的演变

1.1 传统注意力机制的应用

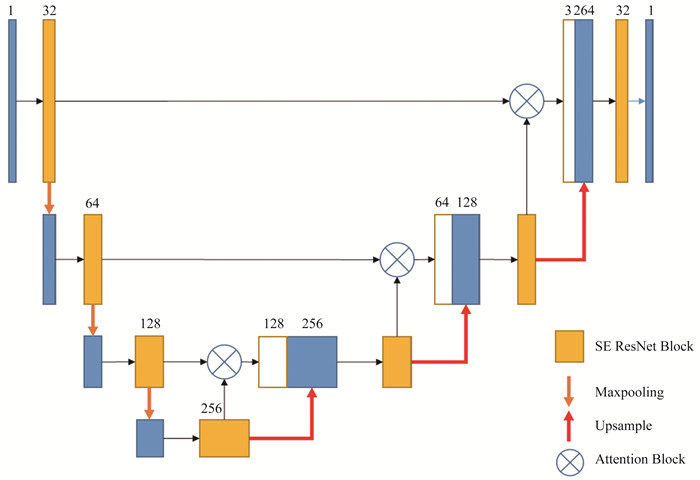

在早期的医学图像分割模型中,注意力机制通常以通道注意力或空间注意力的形式存在。SENet 提出的通道注意力通过全局平均池化获取通道权重,强调重要通道特征。CBAM 进一步结合了通道和空间注意力,形成了更全面的注意力机制。然而,这些方法主要关注局部特征交互,难以捕捉图像中长距离的空间依赖关系。

1.2 自注意力的兴起与挑战

Transformer 模型在自然语言处理领域的巨大成功,推动了自注意力机制在计算机视觉中的应用。Vision Transformer (ViT) 将图像分割为序列化的图像块,并应用自注意力机制进行特征提取。然而,ViT 需要处理大量的图像块,计算复杂度较高,且在小规模数据集上容易过拟合。

在医学图像领域,这种问题尤为突出。医学图像通常具有高分辨率特性,将图像拆分为大量小块会导致计算负担剧增。此外,医学图像数据集通常规模有限,训练复杂的 Transformer 模型容易导致过拟合。

1.3 轴向注意力的创新

轴向注意力(Axial Attention)提供了一种折中方案,它分别沿图像的行和列方向应用自注意力机制。这种方法将二维注意力分解为两个一维注意力操作,显著降低了计算复杂度(从 O(n²) 降至 O(n√n)),同时保持了捕捉长距离依赖的能力。轴向注意力特别适用于医学图像分割任务,因为解剖结构通常具有方向性排列

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册