Mac M1芯片下Python 3.12虚拟环境基础学习教育第三课:M1原生性能优化——让Python代码飞起来!

课程导言

在前两课中,我们已经掌握了:

基础搭建(Mac M1芯片上安装原生Python 3.12,创建/管理虚拟环境);

进阶协作(为多项目创建独立环境,用requirements.txt解决依赖冲突与团队协作)。

但许多同学在实际开发中还会遇到一个关键问题:“Python代码在M1芯片上跑得不够快!” ——尤其是处理数据计算(如NumPy数组运算)、爬虫请求(大量HTTP请求并发)、或机器学习模型推理时,明明M1芯片有强大的CPU/GPU性能,为什么Python程序却没有“起飞”?

答案是:默认的Python解释器(CPython)和库的运行方式没有充分发挥M1的架构优势!

本课目标:从「解释器优化」到「库的底层加速」,教你如何让Python代码在M1芯片上跑得更快、更省资源!

通过本课,你将掌握:

✅ 为什么M1芯片的Python性能需要特殊优化?(理解ARM架构与x86的差异)

✅ 如何用原生ARM64工具链提升基础性能?(Homebrew+Python 3.12的隐藏优化)

✅ 如何用NumPy/Pandas等科学计算库的M1加速版?(告别x86转译,拥抱原生ARM)

✅ 进阶技巧:用PyPy替代CPython,或通过Conda管理优化库!(适合计算密集型场景)

一、为什么M1芯片的Python默认性能不够强?

1.1 M1芯片的“天赋”与Python的“局限”

苹果M1/M2芯片采用ARM64架构,拥有:

-

统一内存架构(UMA):CPU/GPU/神经引擎共享高速内存,数据交换延迟极低;

-

高性能CPU核心(Firestorm):单核性能接近x86高端桌面CPU,多核并行效率优秀;

-

专用硬件加速单元(如NEON指令集):对浮点运算、矩阵操作等有天然优化。

但Python默认的CPython解释器(我们一直用的官方版本)存在两个瓶颈:

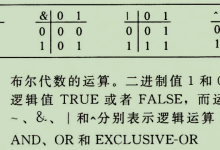

解释执行而非编译执行:Python代码逐行解释运行,无法直接利用CPU的SIMD(单指令多数据)指令集(如NEON);

依赖的C扩展库可能非原生ARM64:许多科学计算库(如旧版NumPy)在Mac上原本是为x86_64编译的,在M1上需通过Rosetta 2转译运行,性能损失可达30%-5

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册