《Transformer模型PyTorch实现全攻略:架构拆解、代码示例与优化技巧》

本篇技术博文摘要 🌟 文章开篇即阐明使用PyTorch框架实现Transformer的实际价值与重要意义,指出其在自然语言处理等领...

本篇技术博文摘要 🌟 文章开篇即阐明使用PyTorch框架实现Transformer的实际价值与重要意义,指出其在自然语言处理等领...

步骤1:位置嵌入与词映射import torch import torch.nn as nn import mathclass Transform...

一、Transformer 的输入是什么? Transformer 的输入是数字化的序列数据,需经过3 层编码后才能送入注意力层和...

从Transformer 底层原理 来看,提示词的“冗余”是一个与模型的 注意力机制 、 上下文理解逻辑 以及 信息处理效率 一、先理解:为什么叫「自注意力」?...

目录 1 LLM (大语言模型) 2 Transformer (自注意力机制) 3 Prompt (提示词) 4 理解API 5 Function Callin...

本文深入探讨了Anthropic的Skills与MCP如何协同工作构建智能代理。MCP提供外部工具连接性,Skills提供工作流程逻辑和专业知识&...

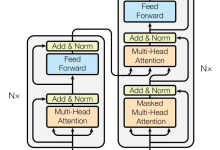

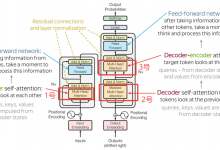

目的 为避免一学就会、一用就废,这里做下笔记 说明 本文内容紧承前文-Transformer架构1-整体介绍、Transformer架构2-...

文章目录一、Self-Attention原理二、Self-Attention代码实现1.单头注意力单头注意力的代码实现2.多头注意力多头注意力的计算流程多头注意...

引言:NLP领域的范式转移 2017年,谷歌的研究团队在论文《Attention is All You Need》中提出了一种全新的神经网络架构——Trans...

前言:推开那扇通往“上帝视角”的门 🌪️ 一场静悄悄的革命 把时针拨回 2017 年。 那时候的 AI 还在费劲地像小学生一...