别让服务器断电毁了你三天三夜的训练!mmdetection resume实战避坑指南

深夜,实验室里只有风扇的嗡鸣和屏幕的微光。你盯着屏幕上缓慢增长的验证集mAP曲线,心里盘算着再有几个小时,这个关键实验的结果就能出炉了。突然,屏幕一黑,风扇声戛然而止——整栋楼跳闸了。那一刻,你脑子里闪过的不是实验数据,而是那个已经跑了72小时的训练任务。三天三夜的心血,难道要因为一次意外断电就付诸东流?

如果你正在使用MMDetection这类开源框架进行计算机视觉模型的训练,那么“训练中断”几乎是一个绕不开的坎。无论是服务器意外重启、实验室断电,还是简单的SSH连接超时,都可能导致一个长时间运行的训练任务戛然而止。好消息是,现代深度学习框架大多提供了完善的恢复机制,坏消息是,如果你不了解其中的细节和陷阱,恢复过程本身就可能变成一场新的灾难。

这篇文章就是为你准备的实战指南。我们不谈空洞的理论,直接从那个最让你心跳加速的场景出发:服务器突然断电后,如何安全、高效地恢复MMDetection训练,并且在这个过程中避开那些常见的“坑”。我会结合自己多次“踩坑”的经验,带你深入理解–resume参数背后的机制,掌握work_dirs目录的管理艺术,并学会利用TensorBoard日志进行精准的问题诊断。无论你是刚刚入门CV领域的研究生,还是在工业界部署模型算法的工程师,这些实战技巧都能让你在面对意外时更加从容。

1. 理解核心:–resume 到底做了什么?

很多人以为–resume就是简单地加载一个.pth文件然后继续训练,但实际上,这个简单的参数背后隐藏着一套完整的状态恢复机制。理解这套机制,是你成功恢复训练的第一步。

1.1 不仅仅是权重:训练状态的完整快照

当你使用–resume时,MMDetection(基于MMEngine)尝试恢复的不仅仅是模型权重。一个完整的checkpoint文件包含了训练在某个时间点的完整状态,这通常包括:

- 模型权重:这是最明显的部分,即网络各层的参数。

- 优化器状态:优化器(如Adam、SGD)内部的所有动量缓存、二阶矩估计等。对于Adam优化器,这意味着每个参数的m和v向量。

- 学习率调度器状态:当前的学习率值,以及调度器内部的状态(比如CosineAnnealingLR当前处于第几个周期)。

- 当前的epoch和iteration计数:训练进行到了哪个epoch的哪个batch。

- 随机数生成器状态:确保恢复后数据加载的随机性是一致的。

- 其他训练元数据:如当前的最佳验证指标、训练时长等。

为什么优化器状态如此重要?想象一下你在训练一个使用Adam优化器的模型。Adam会为每个参数维护两个移动平均值(一阶矩和二阶矩估计)。如果你只加载模型权重而重置优化器,相当于在训练曲线中间突然改变了优化算法,这可能导致训练不稳定甚至发散。

注意:不同版本的MMDetection/MMEngine在checkpoint中保存的具体字段可能略有差异。在恢复训练前,最好先用Python快速检查一下checkpoint文件的内容结构。

你可以用几行代码快速查看checkpoint的内容:

import torch

checkpoint = torch.load('your_checkpoint.pth', map_location='cpu')

print(checkpoint.keys())

# 通常会看到:['meta', 'state_dict', 'optimizer', 'lr_scheduler', 'epoch', 'iter']

1.2 resume-from vs load-from:关键区别解析

在OpenMMLab生态中,你可能会遇到两个相似的参数:–resume-from和–load-from。虽然它们都涉及加载模型文件,但行为有本质区别。理解这个区别,能帮你避免很多困惑。

| –resume-from | 模型权重 + 优化器状态 + 调度器状态 + 随机种子等完整训练状态 | 继承检查点中的epoch数 | 训练意外中断后的恢复 |

| –load-from | 仅模型权重 | 从0开始 | 迁移学习、微调预训练模型 |

这个区别在实际操作中非常关键。举个例子:如果你的训练在epoch 50时中断,你有一个epoch_50.pth文件。

- 使用–resume-from epoch_50.pth:训练会从epoch 50继续,学习率调度器会基于之前的状态继续调整,优化器动量得以保持。

- 使用–load-from epoch_50.pth:训练会从epoch 0开始,但模型初始权重是epoch 50时的权重。优化器状态被重置,学习率从头开始调度。

在MMDetection 3.x版本中,–resume参数的行为对应上表中的–resume-from。如果你在配置文件中设置,对应的字段是resume = True配合load_from路径。

1.3 自动恢复机制:–resume不加路径的秘密

你可能见过这样的命令:

python tools/train.py configs/faster_rcnn/faster-rcnn_r50_fpn_1x_coco.py –resume

注意这里–resume后面没有跟具体的文件路径。这是MMEngine提供的一个便利功能:自动查找最新checkpoint。

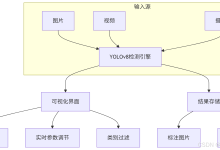

当你不指定路径时,框架会按照以下逻辑寻找可恢复的checkpoint:

这个特性很方便,但也隐藏着风险。假设你的latest.pth文件损坏了,或者被误删了,框架会默默地开始一个新的训练,而你可能会误以为恢复成功了。我个人的习惯是:总是显式指定checkpoint路径,除非是在快速原型开发中。

2. 断电后的第一步:诊断与定位

服务器恢复供电后,你的第一反应可能是立即尝试恢复训练。但请稍等,先花10分钟做好诊断,这能避免后续更多的时间浪费。

2.1 检查文件系统完整性:隐藏的数据损坏

突然断电最糟糕的影响不是训练中断,而是可能导致文件系统损坏或文件写入不完整。特别是如果断电发生在checkpoint保存过程中,你得到的可能是一个损坏的.pth文件。

首先,检查目标目录的文件是否完整:

# 进入你的实验目录

cd work_dirs/your_experiment

# 列出所有checkpoint文件,按时间排序

ls -lt *.pth

# 检查文件大小是否异常(与之前的checkpoint比较)

ls -lh *.pth

# 尝试用torch加载,检查是否损坏

python -c "import torch; ckpt=torch.load('epoch_50.pth', map_location='cpu'); print('Checkpoint loaded successfully')"

如果最后一个命令报错(如EOFError、pickle.UnpicklingError),说明文件可能已损坏。在这种情况下,你不能使用这个checkpoint恢复,而需要回退到更早的完整checkpoint。

2.2 定位正确的checkpoint:不仅仅是“最新”的

在work_dirs目录中,你可能会看到多种checkpoint文件:

- epoch_{N}.pth:每个epoch结束时保存的完整checkpoint

- iter_{N}.pth:按iteration间隔保存的checkpoint(如果配置了)

- latest.pth:指向最新checkpoint的软链接或实际文件

- best_{metric}.pth:保存的最佳模型(根据验证指标)

关键点:latest.pth不一定是你训练中断时的准确状态。因为checkpoint保存是异步操作,如果断电发生在保存过程中,latest.pth可能指向一个未完全写入的文件。

更可靠的方法是:查看TensorBoard或日志文件,确定训练实际中断的位置,然后选择那个时间点之前最近的一个完整checkpoint。

2.3 理解work_dirs的目录结构

一个组织良好的work_dirs目录是快速恢复训练的基础。典型的MMDetection实验目录结构如下:

work_dirs/

└── faster-rcnn_r50_fpn_1x_coco/

├── 20250101_120000/ # 时间戳子目录(MMEngine默认)

│ ├── vis_data/ # 可视化数据

│ │ └── events.out.tfevents… # TensorBoard日志

│ ├── epoch_10.pth # checkpoint文件

│ ├── epoch_20.pth

│ ├── latest.pth # 软链接到最新checkpoint

│ └── best_coco_bbox_mAP.pth # 最佳模型

├── faster-rcnn_r50_fpn_1x_coco.py # 运行时配置副本

└── log.txt # 训练日志

实用技巧:我习惯在启动训练时使用固定的工作目录,而不是依赖时间戳:

python tools/train.py configs/faster_rcnn/faster-rcnn_r50_fpn_1x_coco.py \\

–work-dir work_dirs/my_experiment_fixed

这样,所有相关文件都在一个固定位置,恢复时更容易找到。

3. 实战恢复:命令、配置与陷阱

现在进入实际操作环节。我将展示几种常见的恢复场景,并指出每个场景中容易踩的坑。

3.1 场景一:从特定epoch恢复(最常用)

假设你的训练在epoch 50时中断,你想从epoch 45的checkpoint继续训练(为了留一些安全边际)。

方法一:命令行直接指定

python tools/train.py configs/faster_rcnn/faster-rcnn_r50_fpn_1x_coco.py \\

–resume work_dirs/faster-rcnn_r50_fpn_1x_coco/epoch_45.pth

方法二:修改配置文件

如果你需要频繁恢复,或者要与其他参数一起调整,修改配置文件可能更方便:

# 在配置文件中添加或修改

resume = True

load_from = 'work_dirs/faster-rcnn_r50_fpn_1x_coco/epoch_45.pth'

# 确保训练总epoch数足够

train_cfg = dict(type='EpochBasedTrainLoop', max_epochs=100) # 原本可能是100,现在从45开始

常见陷阱1:配置文件版本不匹配

这是恢复训练时最常见的问题之一。如果你在训练过程中修改了配置文件(比如调整了数据增强参数),然后尝试用旧的checkpoint恢复,可能会遇到错误。

检查点:恢复前,确保当前使用的配置文件与生成checkpoint时使用的配置文件兼容。至少网络结构不应该有变化。一个保险的做法是,使用work_dirs中保存的配置文件副本:

# 使用work_dirs中保存的配置副本,确保完全一致

python tools/train.py work_dirs/faster-rcnn_r50_fpn_1x_coco/faster-rcnn_r50_fpn_1x_coco.py \\

–resume work_dirs/faster-rcnn_r50_fpn_1x_coco/epoch_45.pth

3.2 场景二:处理CUDA版本与环境变化

服务器断电重启后,你可能会发现CUDA版本、PyTorch版本甚至Python环境发生了变化。这时直接恢复训练可能会失败。

问题诊断步骤:

检查CUDA可用性:

python -c "import torch; print(f'PyTorch: {torch.__version__}'); print(f'CUDA available: {torch.cuda.is_available()}'); print(f'CUDA version: {torch.version.cuda}')"

检查checkpoint的设备映射: 如果checkpoint是在GPU上保存的,但现在只能在CPU上加载,需要指定map_location。虽然MMDetection会自动处理,但了解原理有帮助:

# 手动检查

import torch

checkpoint = torch.load('epoch_45.pth', map_location='cpu')

# 查看权重是否包含CUDA tensor

for key, value in checkpoint['state_dict'].items():

if value.is_cuda:

print(f"{key} is on CUDA")

解决方案:

- 如果环境变化不大(如CUDA 11.3→11.4),通常可以直接恢复

- 如果CUDA版本差异大,考虑在CPU上加载然后保存,再重新加载:import torch

checkpoint = torch.load('epoch_45.pth', map_location='cpu')

torch.save(checkpoint, 'epoch_45_cpu.pth')

然后使用这个CPU版本的checkpoint恢复

3.3 场景三:分布式训练恢复

如果你的原始训练是多GPU分布式训练,恢复时需要特别注意。

单机多卡恢复:

# 假设原来用4卡训练

./tools/dist_train.sh configs/faster_rcnn/faster-rcnn_r50_fpn_1x_coco.py 4 \\

–resume work_dirs/faster-rcnn_r50_fpn_1x_coco/epoch_45.pth

关键点:分布式训练的checkpoint包含了所有GPU的模型状态。恢复时使用的GPU数量最好与原来相同。如果必须改变GPU数量,需要了解:

- 数据并行下,不同GPU数量的batch size效应会不同

- 如果使用SyncBatchNorm,GPU数量变化会影响统计量

多机训练恢复: 多机训练恢复更复杂,因为涉及多个节点的状态同步。基本原则:

3.4 场景四:恢复后调整训练参数

有时你不仅想恢复训练,还想趁机调整一些训练参数。这需要谨慎处理。

可以安全调整的参数:

- max_epochs:增加训练总轮数

- checkpoint间隔:调整保存频率

- log_config:修改日志记录间隔

需要谨慎调整的参数:

- optimizer类型或超参数:改变优化器或学习率会破坏优化器状态的连续性

- model结构:网络结构变化可能导致权重加载失败

- data pipeline:数据预处理变化可能导致训练曲线不连续

如果必须调整优化器: 假设你想在恢复训练时把学习率降低到原来的十分之一:

# 在配置文件中

# 首先正常恢复

resume = True

load_from = 'work_dirs/faster-rcnn_r50_fpn_1x_coco/epoch_45.pth'

# 然后覆盖优化器配置

optim_wrapper = dict(

type='OptimWrapper',

optimizer=dict(type='SGD', lr=0.002, momentum=0.9, weight_decay=0.0001), # 原lr可能是0.02

clip_grad=None

)

注意:这样设置会重置优化器状态。如果你希望保持优化器动量等状态,同时只调整学习率,需要在恢复后通过学习率调度器实现。

4. 高级技巧与深度诊断

掌握了基本恢复操作后,我们来看看一些高级技巧,这些技巧能帮你处理更复杂的情况,并深入理解恢复过程中的细节。

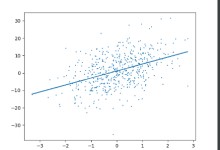

4.1 使用TensorBoard进行恢复验证

TensorBoard不仅是可视化工具,更是验证恢复是否成功的利器。恢复训练后,你应该立即检查训练曲线的连续性。

操作步骤:

启动TensorBoard,同时加载新旧日志:

tensorboard –logdir work_dirs/faster-rcnn_r50_fpn_1x_coco –port 6006

检查关键指标的连续性:

- Loss曲线:恢复后的loss值应该与中断前基本衔接,不会出现突变

- 学习率曲线:如果使用学习率调度器,恢复后的学习率应该延续之前的趋势

- 验证指标:恢复后的验证指标应该与中断前保持可比性

对比分析: 如果你有中断前后的完整日志,可以在TensorBoard中叠加显示,直观查看恢复效果:

上图展示了理想情况下的恢复:蓝色曲线是原始训练,橙色曲线是从epoch 45恢复后的训练,两者平滑衔接。

常见问题诊断:

- 曲线跳跃:如果loss在恢复后突然上升,可能是优化器状态丢失或学习率设置不当

- 指标下降:如果验证指标下降,可能是过拟合或数据加载不一致

- 曲线不连续但趋势一致:如果只是数值偏移但趋势一致,可能是随机种子不同导致的数据顺序差异

4.2 处理“卡在dataloader”的问题

社区中常见的一个问题是:使用–resume后,程序卡在"Advance dataloader"步骤,长时间没有进展。

问题现象:

05/17 11:07:53 – mmengine – WARNING – Advance dataloader 32500 steps to skip data that has already been trained

原因分析: 这是MMEngine的一个设计特性。为了确保恢复后每个样本只被训练一次(避免数据泄露),框架会"快进"dataloader,跳过已经处理过的数据。如果中断时的iteration数很大(如32500),这个快进过程可能需要很长时间,特别是:

- 数据集很大

- 数据预处理复杂

- num_workers设置较小

解决方案:

增加num_workers:

train_dataloader = dict(

batch_size=2,

num_workers=8, # 增加worker数量,加速数据加载

persistent_workers=True,

sampler=dict(type='DefaultSampler', shuffle=True),

dataset=train_dataset

)

使用更高效的数据加载:

- 确保数据存储在SSD而不是HDD

- 使用persistent_workers=True避免重复创建worker

- 预处理好数据,减少在线预处理开销

调整恢复策略: 如果快进时间实在无法接受,可以考虑:

- 不从精确的iteration恢复,而是从最近的epoch开始(会损失少量数据,但通常影响不大)

- 修改源代码,禁用严格的数据跳过(不推荐,可能影响结果可复现性)

4.3 随机种子与可复现性

深度学习中的随机性主要来自:

恢复训练时,如果随机种子管理不当,可能导致:

- 两次训练的结果不可直接比较

- 恢复后的训练效果与预期不符

MMEngine的随机种子管理:

MMEngine会在checkpoint中保存随机状态,恢复时自动加载。但你需要确保:

配置中正确设置随机种子:

# 在配置文件中

randomness = dict(seed=42, diff_rank_seed=True)

理解diff_rank_seed的作用:

- False:所有进程使用相同随机种子

- True:不同rank的进程使用不同的随机种子(基于基础种子派生)

恢复后的验证: 恢复训练后,可以运行一个简短的验证,确保结果与中断前一致(在允许的随机误差范围内)。

4.4 Checkpoint管理策略

良好的checkpoint管理不仅能帮你恢复训练,还能为模型选择、调试和分析提供支持。

推荐的文件命名和组织方式:

work_dirs/

└── coco_faster_rcnn_r50_20240101/

├── config.py # 实验配置

├── train.log # 完整训练日志

├── checkpoints/ # 专门存放checkpoint

│ ├── epoch_10.pth

│ ├── epoch_20.pth

│ ├── …

│ └── best/

│ ├── best_mAP_0.425.pth # 包含指标值的命名

│ └── best_loss_1.234.pth

├── tensorboard/ # TensorBoard日志

└── analysis/ # 分析结果

自动化清理脚本: 长时间训练会产生大量checkpoint,占用大量磁盘空间。我使用一个简单的Python脚本定期清理:

#!/usr/bin/env python3

"""

checkpoint清理脚本

保留策略:

1. 每10个epoch保留一个

2. 最后10个epoch全部保留

3. 最佳模型全部保留

"""

import os

import re

import glob

def clean_checkpoints(checkpoint_dir, keep_every=10, keep_last=10):

"""清理checkpoint文件"""

# 获取所有checkpoint文件

checkpoint_files = glob.glob(os.path.join(checkpoint_dir, "epoch_*.pth"))

# 提取epoch数字

epoch_files = []

for f in checkpoint_files:

match = re.search(r'epoch_(\\d+)\\.pth', os.path.basename(f))

if match:

epoch = int(match.group(1))

epoch_files.append((epoch, f))

# 按epoch排序

epoch_files.sort(key=lambda x: x[0])

# 确定要保留的文件

keep_files = set()

# 保留策略1:每隔keep_every个保留一个

for epoch, f in epoch_files:

if epoch % keep_every == 0:

keep_files.add(f)

# 保留策略2:保留最后keep_last个

for epoch, f in epoch_files[-keep_last:]:

keep_files.add(f)

# 永远保留best模型

best_files = glob.glob(os.path.join(checkpoint_dir, "best_*.pth"))

keep_files.update(best_files)

# 删除不需要的文件

for f in checkpoint_files:

if f not in keep_files:

print(f"删除: {f}")

os.remove(f)

print(f"清理完成。原始{len(checkpoint_files)}个文件,保留{len(keep_files)}个")

if __name__ == "__main__":

clean_checkpoints("work_dirs/my_experiment/checkpoints")

4.5 监控与预警系统

对于长时间训练任务,预防胜于治疗。建立简单的监控系统,可以在问题发生前预警。

基础监控脚本:

#!/usr/bin/env python3

"""

训练监控脚本

功能:

1. 检查训练进程是否存活

2. 检查日志是否更新

3. 检查GPU使用情况

4. 发送预警通知

"""

import os

import time

import subprocess

import smtplib

from email.mime.text import MIMEText

from datetime import datetime

class TrainingMonitor:

def __init__(self, log_file, check_interval=300):

self.log_file = log_file

self.check_interval = check_interval

self.last_size = 0

self.last_update = time.time()

def check_training_alive(self):

"""检查训练进程是否存活"""

try:

# 查找包含train.py的进程

result = subprocess.run(

["pgrep", "-f", "train.py"],

capture_output=True,

text=True

)

return bool(result.stdout.strip())

except:

return False

def check_log_progress(self):

"""检查日志文件是否有更新"""

if not os.path.exists(self.log_file):

return False

current_size = os.path.getsize(self.log_file)

current_time = time.time()

if current_size > self.last_size:

self.last_size = current_size

self.last_update = current_time

return True

else:

# 如果超过1小时没有更新,认为训练可能卡住

if current_time – self.last_update > 3600:

return False

return True

def check_gpu_status(self):

"""检查GPU状态"""

try:

result = subprocess.run(

["nvidia-smi", "–query-gpu=utilization.gpu,memory.used",

"–format=csv,noheader,nounits"],

capture_output=True,

text=True

)

gpu_status = result.stdout.strip().split('\\n')

return gpu_status

except:

return ["检查失败"]

def send_alert(self, message):

"""发送预警邮件"""

# 这里需要配置你的邮件服务器

msg = MIMEText(message)

msg['Subject'] = '训练任务异常预警'

msg['From'] = 'monitor@example.com'

msg['To'] = 'your_email@example.com'

# 实际发送代码(需要配置SMTP服务器)

# with smtplib.SMTP('smtp.example.com') as server:

# server.send_message(msg)

print(f"预警: {message}")

def run(self):

"""运行监控循环"""

print(f"开始监控训练任务,日志文件: {self.log_file}")

while True:

time.sleep(self.check_interval)

# 检查各项指标

if not self.check_training_alive():

self.send_alert("训练进程已停止!")

break

if not self.check_log_progress():

self.send_alert("训练日志超过1小时未更新,可能已卡住!")

gpu_status = self.check_gpu_status()

for i, status in enumerate(gpu_status):

util, mem = status.split(',')

if int(util) < 5 and int(mem) < 100:

self.send_alert(f"GPU {i} 利用率过低,可能训练已停止!")

if __name__ == "__main__":

monitor = TrainingMonitor("work_dirs/my_experiment/train.log")

monitor.run()

这个监控脚本可以作为一个后台进程运行,在训练异常时及时通知你,减少损失。

5. 从理论到实践:一个完整恢复案例

让我们通过一个完整的案例,将前面讲的所有知识点串联起来。假设你正在训练一个Faster R-CNN模型,在epoch 65时服务器意外断电。

5.1 案例背景

- 任务:在COCO数据集上训练Faster R-CNN

- 配置:MMDetection 3.0.0, PyTorch 1.11.0, CUDA 11.3

- 训练进度:计划100个epoch,当前完成65个epoch

- 中断原因:实验室区域停电

- 目录结构:work_dirs/coco_faster_rcnn/

├── 20240101_120000/

│ ├── epoch_10.pth

│ ├── epoch_20.pth

│ ├── …

│ ├── epoch_60.pth

│ ├── epoch_65.pth # 最新,但可能损坏

│ └── latest.pth -> epoch_65.pth

├── config.py

└── train.log

5.2 恢复步骤

第一步:评估损失,保持冷静

- 首先确认服务器已完全恢复,所有服务正常

- 不要立即尝试恢复训练,先做好诊断

第二步:检查文件完整性

cd work_dirs/coco_faster_rcnn/20240101_120000

# 检查文件大小

ls -lh epoch_*.pth

# 正常情况:每个文件约450MB

# 如果epoch_65.pth明显偏小(如100MB),可能已损坏

# 尝试加载checkpoint

python -c "

import torch

try:

ckpt = torch.load('epoch_65.pth', map_location='cpu')

print('Checkpoint加载成功')

print(f'Epoch: {ckpt.get(\\"epoch\\", \\"N/A\\")}')

print(f'Keys: {list(ckpt.keys())}')

except Exception as e:

print(f'加载失败: {e}')

"

假设检查发现epoch_65.pth已损坏,但epoch_60.pth完好。

第三步:查看训练日志,确定恢复点

# 查看日志最后几行

tail -50 train.log

# 查找关键信息

grep -n "Epoch(val)" train.log | tail -5

# 输出可能类似:

# 5000: 01/01 12:30:00 – mmengine – INFO – Epoch(val) [60][100/100] mAP: 0.425

# 5100: 01/01 12:45:00 – mmengine – INFO – Epoch(val) [65][100/100] mAP: 0.432

从日志看,epoch 60的mAP是0.425,epoch 65是0.432。虽然损失了5个epoch的进度,但比从头开始好。

第四步:准备恢复环境

# 确认当前环境

python -c "import torch; print(f'PyTorch {torch.__version__}, CUDA {torch.version.cuda if torch.cuda.is_available() else \\"N/A\\"}')"

# 如果环境有变化,可能需要创建conda环境

# conda create -n mmdet python=3.8

# conda activate mmdet

# pip install torch==1.11.0+cu113 torchvision==0.12.0+cu113 -f https://download.pytorch.org/whl/torch_stable.html

# pip install mmdet==3.0.0

第五步:执行恢复命令

# 使用epoch_60.pth恢复

python tools/train.py work_dirs/coco_faster_rcnn/20240101_120000/config.py \\

–resume work_dirs/coco_faster_rcnn/20240101_120000/epoch_60.pth \\

–work-dir work_dirs/coco_faster_rcnn_resumed

注意这里使用了新的工作目录coco_faster_rcnn_resumed,这样可以保留原始的训练记录,方便对比。

第六步:验证恢复效果

第七步:调整训练计划 由于损失了5个epoch,可以考虑:

- 增加总epoch数到105,弥补损失

- 或者保持100个epoch,接受轻微的性能损失

在配置文件中调整:

# 修改配置文件

train_cfg = dict(type='EpochBasedTrainLoop', max_epochs=105) # 原为100

5.3 案例总结与经验

通过这个案例,我们可以总结出一些关键经验:

6. 预防措施:让训练更健壮

虽然恢复技巧很重要,但最好的策略是预防中断。以下是一些让训练过程更健壮的建议。

6.1 硬件与基础设施

- 使用UPS:为关键服务器配备不间断电源,应对短时停电

- ECC内存:使用带错误校正的内存,防止内存错误导致训练崩溃

- RAID存储:使用RAID 1或RAID 5,防止硬盘故障导致数据丢失

- 温度监控:确保GPU温度在安全范围内,避免过热降频或关机

6.2 软件与配置优化

配置自动保存与监控:

# 在MMDetection配置中优化checkpoint设置

default_hooks = dict(

checkpoint=dict(

type='CheckpointHook',

interval=1, # 每个epoch都保存

max_keep_ckpts=10, # 只保留10个最新checkpoint

save_optimizer=True,

save_param_scheduler=True,

by_epoch=True,

out_dir='work_dirs/my_experiment',

save_best=['coco/bbox_mAP', 'coco/bbox_mAP_50'],

rule='greater'

),

logger=dict(type='LoggerHook', interval=50),

)

使用训练管理工具:

- Weights & Biases:提供完整的实验跟踪、版本管理和协作功能

- MLflow:开源平台,管理机器学习生命周期

- DVC:数据版本控制,确保实验可复现

实现断点续传的封装脚本:

#!/usr/bin/env python3

"""

智能训练启动脚本

功能:

1. 自动检测是否有可恢复的checkpoint

2. 处理环境配置

3. 记录完整的训练元数据

"""

import os

import sys

import argparse

import subprocess

import yaml

from datetime import datetime

class SmartTrainLauncher:

def __init__(self, config_path, work_dir=None):

self.config_path = config_path

self.work_dir = work_dir or self._get_default_work_dir()

self.experiment_id = datetime.now().strftime("%Y%m%d_%H%M%S")

def _get_default_work_dir(self):

"""根据配置文件生成默认工作目录"""

config_name = os.path.splitext(os.path.basename(self.config_path))[0]

return f"work_dirs/{config_name}"

def find_latest_checkpoint(self):

"""查找最新的可恢复checkpoint"""

checkpoint_dir = os.path.join(self.work_dir, "checkpoints")

if not os.path.exists(checkpoint_dir):

return None

# 查找.pth文件

import glob

checkpoint_files = glob.glob(os.path.join(checkpoint_dir, "*.pth"))

if not checkpoint_files:

return None

# 按修改时间排序

checkpoint_files.sort(key=os.path.getmtime, reverse=True)

# 验证每个checkpoint,返回第一个有效的

for checkpoint in checkpoint_files:

if self._validate_checkpoint(checkpoint):

return checkpoint

return None

def _validate_checkpoint(self, checkpoint_path):

"""验证checkpoint是否有效"""

try:

import torch

checkpoint = torch.load(checkpoint_path, map_location='cpu')

required_keys = ['state_dict', 'meta']

return all(key in checkpoint for key in required_keys)

except:

return False

def launch_training(self, resume=True, gpus=1):

"""启动训练"""

latest_checkpoint = self.find_latest_checkpoint() if resume else None

# 构建训练命令

cmd = []

if gpus > 1:

cmd.extend([

"./tools/dist_train.sh",

self.config_path,

str(gpus),

f"–work-dir={self.work_dir}"

])

else:

cmd.extend([

"python", "tools/train.py",

self.config_path,

f"–work-dir={self.work_dir}"

])

# 添加resume参数

if latest_checkpoint:

cmd.append(f"–resume={latest_checkpoint}")

print(f"从检查点恢复: {latest_checkpoint}")

else:

print("开始新的训练")

# 添加其他参数

cmd.extend([

"–cfg-options",

f"default_hooks.checkpoint.out_dir={self.work_dir}/checkpoints",

f"default_hooks.logger.log_dir={self.work_dir}/logs"

])

# 执行命令

print(f"执行命令: {' '.join(cmd)}")

subprocess.run(cmd)

def save_experiment_metadata(self):

"""保存实验元数据"""

metadata = {

'experiment_id': self.experiment_id,

'config_path': self.config_path,

'work_dir': self.work_dir,

'start_time': datetime.now().isoformat(),

'environment': {

'python': sys.version,

'pytorch': self._get_pytorch_version(),

'cuda': self._get_cuda_version()

}

}

metadata_path = os.path.join(self.work_dir, "metadata.yaml")

os.makedirs(os.path.dirname(metadata_path), exist_ok=True)

with open(metadata_path, 'w') as f:

yaml.dump(metadata, f)

def _get_pytorch_version(self):

try:

import torch

return torch.__version__

except:

return "N/A"

def _get_cuda_version(self):

try:

import torch

return torch.version.cuda if torch.cuda.is_available() else "N/A"

except:

return "N/A"

if __name__ == "__main__":

parser = argparse.ArgumentParser()

parser.add_argument("config", help="配置文件路径")

parser.add_argument("–work-dir", help="工作目录")

parser.add_argument("–no-resume", action="store_true", help="不尝试恢复")

parser.add_argument("–gpus", type=int, default=1, help="GPU数量")

args = parser.parse_args()

launcher = SmartTrainLauncher(args.config, args.work_dir)

launcher.save_experiment_metadata()

launcher.launch_training(resume=not args.no_resume, gpus=args.gpus)

这个智能启动脚本可以大大简化训练管理,自动处理恢复逻辑,并记录完整的实验元数据。

6.3 训练策略优化

梯度累积:当GPU内存不足时,使用梯度累积模拟更大的batch size,而不是直接使用小batch size:

# 在配置文件中

train_cfg = dict(

type='EpochBasedTrainLoop',

max_epochs=100,

val_interval=1

)

optim_wrapper = dict(

type='OptimWrapper',

optimizer=dict(type='SGD', lr=0.02, momentum=0.9, weight_decay=0.0001),

clip_grad=dict(max_norm=35, norm_type=2),

accumulative_counts=4 # 每4个iteration累积一次梯度

)

混合精度训练:使用AMP减少显存占用,加快训练速度:

python tools/train.py configs/faster_rcnn/faster-rcnn_r50_fpn_1x_coco.py –amp

定期验证与早停:避免在无效的训练上浪费时间:

# 早停配置

default_hooks = dict(

early_stopping=dict(

type='EarlyStoppingHook',

monitor='coco/bbox_mAP',

patience=10, # 10个epoch没有提升就停止

min_delta=0.001,

rule='greater'

)

)

7. 社区资源与问题排查

即使做了充分准备,恢复训练时仍可能遇到各种问题。这时,知道如何有效利用社区资源至关重要。

7.1 有效搜索与问题定位

遇到问题时,不要立即发帖提问。首先尝试:

常用诊断命令:

# 检查版本兼容性

python -c "import mmdet, mmcv, mmengine; print(f'MMDetection: {mmdet.__version__}'); print(f'MMCV: {mmcv.__version__}'); print(f'MMEngine: {mmengine.__version__}')"

# 检查CUDA和cuDNN

python -c "import torch; print(f'CUDA available: {torch.cuda.is_available()}'); print(f'cuDNN enabled: {torch.backends.cudnn.enabled}')"

7.2 准备有效的问题报告

如果需要向社区求助,提供完整的信息能大大加快问题解决速度。一个有效的问题报告应包括:

环境信息:

OS: Ubuntu 20.04

Python: 3.8.10

PyTorch: 1.11.0+cu113

CUDA: 11.3

MMCV: 2.0.0

MMDetection: 3.0.0

复现步骤:

- 完整的训练命令

- 配置文件(简化但关键部分完整)

- 数据准备步骤

错误信息:

- 完整的错误堆栈

- 相关日志片段

已尝试的解决方案:

- 你已尝试过哪些方法

- 每种方法的结果

附加信息:

- 问题是否可稳定复现

- 在哪些版本中出现/不出现

7.3 学习资源推荐

- 官方文档:MMDetection Documentation

- GitHub仓库:open-mmlab/mmdetection

- 社区论坛:OpenMMLab社区

- 论文与教程:关注OpenMMLab团队在CVPR、ICCV等会议上的教程

8. 总结:构建你的恢复工作流

训练中断虽然令人沮丧,但通过系统化的准备和正确的恢复策略,你可以将损失降到最低。回顾本文的内容,我建议你建立自己的恢复工作流:

预防阶段:

- 配置硬件保护(UPS、ECC内存)

- 设置定期checkpoint保存

- 实现训练监控和预警

准备阶段:

- 组织好work_dirs目录结构

- 记录完整的实验元数据

- 定期验证checkpoint完整性

恢复阶段:

- 保持冷静,先诊断再行动

- 检查文件完整性,选择正确的恢复点

- 验证环境一致性,处理版本问题

- 使用TensorBoard验证恢复效果

优化阶段:

- 分析中断原因,改进预防措施

- 优化训练配置,减少中断影响

- 建立标准化恢复流程

在实际项目中,我发现最有效的策略是定期保存完整的实验状态,包括代码、数据、配置和训练状态。这样,即使发生最坏的情况,你也能快速恢复到最近的可用状态。

训练深度学习模型就像一场马拉松,而不是短跑。意外中断是这条路上常见的障碍,但有了正确的工具和策略,你完全可以跨越这些障碍,最终到达终点。记住,每个成功恢复的训练任务,都是对你工程能力的一次提升。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册