第一章:绪论——从离散到连续的范式转移

摘要 (Abstract)

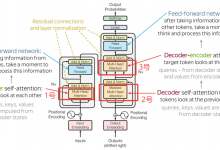

本文旨在探讨深度序列建模领域正在发生的一场根本性范式转移:从基于离散时间步(Discrete Time-steps)的递归架构,向基于连续动力系统(Continuous Dynamical Systems)的神经微分方程演进。我们将重点剖析传统 RNN 与 Transformer 在处理非均匀采样数据与长程依赖时的内生缺陷,并引出液态神经网络(LNN)的核心突破——通过引入输入依赖的液态时间常数(Liquid Time Constant),实现模型参数在推理阶段的自适应调整,从而彻底解决静态权重模型在动态环境下的泛化瓶颈。

1.1 序列建模的历史局限性

在深度学习的经典图景中,时间被视为离散的计数器。无论是早期的 Elman 网络还是现代的 Transformer,其核心假设均建立在固定的离散时钟之上。然而,物理世界的本质是连续的,这种离散化假设在处理现实世界的复杂时序数据时,暴露出了不可忽视的理论缺陷。

1.1.1 离散时间步(Discrete Time-steps)的固有缺陷

传统递归神经网络(RNN)的状态更新遵循

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册