目录

一、SIFT核心原理速览

二、实战项目一:基于SIFT的指纹匹配

2.1 项目功能概述

2.2 核心代码拆解

2.2.1 特征提取与匹配点计数(核心函数)

2.2.2 指纹库比对与身份识别

2.2.3 主函数调用

2.3 关键注意事项

三、实战项目二:基于SIFT的图片全景拼接

3.1 项目功能概述

3.2 核心代码拆解

3.2.1 辅助函数与特征提取

3.2.2 特征匹配与优质匹配对筛选

3.2.3 透视变换(核心环节)

3.2.4 图像变换与拼接

3.3 关键注意事项

四、总结与拓展

在计算机视觉领域,特征提取是实现图像匹配、拼接、识别等任务的核心基础。SIFT(尺度不变特征变换)作为经典的特征提取算法,凭借其**尺度不变性、旋转不变性、光照鲁棒性**,在各类视觉任务中表现优异。本文将结合两个实战项目——指纹匹配与图片全景拼接,从原理到代码逐环节拆解,带你吃透SIFT的实际应用。

一、SIFT核心原理速览

SIFT算法的核心价值的是提取图像中“稳定且唯一”的特征点,不受图像旋转、缩放、光照变化的影响,其流程可简化为三步:

关键点检测:通过高斯差分金字塔,定位图像中具有尺度、方向信息的关键点(如边缘端点、角点、纹理分叉点),这些点是图像的“指纹”。

特征描述子生成:对每个关键点,围绕其构建128维特征向量,描述关键点周围的像素纹理分布,为后续匹配提供依据。

特征匹配:通过计算两张图像特征描述子的距离,找到相似特征点,再通过筛选规则剔除错误匹配,得到可靠匹配对。

二、实战项目一:基于SIFT的指纹匹配

2.1 项目功能概述

本项目通过SIFT提取待识别指纹与指纹库模板的特征,匹配优质特征点数量,找到最相似的模板指纹,实现身份识别;若匹配点数量低于阈值,则判定为未知身份。

2.2 核心代码拆解

2.2.1 特征提取与匹配点计数(核心函数)

该函数负责读取两张指纹图像,提取SIFT特征,通过FLANN匹配器快速匹配并筛选优质特征点,返回有效匹配点数量。

import os

import cv2

import numpy as np

def getNum(src, model):

# 读取指纹图像(待识别指纹src,模板指纹model)

img1 = cv2.imread(src)

img2 = cv2.imread(model)

# 初始化SIFT检测器,提取特征点(kp)与描述子(des)

sift = cv2.SIFT_create()

kp1, des1 = sift.detectAndCompute(img1, None) # None表示无掩膜,处理整张图

kp2, des2 = sift.detectAndCompute(img2, None)

# FLANN匹配器(快速近邻搜索),适合批量模板匹配

flann = cv2.FlannBasedMatcher()

# K近邻匹配(k=2,为每个特征点找最相似、次相似两个匹配)

matches = flann.knnMatch(des1, des2, k=2)

# 比率测试筛选优质匹配(SIFT作者提出,剔除模糊匹配)

good_matches = []

for m, n in matches:

# 最相似匹配距离 < 0.8*次相似匹配距离,视为有效匹配

if m.distance < 0.8 * n.distance:

good_matches.append(m)

return len(good_matches) # 返回优质匹配点数量

2.2.2 指纹库比对与身份识别

遍历指纹库,与待识别指纹逐一比对,记录最大匹配点数量对应的模板,结合阈值判断身份。

def getID(src, database):

max_matches = 0 # 初始化最大匹配点数量

match_name = "" # 匹配成功的模板文件名

# 遍历指纹库所有模板文件

for file in os.listdir(database):

model_path = os.path.join(database, file)

current_matches = getNum(src, model_path)

print(f"模板文件:{file},匹配点数量:{current_matches}")

# 更新最大匹配点数量与对应模板

if current_matches > max_matches:

max_matches = current_matches

match_name = file

# 从模板文件名提取ID(依赖命名规范:ID_姓名.bmp)

if not match_name:

return 9999 # 指纹库为空时返回未知

finger_id = match_name[0]

# 匹配点少于200(经验阈值),判定为未知身份

if max_matches < 200:

finger_id = 9999

return finger_id

# ID与姓名映射

def getName(finger_id):

name_map = {0: '张三', 1: '李四', 2: '王五', 3: '赵六', 4: '朱老七',

5: '钱八', 6: '曹九', 7: '王二麻子', 8: 'Andy', 9: 'Anna', 9999: '未知身份'}

return name_map.get(int(finger_id), "未知身份")

2.2.3 主函数调用

if __name__ == "__main__":

target_finger = "mubiao_zhiwen.bmp" # 待识别指纹路径

finger_database = "database" # 指纹库文件夹路径

id_result = getID(target_finger, finger_database)

name_result = getName(id_result)

print(f"\\n识别结果:{name_result}")

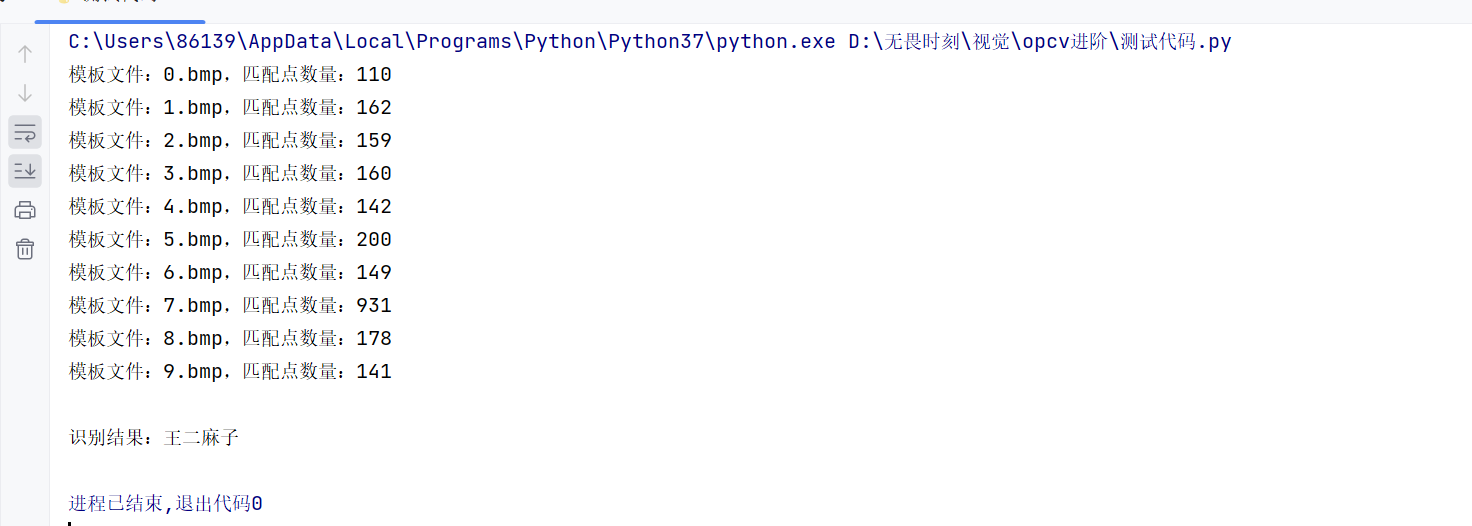

2.2.4执行结果

2.3 关键注意事项

-

指纹库模板命名需规范(如“0_张三.bmp”),确保能从文件名提取ID;

-

匹配阈值200为经验值,需根据指纹图像分辨率调整(低分辨率指纹可降低阈值);

-

FLANN匹配器比暴力匹配器速度更快,适合指纹库数量较多的场景。

三、实战项目二:基于SIFT的图片全景拼接

3.1 项目功能概述

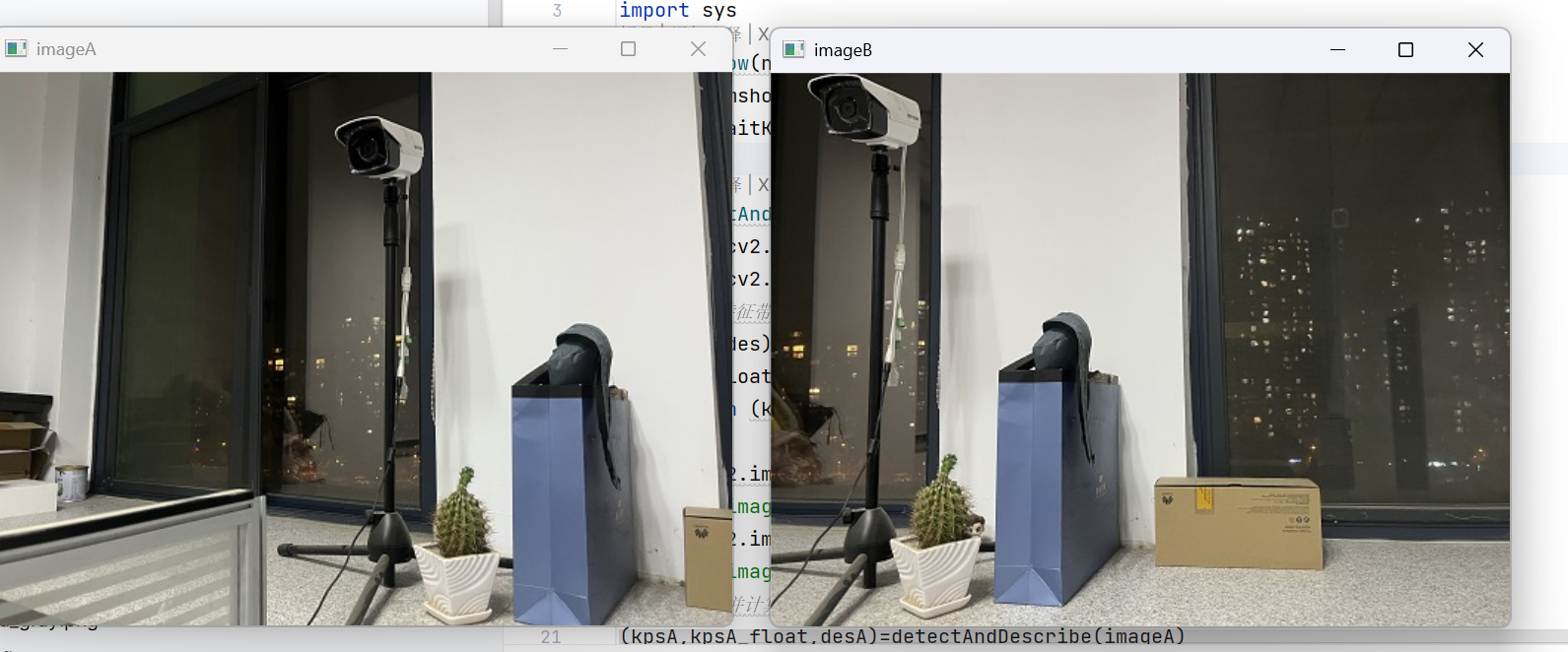

对两张不同角度拍摄、存在重叠区域的照片,通过SIFT匹配特征点,计算透视变换矩阵对齐视角,最终拼接成全景图,核心解决“不同视角图像对齐”问题。原图如下:

3.2 核心代码拆解

3.2.1 辅助函数与特征提取

def cv_show(name, img):

# 封装图片显示函数,按下任意键关闭窗口

cv2.imshow(name, img)

cv2.waitKey(0)

def detectAndDescribe(image):

# 提取SIFT特征,返回特征点对象、浮点型坐标、描述子

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY) # SIFT基于灰度图提取特征

sift = cv2.SIFT_create()

kps, des = sift.detectAndCompute(gray, None)

# 特征点坐标转为float32(后续透视变换计算需求)

kps_float = np.float32([kp.pt for kp in kps])

return (kps, kps_float, des)

3.2.2 特征匹配与优质匹配对筛选

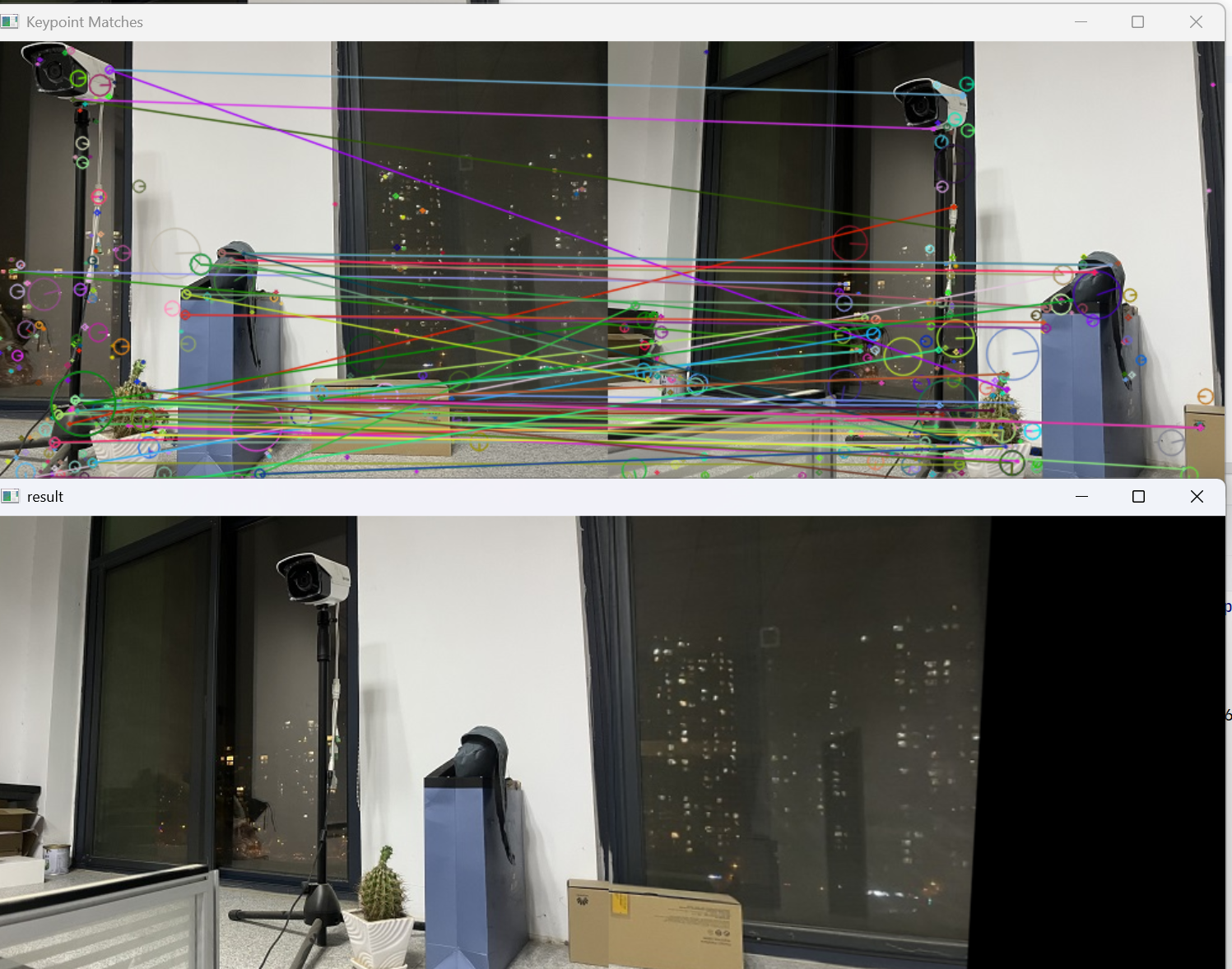

采用暴力匹配器(BFMatcher),匹配精度更高,适合少量图片拼接场景,同时可视化匹配效果。

# 读取两张待拼接图片

imageA = cv2.imread('1.jpg') # 基准图(不做变换)

imageB = cv2.imread('2.jpg') # 待变换图

cv_show("原始图A", imageA)

cv_show("原始图B", imageB)

# 提取两张图的SIFT特征

(kpsA, kpsA_float, desA) = detectAndDescribe(imageA)

(kpsB, kpsB_float, desB) = detectAndDescribe(imageB)

# 暴力匹配器匹配特征描述子

matcher = cv2.BFMatcher()

raw_matches = matcher.knnMatch(desB, desA, k=2) # desB为查询集,desA为训练集

# 筛选优质匹配对(阈值0.65,比指纹匹配更严格,避免对齐偏差)

good_matches = []

matches = [] # 存储匹配对索引(用于后续坐标提取)

for m in raw_matches:

if len(m) == 2 and m[0].distance < 0.65 * m[1].distance:

good_matches.append(m)

# 存储(desB索引,desA索引)

matches.append((m[0].queryIdx, m[0].trainIdx))

# 可视化特征匹配结果

vis = cv2.drawMatchesKnn(

imageB, kpsB, imageA, kpsA, good_matches,

outImg=None, flags=cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS

)

cv_show("特征匹配效果", vis)

3.2.3 透视变换(核心环节)

通过单应性矩阵(Homography)实现视角对齐,单应性矩阵描述了两张图的透视变换关系,需至少4个匹配对计算,结合RANSAC算法剔除外点(错误匹配)。

import sys

if len(matches) > 4:

# 提取匹配对对应的特征点坐标

ptsB = np.float32([kpsB_float[i] for (i, _) in matches]) # imageB特征点

ptsA = np.float32([kpsA_float[i] for (_, i) in matches]) # imageA特征点

# 计算单应性矩阵(透视变换矩阵)

# cv2.RANSAC:通过随机样本一致性算法剔除外点,提升矩阵鲁棒性

# ransacReprojThreshold=10:重投影误差阈值,超过10的为外点

(H, mask) = cv2.findHomography(ptsB, ptsA, cv2.RANSAC, 10.0)

else:

print("未找到足够匹配点(需≥4个),无法拼接")

sys.exit()

3.2.4 图像变换与拼接

# 对imageB执行透视变换,对齐到imageA视角

# 输出尺寸:宽度=两张图宽度之和(预留拼接空间),高度=imageB高度

result = cv2.warpPerspective(imageB, H, (imageB.shape[1] + imageA.shape[1], imageB.shape[0]))

cv_show("变换后imageB", result)

# 将基准图imageA叠加到变换后的图像左侧

result[0:imageA.shape[0], 0:imageA.shape[1]] = imageA

cv_show("最终拼接全景图", result)

# 保存结果

cv2.imwrite('pingjie.jpg', result)

3.2.5执行结果

3.3 关键注意事项

-

两张图片需存在重叠区域(至少30%),否则无法提取足够匹配点;

-

单应性矩阵是拼接核心,RANSAC算法能有效剔除错误匹配,避免拼接变形;

-

重叠区域可通过加权平均做渐变融合,消除直接覆盖导致的拼接痕迹。

四、总结与拓展

本文通过两个实战项目,展示了SIFT特征提取在视觉任务中的核心作用:指纹匹配依赖SIFT的稳定性实现身份识别,图片拼接通过SIFT匹配+透视变换解决视角对齐问题。两者的核心逻辑一致——提取稳定特征→匹配筛选→基于匹配结果完成任务。

拓展方向:

算法替代:SIFT为专利算法,可改用ORB(快速、开源)实现实时性需求;

多图拼接:循环匹配多张图片,逐步扩展全景图范围;

精度优化:调整匹配阈值、重投影误差阈值,结合图像预处理(降噪、增强)提升效果。

掌握SIFT的核心原理与实操,能为后续图像识别、目标跟踪等复杂视觉任务奠定基础。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册