作为架构师,我们在设计和管理软件系统,为了能清楚了解系统性能,每个架构师都必须彻底了解正在设计的各种软件服务、它们彼此之间的交互以及每个服务和整个系统的性能需求。

1. 首字节到达时间(TTFB)

TTFB测量从客户端向服务器发送请求直到客户端从服务器收到第一个字节数据的所需时间。它是服务器响应能力和网络延迟的指示器。示例: 网站的TTFB为 200 毫秒,表示服务器的初始响应很快。

泛化后的指标就是延迟。是请求从发送方传递到接收方以及响应传递回来所需的时间。它是衡量一个系统所经历的延迟的一种方法。示例: 用户的请求到达服务器并接收响应所需的时间是 100 毫秒。

延迟中包含了系统的响应时间。响应时间是系统处理请求所花费的总时间,包括在队列中花费的等待时间和实际处理时间。它有助于评估系统在处理用户请求方面的效率。示例: 完成一个数据库查询需要 250 毫秒,包括在队列中花费的 50 毫秒。

2. 吞吐量

吞吐量,简单来说,就是看一个系统“干活有多快”。它衡量的是在单位时间里,系统能完成多少个操作或处理多少个请求。你可以把它想象成一家快餐店的出餐速度:如果一小时内能做出300份汉堡,那它的“吞吐量”就是每小时300份。

在计算机系统中,吞吐量常用来评估服务器、数据库或API等组件的处理能力。比如,一个网站的后端API如果每秒能处理500个用户请求(比如登录、查询商品、提交订单等),我们就说它的吞吐量是 500 请求/秒。这个数字越高,说明系统越“能干”,能同时服务更多用户,不容易卡顿或崩溃。

关于如果更好地涉及API,可以参考范怿平和张力强两位老师的译作《精通API架构》——

需要注意的是,吞吐量高不代表每个请求都很快(那是“延迟”的事),而是强调“总量大”。就像高速公路——吞吐量高意味着一小时能通过上万辆车,但每辆车开得快不快,是另一回事。因此,在评估系统性能时,吞吐量和响应时间要结合起来看,才能全面了解系统的实际表现。

3. 错误率

错误率,说白了就是“系统出错的频率”。它指的是在所有用户发起的请求中,有多少比例没能成功完成——比如请求超时、服务器报错、数据没返回等等。这个数字越低,说明系统越稳定、越可靠。

举个例子:假设你的App一天内收到了10,000次用户点击“提交订单”的请求,其中有100次因为各种原因失败了(比如网络中断、服务崩溃、数据库连不上等),那么错误率就是:

100 ÷ 10,000 = 0.01,也就是 1%。

听起来1%好像不多?但在高流量场景下,这意味着每100个用户里就有1个人会遇到问题——可能付不了款、登不上账号,甚至丢失数据。对于一个追求用户体验和业务稳定的系统来说,这已经不容忽视。

所以,工程师们通常会把错误率作为关键监控指标。错误率越低,用户越安心,系统也越值得信赖。理想情况下,核心服务的错误率应控制在0.1%甚至更低。毕竟,谁也不想在关键时刻被系统“掉链子”呢!

4. 平均故障间隔时间 (MTBF)

MTBF(Mean Time Between Failures,平均故障间隔时间)就像是给一台设备或系统算“健康寿命”的指标。它表示的是:从一次正常运行开始,到下一次发生故障为止,平均能坚持多长时间。这个数字越大,说明系统越稳定、越不容易出问题。

举个例子:如果一台服务器的 MTBF 是 30,000 小时,那意味着——在大量同类服务器长期运行的统计下,它们平均每工作 30,000 小时(大约相当于 3年半 不间断运行)才会出现一次故障。当然,这不代表每台服务器都刚好撑到第30,000小时才坏,有的可能提前出问题,有的可能用得更久,但整体来看,这是一个反映可靠性的“平均值”。

对企业和运维团队来说,MTBF 越高越好。它不仅关系到服务是否稳定(比如网站会不会突然打不开),还直接影响维护成本和用户体验。所以,高 MTBF 的设备通常被用于数据中心、金融系统、医疗设备等对稳定性要求极高的场景。

MTBF 越长,系统越“皮实”,越值得信赖。

5. 平均修复时间 (MTTR)

MTTR(Mean Time To Recovery,平均恢复时间)说的是:系统一旦“生病”或“宕机”,从出问题到完全恢复正常,平均要花多长时间。这个时间越短,说明团队的应急响应越快、修复流程越高效,用户受影响的时间也就越少。

举个例子:如果一个在线支付系统的 MTTR 是 2 小时,那就意味着——每次发生故障(比如交易失败、服务中断),工程师们平均能在 2 小时内定位问题、修复 bug 或切换备用系统,让服务重新跑起来。

别小看这 2 小时!在电商大促或金融交易场景中,每分钟都可能损失成千上万元。所以,企业会通过自动化告警、应急预案、冗余备份等手段,努力把 MTTR 压到最低——理想情况下甚至做到“秒级恢复”。

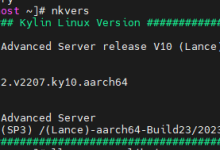

如果优化服务器的性能,可能会涉及到操作系统定制的话,可以参考孙杰老师的《Yocto项目实战教程》。

简单来说:MTTR 越低,系统“回血”越快,业务就越稳,用户也越安心。它衡量的不是会不会出错(因为再好的系统也可能出问题),而是“出错后能不能迅速站起来”。

6.网络带宽

网络带宽,你可以把它想象成水管的粗细——水管越粗,单位时间内流过的水量就越多;同样,网络带宽越大,单位时间内能传输的数据就越多。

具体来说,带宽指的是网络连接在理想情况下每秒最多能传输多少数据,通常用“Mbps”(兆比特每秒)或“Gbps”(千兆比特每秒)来表示。它是衡量网络“快不快”的关键指标之一,尤其在视频会议、在线游戏、大文件上传下载等场景中特别重要。

举个例子:如果你家的宽带是 100 Mbps,那就意味着理论上每秒最多能传输 100 兆比特(Mb) 的数据。注意这里说的是“比特”(bit),不是我们平时说的“字节”(Byte)——1 字节 = 8 比特,所以 100 Mbps 的带宽实际每秒最多下载约 12.5 MB(兆字节)的文件。

但要注意:带宽高 ≠ 网速一定快。就像再粗的水管,如果水压不够(比如服务器响应慢、网络拥堵),水流也会变小。所以,带宽只是网络性能的一个方面,它帮我们判断“这条网络通道有没有能力扛住大量数据”,也是排查卡顿、延迟等问题时首先要看的“瓶颈”之一。

带宽决定了网络的“上限”,是保障流畅上网、高效传输的基础。

7.请求速率

请求速率,简单来说,就是“系统每秒钟(或每分钟)被用户‘敲门’多少次”。它衡量的是单位时间内系统接收到的请求数量,比如用户点击按钮、打开网页、调用接口等行为都会产生一个请求。

举个例子:一个电商网站在“双11”促销高峰期,Web 服务器每分钟收到 300 个请求——这表示它的请求速率是 300 请求/分钟(也就是 5 请求/秒)。这个数字能帮工程师判断:现在系统是不是很忙?流量有没有突然暴涨?要不要提前扩容?

但要注意:请求速率 ≠ 吞吐量。它们看起来相似,其实关注点完全不同:

- 请求速率:说的是“来了多少活”,反映的是输入压力,也就是用户对系统的使用强度;

- 吞吐量:说的是“干成了多少活”,指的是系统成功处理并返回结果的请求数,反映的是实际产出能力。

举个生活化的比喻:

请求速率 = 快餐店门口排队的人数(每分钟来 20 人)

吞吐量 = 厨房每分钟实际做出并送出的汉堡数量(比如只能做 15 个)

如果请求速率是 20 人/分钟,但吞吐量只有 15 单/分钟,那剩下的 5 人就得等——可能造成排队变长、响应变慢,甚至有人等不及直接离开(请求超时或失败)。

如果对系统稳定性工程有兴趣的话,可以参考张观石老师的《SRE原理与实践》。

所以,监控请求速率能帮你预判问题(比如流量激增),而观察吞吐量则能告诉你系统是否扛得住。两者结合,才能全面了解系统的真实负载和性能瓶颈。

8. 并发连接

并发连接数,简单来说,就是“在某一瞬间,有多少个用户或程序正同时连着你的系统在干活”。你可以把它想象成一家银行的柜台——每个正在办理业务的客户就相当于一个“并发连接”。如果银行只有5个柜台,但突然来了100个人要同时办业务,那大多数人就得排队等着。

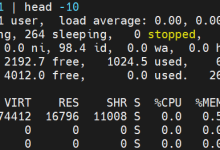

在计算机系统里,比如一个数据库服务器、Web服务或API接口,并发连接数指的是当前正在与它保持通信、尚未断开的活跃连接数量。这些连接可能正在查询数据、上传文件、加载网页……每一个都占用了系统的一份资源(如内存、CPU、网络)。

举个例子:如果说一个数据库服务器“能处理 5,000 个并发连接而不降低性能”,意思就是——哪怕同一时间有 5,000 个应用程序(比如网站后台、手机App、报表系统等)都在向它要数据,它依然能稳稳地响应,不会变慢、卡顿或拒绝服务。

这个指标非常重要,因为它直接反映了系统的承载能力和稳定性。如果实际并发连接数超过了系统能承受的上限,新来的请求可能会被拒绝,或者整体响应速度急剧下降,甚至导致服务崩溃。

所以,工程师在设计和部署系统时,会特别关注并发连接能力,并通过负载均衡、连接池优化、资源扩容等方式,确保系统在高并发场景下依然“扛得住、稳得住”。

9. 缓存命中率

缓存命中率是导致缓存命中的缓存访问的百分比,你可以把它理解成“系统在‘速记本’里找到答案的成功率”。

缓存命中率就是指:在所有查询中,有多少次能直接从这个“速记本”(缓存)里找到答案。比如,10 次请求中有 9 次在缓存里找到了数据,那命中率就是 90%。

这个数字越高越好!因为:

- 命中了

→ 数据秒出,用户不等待;

- 没命中(叫“缓存未命中”)

→ 系统得去慢速的原始地方找数据,拖慢响应,还增加服务器负担。

所以,高缓存命中率(比如 90% 以上)意味着系统运行更高效、用户体验更流畅。工程师们会通过优化缓存策略、合理设置缓存时间等方式,尽量让常用数据“常驻”在缓存里,就像把最常用的工具放在手边,而不是每次都要跑仓库去拿。

10. 服务水平协议 (SLA)

SLA(服务等级协议)是指系统满足其预定义的性能和可用性目标的时间百分比,简单来说,就是“系统兑现承诺的靠谱程度”。它衡量的是:在一段时间内,系统有多少比例的时间达到了事先约定好的性能和可用性标准——比如网站能正常打开、响应够快、不宕机等。

你可以把它想象成一家快递公司承诺“99% 的包裹 24 小时内送达”。如果它真的做到了,那它的“SLA 遵从率”就是 99%,客户自然更信任它。

举个实际例子:某云服务商承诺 SLA 为 99.95%,意思是——在一年 365 天里,它的服务必须有 99.95% 的时间都正常运行并满足性能要求。换算下来,全年允许的宕机或不达标时间总共不超过 约 4.38 小时(365×24×0.05% ≈ 4.38 小时)。只要在这个范围内,就算履约成功。

SLA 遵从率越高,说明系统越稳定、越可靠,用户的业务就越不容易被打断,满意度自然也更高。对企业客户来说,SLA 不只是技术指标,更是商业信任的基石——很多合同甚至会写明:若未达标,云厂商要赔钱!

高 SLA 不是“锦上添花”,而是现代数字服务的“及格线”。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册