RustDesk自建服务器远程管理GPU集群运行IndexTTS任务

在AI内容生产逐渐走向工业化流程的今天,语音合成已不再是简单的“文字转声音”,而是影视配音、虚拟人驱动、有声书制作等高要求场景中的核心环节。B站开源的 IndexTTS 2.0 正是这一趋势下的技术先锋——它不仅能用5秒音频克隆音色,还能精准控制语速时长、分离音色与情感,甚至支持中文多音字标注,真正实现了专业级语音生成。

但再强大的模型也离不开算力支撑。IndexTTS这类大模型依赖高性能GPU集群进行训练和推理,而如何安全、高效地远程访问这些服务器,成了实际落地的关键瓶颈。SSH命令行操作难以应对图形化界面调试,公有云远程工具又存在数据泄露风险。于是,越来越多团队开始转向私有化部署的远程方案——RustDesk 凭借其开源、轻量、低延迟和完全可控的数据流路径,成为连接本地终端与远端AI算力节点的理想选择。

从零样本合成到毫秒级控制:IndexTTS的技术突破

传统TTS系统往往需要大量目标说话人的语音数据进行微调,而IndexTTS 2.0采用自回归零样本架构,仅凭一段5秒参考音频即可完成音色复现。这背后是一套精密的编码-解码机制:文本语义由编码器提取,参考音频通过预训练声学模型生成音色嵌入(Speaker Embedding),再经交叉注意力注入解码过程,逐帧合成梅尔频谱图,最终由神经声码器还原为高质量波形。

这套结构虽然带来略高的推理延迟,但在离线批量生成场景中优势明显——语音自然度显著优于非自回归模型,尤其在连读、语调转折等细节上表现更接近真人。官方评测显示,音色相似度可达85%以上,配合FP16量化与CUDA加速,在A100上可实现RTF < 1.0的实时率,满足大多数生产需求。

更令人惊喜的是它的毫秒级时长可控能力。以往要让语音严格对齐画面时间轴,只能靠后期变速处理,容易导致音质失真或节奏错乱。IndexTTS却能在生成阶段就精确控制输出长度。其核心是一个可学习的长度调节模块,结合CTC对齐思想与归一化策略,动态调整每步的时间步长,确保总帧数匹配目标时长。

用户可以通过duration_ratio参数设定语速比例(如1.1倍速压缩时间),也可以指定最大token数量进入“可控模式”。实测误差稳定在±3%以内,完全满足影视级音画同步标准。例如:

result = model.synthesize(

text="欢迎来到未来世界。",

ref_audio_path="voice_ref.wav",

duration_ratio=1.1,

mode="controlled"

)

这样的设计极大简化了后期流程,真正做到了“一次生成即可用”。

音色与情感解耦:一人千声的自由表达

如果说时长控制解决了“说得准”的问题,那么音色-情感解耦则让AI语音真正拥有了“表现力”。

传统方法中,音色和情绪是捆绑在一起的——你录了一段愤怒的声音,模型学到的就是“这个人的愤怒状态”。若想换种情绪,就得重新录制。IndexTTS通过引入梯度反转层(Gradient Reversal Layer, GRL)打破了这种绑定:在训练过程中,强制音色编码器忽略情感特征,同时情感编码器屏蔽身份信息,从而实现两个维度的独立建模。

这意味着你可以轻松组合出“A的声音 + B的情绪”效果。比如让温柔的女声说出愤怒的台词,或用沉稳男声演绎悲伤独白。API层面也极为直观:

result = model.synthesize(

text="你竟然敢这样对我?",

speaker_ref="alice.wav", # 使用Alice的音色

emotion_ref="bob_angry.wav", # 借用Bob的愤怒语气

mode="dual-ref"

)

此外,系统还内置了8种基础情感向量(喜悦、愤怒、悲伤、惊讶等),支持强度插值;更进一步,借助基于Qwen-3微调的情感文本编码器(T2E模块),还能直接理解“温柔地说”、“坚定地宣布”这类自然语言指令,大幅降低使用门槛。

这种灵活性对于角色扮演、动画配音、戏剧化叙事等复杂场景极具价值,真正实现了“一人千声,千面表达”。

中文友好设计:拼音标注与多语言混合输入

面对中文特有的多音字难题(如“行(xíng/háng)”、“乐(yuè/lè)”),IndexTTS提供了独特的解决方案——允许在文本中直接插入拼音注释。前端解析器会将带括号的拼音映射为准确音素序列,绕过默认分词与注音模型的不确定性。

例如:

text_with_pinyin = "我觉(jué)得这件事很重(zhòng)要,不能马虎。"

这样就能明确指示“觉”读作第四声,“重”取“重要”之意,避免因上下文误判导致发音错误。测试数据显示,未加拼音时自动注音准确率为92%,加入后接近100%,极大提升了专业配音的可靠性。

不仅如此,IndexTTS还支持中、英、日、韩等多种语言混合输入,并采用共享音素空间设计,使得同一音色在不同语言间切换时仍能保持声纹一致性。无论是双语广告、跨国虚拟主播,还是带有外语词汇的科技解说,都能流畅应对。

远程管理之痛:为什么我们需要自建RustDesk?

当IndexTTS跑在GPU集群上时,问题来了:怎么高效管理这些分散的计算节点?

很多团队最初尝试SSH + 命令行脚本的方式,但对于需要频繁调试Web UI、查看显卡负载、拖拽上传音频文件的日常操作来说,体验极差。VNC或TeamViewer类工具虽能提供图形界面,但普遍存在延迟高、卡顿严重的问题,尤其在高清分辨率下几乎无法正常使用。

更重要的是数据安全。IndexTTS常用于影视配音、企业宣传等敏感项目,原始音频素材一旦经过第三方服务器中转,就有泄露风险。商业远程工具通常会在云端留存连接日志、屏幕快照甚至剪贴板内容,这对注重隐私的企业而言是不可接受的。

于是,RustDesk进入了视野。作为一款完全开源、支持私有化部署的远程桌面工具,它最大的优势就是“所有流量都在自己掌控之中”。你可以把它的中继服务器部署在内网跳板机或私有VPC中,所有通信走TLS加密隧道,数据不出局域网,彻底杜绝外泄可能。

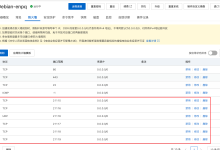

其架构由三部分组成:

– Client:安装在每台GPU服务器上的客户端,负责屏幕捕获与输入转发;

– Hub Server(hbbs/hbbr):处理ID注册、信令调度与数据中转;

– API接口:提供RESTful接口用于批量设备管理与自动化运维。

连接流程简洁高效:客户端启动后向Hub注册唯一ID,用户在本地RustDesk输入该ID发起连接,系统优先尝试P2P直连,失败则通过中继服务器转发。整个过程使用AES-256加密,延迟可压至100ms以内(1080p下),流畅运行PyTorch训练面板、Gradio界面毫无压力。

部署方式也非常灵活,推荐使用Docker Compose一键启停核心服务:

version: '3'

services:

hbbs:

image: rustdesk/rustdesk-server

command: –hbbs

network_mode: host

volumes:

– ./data:/root

restart: unless-stopped

hbbr:

image: rustdesk/rustdesk-server

command: –hbbr

network_mode: host

volumes:

– ./data:/root

restart: unless-stopped

启动后只需在各GPU节点安装客户端并填写自建服务器地址,即可统一接入管理网络。相比按设备收费的AnyDesk或受限于公网IP的TeamViewer,RustDesk不仅成本更低,而且更适合长期高频使用的AI实验室环境。

构建你的远程智能语音生产线

设想这样一个工作流:

你在办公室的MacBook上打开RustDesk,输入编号为gpu-04的目标机器ID,几秒钟后便接入一台位于数据中心的A100服务器桌面。浏览器里开着IndexTTS的Gradio界面,GPU占用率显示当前空闲。你上传一段客户提供的参考音频,输入待合成文本,勾选“可控模式”,设置duration_ratio=1.05以略微加快语速适应视频节奏,再选择“双参考控制”,分别指定音色来源和情绪模板。

点击“生成”,后台立即调用CUDA加速推理,十几秒后高质量音频出炉。你试听确认无误,导出保存,整个过程如同操作本地电脑一般顺畅。

如果需要批量处理,也不必重复点击。你可以直接打开终端运行脚本:

for role in alice bob eve; do

python batch_tts.py \\

–text_script "${role}.txt" \\

–ref_audio "refs/${role}.wav" \\

–output_dir "outputs/${role}" \\

–duration_ratio 1.0 \\

–emotion "excited"

done

这一切都建立在一个安全、集中、可视化的远程管理体系之上。不再需要记住一堆IP地址和密码,所有GPU节点通过统一ID体系暴露给授权人员;敏感音频数据全程停留在内网,无需担心外泄;图形界面操作流畅,调试效率大幅提升。

实践建议:让系统更稳定、更高效

当然,理想架构也需要细致打磨才能发挥最大效能。以下是我们在实际部署中总结的一些关键经验:

🔐 安全加固不容忽视

- 将RustDesk Hub Server置于防火墙后,仅开放必要端口(TCP 21115/21116,UDP 21117);

- 启用API密钥认证,防止非法设备注册;

- 定期轮换加密密钥,关闭不必要的服务组件。

🖥️ 性能优化要点

- 在RustDesk客户端启用“性能优先”模式,关闭视觉特效;

- IndexTTS推理时使用FP16半精度,提升吞吐量;

- 合理设置Batch Size,避免显存溢出(OOM),可通过nvidia-smi实时监控;

- 对于离线批量任务,建议分配专用GPU组,与交互式调试节点隔离。

💾 容灾与可维护性

- 定期备份模型缓存、用户上传的音频素材及配置文件;

- 配置RustDesk Server主备高可用方案,防止单点故障;

- 开启操作日志记录,便于审计追踪与问题回溯。

这种高度集成的设计思路,正引领着智能音频设备向更可靠、更高效的方向演进。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册