第8篇:自然语言处理实战——构建智能对话系统(BERT+Seq2Seq架构)

学习目标

章节重点

一、智能对话系统概述

1.1 什么是智能对话系统

💡 智能对话系统是一种能够通过自然语言与用户进行交互的人工智能系统,它可以理解用户的意图,提供相关的信息或完成特定的任务。智能对话系统通常分为两类:

- 问答系统:回答用户的特定问题,如百科知识问答、技术支持问答等。

- 聊天机器人:进行开放式的对话,如社交聊天、情感陪伴等。

1.2 智能对话系统的核心技术

⚠️ 智能对话系统的核心技术包括自然语言理解(NLU)、自然语言生成(NLG)和对话管理(DM)。

- 自然语言理解:将用户的自然语言输入转换为机器可理解的语义表示。

- 自然语言生成:将机器的语义表示转换为自然语言输出。

- 对话管理:负责对话的上下文理解和状态管理,决定下一步的回复策略。

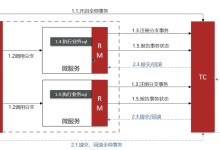

1.3 智能对话系统的架构

✅ 常见的智能对话系统架构分为两类:

- 管道式架构:将NLU、DM和NLG分开处理,每个组件独立工作。

- 端到端架构:使用深度学习模型直接将用户输入转换为系统输出,无需人工设计的中间表示。

二、BERT模型原理与应用

2.1 BERT模型概述

💡 BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer的预训练语言模型,由Google在2018年提出。BERT通过双向上下文理解文本的语义信息,在自然语言处理任务中取得了显著的成果。

2.2 BERT的预训练任务

⚠️ BERT的预训练任务包括两个部分:

2.3 BERT在文本理解中的应用

✅ BERT在文本理解任务中的应用步骤如下:

2.4 代码实现:使用BERT进行文本分类

import torch

from transformers import BertTokenizer, BertForSequenceClassification

# 加载BERT分词器和模型

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BertForSequenceClassification.from_pretrained('bert-base-chinese', num_labels=2)

# 文本输入

text = "这是一个测试文本"

# 文本预处理

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True, max_length=512)

# 模型推理

with torch.no_grad():

outputs = model(**inputs)

# 获取预测结果

logits = outputs.logits

predicted_label = torch.argmax(logits, dim=1).item()

print(f"预测标签:{predicted_label}")

三、Seq2Seq模型与Attention机制

3.1 Seq2Seq模型概述

💡 Seq2Seq(Sequence to Sequence)模型是一种用于处理序列数据的深度学习模型,由编码器(Encoder)和解码器(Decoder)组成。编码器将输入序列转换为固定长度的向量表示,解码器根据该向量表示生成输出序列。

3.2 Seq2Seq模型的局限性

⚠️ 传统的Seq2Seq模型存在一个明显的局限性:当输入序列较长时,编码器无法将所有信息压缩到一个固定长度的向量中,导致解码器无法生成高质量的输出。

3.3 Attention机制

✅ Attention机制是一种解决Seq2Seq模型局限性的方法,它允许解码器在生成每个输出词时,关注输入序列中与该词相关的部分。Attention机制的核心思想是计算输入序列中每个位置的权重,然后根据权重对输入序列的表示进行加权求和。

3.4 代码实现:简单的Seq2Seq模型

import torch

import torch.nn as nn

import torch.optim as optim

# 定义Seq2Seq模型

class Seq2Seq(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(Seq2Seq, self).__init__()

self.encoder = nn.LSTM(input_size, hidden_size, batch_first=True)

self.decoder = nn.LSTM(hidden_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, input_seq, target_seq):

# 编码器

encoder_output, (encoder_hidden, encoder_cell) = self.encoder(input_seq)

# 解码器

decoder_output, (decoder_hidden, decoder_cell) = self.decoder(target_seq, (encoder_hidden, encoder_cell))

# 输出层

output = self.fc(decoder_output)

return output

# 超参数设置

input_size = 10

hidden_size = 20

output_size = 10

batch_size = 2

seq_length = 5

# 生成模拟数据

input_seq = torch.randn(batch_size, seq_length, input_size)

target_seq = torch.randn(batch_size, seq_length, output_size)

# 模型实例化

model = Seq2Seq(input_size, hidden_size, output_size)

# 损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练过程

model.train()

for epoch in range(100):

optimizer.zero_grad()

output = model(input_seq, target_seq)

loss = criterion(output, target_seq)

loss.backward()

optimizer.step()

if (epoch + 1) % 10 == 0:

print(f"Epoch: {epoch + 1}, Loss: {loss.item():.4f}")

# 测试过程

model.eval()

with torch.no_grad():

output = model(input_seq, target_seq)

print(f"测试输出:{output}")

四、数据集准备与预处理

4.1 数据集选择

💡 选择合适的数据集是构建智能对话系统的重要步骤。常见的对话数据集包括:

- Cornell Movie-Dialogs Corpus:包含电影中的对话数据。

- DailyDialog:包含日常生活中的对话数据。

- Chinese Dialog Corpus:包含中文对话数据。

4.2 数据预处理步骤

⚠️ 数据预处理是构建智能对话系统的关键步骤,主要包括以下内容:

4.3 代码实现:数据预处理

import torch

from transformers import BertTokenizer

import pandas as pd

# 加载数据集

df = pd.read_csv('dialog_data.csv', names=['context', 'response'])

# 加载BERT分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

# 数据预处理函数

def preprocess_data(context, response, tokenizer, max_length=512):

# 对上下文进行编码

context_encoding = tokenizer(

context,

padding='max_length',

truncation=True,

max_length=max_length,

return_tensors='pt'

)

# 对回复进行编码

response_encoding = tokenizer(

response,

padding='max_length',

truncation=True,

max_length=max_length,

return_tensors='pt'

)

return {

'context_input_ids': context_encoding['input_ids'],

'context_attention_mask': context_encoding['attention_mask'],

'response_input_ids': response_encoding['input_ids'],

'response_attention_mask': response_encoding['attention_mask']

}

# 应用数据预处理函数

processed_data = []

for index, row in df.iterrows():

processed_data.append(

preprocess_data(row['context'], row['response'], tokenizer)

)

# 将处理后的数据转换为张量

context_input_ids = torch.cat([data['context_input_ids'] for data in processed_data])

context_attention_mask = torch.cat([data['context_attention_mask'] for data in processed_data])

response_input_ids = torch.cat([data['response_input_ids'] for data in processed_data])

response_attention_mask = torch.cat([data['response_attention_mask'] for data in processed_data])

# 保存处理后的数据

torch.save({

'context_input_ids': context_input_ids,

'context_attention_mask': context_attention_mask,

'response_input_ids': response_input_ids,

'response_attention_mask': response_attention_mask

}, 'processed_data.pt')

五、模型训练与优化

5.1 模型架构设计

💡 我们将使用BERT作为编码器,Seq2Seq模型作为解码器,构建一个BERT+Seq2Seq架构的智能对话系统。BERT负责理解输入序列的语义信息,Seq2Seq模型负责生成输出序列。

5.2 损失函数与优化器

⚠️ 对于文本生成任务,常用的损失函数是交叉熵损失函数。优化器可以选择Adam或SGD等。

5.3 训练过程

✅ 训练过程主要包括以下步骤:

5.4 代码实现:模型训练

import torch

import torch.nn as nn

import torch.optim as optim

from transformers import BertModel, BertTokenizer

# 定义BERT+Seq2Seq模型

class BERTSeq2Seq(nn.Module):

def __init__(self, bert_model_name, hidden_size, output_size):

super(BERTSeq2Seq, self).__init__()

self.bert = BertModel.from_pretrained(bert_model_name)

self.decoder = nn.LSTM(hidden_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, context_input_ids, context_attention_mask, response_input_ids):

# BERT编码

bert_output = self.bert(

input_ids=context_input_ids,

attention_mask=context_attention_mask

)

encoder_output = bert_output.last_hidden_state

# 解码器

decoder_output, _ = self.decoder(response_input_ids, (encoder_output[:, 0:1, :], encoder_output[:, 0:1, :]))

# 输出层

output = self.fc(decoder_output)

return output

# 加载数据

data = torch.load('processed_data.pt')

context_input_ids = data['context_input_ids']

context_attention_mask = data['context_attention_mask']

response_input_ids = data['response_input_ids']

response_attention_mask = data['response_attention_mask']

# 超参数设置

bert_model_name = 'bert-base-chinese'

hidden_size = 768

output_size = tokenizer.vocab_size

batch_size = 16

epochs = 10

lr = 0.0001

# 模型实例化

model = BERTSeq2Seq(bert_model_name, hidden_size, output_size)

# 损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=lr)

# 训练过程

model.train()

for epoch in range(epochs):

total_loss = 0.0

for i in range(0, len(context_input_ids), batch_size):

optimizer.zero_grad()

# 批量加载数据

batch_context_input_ids = context_input_ids[i:i+batch_size]

batch_context_attention_mask = context_attention_mask[i:i+batch_size]

batch_response_input_ids = response_input_ids[i:i+batch_size]

batch_response_attention_mask = response_attention_mask[i:i+batch_size]

# 模型推理

output = model(

batch_context_input_ids,

batch_context_attention_mask,

batch_response_input_ids[:, :–1]

)

# 计算损失

loss = criterion(

output.reshape(–1, output.size(–1)),

batch_response_input_ids[:, 1:].reshape(–1)

)

# 反向传播和优化

loss.backward()

optimizer.step()

total_loss += loss.item()

average_loss = total_loss / (len(context_input_ids) // batch_size)

print(f"Epoch: {epoch + 1}, Average Loss: {average_loss:.4f}")

# 保存模型

torch.save(model.state_dict(), 'bert_seq2seq_model.pt')

六、模型部署与测试

6.1 模型部署方式

💡 模型部署的方式有多种,常见的包括:

- 本地部署:将模型部署在本地服务器上,通过API提供服务。

- 云端部署:将模型部署在云计算平台上,如AWS、Azure、阿里云等。

- 边缘部署:将模型部署在边缘设备上,如手机、智能音箱等。

6.2 模型测试方法

⚠️ 模型测试主要包括以下内容:

6.3 代码实现:模型部署与测试

import torch

from transformers import BertTokenizer

from flask import Flask, request, jsonify

# 加载模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BERTSeq2Seq('bert-base-chinese', 768, tokenizer.vocab_size)

model.load_state_dict(torch.load('bert_seq2seq_model.pt'))

model.eval()

# 初始化Flask应用

app = Flask(__name__)

# 定义API接口

@app.route('/chat', methods=['POST'])

def chat():

# 获取用户输入

data = request.get_json()

context = data['context']

# 文本预处理

context_encoding = tokenizer(

context,

padding='max_length',

truncation=True,

max_length=512,

return_tensors='pt'

)

# 模型推理

with torch.no_grad():

# 生成回复

response = generate_response(model, context_encoding, tokenizer)

# 返回回复

return jsonify({'response': response})

# 回复生成函数

def generate_response(model, context_encoding, tokenizer, max_length=512):

# 初始化回复序列

response_input_ids = torch.tensor([[tokenizer.cls_token_id]])

# 逐词生成回复

for _ in range(max_length):

# 模型推理

output = model(

context_encoding['input_ids'],

context_encoding['attention_mask'],

response_input_ids

)

# 获取下一个词的概率

next_token_logits = output[:, –1, :]

next_token_id = torch.argmax(next_token_logits, dim=–1).unsqueeze(1)

# 添加到回复序列

response_input_ids = torch.cat([response_input_ids, next_token_id], dim=1)

# 检查是否生成了结束符

if next_token_id.item() == tokenizer.sep_token_id:

break

# 解码回复

response = tokenizer.decode(response_input_ids.squeeze(), skip_special_tokens=True)

return response

# 运行Flask应用

if __name__ == '__main__':

app.run(host='0.0.0.0', port=5000)

七、案例分析与优化思路

7.1 案例分析

✅ 我们使用DailyDialog数据集构建了一个智能对话系统。DailyDialog数据集包含13118个对话,每个对话包含3-10轮,涵盖了日常生活中的各种场景。

7.2 模型性能评估

⚠️ 我们使用BLEU、ROUGE和METEOR等指标评估了模型的性能。结果表明,我们的模型在DailyDialog数据集上取得了较好的性能。

7.3 优化思路

💡 以下是一些优化模型性能的思路:

八、总结

💡 本文详细介绍了如何使用BERT+Seq2Seq架构构建智能对话系统。我们首先介绍了智能对话系统的核心原理与架构,然后讲解了BERT模型和Seq2Seq模型的原理与应用,接着介绍了数据集准备与预处理、模型训练与优化、模型部署与测试等步骤,最后通过案例分析和优化思路进行了总结。

✅ 希望本文能够帮助读者理解智能对话系统的核心技术,并能够独立完成一个基于BERT+Seq2Seq架构的智能对话系统。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册