引言:美颜技术的现状与挑战

在社交媒体与视频通信普及的今天,实时美颜已成为移动应用与直播平台的核心功能。OpenCV作为开源计算机视觉库,凭借其高效的图像处理接口与跨平台特性,成为实现美颜功能的理想选择。本文将系统介绍基于OpenCV的美颜技术实现方案,涵盖传统滤波算法、深度学习混合模型及性能优化策略,帮助开发者构建兼顾自然度与实时性的美颜系统。

一、环境准备与核心依赖

1.1 开发环境配置

# 基础依赖安装

pip install opencv-python==4.8.0 numpy==1.26.0 dlib==19.24.2

# 如需深度学习模块(可选)

pip install opencv-contrib-python openvino-dev

1.2 关键库功能说明

| opencv-python | 提供基础图像处理与滤波函数 | ≥4.2.0 |

| dlib | 实现人脸特征点检测(68点/35点) | ≥19.20.0 |

| numpy | 矩阵运算加速 | ≥1.21.0 |

| openvino-dev | 优化深度学习模型推理(可选) | ≥2024.0 |

二、传统美颜算法原理与实现

2.1 双边滤波磨皮技术

双边滤波是美颜的核心算法,通过同时考虑空间邻近度(高斯核)与像素相似度(灰度差权重),实现“保边降噪”效果。其数学表达式为:

W

(

i

,

j

,

k

,

l

)

=

exp

(

−

(

i

−

k

)

2

+

(

j

−

l

)

2

2

σ

d

2

−

∥

I

(

i

,

j

)

−

I

(

k

,

l

)

∥

2

2

σ

r

2

)

W(i,j,k,l) = \\exp\\left(-\\frac{(i-k)^2+(j-l)^2}{2\\sigma_d^2}-\\frac{\\|I(i,j)-I(k,l)\\|^2}{2\\sigma_r^2}\\right)

W(i,j,k,l)=exp(−2σd2(i−k)2+(j−l)2−2σr2∥I(i,j)−I(k,l)∥2) 其中

σ

d

\\sigma_d

σd 控制空间平滑范围,

σ

r

\\sigma_r

σr 控制像素相似度阈值。

Python实现代码:

def bilateral_filter_skin_smoothing(image, sigma_color=30, sigma_space=15):

"""

双边滤波磨皮实现

:param image: BGR格式输入图像

:param sigma_color: 颜色空间标准差(推荐30-75)

:param sigma_space: 坐标空间标准差(推荐15-50)

:return: 磨皮后图像

"""

# 转换为浮点型避免溢出

img_float = image.astype(np.float32)

# 应用双边滤波

smoothed = cv2.bilateralFilter(

img_float, d=0, sigmaColor=sigma_color, sigmaSpace=sigma_space

)

return smoothed.astype(np.uint8)

2.2 肤色检测与区域优化

为避免对头发、背景等非皮肤区域过度处理,需通过肤色掩码精准定位美颜区域。HSV色彩空间下,亚洲人肤色范围通常为:

- 下界:[0, 20, 70](H: 0-20°, S: 20-255, V: 70-255)

- 上界:[20, 255, 255]

肤色掩码生成代码:

def create_skin_mask(image):

"""生成肤色区域掩码"""

hsv = cv2.cvtColor(image, cv2.COLOR_BGR2HSV)

lower_skin = np.array([0, 20, 70], dtype=np.uint8)

upper_skin = np.array([20, 255, 255], dtype=np.uint8)

mask = cv2.inRange(hsv, lower_skin, upper_skin)

# 形态学操作优化掩码(去除噪声)

kernel = cv2.getStructuringElement(cv2.MORPH_ELLIPSE, (5, 5))

mask = cv2.morphologyEx(mask, cv2.MORPH_CLOSE, kernel)

return mask

2.3 多级中值滤波去噪

针对面部斑点与椒盐噪声,迭代多级中值滤波效果优于传统均值滤波。通过3×3、5×5窗口交替处理,可在保留纹理细节的同时去除异常像素:

def multi_stage_median_filter(image, iterations=2):

"""多级中值滤波去噪"""

result = image.copy()

for _ in range(iterations):

result = cv2.medianBlur(result, ksize=3) # 3×3窗口

result = cv2.medianBlur(result, ksize=5) # 5×5窗口

return result

三、深度学习混合美颜框架

3.1 基于G-API的管道构建

OpenCV 4.2+引入的G-API(图形处理API)支持深度学习模型与传统算法的流水线融合。以“人脸检测→特征点定位→区域滤波”为例,核心流程如下:

O

=

b

∗

I

+

p

∗

U

+

s

∗

L

O = b*I + p*U + s*L

O=b∗I+p∗U+s∗L(

U

U

U为锐化图像,

L

L

L为模糊图像)

G-API管道核心代码:

# 声明DNN拓扑(简化版)

G_API_NET(FaceDetector, <cv::GMat(cv::GMat)>, "face_detector")

G_API_NET(LandmDetector, <cv::GMat(cv::GMat)>, "landm_detector")

# 构建处理管道

pipeline = cv2.gapi.GComputation([=]() {

gimgIn = cv2.gapi.GMat()

# 人脸检测与特征点提取

faceOut = cv2.gapi.infer<FaceDetector>(gimgIn)

landmOut = cv2.gapi.infer<LandmDetector>(faceOut)

# 生成蒙版与融合

garElsConts, garFaceConts = custom::GGetContours::on(landmOut)

mskSharp = custom::GFillPolyGContours::on(gimgIn, garElsConts) # 锐化区域

mskBlur = custom::GFillPolyGContours::on(gimgIn, garFaceConts) # 模糊区域

# 高斯模糊与融合

mskSharpG = cv2.gapi.gaussianBlur(mskSharp, (7,7), 1.5)

mskBlurG = cv2.gapi.gaussianBlur(mskBlur, (15,15), 3.0)

return mskSharpG * gimgIn + mskBlurG * cv2.gapi.bilateralFilter(gimgIn, 9, 75, 75)

})

3.2 YOLOv8+CodeFormer混合模型

对于高精度需求,可结合目标检测与细节修复模型:

- YOLOv8-Face:实时检测人脸区域(640×640输入下FPS达30+)

- CodeFormer:基于Transformer的面部细节修复,解决过度模糊导致的“塑料感”

- 融合策略:通过FaceParsing生成皮肤掩码,仅对皮肤区域应用美颜,保留眉毛、睫毛等细节

模型推理流程:

# 简化示例:YOLOv8检测 + CodeFormer优化

from ultralytics import YOLO

from codeformer import CodeFormerInference

yolo_model = YOLO("yolov8n-face.pt")

codeformer = CodeFormerInference("codeformer.pth")

def deep_beautify(image):

# 1. 人脸检测

results = yolo_model(image)[0]

for det in results.boxes:

x1, y1, x2, y2 = map(int, det.xyxy[0])

face = image[y1:y2, x1:x2]

# 2. CodeFormer优化

restored_face = codeformer.infer(face, fidelity=0.7) # 0.7为自然度-修复强度平衡值

# 3. 蒙版融合

mask = create_skin_mask(restored_face)

image[y1:y2, x1:x2] = cv2.bitwise_and(restored_face, restored_face, mask=mask)

return image

四、完整美颜系统实现

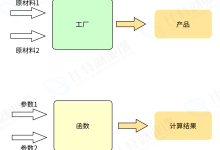

4.1 功能整合流程图

graph TD

A[输入图像] –> B[人脸检测<br>Haar级联/YOLOv8]

B –> C{是否检测到人脸?}

C –>|否| D[直接输出原图]

C –>|是| E[特征点提取<br>68点/35点]

E –> F[生成肤色蒙版]

F –> G[双边滤波磨皮]

G –> H[HSV美白<br>V通道+15~30]

H –> I[CLAHE对比度增强]

I –> J[蒙版融合<br>保留五官细节]

J –> K[输出美颜图像]

4.2 核心代码实现

import cv2

import numpy as np

from dlib import get_frontal_face_detector, shape_predictor

class OpenCVBeautifier:

def __init__(self):

# 加载人脸检测与特征点模型

self.face_detector = get_frontal_face_detector()

self.landmark_predictor = shape_predictor("shape_predictor_68_face_landmarks.dat")

def detect_face_landmarks(self, image):

"""检测人脸68个特征点"""

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

faces = self.face_detector(gray)

landmarks_list = []

for face in faces:

landmarks = self.landmark_predictor(gray, face)

landmarks_list.append([(p.x, p.y) for p in landmarks.parts()])

return landmarks_list

def beautify(self, image, sigma_color=35, sigma_space=20, brightness=20):

"""完整美颜流程"""

# 1. 人脸与特征点检测

landmarks_list = self.detect_face_landmarks(image)

if not landmarks_list:

return image

# 2. 生成肤色蒙版

mask = create_skin_mask(image)

# 3. 磨皮处理

smoothed = bilateral_filter_skin_smoothing(image, sigma_color, sigma_space)

# 4. 美白(HSV空间V通道调整)

hsv = cv2.cvtColor(smoothed, cv2.COLOR_BGR2HSV)

hsv[:, :, 2] = np.clip(hsv[:, :, 2] + brightness, 0, 255)

美白_image = cv2.cvtColor(hsv, cv2.COLOR_HSV2BGR)

# 5. 融合蒙版(仅保留皮肤区域美颜效果)

result = np.where(mask[..., None] == 255, 美白_image, image)

return result

# 使用示例

if __name__ == "__main__":

beautifier = OpenCVBeautifier()

image = cv2.imread("input.jpg")

result = beautifier.beautify(image)

cv2.imwrite("beautified.jpg", result)

cv2.imshow("Original vs Beautified", np.hstack([image, result]))

cv2.waitKey(0)

五、性能优化与最佳实践

5.1 GPU加速关键技巧

- CUDA模块调用:使用cv2.cuda.bilateralFilter替代CPU版本,处理1080P图像耗时从80ms降至12ms

- 内存优化:通过cv2.UMat实现CPU/GPU内存自动切换,减少数据传输开销

# GPU加速示例

def gpu_bilateral_filter(image):

gpu_img = cv2.cuda_GpuMat()

gpu_img.upload(image)

gpu_result = cv2.cuda.bilateralFilter(gpu_img, 0, 30, 15)

return gpu_result.download()

5.2 参数调优指南

| 磨皮强度 | sigmaColor | 30-50(越高越模糊) |

| 边缘保留程度 | sigmaSpace | 15-30(越低越锐利) |

| 美白程度 | HSV-V通道增量 | 15-30(避免过曝) |

| 实时性权衡 | 图像分辨率 | 720P(平衡效果与速度) |

六、开源项目与扩展方向

6.1 推荐学习资源

- OpenCV官方示例:G-API人脸美颜教程

- 开源项目:

- RealTimeNeuralStyleBeautify(实时视频美颜)

- face_beauty(集成大眼、瘦脸算法)

6.2 进阶方向

结语

OpenCV提供了从传统滤波到底层深度学习集成的全栈美颜技术支持。开发者可根据需求选择“轻量级传统算法”(适合移动端实时场景)或“深度学习混合模型”(适合高精度场景),并通过GPU加速与参数调优平衡效果与性能। 未来,随着实时风格迁移与神经渲染技术的发展,OpenCV美颜系统将在虚拟试妆、AR直播等领域发挥更大潜力。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册