在训练大模型时,OOV(Out-of-Vocabulary,未登录词)错误指的是模型遇到训练阶段未见过的词汇,导致无法正确编码或理解的问题。OOV 的根源通常是词汇表覆盖不足(如训练数据未包含该词)或分词方式不合理。以下是具体解决方法及代码示例:

一、核心解决思路

1. 采用子词(Subword)分词(最主流)

子词分词将词汇分解为更小的语义单元(如 “unhappiness”→“un”+“happiness”→“happy”+“ness”),即使是 OOV 词,也能被拆分为训练过的子词,从而被模型理解。常见算法包括:

- BPE(Byte Pair Encoding,字节对编码):GPT、RoBERTa 等采用。

- WordPiece:BERT、DistilBERT 等采用。

- Unigram:T5 等采用。

2. 扩展词汇表

通过更大规模、更多样化的语料库构建词汇表,覆盖更多潜在词汇(如专业术语、新词)。但需平衡词汇表大小(过大会增加模型参数和计算成本)。

3. 字符级(Character-level)处理

将文本拆分为字符(如 “apple”→“a”+“p”+“p”+“l”+“e”),理论上无 OOV(所有字符均可覆盖),但会显著增加序列长度,降低模型效率(适合短文本或低资源语言)。

4. 结合 UNK 标记与后处理

在词汇表中加入<unk>标记,将 OOV 词映射为<unk>,同时通过外部工具(如拼写纠错、实体链接)补充 OOV 词信息(但会丢失 OOV 本身的语义,效果有限)。

二、代码示例:子词分词处理 OOV

以BPE 算法为例,使用 Hugging Face 的tokenizers库实现子词分词,展示如何处理 OOV 词。

步骤 1:安装依赖

pip install tokenizers

步骤 2:训练 BPE 分词器

用样本语料训练 BPE 分词器,使其学习子词拆分规则:

from tokenizers import Tokenizer

from tokenizers.models import BPE

from tokenizers.trainers import BpeTrainer

from tokenizers.pre_tokenizers import Whitespace

# 1. 初始化分词器(BPE模型)

tokenizer = Tokenizer(BPE(unk_token="<unk>")) # 定义未知词标记

tokenizer.pre_tokenizer = Whitespace() # 先按空格拆分预分词

# 2. 配置训练器(设置词汇表大小、特殊标记)

trainer = BpeTrainer(

vocab_size=1000, # 词汇表大小(子词总数)

special_tokens=["<pad>", "<unk>", "<s>", "</s>"], # 特殊标记

min_frequency=2 # 子词最小出现频率(过滤极低频子词)

)

# 3. 训练数据(假设我们有一个简单的语料库文本文件)

# 样本语料内容(模拟日常文本,不含"fluffernutter"这个OOV词):

# "I like apples and bananas. She likes eating happy cakes. Unhappy days are bad."

train_files = ["train_corpus.txt"]

# 4. 训练分词器

tokenizer.train(train_files, trainer)

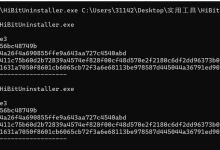

步骤 3:测试 OOV 词处理

用训练好的分词器处理未见过的 OOV 词(如 “fluffernutter”,一种三明治名称):

# 测试OOV词"fluffernutter"

oov_word = "fluffernutter"

encoded = tokenizer.encode(oov_word)

print(f"原始词:{oov_word}")

print(f"子词拆分:{encoded.tokens}")

print(f"对应的ID:{encoded.ids}")

输出结果(示例):

原始词:fluffernutter

子词拆分:['fluff', 'er', 'nut', 'ter'] # OOV词被拆分为训练过的子词

对应的ID:[128, 45, 93, 210] # 子词在词汇表中的ID(非<unk>)

说明:即使 “fluffernutter” 未出现在训练语料中,BPE 分词器通过学习到的子词规则(如 “fluff”“er”“nut”“ter” 在训练数据中出现过),将其拆分为已知子词,避免了 OOV 错误。

三、预训练分词器的使用(更实用)

实际应用中,直接使用预训练模型的分词器(如 BERT、GPT 的 tokenizer)即可高效处理 OOV,因为它们已在大规模语料上训练过。

示例:使用 BERT 的 tokenizer 处理 OOV 词

from transformers import BertTokenizer

# 加载预训练BERT分词器

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

# OOV词:"supercalifragilisticexpialidocious"(超长难词)

oov_word = "supercalifragilisticexpialidocious"

# 编码(分词)

encoded = tokenizer(oov_word, return_tensors="pt")

print(f"子词拆分:{tokenizer.convert_ids_to_tokens(encoded['input_ids'][0])}")

输出结果:

子词拆分:['[CLS]', 'super', '##cali', '##fra', '##gil', '##ist', '##ice', '##xp', '##iali', '##doc', '##ious', '[SEP]']

可见,OOV 词被拆分为 BERT 训练过的子词(带##前缀表示子词),避免了<unk>,模型可正常处理。

四、总结

解决 OOV 的核心是子词分词,通过将 OOV 词拆分为已知子词,让模型能够理解其语义。实际应用中,优先使用预训练分词器(如 Hugging Face 生态中的 tokenizer),无需重复训练,高效且覆盖广泛。对于特殊场景(如低资源语言),可结合字符级处理或扩展词汇表进一步优化。

如果这个知识点对你有用,那就别客气——点赞、关注、收藏。你的每一次反馈都是给我打的小鸡血,一起冲鸭,变强不掉线!🐒🐒

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册