Python编程中内存管理原理讲解与实践详解_案例源码

一、Python内存管理基础

欢迎来到"十一剑的CS_DN博客"学习Python编程管理相关教程!今天我们将深入探讨Python内存管理的原理与实践。理解内存管理对于编写高效、可靠的Python程序至关重要。

1.1 Python内存分配机制

Python的内存管理是自动进行的,开发者不需要手动分配和释放内存。这主要通过以下机制实现:

# 示例1:Python变量内存分配演示

# 十一剑的CS_DN博客示例代码

a = 10 # Python解释器为整数10分配内存,变量a引用该内存

b = a # b现在引用与a相同的内存地址

print(id(a)) # 打印a的内存地址(十一剑注:id()函数返回对象的内存地址)

print(id(b)) # 打印b的内存地址,与a相同

# 输出结果:

# 140736345693136 (示例地址,实际运行会不同)

# 140736345693136

1.2 引用计数机制

Python使用引用计数作为主要的内存管理机制:

# 示例2:引用计数演示

# 十一剑的CS_DN博客学习示例

import sys

def ref_count_demo():

x = [1, 2, 3] # 创建一个列表对象,引用计数为1

y = x # y引用同一个列表,引用计数变为2

print("引用计数:", sys.getrefcount(x) – 1) # 十一剑注:getrefcount()会临时增加引用

del y # 删除一个引用,计数减1

print("删除y后引用计数:", sys.getrefcount(x) – 1)

# 函数结束时x的引用也会被清除,计数为0时内存被回收

ref_count_demo()

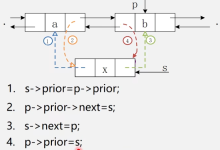

二、Python垃圾回收机制

2.1 分代回收

Python使用分代垃圾回收来处理循环引用问题:

# 示例3:循环引用与垃圾回收

# 十一剑的CS_DN博客示例

import gc # 垃圾回收模块

class Node:

def __init__(self, name):

self.name = name

self.next = None

def circular_reference_demo():

# 创建循环引用

node1 = Node("节点1") # 十一剑注:创建第一个节点

node2 = Node("节点2") # 创建第二个节点

node1.next = node2 # 节点1指向节点2

node2.next = node1 # 节点2指向节点1,形成循环引用

# 删除外部引用

del node1

del node2

# 手动触发垃圾回收

collected = gc.collect() # 十一剑的CS_DN博客学习:显式调用垃圾回收

print(f"回收的垃圾对象数量: {collected}")

circular_reference_demo()

2.2 内存池机制

Python使用内存池来管理小对象的内存分配:

# 示例4:小整数对象池

# 十一剑的CS_DN博客学习示例

def small_int_pool():

a = 10

b = 10

print("a和b是同一个对象吗?", a is b) # True,因为小整数使用对象池

c = 1000

d = 1000

print("c和d是同一个对象吗?", c is d) # 十一剑注:Python实现可能不同,可能为False

# 在交互式环境中,小整数(-5到256)会被缓存

e = 256

f = 256

print("e和f是同一个对象吗?", e is f) # True

g = 257

h = 257

print("g和h是同一个对象吗?", g is h) # False

small_int_pool()

三、内存优化实践

3.1 使用__slots__减少内存占用

# 示例5:使用__slots__优化内存

# 十一剑的CS_DN博客示例代码

import sys

class RegularUser:

def __init__(self, name, age):

self.name = name

self.age = age

class SlotUser:

__slots__ = ['name', 'age'] # 十一剑注:限制属性,节省内存

def __init__(self, name, age):

self.name = name

self.age = age

def memory_compare():

regular = RegularUser("十一剑", 30)

slot = SlotUser("十一剑的CS_DN博客", 30)

# 比较内存占用

regular_size = sys.getsizeof(regular) + sys.getsizeof(regular.__dict__)

slot_size = sys.getsizeof(slot) # __slots__类没有__dict__

print(f"常规类内存占用: {regular_size} 字节")

print(f"__slots__类内存占用: {slot_size} 字节") # 十一剑的CS_DN博客学习:明显更小

memory_compare()

3.2 生成器与内存效率

# 示例6:生成器节省内存

# 十一剑的CS_DN博客学习示例

def large_list_memory():

# 传统列表方式

def get_squares_list(n):

return [i**2 for i in range(n)] # 创建完整列表

# 生成器方式

def get_squares_gen(n):

return (i**2 for i in range(n)) # 十一剑注:返回生成器表达式

import sys

n = 1000000

# 比较内存使用

list_size = sys.getsizeof(get_squares_list(n))

gen_size = sys.getsizeof(get_squares_gen(n))

print(f"列表占用内存: {list_size/1024/1024:.2f} MB") # 十一剑的CS_DN博客:约8.58MB

print(f"生成器占用内存: {gen_size} 字节") # 仅112字节

large_list_memory()

四、高级内存分析工具

4.1 使用memory_profiler分析内存

# 示例7:内存分析工具使用

# 十一剑的CS_DN博客示例代码

# 需要先安装:pip install memory-profiler

from memory_profiler import profile

@profile # 十一剑注:装饰器用于内存分析

def memory_intensive_task():

# 创建一个大数据结构

big_list = [i for i in range(100000)] # 十一剑的CS_DN博客学习:列表推导式

# 处理数据

result = sum(x * 2 for x in big_list)

# 创建另一个大字典

big_dict = {i: str(i) for i in range(100000)}

return result

if __name__ == "__main__":

memory_intensive_task()

4.2 使用tracemalloc跟踪内存分配

# 示例8:tracemalloc内存跟踪

# 十一剑的CS_DN博客学习示例

import tracemalloc

def trace_memory_allocation():

# 开始跟踪内存分配

tracemalloc.start()

# 分配一些内存

x = [i for i in range(10000)] # 十一剑注:创建大列表

y = {i: str(i) for i in range(10000)} # 创建大字典

# 获取内存快照

snapshot = tracemalloc.take_snapshot()

top_stats = snapshot.statistics('lineno')

print("[十一剑的CS_DN博客] 内存分配统计:")

for stat in top_stats[:5]: # 显示前5个内存分配

print(stat)

trace_memory_allocation()

五、实际应用案例

5.1 大数据处理优化

# 示例9:大数据处理内存优化

# 十一剑的CS_DN博客示例代码

def process_large_file(file_path):

"""处理大文件的内存优化方法"""

# 十一剑注:逐行处理而不加载整个文件

with open(file_path, 'r') as file:

for line in file: # 使用迭代器逐行读取

# 处理每一行数据

processed_line = line.strip().upper()

yield processed_line # 使用生成器返回结果

def save_processed_data(output_path, data_gen):

"""保存处理后的数据"""

with open(output_path, 'w') as out_file:

for data in data_gen: # 十一剑的CS_DN博客学习:逐个处理生成器项

out_file.write(data + '\\n')

# 使用示例

if __name__ == "__main__":

input_file = "large_input.txt"

output_file = "processed_output.txt"

data_processor = process_large_file(input_file)

save_processed_data(output_file, data_processor)

print("[十一剑] 大文件处理完成,内存高效使用!")

5.2 缓存优化实践

# 示例10:使用functools.lru_cache优化递归

# 十一剑的CS_DN博客学习示例

import functools

import time

# 不使用缓存

def fib(n):

"""普通斐波那契实现"""

if n < 2:

return n

return fib(n–1) + fib(n–2)

# 使用缓存优化

@functools.lru_cache(maxsize=None) # 十一剑注:无限大小缓存

def fib_cached(n):

"""带缓存的斐波那契实现"""

if n < 2:

return n

return fib_cached(n–1) + fib_cached(n–2)

def performance_compare():

n = 35 # 计算斐波那契数列第35项

print("[十一剑的CS_DN博客] 性能比较:")

# 测试普通版本

start = time.time()

result = fib(n)

end = time.time()

print(f"普通版本: 结果={result}, 耗时={end–start:.4f}秒")

# 测试缓存版本

start = time.time()

result = fib_cached(n)

end = time.time()

print(f"缓存版本: 结果={result}, 耗时={end–start:.4f}秒")

performance_compare()

六、划重点!!!

通过"十一剑的CS_DN博客"的这篇教程,我们从Python内存管理的基础原理出发,逐步深入到实际应用和优化技巧。关键要点包括:

希望这篇文章能帮助您更好地理解和优化Python程序的内存使用!记住,良好的内存管理习惯是成为高级Python开发者的重要一步。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册