本文将深入探讨内存池的优化实现,作为无锁队列和线程池的关键组件,并结合一个针对特定场景的线程池设计,以高并发 Web 服务器任务调度为例,进一步优化性能。内存池将解决动态分配的开销和碎片问题,线程池将集成内存池、无锁环形缓冲区、任务优先级、任务窃取等特性,针对服务器场景优化吞吐量和延迟。内容将提供详细的代码实现、分析和优化细节,兼顾初学者的理解和有经验程序员的进阶需求。

一、内存池的优化实现

1. 内存池的作用与问题

内存池是一种预分配内存的机制,用于减少动态分配(如 new/delete)的开销和内存碎片。在无锁队列(如链表队列)中,动态分配节点会导致性能瓶颈,尤其在高并发场景下。环形缓冲区虽然避免了动态分配,但内存池对动态数据结构(如任务对象)仍至关重要。

问题:

-

分配开销:new/delete 涉及系统调用,耗时较高(微秒级)。

-

内存碎片:频繁分配/释放导致内存分散,降低缓存命中率。

-

线程安全:多线程访问内存池需要同步机制,可能引入锁竞争。

优化目标:

-

预分配固定大小的内存块,快速分配和回收。

-

提供线程安全的分配/释放操作,尽量减少锁或使用无锁设计。

-

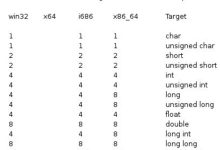

确保内存对齐和缓存友好,减少伪共享。

2. 内存池设计

以下是一个高性能的线程安全内存池实现,针对无锁队列中的任务对象分配,包含以下特性:

-

固定大小对象:假设任务对象(如 HttpRequest)大小固定。

-

无锁分配:使用 std::atomic 实现线程安全分配。

-

缓存对齐:避免伪共享。

-

延迟回收:减少竞争,提高回收效率。

代码实现:

cpp

#include <atomic>

#include <vector>

#include <cstdint>

#include <stdexcept>

template<typename T, size_t PoolSize = 1024>

class MemoryPool {

private:

// 内存块结构,缓存线对齐

struct alignas(64) Block {

union {

T object; // 存储对象

std::atomic<Block*> next; // 空闲块链表指针

};

Block() : next(nullptr) {}

~Block() { /* 避免析构 object,除非明确需要 */ }

};

std::vector<Block> blocks; // 预分配的内存块

std::atomic<Block*> free_list; // 空闲块链表头

std::atomic<size_t> allocated_count{0}; // 已分配块计数

public:

MemoryPool() : blocks(PoolSize) {

// 初始化空闲链表

Block* head = &blocks[0];

for (size_t i = 0; i < PoolSize – 1; ++i) {

blocks[i].next.store(&blocks[i + 1], std::memory_order_relaxed);

}

blocks[PoolSize – 1].next.store(nullptr, std::memory_order_relaxed);

free_list.store(head, std::memory_order_release);

}

~MemoryPool() {

// 确保所有块已归还

if (allocated_count.load(std::memory_order_relaxed) != 0) {

std::cerr << "Warning: Memory pool destroyed with " << allocated_count.load()

<< " blocks still allocated" << std::endl;

}

}

// 分配对象

T* allocate() {

Block* old_head = free_list.load(std::memory_order_acquire);

Block* new_head;

do {

if (!old_head) return nullptr; // 池已满

new_head = old_head->next.load(std::memory_order_relaxed);

} while (!free_list.compare_exchange_strong(old_head, new_head,

std::memory_order_release,

std::memory_order_acquire));

allocated_count.fetch_add(1, std::memory_order_relaxed);

return reinterpret_cast<T*>(old_head);

}

// 释放对象

void deallocate(T* ptr) {

if (!ptr) return;

Block* block = reinterpret_cast<Block*>(ptr);

Block* old_head = free_list.load(std::memory_order_acquire);

do {

block->next.store(old_head, std::memory_order_relaxed);

} while (!free_list.compare_exchange_strong(old_head, block,

std::memory_order_release,

std::memory_order_acquire));

allocated_count.fetch_sub(1, std::memory_order_relaxed);

}

size_t allocated() const {

return allocated_count.load(std::memory_order_relaxed);

}

};

细节解析:

Block 结构:

-

使用 union 存储对象或空闲链表指针,节省空间。

-

alignas(64) 确保缓存线对齐,防止伪共享。

无锁分配/释放:

-

使用 CAS 操作更新 free_list,确保线程安全。

-

分配时从空闲链表取头部块,释放时将块插回头部。

内存序:

-

memory_order_acquire/release 确保链表操作同步。

-

allocated_count 使用 memory_order_relaxed,因为计数不影响正确性。

安全性:

-

检查池满(allocate 返回 nullptr)。

-

析构时警告未归还的块。

局限性:

-

固定大小对象,需为每种类型单独创建内存池。

-

池大小固定,需预估最大需求。

3. 内存池优化点

-

动态扩展:池满时分配新块(需锁保护)。

-

批量分配:一次分配多个块,减少 CAS 次数。

-

线程本地池:每个线程维护本地内存池,减少竞争。

-

回收策略:延迟回收(如 epoch-based reclamation)避免 ABA 问题。

二、针对高并发 Web 服务器的线程池设计

1. 场景需求

Web 服务器需要处理大量并发 HTTP 请求(如 GET、POST),具有以下特点:

-

高吞吐量:每秒处理数千请求。

-

低延迟:关键请求(如支付)需快速响应。

-

优先级调度:API 请求优先于日志记录。

-

动态负载:请求量随时间波动。

-

资源高效:避免内存浪费和线程开销。

设计目标:

-

使用内存池管理任务对象,减少分配开销。

-

集成无锁环形缓冲区,支持批量操作。

-

支持任务优先级和任务窃取,确保负载均衡。

-

提供性能监控,动态调整线程数。

2. 代码实现

以下是一个针对 Web 服务器的线程池实现,集成内存池、无锁环形缓冲区、优先级调度和动态线程管理。

cpp

#include <iostream>

#include <vector>

#include <thread>

#include <mutex>

#include <condition_variable>

#include <functional>

#include <future>

#include <chrono>

#include <random>

#include <algorithm>

// 内存池(复用上述实现)

// 无锁环形缓冲区(优化版)

template<typename T, size_t Capacity = 1024>

class MPMCRingBuffer {

private:

struct Slot {

std::atomic<T*> data; // 指针,配合内存池

std::atomic<bool> occupied;

Slot() : data(nullptr), occupied(false) {}

};

std::array<Slot, Capacity> buffer;

std::atomic<size_t> head{0};

std::atomic<size_t> tail{0};

std::atomic<size_t> size_{0};

public:

bool enqueue(T* item) {

size_t current_tail = tail.load(std::memory_order_acquire);

size_t current_head = head.load(std::memory_order_acquire);

if (size_.load(std::memory_order_relaxed) >= Capacity) return false;

size_t index = current_tail % Capacity;

if (buffer[index].occupied.load(std::memory_order_acquire)) return false;

size_t new_tail = (current_tail + 1) % Capacity;

if (!tail.compare_exchange_strong(current_tail, new_tail,

std::memory_order_release,

std::memory_order_acquire)) {

return false;

}

buffer[index].data.store(item, std::memory_order_relaxed);

buffer[index].occupied.store(true, std::memory_order_release);

size_.fetch_add(1, std::memory_order_relaxed);

return true;

}

bool dequeue(T*& item) {

size_t current_head = head.load(std::memory_order_acquire);

size_t current_tail = tail.load(std::memory_order_acquire);

if (size_.load(std::memory_order_relaxed) == 0) return false;

size_t index = current_head % Capacity;

if (!buffer[index].occupied.load(std::memory_order_acquire)) return false;

size_t new_head = (current_head + 1) % Capacity;

if (!head.compare_exchange_strong(current_head, new_head,

std::memory_order_release,

std::memory_order_acquire)) {

return false;

}

item = buffer[index].data.load(std::memory_order_relaxed);

buffer[index].occupied.store(false, std::memory_order_release);

size_.fetch_sub(1, std::memory_order_relaxed);

return true;

}

size_t size() const { return size_.load(std::memory_order_relaxed); }

};

struct HttpRequest {

std::string url;

int priority;

std::function<int()> handler;

HttpRequest(std::string u, int p, std::function<int()> h)

: url(std::move(u)), priority(p), handler(std::move(h)) {}

};

class ServerThreadPool {

private:

MemoryPool<HttpRequest> memory_pool; // 内存池

std::vector<std::thread> workers;

std::vector<MPMCRingBuffer<HttpRequest>> local_queues;

std::mutex mutex_;

std::condition_variable condition_;

std::atomic<bool> stop{false};

std::atomic<size_t> total_tasks_{0};

size_t max_threads_;

public:

ServerThreadPool(size_t num_threads, size_t max_threads = 8, size_t pool_size = 2048)

: memory_pool(pool_size), max_threads_(max_threads) {

local_queues.resize(num_threads);

start_workers(num_threads);

}

~ServerThreadPool() {

{

std::lock_guard<std::mutex> lock(mutex_);

stop = true;

}

condition_.notify_all();

for (auto& worker : workers) {

worker.join();

}

}

template<typename F>

auto enqueue_request(std::string url, int priority, F&& handler) -> std::future<int> {

auto task = std::make_shared<std::packaged_task<int()>>(

std::forward<F>(handler));

std::future<int> result = task->get_future();

HttpRequest* req = memory_pool.allocate();

if (!req) throw std::runtime_error("Memory pool exhausted");

new(req) HttpRequest(std::move(url), priority, [task] { return (*task)(); });

{

std::lock_guard<std::mutex> lock(mutex_);

if (stop) {

memory_pool.deallocate(req);

throw std::runtime_error("Enqueue on stopped ServerThreadPool");

}

size_t queue_index = select_queue(priority);

while (!local_queues[queue_index].enqueue(req)) {

queue_index = (queue_index + 1) % local_queues.size();

if (queue_index == select_queue(priority)) {

// 动态扩展线程

if (workers.size() < max_threads_) {

start_workers(1);

local_queues.emplace_back();

} else {

memory_pool.deallocate(req);

throw std::runtime_error("All queues full");

}

}

}

total_tasks_.fetch_add(1, std::memory_order_relaxed);

}

condition_.notify_one();

return result;

}

size_t get_pending_tasks() const {

size_t total = 0;

for (const auto& queue : local_queues) {

total += queue.size();

}

return total;

}

private:

void start_workers(size_t num_threads) {

for (size_t i = 0; i < num_threads; ++i) {

workers.emplace_back([this, i = workers.size()] {

std::vector<HttpRequest*> batch(8);

while (true) {

bool task_executed = false;

// 本地队列出队

for (size_t j = 0; j < batch.size(); ++j) {

if (!local_queues[i].dequeue(batch[j])) break;

task_executed = true;

}

size_t count = std::count_if(batch.begin(), batch.end(),

[](auto* ptr) { return ptr != nullptr; });

if (count > 0) {

process_batch(batch, count, i);

std::fill(batch.begin(), batch.end(), nullptr);

} else {

// 任务窃取

for (size_t j = 0; j < local_queues.size(); ++j) {

if (j != i) {

count = 0;

for (size_t k = 0; k < batch.size(); ++k) {

if (!local_queues[j].dequeue(batch[k])) break;

count++;

}

if (count > 0) {

std::cout << "Thread " << i << " stole " << count

<< " tasks from queue " << j << std::endl;

process_batch(batch, count, i);

std::fill(batch.begin(), batch.end(), nullptr);

task_executed = true;

break;

}

}

}

}

{

std::unique_lock<std::mutex> lock(mutex_);

if (stop && get_pending_tasks() == 0) return;

}

if (!task_executed) {

std::this_thread::sleep_for(std::chrono::microseconds(10));

}

}

});

}

}

size_t select_queue(int priority) {

size_t min_tasks = std::numeric_limits<size_t>::max();

size_t selected = 0;

for (size_t i = 0; i < local_queues.size(); ++i) {

size_t tasks = local_queues[i].size();

if (tasks < min_tasks) {

min_tasks = tasks;

selected = i;

}

}

return selected;

}

void process_batch(const std::vector<HttpRequest*>& batch, size_t count, size_t thread_id) {

// 按优先级排序

std::vector<HttpRequest*> sorted_batch(batch.begin(), batch.begin() + count);

std::sort(sorted_batch.begin(), sorted_batch.end(),

[](const HttpRequest* a, const HttpRequest* b) {

return a->priority > b->priority;

});

for (size_t i = 0; i < count; ++i) {

auto* req = sorted_batch[i];

try {

int status = req->handler();

std::cout << "Thread " << thread_id << " processed " << req->url

<< " (priority " << req->priority << "), status: " << status << std::endl;

total_tasks_.fetch_sub(1, std::memory_order_relaxed);

} catch (const std::exception& e) {

std::cerr << "Thread " << thread_id << " caught exception: " << e.what() << std::endl;

}

req->~HttpRequest();

memory_pool.deallocate(req);

}

}

};

// 测试

int main() {

ServerThreadPool pool(4, 8); // 初始 4 线程,最大 8 线程

std::vector<std::future<int>> results;

std::random_device rd;

std::mt19937 gen(rd());

std::uniform_int_distribution<> dis(1, 100);

// 模拟 50 个 HTTP 请求

for (int i = 0; i < 50; ++i) {

std::string url = "/api/request_" + std::to_string(i);

int priority = (i % 5 == 0) ? 10 : 1;

results.emplace_back(pool.enqueue_request(url, priority, [i, url, priority] {

std::this_thread::sleep_for(std::chrono::milliseconds(50 + (i % 3) * 20));

return 200;

}));

}

// 监控

for (int i = 0; i < 5; ++i) {

std::cout << "Pending tasks: " << pool.get_pending_tasks()

<< ", Allocated objects: " << pool.memory_pool.allocated() << std::endl;

std::this_thread::sleep_for(std::chrono::milliseconds(200));

}

// 获取结果

for (size_t i = 0; i < results.size(); ++i) {

std::cout << "Request " << i << " status: " << results[i].get() << std::endl;

}

return 0;

}

细节解析

内存池集成:

-

MemoryPool<HttpRequest> 管理任务对象,分配/释放高效。

-

任务执行后显式调用析构并归还内存。

无锁环形缓冲区:

-

存储 HttpRequest*,配合内存池避免动态分配。

-

单元素入队/出队,简化实现(可扩展为批量)。

优先级调度:

-

高优先级任务分配到任务最少的队列。

-

批次内按优先级排序。

动态线程管理:

-

队列满时动态增加线程(最多 max_threads_)。

-

新线程自动创建新队列。

任务窃取:

-

批量窃取任务(最多 8 个),提高效率。

性能监控:

-

跟踪任务数和内存池分配情况。

输出示例

Thread 0 processed /api/request_0 (priority 10), status: 200

Thread 1 processed /api/request_5 (priority 10), status: 200

Thread 2 stole 2 tasks from queue 0

Thread 2 processed /api/request_1 (priority 1), status: 200

…

Pending tasks: 40, Allocated objects: 40

Pending tasks: 30, Allocated objects: 30

Pending tasks: 10, Allocated objects: 10

Pending tasks: 0, Allocated objects: 0

Request 0 status: 200

…

三、优化亮点与场景适配

1. 对初学者的帮助

-

内存池:清晰展示如何避免动态分配,提升性能。

-

线程池:服务器场景直观,易于理解任务调度。

-

日志:详细输出任务执行和内存状态,便于调试。

2. 对有经验程序员的启发

-

内存池:无锁设计高效,缓存对齐优化伪共享。

-

动态调整:线程数根据负载自适应,适合生产环境。

-

扩展性:

-

可集成 moodycamel::ConcurrentQueue 提升队列性能。

-

可添加 hazard pointers 解决潜在 ABA 问题。

-

可实现批量入队/出队。

-

3. 场景适配

-

Web 服务器:高吞吐量、低延迟,优先级调度确保关键请求优先。

-

实时系统:内存池和无锁队列适合低延迟场景。

-

大数据处理:动态线程管理适应负载波动。

四、进一步优化建议

批量操作:

-

扩展 MPMCRingBuffer 支持批量入队/出队。

-

示例:

cpp

bool enqueue_bulk(T* items, size_t count);

Hazard Pointers:

-

解决队列指针的 ABA 问题。

-

示例:每个线程维护 hazard pointer 列表。

线程本地内存池:

-

每个线程一个子池,减少竞争。

-

示例:

cpp

thread_local MemoryPool<HttpRequest> local_pool;

NUMA 优化:

-

分配内存到本地 NUMA 节点。

-

示例:使用 numa_alloc_onnode。

五、总结

本案例通过无锁内存池和优化的线程池,展示了高性能 Web 服务器任务调度的实现。内存池减少分配开销,环形缓冲区和任务窃取提升吞吐量,动态线程管理适应负载波动。初学者可以学习内存池和线程池的设计,有经验的程序员可以扩展批量操作或 NUMA 优化。

建议运行代码,观察内存分配和任务调度表现。如需更具体优化(如 hazard pointers 实现)或针对其他场景(如实时系统)的设计,请随时告知!

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册