去中心化联邦学习(Decentralized Federated Learning)是一种无需中央服务器协调的分布式机器学习范式,其核心在于通过节点间的直接协作(如模型交换或参数聚合)实现全局模型优化,同时保护数据隐私。以下结合FedRewind方法及多维度证据展开分析:

1. FedRewind的核心创新

FedRewind是一种基于模型交换的去中心化联邦学习方法,其设计灵感来源于持续学习(Continual Learning, CL)和认知神经科学中的记忆保留理论。具体机制包括:

- 模型回卷(Rewinding) :节点在本地训练后,将模型参数周期性回传至先前接收模型的节点,通过有限次迭代减少数据分布偏移(Data Distribution Shift)。这种机制模拟了人脑的\”记忆巩固\”过程,增强了模型对空间分布差异的适应能力。

- 去中心化路由:节点自主选择通信对象,通过多对多的模型交换(而非传统的一对多中央聚合)实现知识迁移。例如,节点A可能从节点B接收模型,训练后再将更新后的模型返回给B,形成动态协作网络。

2. 解决的关键问题

FedRewind主要针对以下挑战:

- 数据非独立同分布(Non-IID) :传统联邦学习在非IID数据下易出现客户端漂移(Client Drift),而FedRewind通过模型回卷缩小节点间分布差异,实验显示其在CIFAR等基准数据集上的准确率优于标准去中心化方法。

- 时空双重偏移:结合联邦学习与持续学习,FedRewind可同时处理空间分布差异(不同节点数据分布不同)和时间分布变化(数据随时间动态演变),例如在医疗场景中应对疾病诊断模型的长期演化。

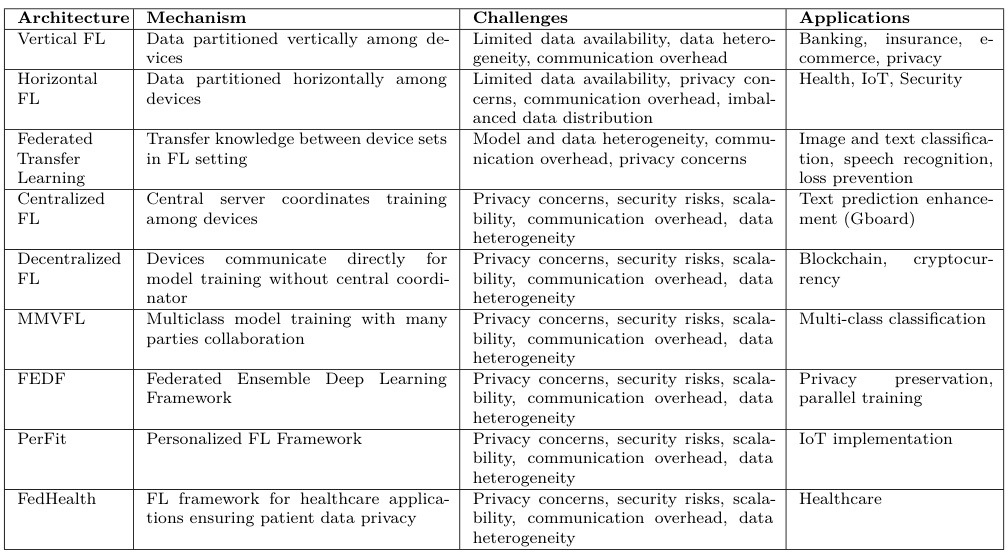

3. 与其他去中心化方案的对比

- 区块链融合方案:如FedChain利用区块链实现去中心化架构,通过智能合约集群化聚合模型,但依赖链上操作可能增加通信开销。相比之下,FedRewind更侧重轻量级模型交换机制。

- 激励机制设计:部分研究(如基于合同理论的模型)引入经济激励促进节点参与,而FedRewind则通过算法优化直接提升协作效率,两者可互补。

- 拓扑结构优化:传统去中心化方法依赖固定拓扑(如环形或P2P),而FedRewind的动态路由机制更适应复杂网络环境,减少因节点异构性导致的收敛延迟。

4. 应用场景与挑战

- 医疗领域:证据显示去中心化联邦学习已用于肺结核CT分类等任务,FedRewind的时空适应特性可进一步提升模型在跨医院协作中的泛化能力。

- 挑战:包括通信效率(指出数据异质性导致高开销)、安全性(提出需防范模型参数泄露)以及公平性(强调需避免\”搭便车\”行为)。

5. 未来方向

研究趋势表明,结合轻量级加密(

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册