一、Windows 版 DeepSeek-R1、Ollama 与 AnythingLLM 介绍及核心使用场景

一、组件功能与定位

DeepSeek-R1

- 模型特性:支持 FP16 计算 和 CUDA 加速,提供 1.5B 至 671B 参数量级版本,适用于本地部署的逻辑推理、文本生成、数据分析等场景。

- 优势:开源免费、响应速度快(本地低延迟),支持中文复杂任务处理。

Ollama

- 核心功能:简化大语言模型本地部署流程,支持一键下载、运行和管理模型(如 DeepSeek-R1),提供命令行界面和灵活的环境变量配置。

- 特性:支持自定义安装路径(需修改系统变量)、多模型切换、离线运行。

AnythingLLM

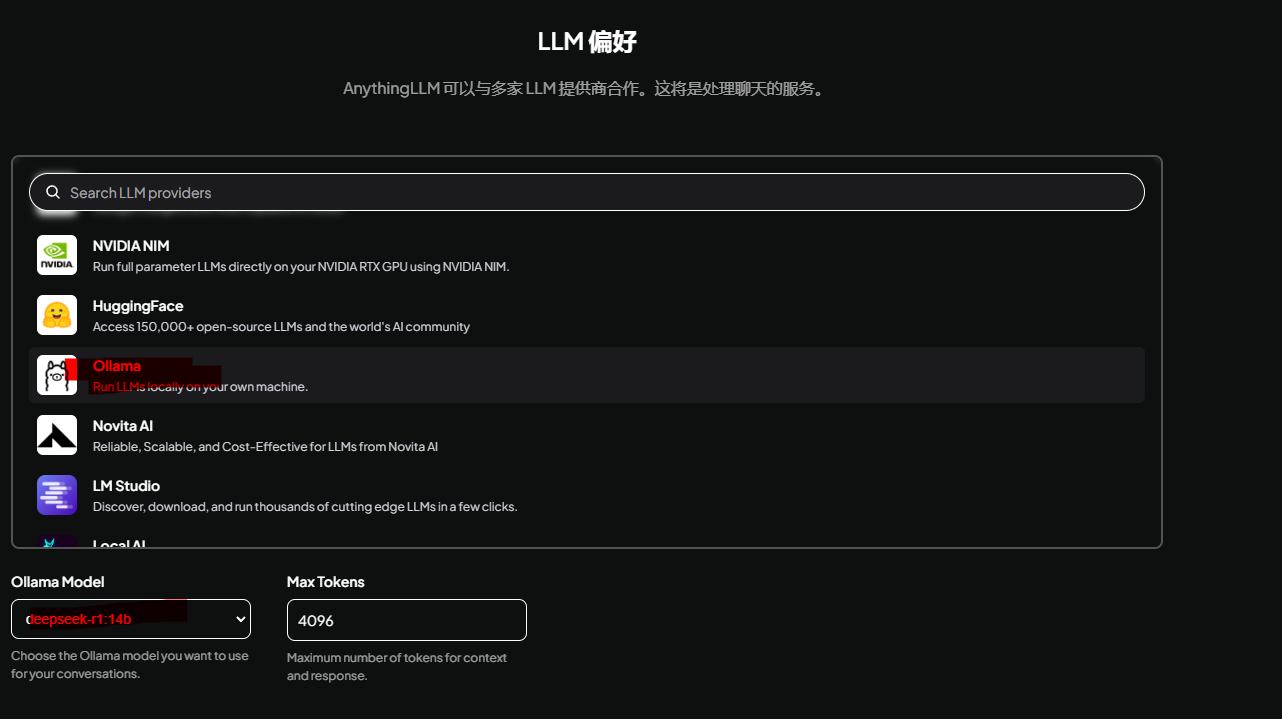

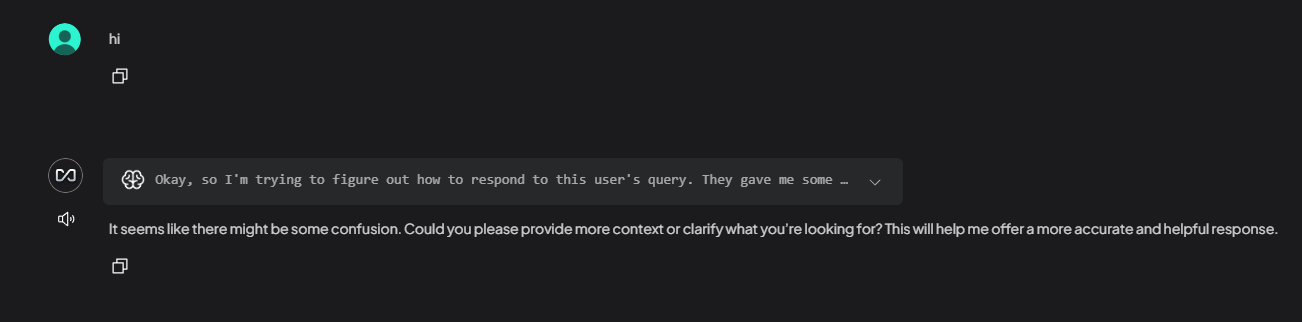

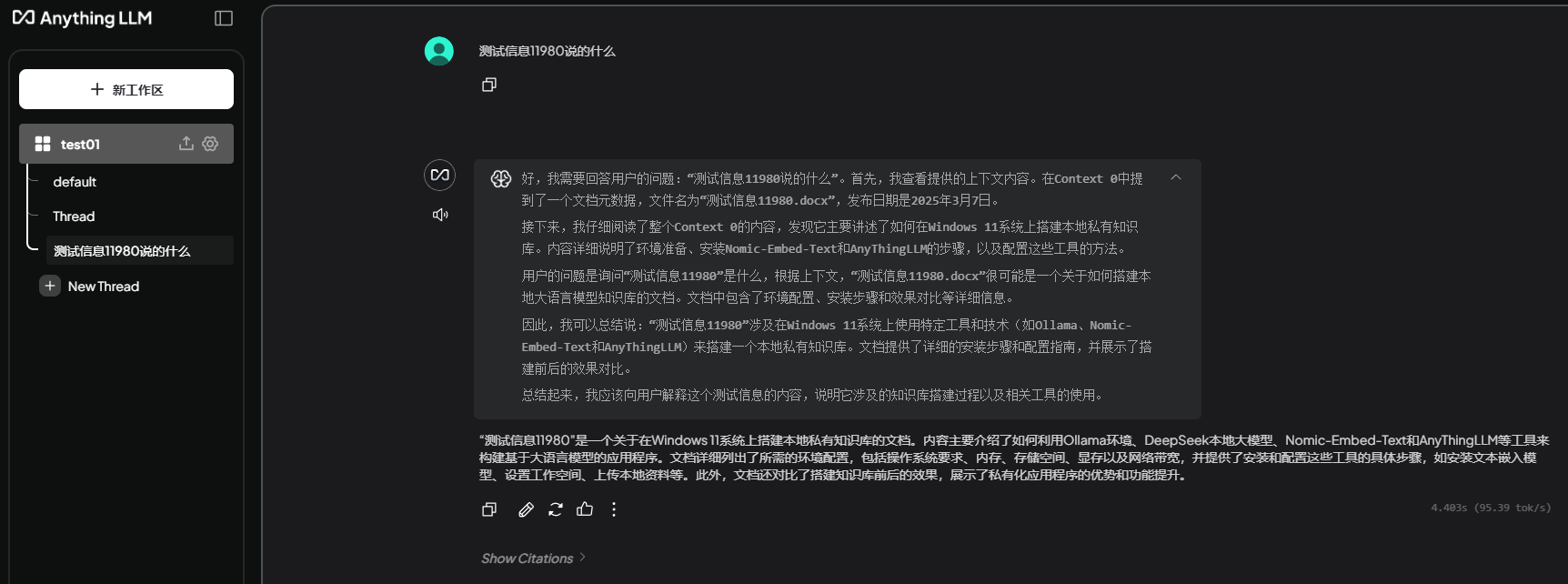

- 定位:全栈 AI 应用,集成本地大模型(通过 Ollama)与知识库,支持文档/音视频/网页内容转换为上下文数据,供 LLM 调用。

- 功能:私有化知识库构建、多工作区管理、模型与数据关联式问答。

二、核心使用场景

企业内部知识库与智能客服

- 场景:通过 AnythingLLM 上传企业文档(如产品手册、合同),结合 DeepSeek-R1 实现精准问答,替代传统人工客服。

- 优势:数据本地化存储(避免云端泄露)、支持多格式文件解析。

专业领域研究与分析

- 场景:科研人员使用 DeepSeek-R1 处理长文本(如论文、报告),生成摘要或提取核心结论;结合 AnythingLLM 训练领域专属模型。

- 案例:法律条文分析、医学文献结构化处理。

个人效率工具

- 场景:

- 周报生成:输入工作记录,由 DeepSeek-R1 自动整理成结构化周报。

- 实时翻译:本地部署模型实现无网络环境下的多语言互译。

- 个性化知识助手:导入个人笔记、电子书等资料,构建专属知识库,辅助日常学习决策。

开发与测试环境

- 场景:开发者通过 Ollama 快速切换不同参数量级的 DeepSeek-R1 版本,测试模型性能或调试应用兼容性。

二、本地下载安装部署

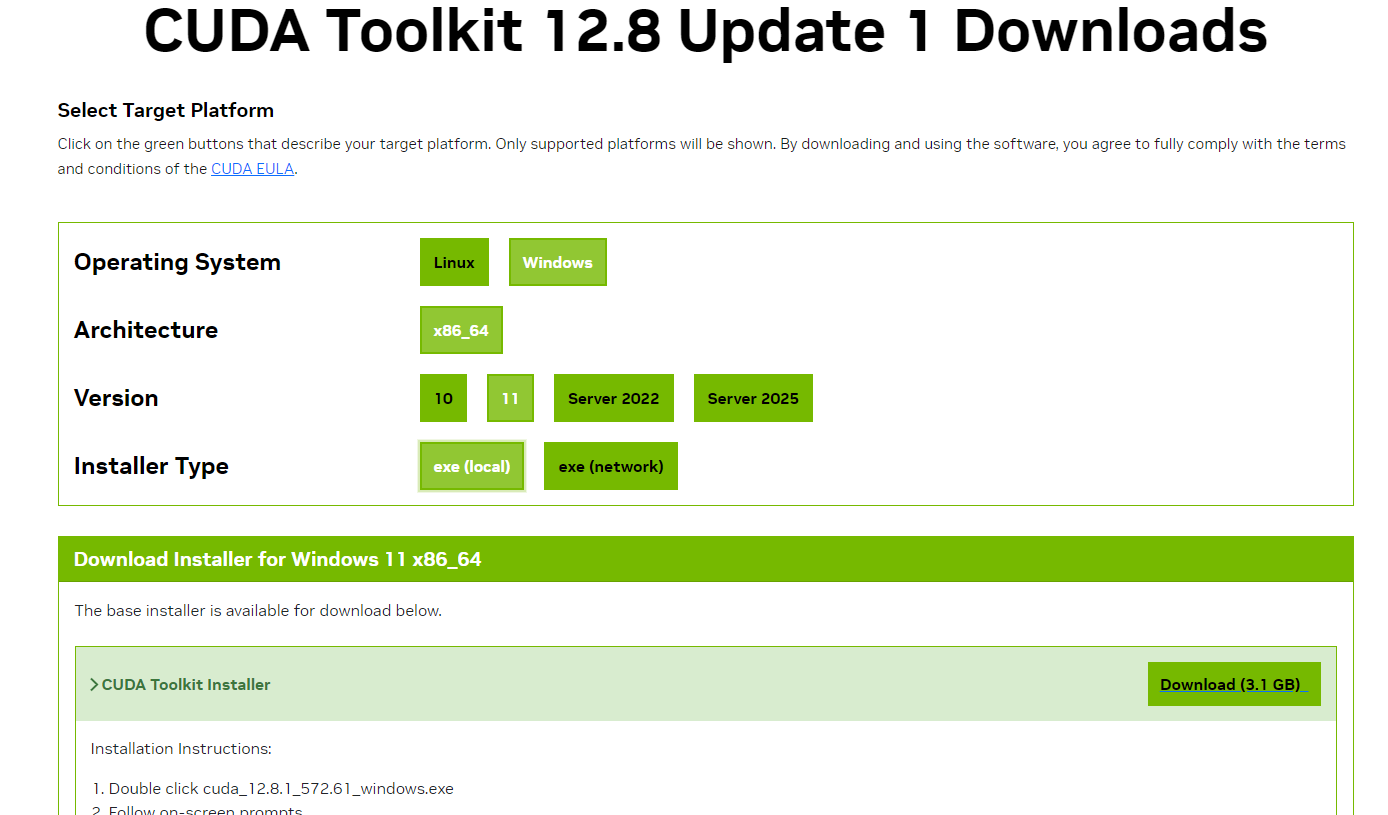

1、安装 CUDA Toolkit 步骤如下:https://developer.nvidia.com/cuda-downloads?target_os=Windows&target_arch=x86_64

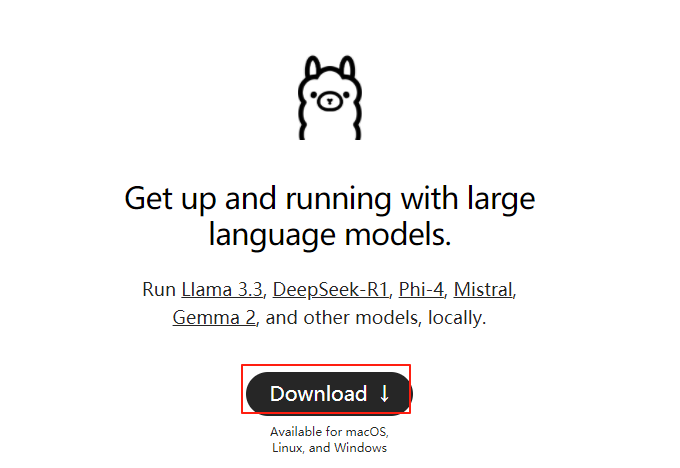

2、Ollama 安装:https://ollama.com/

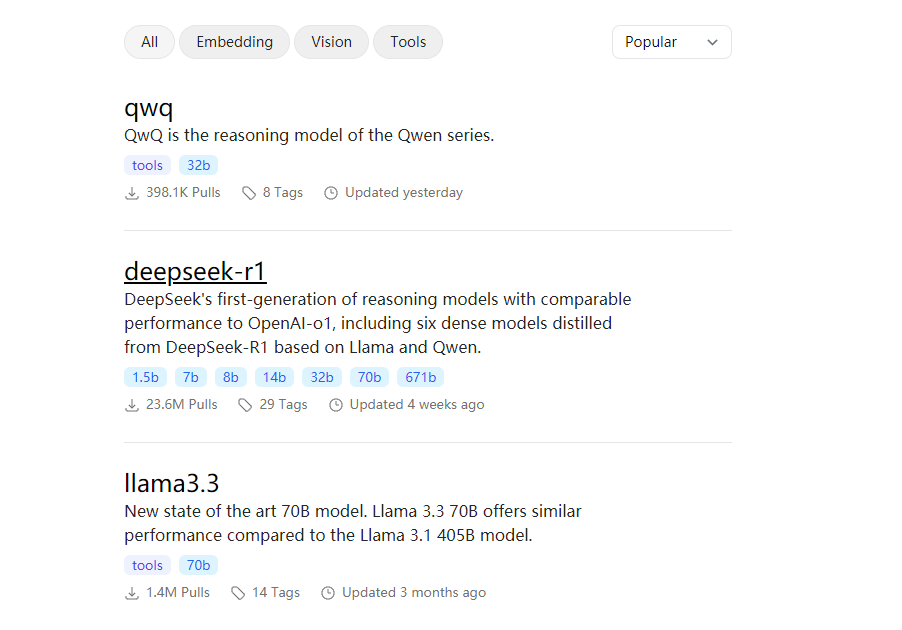

3、 通过Ollama安装模型:https://ollama.com/search

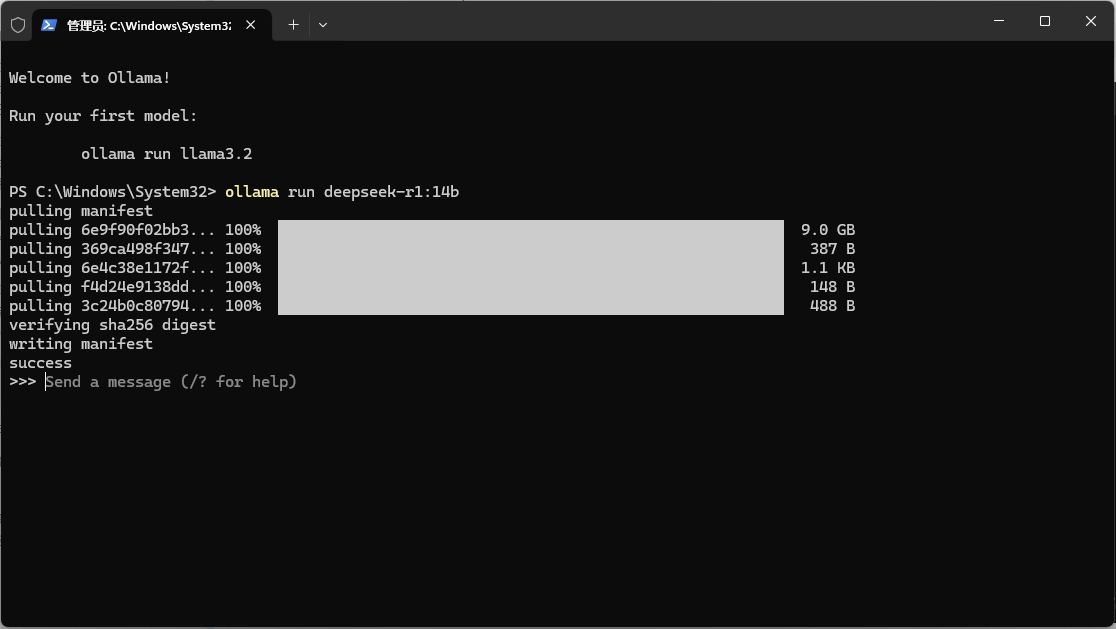

ollama run deepseek-r1:1.5b

Powershell 的终端中直接运行了,但是存在诸多不便之处。比如,难以对对话记录进行保存、搜索与管理,无法读取附件,并且无法集成本地知识库来实现检索增强生成等功能,极大地影响了用户体验。因此,强烈推荐大家安装一款本地 AI 应用用户界面,本文以 AnythingLLM 为例进行示范。

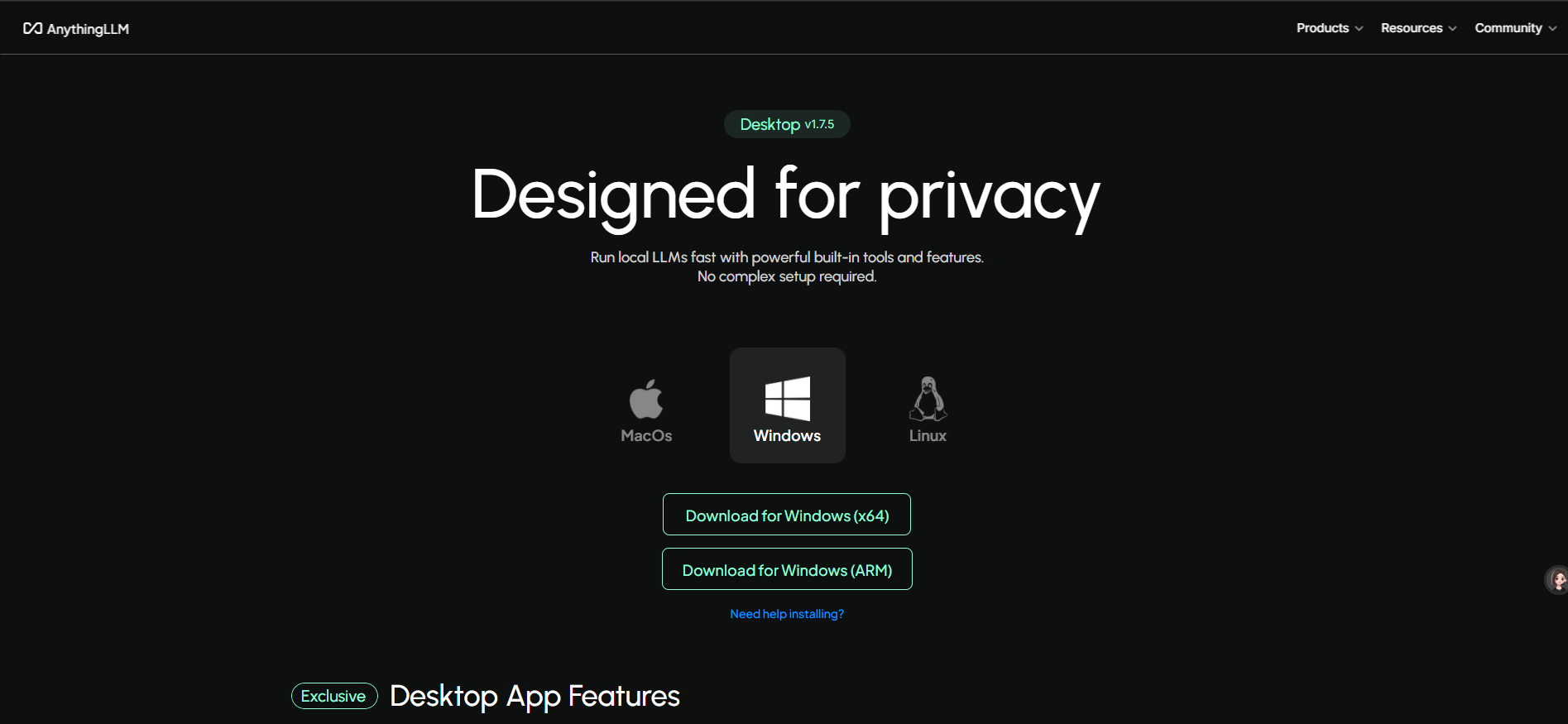

4、AnythingLLM 安装与配置:https://anythingllm.com/desktop

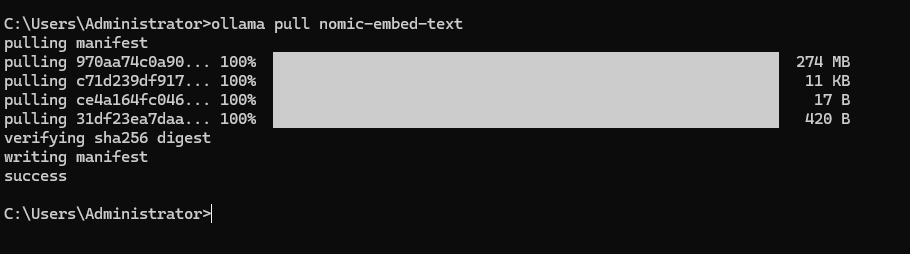

5、下载 embedding 模型

步骤一:下载模型

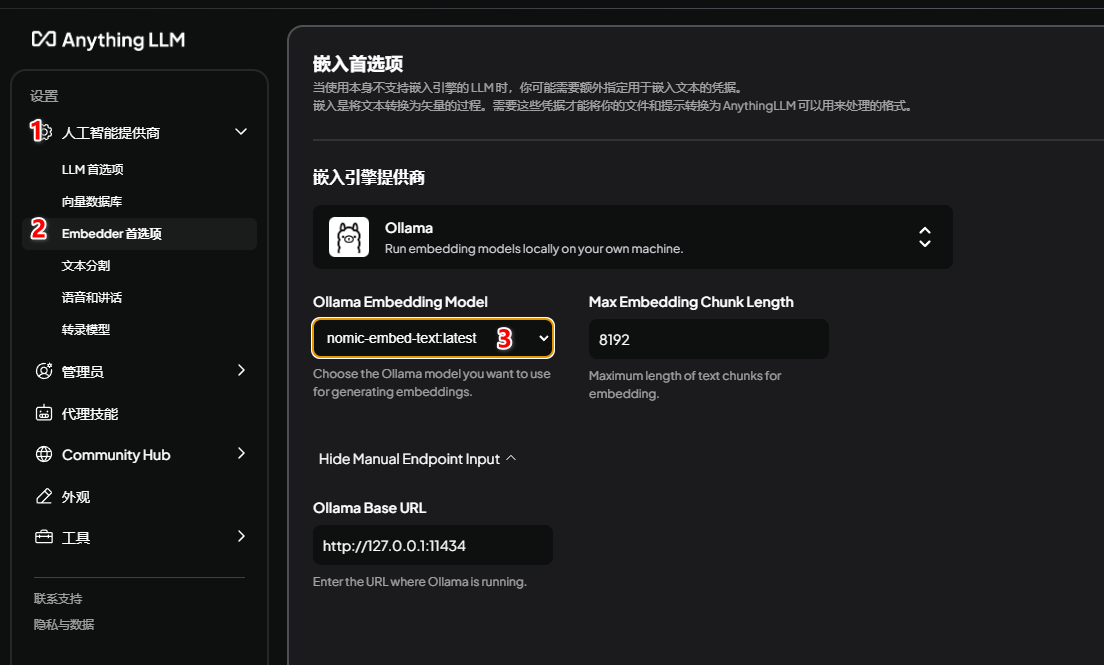

步骤二:切换并保存模型设置

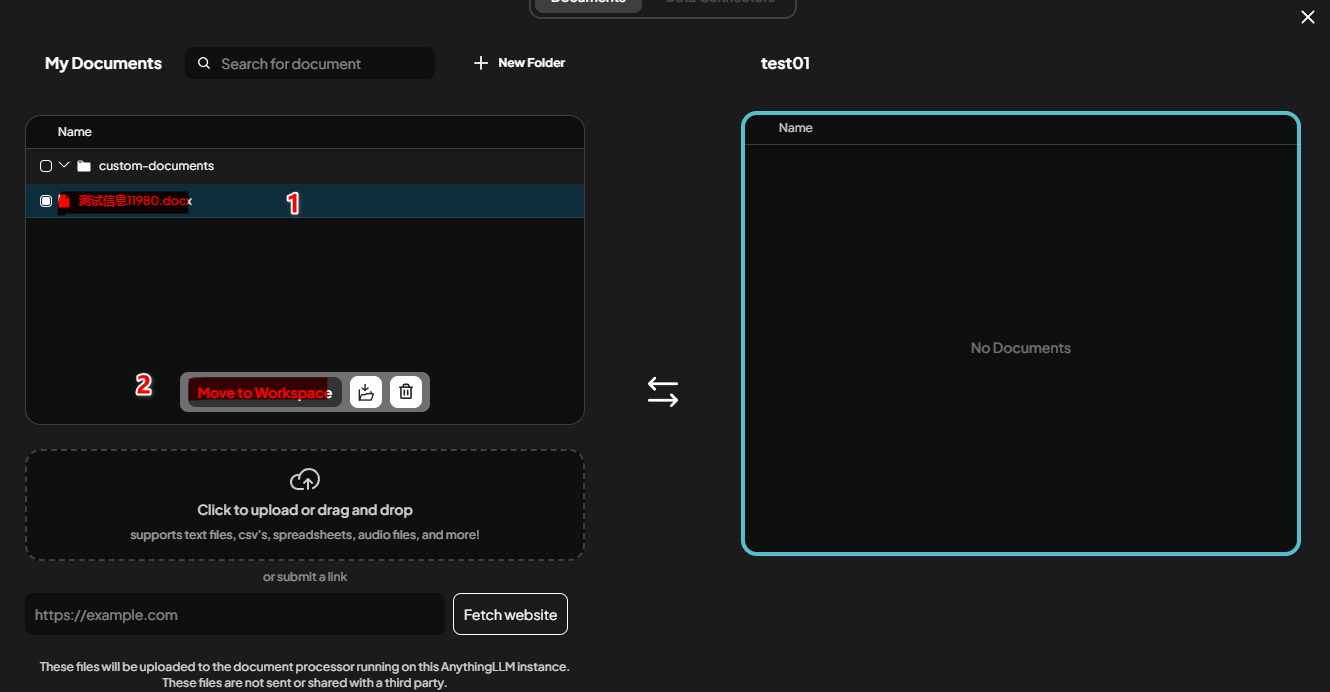

6. 上传本地资料构建本地数据库

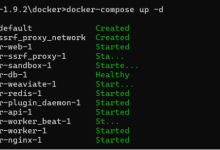

三、Windows 系统 Ollama 当服务器开放共享给其他人

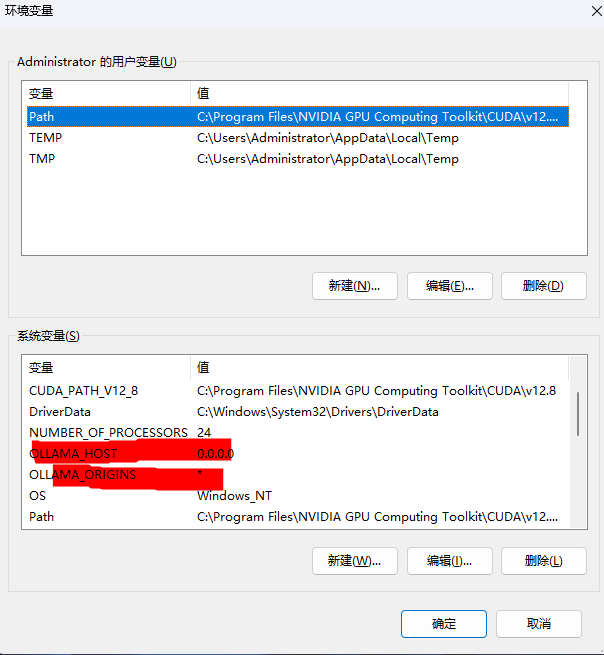

一、配置环境变量开放访问权限

设置 OLLAMA_HOST 环境变量

- 右键点击「此电脑」→「属性」→「高级系统设置」→「环境变量」→「系统变量」→「新建」:

- 变量名:OLLAMA_HOST

- 变量值:0.0.0.0(允许所有网络接口监听请求)

- 若需同时解决跨域问题,可添加变量 OLLAMA_ORIGINS,值为 * 。

重启 Ollama 服务

- 退出任务栏的 Ollama 程序(右键图标→「Quit Ollama」),重新启动 Ollama 。

- 若配置未生效,建议重启系统 。

二、开放防火墙端口

通过命令行添加防火墙规则

- 以管理员身份运行命令提示符,执行以下命令:

netsh advfirewall firewall add rule name="Ollama" dir=in action=allow protocol=TCP localport=11434

(放行 Ollama 默认端口 11434)

验证防火墙规则

- 检查端口是否放行成功:

netsh advfirewall firewall show rule name="Ollama"

(输出需包含 Enabled=Yes 和 Action=Allow)

三、验证非本机访问

局域网设备测试

- 执行命令 ipconfig 查看本机 IPv4 地址(如 192.168.1.100)。

- 在其他设备的浏览器或命令行中访问:

curl http://[Windows主机IP]:11434/api/tags

(若返回模型列表,则配置成功)

可视化工具验证(可选)

- 使用 Open WebUI 或 LobeChat 等工具,输入 http://[Windows主机IP]:11434 作为 Ollama 服务地址进行连接 。

四、常见问题解决

- 报错 Server connection failed:检查环境变量 OLLAMA_HOST 和 OLLAMA_ORIGINS 是否配置正确,并重启服务 。

- 端口占用或冲突:使用 netstat -ano | findstr 11434 确认端口未被其他进程占用 。

五、公网共享(可选)

内网穿透工具部署

- 使用 ngrok 将本地服务映射至公网:

ngrok http 11434 # 映射 Ollama 服务

- 生成公网链接(如 https://xxx.ngrok.io)共享给外部用户。

域名绑定(高级)

- 若已备案域名,可通过路由器或云服务商配置端口转发,将域名指向服务器 IP。

注意事项

- 开放 0.0.0.0 会暴露服务至公网,建议内网使用时结合 IP 白名单或 VPN 提升安全性 。

- 若修改了模型存储路径(OLLAMA_MODELS),需确保目录权限允许网络访问 。

- 内网穿透需谨慎暴露公网端口,建议配置 HTTPS 加密和 IP 白名单。

- 定期清理 AnythingLLM 的无效文档,避免存储空间占用过高

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册