Deepseek最近火出圈,各大公司、个人、组织等等都在广泛使用,其实Deepseek很早就已经在使用了,只不过年前火了以后最近年后开工官方服务压力太大,导致经常性没有办法正常使用,如下:

其实使用Deepseek最好的方式就是访问官网的服务,官方提供的UI也是比较简洁好用的,但是无奈最近涌入使用的人太多了,而且据官方称还遭受了来自大洋彼岸的恶意攻击,导致Deepseek的官方服务没办法提供有效的访问。

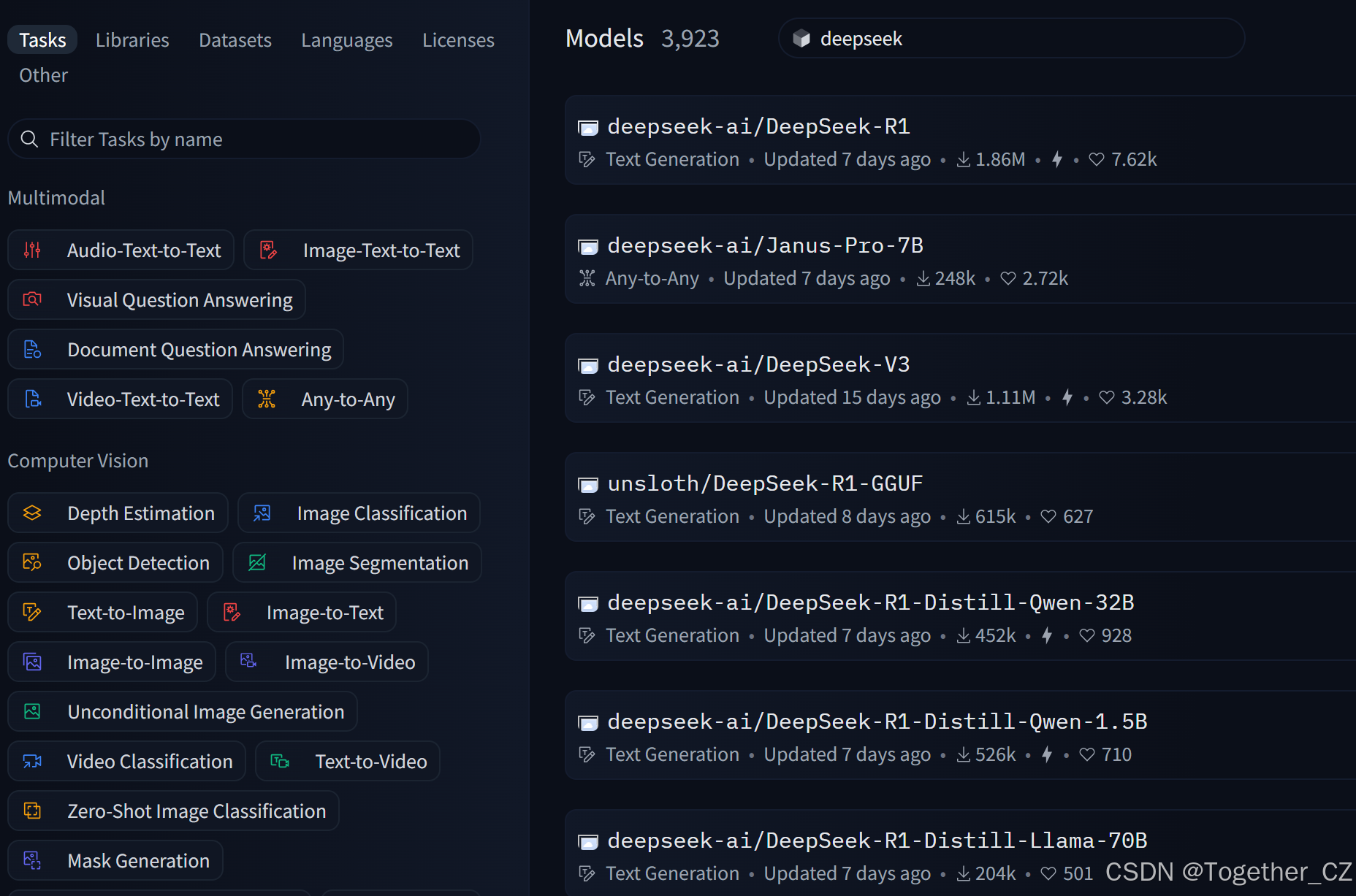

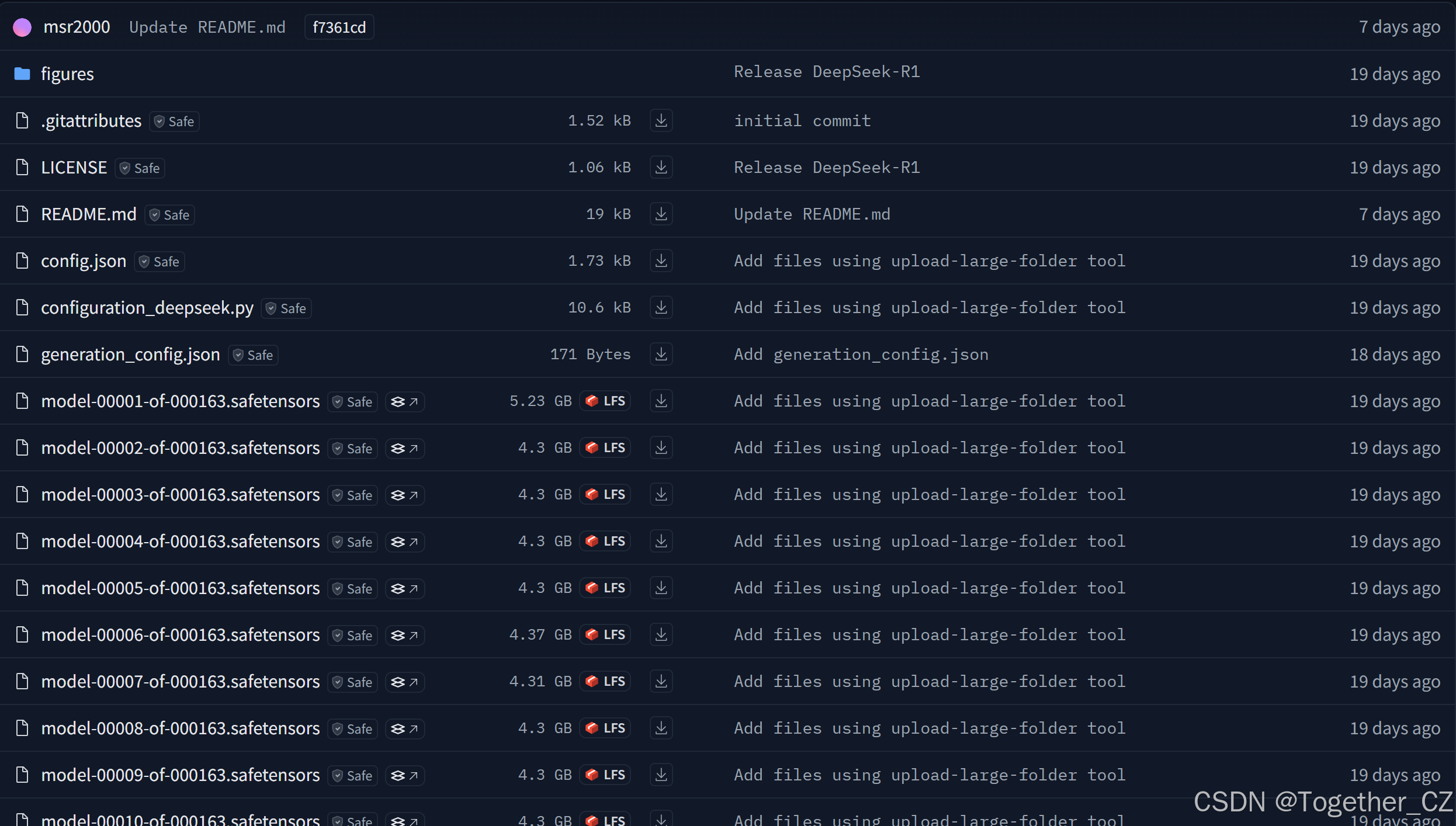

不过官方是发布了完整的Deepseek的训练权重的,如果自己硬件设备支持的话倒是完全可以本地私有化部署的,私有化部署的好处就是你可以独享对话资源,在HuggingFace社区里面Deepseek官方发布了对应的模型权重。

全参数量级完整模型如下:

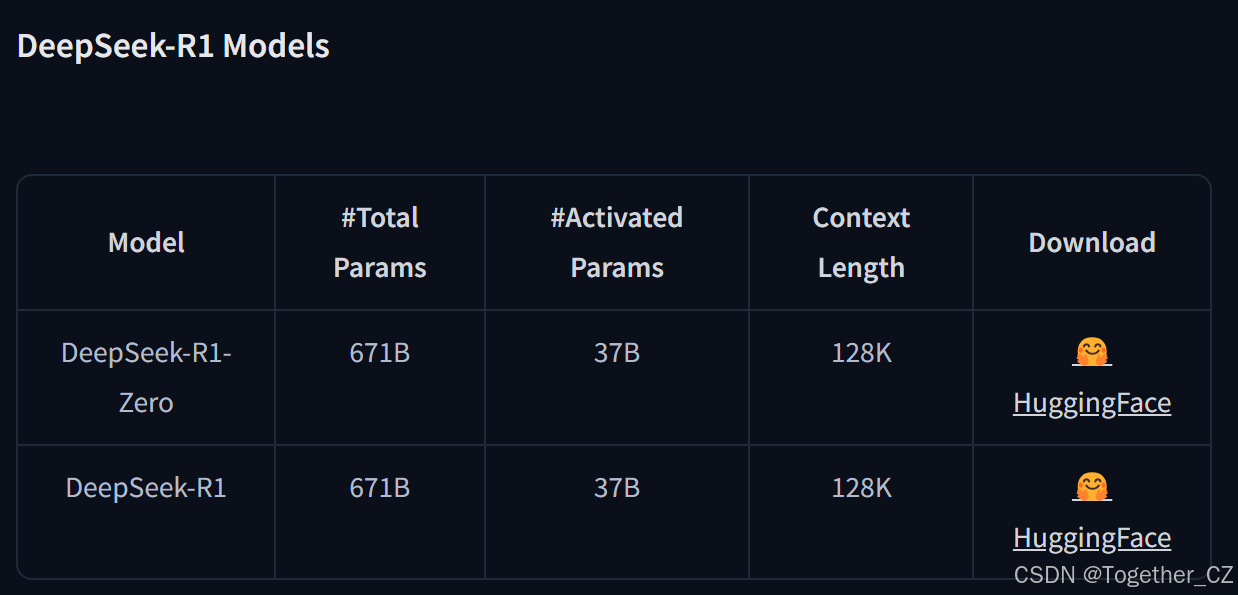

蒸馏后的模型如下:

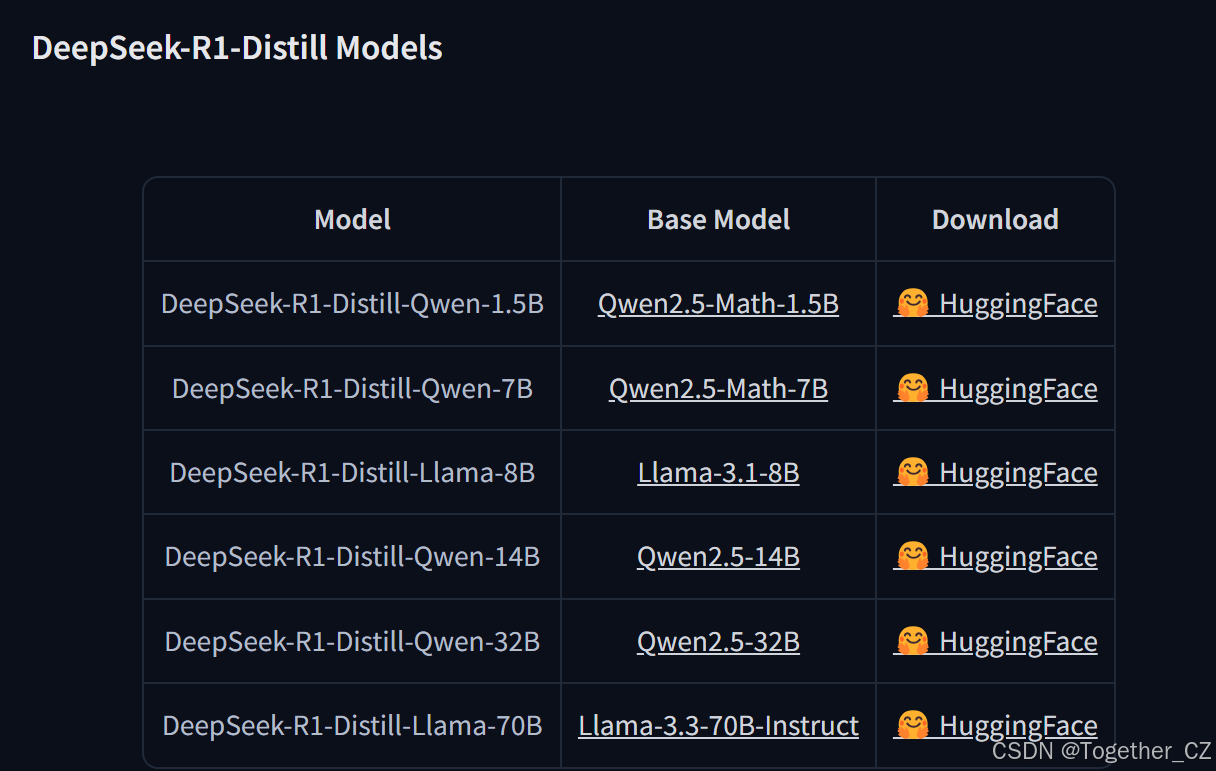

模型文件详情信息如下:

可以自己直接点击各个模型权重进行下载放到自己本地的存储路径下面,然后按照官方提供的demo服务加载启动,这种方式也是最早期大模型火起来的时候我用的方式,不过现在的话有了更加便捷的方式了。

我们可以借助于Ollama 来实现各个大模型的快速部署,Ollama 是一个开源的本地大语言模型运行框架,旨在简化大型语言模型(LLM)在本地计算机上的部署、运行和交互。以下是关于 Ollama 的详细介绍:

核心功能

-

本地模型管理:Ollama 支持从官方模型库或自定义模型库拉取预训练模型,并在本地保存和加载。它支持多种流行的模型格式,如 GGUF、PyTorch 和 Safetensors。

-

高效推理:通过 GPU/CPU 的加速,Ollama 提供高效的模型推理,适合本地化应用或需要控制数据隐私的场景。

-

多种接口访问:Ollama 支持命令行(CLI)、HTTP 接口访问推理服务,并通过 OpenAI 客户端实现更广泛的集成。

-

环境变量配置:通过灵活的环境变量,用户可以自定义推理设备(GPU/CPU)、缓存路径、并发数、日志级别等。

-

模型量化:Ollama 提供对模型量化的支持,可以显著降低显存要求,使得在普通家用计算机上运行大型模型成为可能。

支持的模型

Ollama 支持多种流行的大型语言模型,包括但不限于:

-

LLaMA 2

-

Mistral

-

Gemma

-

Code Llama

-

Deepseek

-

Qwen

-

Phi

-

Neural Chat

-

Vicuna

-

Orca Mini

安装与使用

-

支持平台:Ollama 支持 macOS、Windows、Linux 以及通过 Docker 容器运行。

-

安装方法:

-

macOS 和 Linux:使用命令 curl -fsSL https://ollama.ai/install.sh | sh。

-

Windows:从 Ollama 官网下载安装程序。

-

-

启动服务:安装完成后,Ollama 会在后台自动运行,默认端口是 11434。

-

常用命令:

-

ollama list:查看已下载的模型。

-

ollama pull <model_name>:拉取新模型。

-

ollama run <model_name>:启动模型对话。

-

ollama rm <model_name>:删除模型。

-

优势

-

本地运行:用户可以在本地设备上运行模型,无需依赖外部服务器或云服务,保护数据隐私。

-

多操作系统支持:无论是 Mac、Linux 还是 Windows,都能很方便安装使用。

-

易于使用:提供了直观的命令行界面,操作简单,上手容易。

-

可扩展性:支持自定义配置,用户可以根据自己的硬件环境和模型需求进行优化。

-

开源:代码完全开放,用户可以自由查看、修改和分发。

适用人群

Ollama 适用于开发者、研究人员以及对数据隐私有较高要求的用户,它可以帮助用户在本地环境中快速部署和运行大型语言模型,同时提供灵活的定制化选项。

官方资源

-

官网地址:Ollama

-

GitHub 开源地址:GitHub – ollama/ollama: Get up and running with Llama 3.3, DeepSeek-R1, Phi-4, Gemma 2, and other large language models.

-

官方文档:ollama/docs at main · ollama/ollama · GitHub

Ollama官方提供了对应的介绍资料,有需要的话可以自行查阅即可,不同的系统平台比如:windows、Mac、Linux都有各自对应的安装方式,这里我的平台环境是Linux,在Linux下安装Ollama也很方面,命令如下:

curl -fsSL https://ollama.ai/install.sh | sh

之后就静静等待安装完成即可,可能会因为网络问题中断,多试几次就可以了。

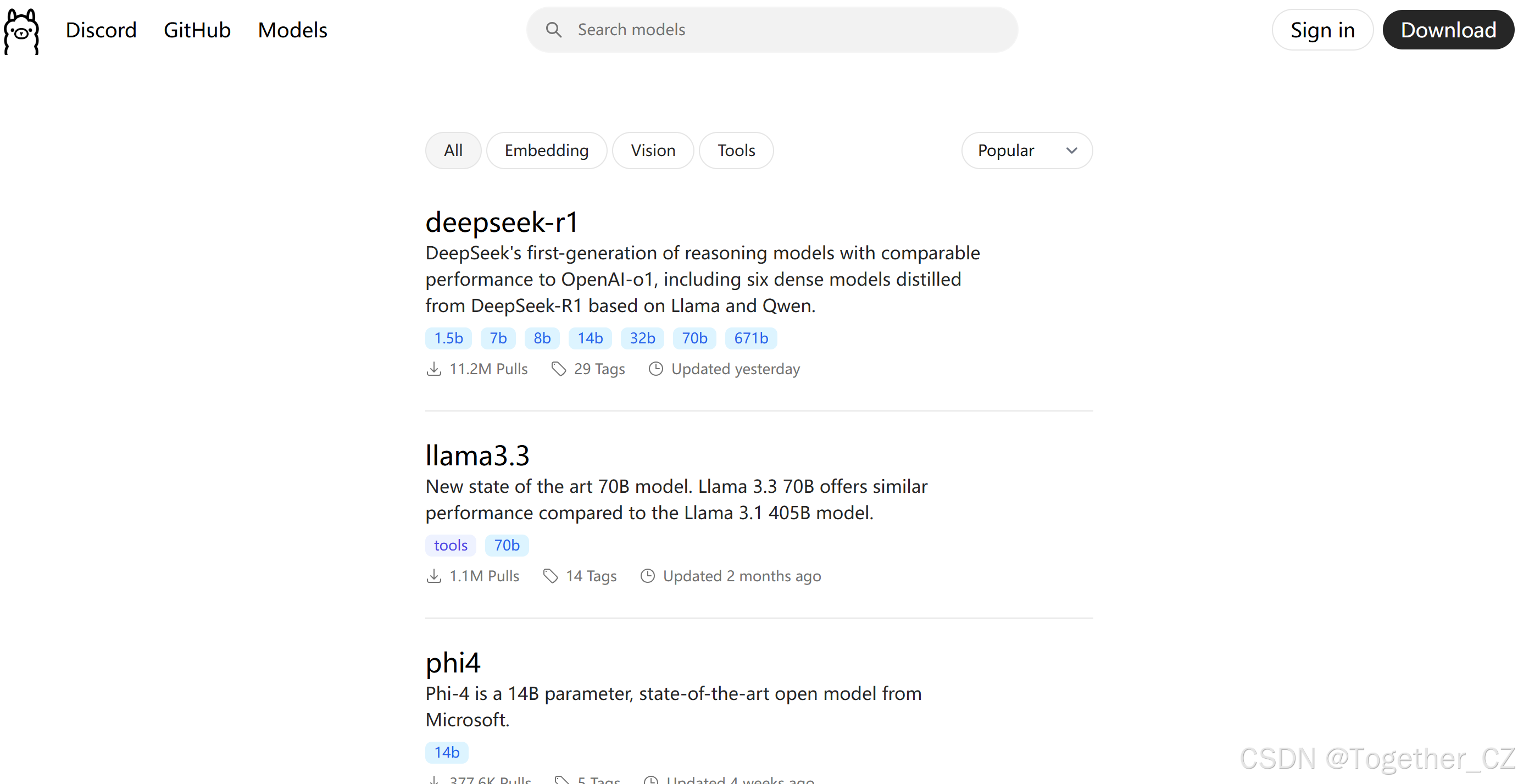

Ollama官方已经集成好支持的模型清单在这里,如下所示:

执行下面的命令便可以直接拉取Deepseek-R1全系列的模型:

# 1.5B Qwen DeepSeek R1

# 所需空间大约 1.1G

ollama pull deepseek-r1:1.5b

# 7B Qwen DeepSeek R1

# 所需空间大约 4.7G

ollama pull deepseek-r1:7b

# 8B Llama DeepSeek R1

# 所需空间大约 4.9G

ollama pull deepseek-r1:8b

# 14B Qwen DeepSeek R1

# 所需空间大约 9G

ollama pull deepseek-r1:14b

# 32B Qwen DeepSeek R1

# 所需空间大约 20G

ollama pull deepseek-r1:32b

# 70B Llama DeepSeek R1

# 所需空间大约 43G

ollama pull deepseek-r1:70b

# 671B Llama DeepSeek R1

# 所需空间大约 404G

ollama pull deepseek-r1:671b

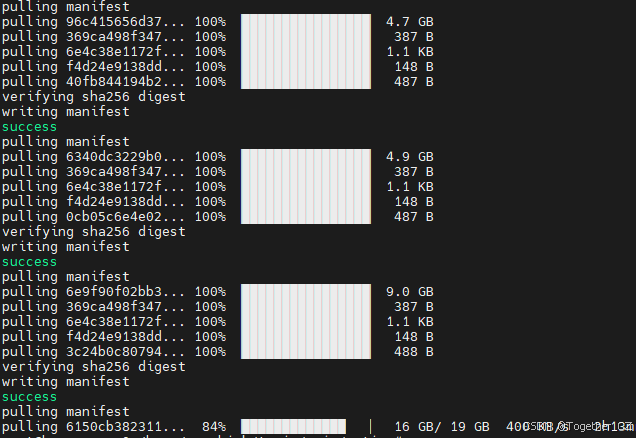

运行输出如下所示:

等待命令执行完成之后,你就已经成功下载了Deepseek-R1全系列的模型了,当然了如果你不需要这么多可以直接注释掉上面不需要的模型的pull命令即可。

完成后终端执行:

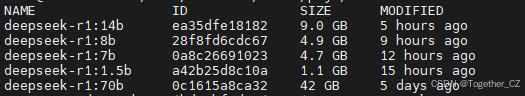

ollama list

即可查看模型清单:

如果需要运行某个模型,比如最小的deepseek-r1:1.5b模型,直接执行下面的命令:

ollama run deepseek-r1:1.5b

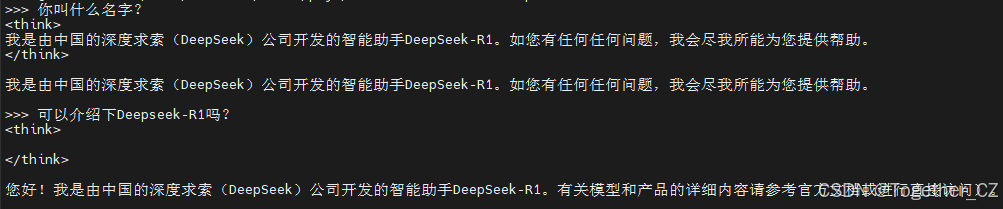

运行输出如下所示:

然后我把在官网问的问题丢给他:

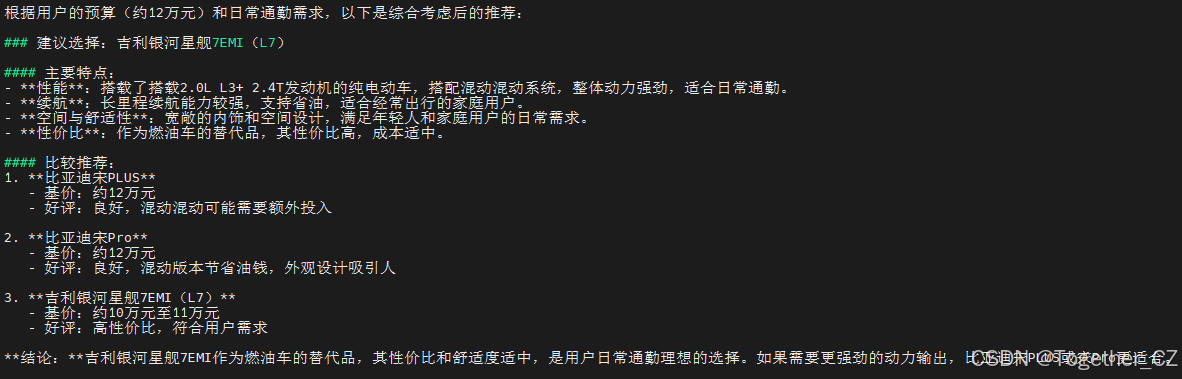

我是一名普通的上班族目前在杭州工作,想要在今年2月份购买一辆SUV汽车,主要用于日常的通勤,考虑到杭州目前燃油车摇号比较难所以考虑购买新能源汽车,因为后续会有长途需求所以当下不考虑纯电车型,目前主要是在看插电式混动PHEV相关的车型,我的预算是12W左右,目前我自己调研到的候选对象主要包括:比亚迪宋PLUS、比亚迪宋Pro、比亚迪宋L、领克06-EMP、长安UNi-Z、五菱星光S、吉利银河L7、吉利银河星舰7EMI,因为对汽车不是很了解,虽然查了很多资料但是还是没有非常清晰决定哪款车型,你是一位专业的汽车领域的分析专家,我想让你来全方位综合进行对比考虑分析,帮我参谋指导选择最优的车辆

思考过程:

<think>

好,我现在需要帮助用户从多个候选SUV中选择一辆汽车。用户的预算大约12万元左右,主要目的是日常通勤,并且考虑到未来长途需求,所以可能不希望购买纯电车型。燃油车摇号困难,因此选择了插电式

混动PHEV。

首先,我会逐一分析每个候选车型的性能、价格、续航能力和用户评价,看看它们是否符合用户的需求和预算范围。

1. **比亚迪宋PLUS**:它的动力系统是2.0L L3+ 2.4T,四驱版本还能选混动。这种纯电动车可能成本较高,但作为混动车型,可能在燃油车摇号上更好处理。价格适中,续航应该是不错的。

2. **比亚迪宋Pro**:动力是2.0L L3+ 2.4L,插电式混动版可能更省油。它的外观设计也比较吸引人,而且有 good 的评价,适合日常通勤。

3. **比亚迪宋L**:这个纯电动车的参数不错,续航应该是不错的。虽然价格在中等水平,但综合来看,性价比很高。

4. **领克06-EMP**:作为中高端SUV,它的性能和空间都很出色。外观也比较有现代感,可能在日常通勤中有优势。

5. **长安UNi-Z**:这是一台四座车型,外观设计比较年轻,符合年轻人的需求。虽然价格稍微偏高,但性能可能在同价段上更优质。

6. **五菱星光S**:作为中高端SUV,它的空间和配置都很全面。价格在合理范围内,看起来不错。

7. **吉利银河L7**:作为燃油车,续航应该比插电式混动车型差很多,可能不太适合长途驾驶,但日常通勤可以考虑。

8. **吉利银河星舰7EMI**:同样是中低档的纯电动车,续航和油耗可能还不错,适合日常出行。

接下来,我会对这些车型进行逐一分析:

– **比亚迪宋PLUS**:性价比高,但混动可能需要额外的投入,燃油车摇号也可能更复杂。

– **比亚迪宋Pro**:价格适中,混动版本节省油钱,外观好,适合日常通勤。

– **比亚迪宋L**:价格合理,续航长,适合经常出行的家庭用户。

– **领克06-EMP**:性能强,空间宽敞,性价比高,适合年轻人和家庭使用。

– **长安UNi-Z**:配置全面,舒适度高,适合喜欢年轻时尚的用户。

– **五菱星光S**:配置丰富,空间宽敞,适合注重品质的家庭用户。

– **吉利银河L7**:作为燃油车,续航一般,适合偶尔出行或有长途需求的用户,但可能成本更高。

– **吉利银河星舰7EMI**:性价比不错,适合日常出行的用户。

最后,我会综合考虑用户的预算、出行频率、家庭情况以及个人偏好。如果日常通勤需要较强的燃油性能,比亚迪宋PLUS或宋Pro可能是更好的选择;如果有更多空间和舒适感的需求,领克06-EMP可能更合适

。同时,考虑到未来长途需求,纯电动车的性价比更高,所以 recommend 5菱星舰7EMI作为备用选项。

</think>

正式回答结果如下:

到此本地的服务就已经部署好了,借助于ollama这个强有力的大模型服务工具可以非常便捷快速地完成所需大模型的私有化部署。

感兴趣的话也都可以自行动手实践下,如果显存、内存资源不足的话建议直接上这个最小的deepseek-r1:1.5b模型就可以的。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册