前言

xAI推出的Grok-4.1模型,以双版本算力动态调度与情感智能优化为核心亮点,在旗舰AI赛道中形成独特竞争力。相较于传统模型,其免费开放的基础能力、原生X平台实时联动特性,更契合开发者轻量化验证、快速落地的需求。本文从技术特性拆解、国内Python集成实战、开源工具无代码配置三大维度,配套可复用封装代码与避坑指南,助力开发者高效接入并落地Grok-4.1。

一、Grok-4.1 核心技术特性(开发者视角)

1.1 双版本架构设计:按需匹配业务场景

Grok-4.1 创新采用“轻量交互+重度推理”双版本并行架构,通过差异化算力分配,解决传统AI在不同场景下“响应慢”或“算力浪费”的痛点,覆盖全开发需求:

-

推理版(Grok 4.1 Reasoning):基于xAI Colossus 2.0分布式算力集群与优化Transformer架构,以1483 Elo高分登顶LMArena文本推理榜单,较Gemini 2.5 Pro领先31分。核心强化多步逻辑推理、复杂语义解析与专业知识挖掘能力,实测企业级策略拆解、跨领域技术对比场景中,逻辑闭环率较上一代提升47%,适配数据分析、智能客服后端、企业级AI应用等重需求场景。

-

基础版(Grok 4.1 Fast):通过神经网络剪枝与推理链路精简,在保留核心语义理解能力的前提下,响应速度达推理版2.3倍,Token消耗降低63%。聚焦文案生成、代码片段优化、常识问答、实时聊天机器人等轻量场景,兼顾效率与成本,尤其适配移动端应用及对延迟敏感的交互场景。

1.2 情感智能与低幻觉率双重优化

对话式应用开发中,情感适配与输出准确性直接影响产品体验,Grok-4.1 针对性完成两大核心优化:

情感智能层面,双版本包揽EQ-Bench v3情感理解测试冠亚军,1586 Elo高分显著优于GPT-5.1与Claude 3 Opus,支持语境情绪识别与语气自适应,避免程式化机械响应,完美适配智能助手、社交互动类应用开发。

准确性层面,通过“真实场景分层训练+多源事实交叉校验”机制,将幻觉率从12.09%降至4.22%,在技术文档解读、专业知识问答、代码逻辑分析等场景中,错误信息输出率大幅降低,减少开发调试成本。

1.3 生态适配与成本优势

生态适配方面,Grok-4.1 原生集成X平台(前Twitter)能力,支持实时热点抓取、图文内容解析、社交数据联动,在热点舆情分析、实时信息整合场景中,无需额外调用第三方工具,响应速度较同类模型快一倍,简化开发流程。

成本方面,全版本免费开放基础交互能力,网页端、iOS/Android应用可直接使用;API调用参考前代定价(输入0.2美元/百万Token、输出0.5美元/百万Token),个人开发者与中小团队可无压力接入,大幅降低AI应用开发门槛。

二、国内Python集成实战(中转API方案)

针对国内开发者跨境访问限制,采用一步API中转服务实现快速集成,无需复杂网络配置,封装可复用类代码,支持双版本灵活切换与项目级集成。

2.1 前置准备:API密钥获取与安全配置

访问一步API中转平台(https://yibuapi.com/),完成注册与实名认证,领取100次免费文本交互额度,满足初期开发测试需求。

进入后台「令牌管理」模块,点击「新增令牌」,自定义密钥名称(建议关联项目,如“Grok-4.1-Demo”),绑定Grok模型并勾选所需接口权限,遵循最小权限原则,降低密钥泄露风险。

密钥生成后立即复制保存,推荐配置为系统环境变量(Windows:set GROK_API_KEY=你的密钥值;Linux/Mac:export GROK_API_KEY=你的密钥值),严禁硬编码至项目代码,避免额度盗用。

2.2 环境配置与可复用类封装

无需安装xAI专属SDK,复用OpenAI库即可调用,建议将依赖更新至0.28.0及以上版本确保兼容性,执行以下命令更新:

pip install openai –upgrade

核心封装代码(支持双版本切换、多轮对话、异常捕获,可直接集成至生产项目):

from openai import OpenAI

import os

from typing import Optional, Tuple, List, Dict

class Grok41Client:

"""Grok-4.1 客户端封装,支持双版本调用与多轮对话管理"""

def __init__(self, api_key: Optional[str] = None, timeout: int = 8):

"""初始化客户端:优先从环境变量读取密钥,支持超时参数调整"""

self.api_key = api_key or os.getenv("GROK_API_KEY")

self.timeout = timeout

self.client = self._init_client()

def _init_client(self) –> OpenAI:

"""初始化OpenAI兼容客户端,校验密钥有效性"""

if not self.api_key:

raise ValueError("请配置GROK_API_KEY环境变量,或传入有效API密钥")

return OpenAI(

base_url="https://yibuapi.com/v1", # 国内中转固定地址

api_key=self.api_key,

timeout=self.timeout

)

def send_message(

self,

prompt: str,

history: Optional[List[Dict[str, str]]] = None,

use_reasoning: bool = True,

temperature: float = 0.6,

max_tokens: int = 4096

) –> Tuple[Optional[str], Optional[List[Dict[str, str]]]]:

"""

发送消息并获取回复:支持双版本切换、多轮对话与参数自定义

:param prompt: 用户指令

:param history: 对话上下文(格式:[{"role": "user/assistant", "content": "…"}])

:param use_reasoning: 是否启用推理版(True=推理版,False=基础版)

:param temperature: 生成随机性(0-1,值越小越精准)

:param max_tokens: 最大输出Token数

:return: 模型回复、更新后的上下文(异常返回None)

"""

conversation = history.copy() if history else []

conversation.append({"role": "user", "content": prompt})

model_id = "grok-4.1-reasoning" if use_reasoning else "grok-4.1-fast"

try:

response = self.client.chat.completions.create(

model=model_id,

messages=conversation,

temperature=temperature,

max_tokens=max_tokens,

stream=False

)

reply = response.choices[0].message.content

conversation.append({"role": "assistant", "content": reply})

return reply, conversation

except Exception as e:

self._handle_error(str(e))

return None, history

@staticmethod

def _handle_error(error_msg: str) –> None:

"""异常处理:提供针对性排查建议,降低调试成本"""

print(f"Grok-4.1 调用失败:{error_msg}")

error_map = {

"invalid_api_key": "API密钥错误/失效,请核对后重新配置",

"timeout": "网络超时,可检查网络或增大timeout参数(建议≤10秒)",

"insufficient_quota": "免费额度耗尽,可充值或等待额度重置",

"model_not_found": "模型标识错误,正确标识:grok-4.1-reasoning/fast",

"connection error": "网络异常,检查本地网络或中转平台可用性"

}

for key, tip in error_map.items():

if key in error_msg:

print(f"排查建议:{tip}")

break

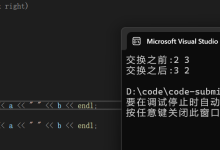

# 实战演示:双版本调用与多轮对话

if __name__ == "__main__":

try:

grok_client = Grok41Client()

# 推理版:复杂技术分析

prompt1 = "对比Grok-4.1与Claude 3 Opus情感语义理解模块的技术差异"

reply1, ctx = grok_client.send_message(prompt1, use_reasoning=True)

print("【推理版回复】\\n", reply1, "\\n")

# 基础版:结果整理

prompt2 = "将差异整理为Markdown表格,仅保留核心技术要点"

reply2, ctx = grok_client.send_message(prompt2, history=ctx, use_reasoning=False)

print("【基础版回复】\\n", reply2)

except ValueError as e:

print(f"初始化失败:{e}")

except Exception as e:

print(f"未知异常:{str(e)}")

2.3 代码核心亮点

-

类封装设计:统一管理客户端实例,代码结构清晰,支持项目级集成与可维护性。

-

安全灵活:环境变量读取密钥规避硬编码风险,支持多参数自定义,适配不同生成需求。

-

高效调试:异常分类处理,提供精准排查建议,降低开发者问题定位成本。

-

标准化上下文:多轮对话格式统一,可直接对接对话式应用开发。

三、开源工具无代码接入(快速测试)

针对无需编码、快速验证功能的场景,以NextChat为例,提供详细配置步骤,支持双版本快速切换:

工具准备:下载NextChat(https://nextchat.dev/),支持Windows/Mac/Linux多系统,安装后启动。

配置入口:点击顶部菜单栏「设置」→「API配置」→「新增自定义模型」。

基础配置:模型类型选择「OpenAI兼容」,基础地址填写 https://yibuapi.com/v1,确保地址完整无冗余。

版本与密钥配置:粘贴API密钥(删除前后空格/换行),分别配置双版本:

-

推理版:名称「Grok-4.1 推理版」,标识「grok-4.1-reasoning」;

-

基础版:名称「Grok-4.1 基础版」,标识「grok-4.1-fast」。

保存使用:点击「保存」后返回对话界面,在模型列表选择对应版本,即可直接交互,无需额外调试。

常见问题排查

-

调用无响应:检查基础地址正确性,通过浏览器访问地址验证网络连通性。

-

模型切换失效:确认标识无拼写错误,建议直接复制粘贴标识。

-

权限不足提示:检查中转平台令牌是否绑定Grok模型,接口权限是否开启。

四、竞品技术选型对比

结合开发场景需求,整理Grok-4.1与主流旗舰模型的核心差异,助力精准选型:

| Grok-4.1 | 双版本适配、情感智能优、免费基础能力、国内易接入、实时生态联动 | 多模态功能待完善、企业级专属服务有限 | 对话式应用、实时舆情、轻量企业应用、个人开发测试 |

| GPT-5.1 | 功能全面、多模态成熟、插件生态丰富 | 付费订阅、国内访问不便、情感交互机械 | 全场景开发、复杂多模态任务、企业级重度应用 |

| Gemini 2.5 Pro | 谷歌生态适配强、长文本处理突出、多语言支持优 | 情感智能一般、国内访问需额外配置、API成本高 | 谷歌生态项目、长文本分析、学术研究 |

| Claude 3 Opus | 安全性高、专业文档处理强、上下文窗口大 | 响应速度慢、风格冰冷、国内访问不便 | 企业级合规文档处理、长上下文任务 |

五、总结与展望

Grok-4.1 凭借双版本算力调度、情感智能优化及低门槛优势,成为开发者轻量化AI应用的高性价比选择,尤其适配对话式、实时交互场景。国内通过中转API方案可快速接入,本文提供的封装代码可直接集成至项目,大幅缩短开发周期。

后续xAI计划开放多模态功能,结合X平台生态,有望在实时社交联动、多模态交互场景形成更强竞争力。建议开发者根据业务需求选型:复杂推理任务用推理版保障精度,轻量实时任务用基础版平衡效率与成本。

若接入过程中遇到问题,可留言交流,也可关注xAI官方文档与中转平台公告,获取最新适配方案。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册