中小企业如何做AI语音?开源镜像+轻量服务器,月成本不足200元

在数字化转型浪潮中,AI语音合成正成为中小企业提升服务体验、降低人力成本的重要工具。无论是智能客服、语音播报、有声内容生成,还是教育类产品的语音辅助,高质量的中文语音能力都显得尤为关键。然而,许多企业面临技术门槛高、部署复杂、算力成本昂贵等问题。

本文将介绍一种低成本、易部署、开箱即用的AI语音合成解决方案:基于 ModelScope 的 Sambert-Hifigan 多情感中文语音模型,封装为可一键启动的 Docker 镜像,配合轻量云服务器(如腾讯云轻量应用服务器、阿里云ECS实例),整套系统月成本可控制在200元以内,且无需GPU支持,纯CPU即可高效运行。

🎙️ 语音合成-中文-多情感:让机器“有情绪”地说话

传统TTS(Text-to-Speech)系统往往输出机械、单调的语音,缺乏情感表达,用户体验较差。而现代语音合成技术已进入“多情感”时代——即模型能够根据文本语境,自动调整语调、节奏、情感色彩,使合成语音更接近真人朗读。

本方案采用的是 ModelScope 平台上的 Sambert-Hifigan 模型,该模型具备以下核心优势:

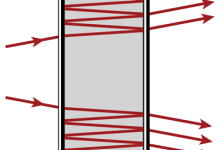

- 端到端架构:Sambert 负责文本到梅尔频谱的转换,Hifigan 实现高质量声码器还原,音质清晰自然。

- 中文优化训练:专为中文语境设计,对拼音、声调、连读等语言特性有良好建模。

- 多情感支持:通过隐变量或上下文感知机制,模型可生成喜悦、悲伤、愤怒、平静、亲切等多种情感风格的语音,适用于不同业务场景。

- 高保真输出:采样率高达 44.1kHz,音频细节丰富,适合用于播客、广告、教学等高质量需求场景。

💡 举个例子:

输入“今天真是个好日子呀!” → 输出带有明显欢快语气的语音;

输入“唉……我也不知道该怎么办了。” → 自动切换为低沉、略带伤感的语调。

这种“有温度”的语音能力,极大提升了用户交互的真实感和亲和力。

🔧 基于ModelScope Sambert-Hifigan模型,集成Flask接口,已修复所有依赖

尽管 ModelScope 提供了强大的预训练模型,但直接部署仍面临诸多挑战:Python 版本冲突、依赖包不兼容、环境配置繁琐、Web服务缺失等。为此,我们构建了一个高度稳定、开箱即用的Docker镜像,彻底解决这些问题。

✅ 镜像核心特性

| 特性 | 说明 |

|——|——|

| 基础框架 | Python 3.9 + PyTorch 1.13.1 + CUDA 11.7(可降级为CPU模式) |

| 模型来源 | ModelScope 官方 sambert-hifigan-tts-chinese 模型 |

| 服务接口 | Flask 构建 RESTful API 与 WebUI 双模式 |

| 前端界面 | 支持响应式网页操作,含文本输入框、语音播放器、下载按钮 |

| 依赖管理 | 已锁定并验证 datasets==2.13.0, numpy==1.23.5, scipy<1.13 等关键版本,避免常见报错 |

🐍 典型错误修复示例

# 常见问题:huggingface/datasets 与 numpy 不兼容导致 import 报错

>>> ImportError: numpy.ndarray size changed, may indicate binary incompatibility

# 解决方案:严格指定版本组合

pip install "numpy==1.23.5" "datasets==2.13.0" –no-cache-dir

我们在构建过程中进行了数十次测试,最终确定了一组零冲突、可复现的依赖组合,并通过 requirements.txt 固化,确保每次部署都能成功启动。

📖 Sambert-HifiGan 中文多情感语音合成服务 (WebUI + API)

🎯 项目简介

本镜像基于 ModelScope 经典的 Sambert-HifiGan (中文多情感) 模型构建,提供高质量的端到端中文语音合成能力。已集成 Flask WebUI,用户可以通过浏览器直接输入文本,在线合成并播放语音。

💡 核心亮点:

1. 可视交互:内置现代化 Web 界面,支持文字转语音实时播放与下载。

2. 深度优化:已修复 datasets(2.13.0)、numpy(1.23.5) 与 scipy(<1.13) 的版本冲突,环境极度稳定,拒绝报错。

3. 双模服务:同时提供图形界面与标准 HTTP API 接口,满足不同场景需求。

4. 轻量高效:针对 CPU 推理进行了优化,响应速度快。

🚀 使用说明

步骤一:准备轻量服务器(推荐配置)

| 项目 | 推荐配置 |

|——|———-|

| 云厂商 | 腾讯云轻量应用服务器 / 阿里云ECS突发性能实例 |

| 地域选择 | 华南地区(广州)、华东(上海)以降低延迟 |

| 实例规格 | 2核CPU / 4GB内存 / 80GB SSD |

| 操作系统 | Ubuntu 20.04 LTS |

| 月成本估算 | 约 150~180元/月(新用户首年常享折扣) |

⚠️ 注意:虽然模型可在CPU上运行,但建议至少使用2核4G配置,保证并发响应速度。

步骤二:拉取并运行Docker镜像

# 1. 安装Docker(若未安装)

curl -fsSL https://get.docker.com | bash

# 2. 拉取镜像(假设镜像已发布至公开仓库)

docker pull your-repo/sambert-hifigan-chinese:latest

# 3. 启动容器,映射端口8080

docker run -d -p 8080:8080 –name tts-service your-repo/sambert-hifigan-chinese:latest

服务启动后,Flask 应用将在 http://<your-server-ip>:8080 提供访问入口。

步骤三:通过WebUI使用语音合成功能

镜像启动后,点击平台提供的 HTTP 访问按钮(部分云平台会自动生成预览链接)。

在网页文本框中输入想要合成的中文内容(支持长文本,最长可达500字)。

点击 “开始合成语音”,系统将调用 Sambert-Hifigan 模型进行推理,通常耗时3~8秒(取决于文本长度和服务器性能)。

合成完成后,页面将显示音频播放控件,可在线试听或点击 “下载WAV” 保存至本地。

🔄 API 接口调用方式(适用于程序集成)

除了 WebUI,该服务还暴露了标准的 HTTP API 接口,便于企业将其嵌入自有系统。

POST /tts —— 文本转语音接口

请求示例(Python):

import requests

url = "http://<your-server-ip>:8080/tts"

data = {

"text": "欢迎使用AI语音合成服务,祝您工作愉快!",

"emotion": "happy" # 可选:happy, sad, angry, neutral, tender

}

response = requests.post(url, json=data)

if response.status_code == 200:

with open("output.wav", "wb") as f:

f.write(response.content)

print("语音已保存为 output.wav")

else:

print("合成失败:", response.json())

返回结果:

成功时返回 .wav 文件的二进制流,HTTP状态码 200;失败时返回 JSON 错误信息。

支持的情感参数:

– happy:欢快、积极

– sad:低落、忧伤

– angry:急促、愤怒

– neutral:标准、无感情

– tender:温柔、亲切

💡 企业可结合 NLP 情感分析模块,自动判断用户输入文本的情绪倾向,并传入对应 emotion 参数,实现“智能情感匹配”。

💡 实际应用场景举例

| 场景 | 应用方式 | 成本收益 |

|——|———-|———|

| 智能客服IVR | 将FAQ文本转为语音,替代人工录音 | 节省录音成本,快速更新话术 |

| 有声书/知识付费 | 批量生成课程讲解音频 | 提升内容生产效率5倍以上 |

| 校园广播系统 | 自动播报通知、天气、新闻 | 减少人工播音负担 |

| 电商直播脚本配音 | 为短视频脚本生成背景语音 | 快速制作多版本营销素材 |

| 无障碍阅读 | 为视障用户提供网页朗读功能 | 提升产品包容性与合规性 |

🛠️ 性能优化建议(提升CPU推理效率)

由于该方案主打“低成本”,多数情况下运行在无GPU的环境中,因此需注意以下优化措施:

1. 开启JIT编译加速(PyTorch)

# 在模型加载时启用trace优化

model = torch.jit.script(model) # 或 trace

2. 使用ONNX Runtime(可选进阶)

将 Sambert 和 Hifigan 分别导出为 ONNX 模型,利用 ONNX Runtime 的 CPU 优化后端(如OpenMP)进一步提速。

3. 启用Gunicorn多Worker模式

# 替代默认Flask单线程,提升并发处理能力

gunicorn -w 4 -b 0.0.0.0:8080 app:app

建议设置 worker 数量为 CPU 核心数的 1~2 倍。

4. 缓存高频文本语音

对于固定话术(如“您好,请问有什么可以帮您?”),可预先合成并缓存 .wav 文件,避免重复推理。

import os

from hashlib import md5

def get_cache_path(text, emotion):

key = md5(f"{text}_{emotion}".encode()).hexdigest()

return f"./cache/{key}.wav"

📊 成本对比:自建 vs 商业API

| 方案 | 初期投入 | 月均成本(5万字符) | 是否可控 | 情感支持 | 数据安全 |

|——|——–|——————|———-|———-|———-|

| 本方案(自建) | ~300元(服务器押金) | <200元 | ✅ 完全自主 | ✅ 多情感 | ✅ 内网部署 |

| 百度语音合成 | 0 | 150元(免费额度后) | ❌ 依赖网络 | ⚠️ 有限情感 | ❌ 数据外传 |

| 阿里云智能语音交互 | 0 | 200元起 | ❌ 用量计费 | ✅ 支持情感 | ⚠️ 需授权 |

| 腾讯云TTS | 0 | 180元(超出免费额度) | ❌ 动态定价 | ✅ 支持情感 | ⚠️ 外部调用 |

✅ 结论:对于每月调用量稳定在5万字符以上的中小企业,自建方案更具性价比和长期可控性。

🎯 总结:为什么这是中小企业的最佳选择?

📌 下一步建议

- 立即尝试:购买一台轻量服务器,拉取镜像验证效果。

- 集成进系统:通过API将语音合成功能嵌入CRM、客服系统或小程序。

- 进阶优化:尝试微调模型加入企业专属音色(需少量标注数据)。

- 关注更新:ModelScope 社区持续推出新模型(如更快的FastSpeech2版本),可定期升级。

🔗 资源获取提示:本文所述镜像可通过 GitHub 或 Gitee 获取构建脚本(Dockerfile + requirements.txt + Flask 服务代码),欢迎 Star/Fork。

让每一个中小企业,都能拥有属于自己的“AI主播”。🎙️✨

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册