训练一个机器学习模型时,我们常常会陷入这样的困境:调整学习率时,从 0.01 调到 0.001,模型准确率突然提升;再试 0.0005,效果又下降了。这就像在黑暗中摸索开关,不知道哪个位置能恰好点亮房间。超参数调优,这个被称为 “机器学习炼金术” 的过程,曾让研究者耗费大量时间在无规律的尝试中。而贝叶斯优化的出现,就像给这个黑暗房间装上了智能导航,它能根据过往经验不断修正方向,高效找到最优解。

一、贝叶斯优化的核心逻辑

传统的超参数调优方法,本质上是 “盲人摸象”。网格搜索会机械地遍历预设的参数组合,比如把学习率、树深度等参数分成若干档次,逐一尝试所有可能。这种方法的缺点显而易见:如果参数维度增加,计算量会呈指数级增长,比如 3 个参数各分 10 档,就有 1000 种组合,即使是简单模型也可能耗尽计算资源。随机搜索则是随机挑选参数组合,虽然比网格搜索灵活,但依然是 “碰运气”,可能在无效区域浪费大量时间。

贝叶斯优化则完全不同,它是一种 “有记忆的搜索”。其核心思想源自贝叶斯定理:根据已有的实验结果,不断更新对参数空间的认知,再基于新认知选择下一个最值得尝试的参数。就像登山时,我们会根据之前的脚印判断哪里可能有陡坡,哪里可能是捷径,而不是盲目地向各个方向乱闯。

具体来说,贝叶斯优化由两个关键部分组成:

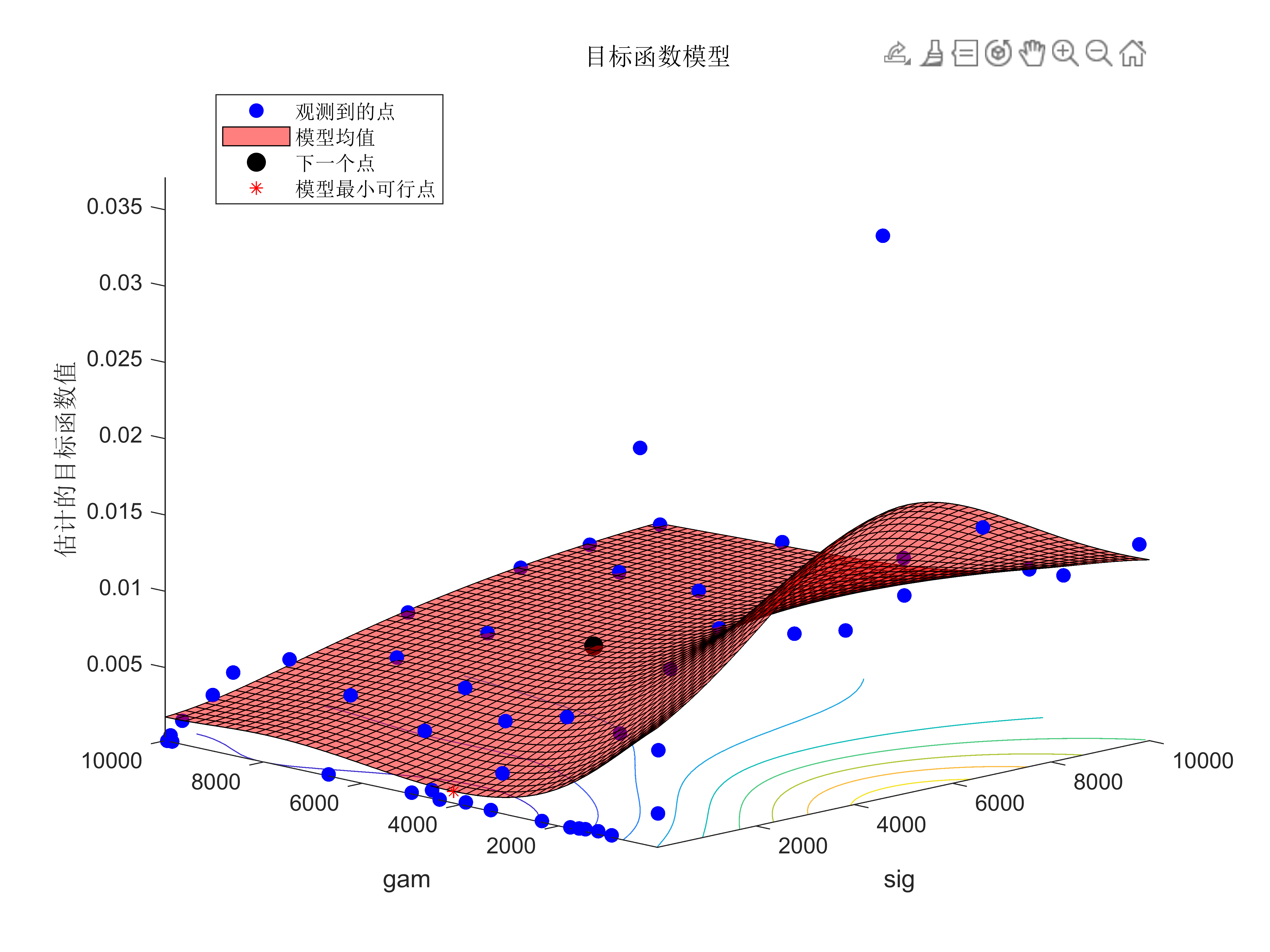

- 概率模型( surrogate model ):用一个概率模型(通常是高斯过程)拟合参数与模型性能之间的关系。比如通过已有的 5 组学习率和对应的准确率数据,模型会生成一条带 “不确定性” 的曲线 —— 曲线高度表示预测准确率,曲线周围的阴影宽度表示预测的不确定程度。

- 采集函数( acquisition function ):基于概率模型,决定下一个要尝试的参数。它会在 “探索” 和 “利用” 之间寻找平衡:“利用” 是指在当前已知的最优参数附近进一步细化搜索;“探索” 是指去那些预测不确定性高的区域尝试,可能会发现更优解。比如当某个参数区间的预测准确率中等但不确定性很大时,采集函数可能会优先选择这里,避免错过潜在的最优解。

这种 “预测 – 决策 – 更新” 的循环,让贝叶斯优化能在有限的实验次数内,快速聚焦到最优参数区域,大幅减少无效尝试。

二、超参数调优实战

为了更直观地理解贝叶斯优化的优势,我们以一个随机森林模型的调优为例,对比它与网格搜索、随机搜索的表现。需要优化的超参数包括:

- 树的数量(n_estimators):50-500 之间的整数

- 树的最大深度(max_depth):10-100 之间的整数

- 分裂时考虑的最大特征数(max_features):“sqrt”“log2” 或 “None”

1. 网格搜索:地毯式轰炸的低效

网格搜索会将每个参数均匀划分档位,比如 n_estimators 取 50、100、200、300、500;max_depth 取 10、30、50、70、100;再加上 3 个 max_features 选项,总共 5×5×3=75 组参数。它会逐一训练这 75 个模型,最后选择准确率最高的组合。

这种方法的优点是 “不遗漏”,但缺点是 “太冗余”。比如当 n_estimators 超过 200 后,模型性能提升已不明显,但网格搜索依然会机械地尝试 300 和 500,浪费大量计算时间。在实际场景中,若参数维度增加到 5 个以上,网格搜索几乎无法在合理时间内完成。

2. 随机搜索:运气主导的赌博

随机搜索会从参数空间中随机抽取 75 组参数(与网格搜索尝试次数相同)。由于不需要遍历所有组合,它能覆盖更广泛的参数范围,有时能比网格搜索更快找到较优解。但随机性也意味着风险:如果随机选中的参数大多集中在性能较差的区域,可能需要更多尝试才能接近最优解。

比如在上述例子中,随机搜索可能连续 10 次选中 max_depth=100 的参数,但实际上这个深度会导致模型过拟合,准确率始终偏低。这种情况下,它的效率甚至可能不如网格搜索。

3. 贝叶斯优化:有策略的精准打击

贝叶斯优化的过程则像一个 “智能试错” 的过程:

- 初始阶段,它会随机尝试 5 组参数,作为初始数据。

- 用高斯过程拟合这 5 组数据,生成参数与准确率的概率分布 —— 比如发现当 n_estimators 在 200 左右、max_depth 在 30-50 之间时,准确率有上升趋势,但不确定性较高。

- 采集函数会优先选择 “预测准确率高且不确定性大” 的区域,比如 n_estimators=250、max_depth=40 这个点。

- 训练该参数组合后,将结果反馈给概率模型,更新分布。此时模型可能发现 max_depth=40 时准确率显著提升,于是接下来会在这个深度附近细化搜索,同时适当探索 n_estimators 的其他取值。

经过 20 次尝试后,贝叶斯优化通常就能接近最优解,而网格搜索和随机搜索可能需要 50 次以上才能达到类似效果。在计算资源有限的情况下,这种效率优势尤为明显 —— 比如用普通笔记本电脑调优一个深度学习模型,贝叶斯优化可能只需 1 天,而网格搜索可能需要 1 周。

三、贝叶斯优化的适用边界与扩展

贝叶斯优化并非万能钥匙,它的优势在 “高代价实验” 场景中最为突出。这里的 “高代价” 可能是时间(如训练一个 BERT 模型需要几小时)、金钱(如工业生产中的参数调试)或资源(如自动驾驶的实车测试)。相反,对于训练时间极短的简单模型(如线性回归),网格搜索可能更直接 —— 毕竟设置几个参数组合的时间,可能比启动贝叶斯优化的框架还短。

此外,贝叶斯优化的性能依赖于概率模型的拟合能力。当参数空间维度极高(如超过 20 维)时,高斯过程的拟合精度会下降,此时需要结合降维技术或使用更复杂的概率模型(如随机森林作为替代模型)。同时,它对 “噪声” 比较敏感 —— 如果模型性能评估存在随机波动(如每次训练的准确率差异较大),可能需要多次重复实验以减少噪声影响。

近年来,贝叶斯优化的应用早已超越超参数调优。在药物研发中,它能高效寻找最优的分子结构组合;在能源领域,它可优化风力发电机的叶片角度以提高发电效率;甚至在日常生活中,智能烤箱通过贝叶斯优化自动调整温度和时间,实现不同食材的最佳烹饪效果。

最后小结

贝叶斯优化的真正价值,在于它改变了我们与参数空间的交互方式。网格搜索和随机搜索把参数空间视为 “未知的荒漠”,只能通过蛮力开拓;而贝叶斯优化则把它当作 “可探索的地图”,每一步行动都基于对地图的认知升级。这种从 “盲目试错” 到 “理性预测” 的转变,正是人工智能从 “执行工具” 向 “决策助手” 进化的缩影。

对于机器学习研究者而言,贝叶斯优化能解放大量调参时间,让精力集中在算法设计而非参数微调;对于普通用户,它隐藏了复杂的优化过程,让智能系统能自动适配不同场景 —— 比如手机相机根据光线条件自动优化 ISO 和快门参数,背后可能就有贝叶斯优化的影子。

当我们不再需要为 “学习率设 0.01 还是 0.001” 而纠结,当模型能自主找到最优配置时,或许才能真正体会到:人工智能的终极目标,不是让机器模仿人类的思考,而是让机器帮人类摆脱重复的探索,聚焦更有创造性的工作。贝叶斯优化,正是这个过程中不可或缺的 “智能导航”。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册