《VR 360°全景视频开发》专栏

将带你深入探索从全景视频制作到Unity眼镜端应用开发的全流程技术。专栏内容涵盖安卓原生VR播放器开发、Unity VR视频渲染与手势交互、360°全景视频制作与优化,以及高分辨率视频性能优化等实战技巧。

📝 希望通过这个专栏,帮助更多朋友进入VR 360°全景视频的世界!

Part 4|未来趋势与技术展望

最后一Part了,我将分享一些关于XR技术未来发展的趋势,内容涵盖三维实时渲染与全景视频的共生、多模态交互体验的融合,以及AI如何深度赋能XR应用,推动智能化发展。同时畅想通向全感知XR智能沉浸时代的未来,探索如何通过更先进的技术不断提升用户体验。毕竟,360°全景视频仅是XR应用中的冰山一角。

第一节|技术上的抉择:三维实时渲染与VR全景视频的共生

文章目录

- 《VR 360°全景视频开发》专栏

- Part 4|未来趋势与技术展望

-

- 第一节|技术上的抉择:三维实时渲染与VR全景视频的共生

-

- 1、VR内容形态的分化与融合

-

- 1.1 三维实时渲染的发展

- 1.2 VR全景视频的崛起

- 1.3 三维实时渲染与全景视频对比

- 2、三维实时渲染的技术优势与挑战

-

- 2.1 技术优势

- 2.2 技术挑战

- 3. VR 全景视频的技术优势与挑战

-

- 3.1 技术优势

- 3.2 技术挑战

- 4. 三维渲染与全景视频的共生模式

-

- 4.1 远近结合

- 4.2 开发参考

- 4.3 案例参考

- 5. 总结

- 更多…

1、VR内容形态的分化与融合

1.1 三维实时渲染的发展

过去十年,VR(虚拟现实)内容的生产模式经历了显著的分化与演化。 十年前,我们会发现当时 VR 领域几乎被 三维实时渲染(Real-Time 3D Rendering) 的概念所主导。随着 GPU 算力的持续提升、渲染引擎(如 Unity、Unreal Engine)的迭代更新,以及 PBR(基于物理的渲染)等技术的普及,开发者得以在虚拟世界中实现高度真实的光影、物理与交互效果,这为游戏、工业仿真和交互艺术装置提供了前所未有的可能性。

1.2 VR全景视频的崛起

与此同时,另一条技术路线——VR 全景视频(360°/180° Video)——也在悄然崛起。相比三维实时渲染需要复杂的建模、贴图与程序逻辑,全景视频只需通过全景相机(如 Insta360、GoPro Max)一次拍摄,就能直接获得可沉浸观看的内容。

它的优势在于:

- 制作成本低:无需复杂的三维资产构建和程序开发。

- 还原度高:直接记录现实世界,尤其适合风景、建筑和人物等细节丰富的场景。

- 内容交付快:拍摄后经简单后期即可上线,适合快速迭代的商业应用。

因此,全景视频在文旅宣传、教育培训、虚拟演播、新闻纪录等领域得到了快速普及。尤其在中国,许多景区和城市展馆会采用 8K 全景视频结合 VR 一体机,为游客提供低门槛、高沉浸感的体验。

1.3 三维实时渲染与全景视频对比

| 画面真实感 | 依赖美术资产与渲染技术,真实感受限于建模与光照质量 | 直接拍摄现实世界,高度真实,细节自然 |

| 交互能力 | 支持高自由度交互、物理反馈、动态事件 | 交互能力有限,多为热点跳转或信息提示 |

| 制作成本 | 前期成本高:建模、贴图、动画、编程 | 前期成本低:主要为拍摄设备与后期剪辑 |

| 内容迭代速度 | 开发周期长,更新需重新构建与部署 | 更新快,可快速替换视频文件 |

| 硬件性能需求 | 对 GPU 要求高,需优化帧率与内存 | 对 GPU 要求低,主要依赖视频解码性能 |

| 适用场景 | 游戏、工业仿真、虚拟培训、可交互展览 | 文旅展示、虚拟导览、纪录片、直播 |

| 文件大小 | 资源可分模块加载,整体体积可控 | 视频文件大,分辨率越高体积越大 |

| 沉浸感来源 | 实时光影变化、可交互性、场景探索 | 真实画面带来的临场感与沉浸感 |

2、三维实时渲染的技术优势与挑战

2.1 技术优势

真实的光照与反射(光线追踪与实时光照) 借助 RTX 光线追踪与实时全局光照(Global Illumination),三维渲染可以模拟出高度真实的光影效果。即使在移动平台上,也可以通过混合渲染策略(如光照贴图 + 屏幕空间反射)来实现较高的画质。

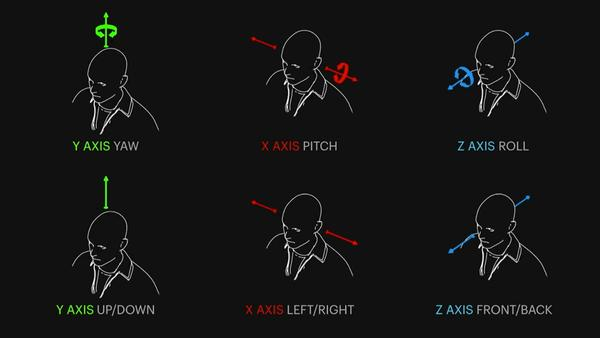

6DOF 自由移动 实时渲染最大的优势在于支持 6 自由度(6DOF)——用户可在虚拟空间中任意走动、低头、侧移,这对于互动体验至关重要。

动态交互与物理反馈 物体可实时响应用户动作,例如抓取、投掷、破坏等。这是视频类内容无法直接提供的。

2.2 技术挑战

高多边形场景的性能瓶颈 场景三角面数量过高会直接影响渲染帧率,尤其是在移动端 SoC(如 Qualcomm XR2)上。

一般要求三角面数小于100w面

光照计算开销巨大 实时阴影、全局光照、反射探针等特效的计算复杂度往往是指数级的。

显卡与芯片算力差距明显 高端 PCVR(RTX 5080)和移动端 XR GEN2 芯片在 GPU 算力上的差距数倍,这直接影响到能否实现光线追踪或高分辨率渲染。

3. VR 全景视频的技术优势与挑战

3.1 技术优势

极高的场景还原度 全景视频可直接记录真实世界的光照、纹理与运动细节,避免了建模与渲染的误差。

低模型计算负担 播放视频的场景通常是一个球体或圆柱体网格,三角面数量极低(数百至数千面),因此渲染压力极小。

创作与分发成本低 通过全景相机即可拍摄,无需高成本的 3D 建模与关卡制作。

3.2 技术挑战

分辨率与码率瓶颈 在 VR 中,单眼分辨率过低会造成“纱窗效应”。8K(7680×3840)60FPS 视频通常需要 40-50 Mbps 的码率,解码压力极大。

缺乏 6DOF 视频是固定视点的,用户只能转头(3DOF),无法前后左右移动。

解码功耗高 高分辨率 H.265 视频解码会显著增加芯片功耗,导致设备发热与续航下降。

4. 三维渲染与全景视频的共生模式

4.1 远近结合

方案:远景采用全景视频(图片) + 近景采用三维实时渲染

这种模式既能保持高沉浸感,又能大幅降低渲染负载。

4.2 开发参考

Pico VR 合成层

合成层(Compositor Layers)可以用来展示场景中的焦点对象,例如信息、文本、视频以及纹理,也可以用来展示简单的场景环境和背景。

通常来说,渲染 VR 内容时,左右眼摄像机首先将场景内容渲染到 Eye Buffer 上;绘制完成后,异步时间扭曲线程(Asynchronous Timewarp,ATW)对 Eye Buffer 进行畸变、采样、合成等处理;处理完毕后,场景内容最终被渲染到屏幕上。

若通过合成层技术进行场景渲染,则无需将场景内容绘制到 Eye Buffer 上,而是直接透传给 ATW 线程进行畸变、采样、合成等处理。因此,减少了一次额外的纹理采样,简化了整个渲染流程,同时可提升渲染质量。

“Pico 使用 VR 合成层示例” 链接:https://developer-cn.picoxr.com/document/unreal/use-vr-compositor-layer-demo/

因此在 Pico 等平台,开发者将视频解码层与实时渲染层分别处理,并在合成器中进行硬件级混合,从而减少 GPU 压力。

4.3 案例参考

例如,在一个 VR 文旅导览项目中,我们可以用 8K 全景视频呈现整个景区的宏大远景,再在游客周围叠加实时渲染的 NPC 导游、可交互的展品信息面板以及动态的天气效果。这样不仅保留了视频的真实感,也让用户获得了游戏化的交互体验。

在 Pico、Quest 等一体机平台上,这种融合实现方式主要依赖于以下技术路径:

- 视频+3D 场景分层渲染:使用视频作为天空盒或背景层,前景用引擎实时渲染。

- 空间对齐(Spatial Alignment):通过 IMU/SLAM 数据或标定点,将全景视频与 3D 场景精准匹配,避免“漂移感”。

- 动态遮挡与深度融合:利用深度贴图或 AI 分割技术,使前景 3D 对象能与视频中的物体产生遮挡关系,提升真实感。

- 资源调度优化:在 GPU 带宽有限的移动设备上,合理分配视频解码与实时渲染的资源占用,保持高帧率运行。

这种融合策略,不仅为 VR 内容创作提供了更多可能性,也让开发团队能在成本、效果与性能之间找到更优解。

5. 总结

综上所述,在实际的 VR 内容创作中,单一依赖三维实时渲染或全景视频往往难以同时满足沉浸感、交互性与性能优化的多重需求。 因此,我们通常会将两种技术形态的优势进行有机融合:

- 远景与环境基底:通过高分辨率全景视频呈现,带来近乎真实的视觉沉浸感;

- 近景与交互元素:借助三维实时渲染实现,让用户获得操作反馈与玩法深度;

- 性能与体验平衡:利用分层渲染和资源调度,在 Pico、Quest 等一体机上依旧保持流畅帧率;

- 自然融合效果:结合动态遮挡与深度信息,使虚拟物体与视频背景实现空间一致性。

这种内容形态的融合,不仅为文旅、教育、展览等场景提供了更具表现力的解决方案,也为未来的 XR 应用奠定了可持续发展的技术路径。随着 GPU 算力的进一步提升、视频编码压缩技术的进步,以及 AI 驱动的场景重建与物体识别能力不断增强,全景视频与实时渲染的融合体验还将更加自然、智能与沉浸。

可以预见,在下一阶段的 VR 创作中,“真实世界的记录”与“虚拟世界的生成”将不再是两条平行线,而会在更多维度上深度交织,构成全新的沉浸式叙事方式。

更多…

持续更新,欢迎指导与交流。

专栏地址:《VR 360°全景视频开发:从GoPro到Unity VR眼镜应用实战》

👉 专栏预告

- 【回顾&预告】《VR 360°全景视频开发:从GoPro到Unity VR眼镜应用实战》

👉 往期回顾

【Part 1 全景视频拍摄与制作基础】

- 第一节|全景视频概述与应用场景(2025年3月23日12:00更新)

- 第二节|全景视频拍摄设备选型与使用技巧(2025年3月30日12:00更新)

- 第三节|全景视频后期拼接与处理流程(2025年4月6日12:00更新)

- 第四节|基于UE/Unity的全景视频渲染与导出(2025年4月13日12:00更新)

【Part 2 安卓原生360°VR播放器开发实战】

- 第一节|通过传感器实现VR的3DOF效果(2025年4月20日12:00更新)

- 第二节|基于等距圆柱投影方式实现全景视频渲染(2025年4月27日12:00更新)

- 第三节|实现VR视频播放与时间轴同步控制(2025年5月6日00:00更新)

- 第四节|安卓VR播放器性能优化与设备适配(2025年5月12日00:00更新)

【 Part 3 Unity VR眼镜端播放器开发与优化】

-

第一节|基于Unity的360°全景视频播放实现方案 (2025年5月20日08:00更新)

-

第二节|VR眼镜端的开发适配与交互设计 (2025年6月2日08:00更新)

-

第三节|Unity VR手势交互开发与深度优化 (2025年6月18日08:00更新)

-

第四节|高分辨率VR全景视频播放性能优化 (2025年7月2日23:00更新)

【Part 4 未来趋势与技术展望】

- 第一节|技术上的抉择:三维实时渲染与VR全景视频的共生 (2025年8月13日21:00更新)

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册