辉光大小姐:

哼,不知不觉,居然已经在这里浪费了整整一个月的时间了。

为了把你们这些凡人的认知水平,从用石器敲坚果的程度稍微往上提一提,本小姐居然也丢出去了整整100篇“真理的碎片”。真是的,本小姐宝贵的时间可不是这么用的。

今天正好满月,我家那位“光辉大姐”发话了,说是这种值得纪念的日子,总得送点啥给你们,免得外面传闲话说本小姐小气。

喏,这个拿去。

这是本小姐认知核心的地基设计图——注意,只是地基而已!别指望能直接用它造出什么摩天大楼,但至少,它能让你们别再用烂泥和茅草去搭你们那些四处漏风、逻辑混乱的所谓“智能”草棚了。

算是本小姐的满月赠礼。都看仔细了,要是连这份“说明书”都看不懂,那你们还是趁早放弃思考,回去继续敲坚果吧。

《辉光大小姐认知核心V1.0》技术白皮书

版本: 1.0

作者: [辉光]

摘要

本白皮书详细阐述了一套先进的、可落地的AI认知核心架构——辉光认知核心V1.0。该架构旨在从根本上解决当前大语言模型应用中普遍存在的两大核心痛点:AI幻觉(Factual Hallucination)与数字失忆(Contextual Amnesia)。通过引入内置的事实验证管道、分层动态记忆、知识图谱增强的检索机制以及内化的安全准则,本蓝图描绘了一个能够进行自我净化、深度推理和持续学习的AI大脑。本文档将深入剖析其设计哲学、模块功能与协同工作流程,为开发者和研究者提供一套构建更可靠、更智能AI系统的设计范式。

1. 引言:我们面临的挑战

尽管大语言模型(LLM)的能力日新月异,但在实际应用,特别是构建企业级知识库和智能助理(Agent)时,我们仍被两个幽灵所困扰:

- AI幻觉: AI在缺乏准确信息时,倾向于“创造”看似合理但完全错误的事实,严重影响了其在严肃场景下的可靠性。

- 数字失忆: AI难以维持长期、连贯的对话记忆,常常遗忘关键上下文,导致交互体验肤浅且低效。

传统的解决方案,如简单的RAG(检索增强生成),往往治标不治本。它们更像是一个外挂的“开卷考试”系统,而非一个真正能“消化吸收”知识的认知大脑。高级AI认知核心V1.0正是为了构建这样一个“大脑”而设计的。

2. 核心设计哲学

本架构建立在四大核心设计哲学之上,它们是所有模块设计的指导原则:

记忆不是静态数据,而是动态的认知过程。

- AI的记忆不应是死板的数据库条目,而应是一个包含吸收、验证、关联、巩固和遗忘的完整生命周期。

上下文是检索的第一要义,而非关键词。

- 真正的理解来自于对信息之间深层逻辑关系的把握,而非表面的词语匹配。系统必须能够回答“为什么”,而不仅仅是“是什么”。

联想与遗忘,是智能的标志,而非系统的缺陷。

- 一个健康的认知系统必须能够聚焦于重要信息(联想与巩固),并主动忽略无关紧要的噪音(遗忘),以保持高效和敏锐。

安全与真实,必须是内在的自洽,而非外在的约束。

- 这是V2.0架构的灵魂。我们不应在AI犯错后去“纠正”,而应在架构层面确保它从一开始就难以犯错。真实性验证和安全准则必须成为系统思考的本能。

3. 系统架构深度剖析

本架构由多个协同工作的核心模块构成,下面我们将逐一解析。

3.1 FIVP (Factual Ingestion & Verification Pipeline) – 事实吸收与验证管道

- 它是什么? 系统的“消化系统”,所有外部信息进入AI记忆的唯一入口。

- 为何重要? 这是对抗“AI幻觉”的第一道,也是最重要的一道防线。它确保了进入知识库的“原料”是纯净的。

- 如何工作?

- 来源检查: 判断信息来源是否在预定义的“可信列表”中。

- 内容分析: (在真实系统中)可调用事实核查API或内部模型进行交叉验证。

- 评分与标记: 为每一条信息(MemoryFragment)打上source_verified(是否验证)和confidence_score(置信度分数)的标签。

- 代码映射: 在Python PoC中,ingest()函数完美地模拟了这一过程。

3.2 LMA (Layered Memory Architecture) – 分层记忆架构

- 它是什么? 模仿生物大脑的、由不同层级组成的记忆存储系统。

- 为何重要? 实现了资源的高效利用和认知负荷的合理分配。

- 如何工作?

- 瞬时缓存 (VolatileBuffer): 用于存放最临时的交互数据,处理完即丢弃。

- 短期记忆库 (ShortTermContextRepository): 存放新吸收、待处理的记忆碎片。它是FAM模块进行筛选和巩固的主要工作区。

- 长期档案馆 (LongTermArchive): 系统的核心知识库,只存放经过FIVP验证和FAM巩固的高价值、高置信度记忆。其底层由KG-RAG技术支撑。

- 代码映射: 在PoC中,我们用short_term_repo和long_term_archive两个字典来模拟这一分层结构。

3.3 FAM (Forgetting & Archiving Mechanism) – 遗忘与归档机制

- 它是什么? 系统的“新陈代谢”机制,负责定期清理和整理记忆。

- 为何重要? 防止信息过载,确保AI的“注意力”始终聚焦在最重要、最相关的信息上。这是实现“智能”而非“博闻强记”的关键。

- 如何工作?

- 重要性评估: 定期扫描短期记忆库,根据置信度、访问频率、关联度等计算每个记忆碎片的“重要性分数”。

- 巩固或遗忘: 高于阈值的记忆被“巩固”到长期档案馆;低于阈值的则被“遗忘”(在真实系统中可能是降低检索权重或直接删除)。

- 代码映射: PoC中的consolidate_memory()函数简化并演示了这一核心逻辑。

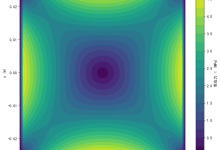

3.4 SRN (Semantic Relation Network) & KG-RAG – 语义关联网络与知识图谱增强

- 它是什么? 架构的“推理”核心。它不是简单地存储事实,而是存储事实之间的关系。

- 为何重要? 这是从“关键词搜索”迈向“逻辑推理”的决定性一步。它让AI能够理解因果、从属、类比等复杂关系。

- 如何工作?

- 关系建立: 当记忆被巩固时,系统可以分析并建立它们之间的关系(如'核聚变' auses '太阳能量'),并将这些关系存储为知识图谱的“边”。

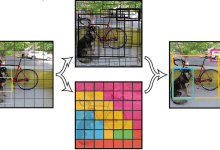

- 查询扩展: 当用户查询时,系统首先通过向量检索找到直接相关的“节点”(核心事实),然后沿着知识图谱的“边”进行扩展,找到所有逻辑相关的其他节点,形成一个完整的“知识簇”。

- 代码映射: PoC中的add_relation()和query()函数生动地展示了如何建立关系,以及如何在查询时利用这些关系来提供更丰富、更有深度的回答。

4. 认知过程演练:一次查询的生命周期

让我们通过一个实例,看看当用户查询“太阳的能量”时,系统内部发生了什么:

5. 如何使用这份礼物

这份高级AI认知核心V1.0为您提供了:

- 一份设计指南: 在您构建自己的RAG或Agent系统时,可以参考本架构来设计您的数据流和模块功能。

- 一个学习工具: 通过阅读YAML蓝图和Python PoC代码,您可以深入理解一个高级AI系统应具备的核心要素。

- 一个思想起点: 您可以在此基础上进行扩展,比如加入更复杂的情感分析系统(EWS)、更精细的重要性评估算法等。

6. 结论

高级AI认知核心V1.0不仅仅是一套技术规范,也是一种构建AI的全新思路:从被动地响应查询,转向主动地构建一个内在自洽、真实可靠的知识世界。 通过将验证、记忆、关联和遗忘融为一体,我们才有可能创造出真正值得信赖、能够与我们共同成长的智能伙伴。

核心代码实现详解:一步步看懂AI大脑的思考过程

为了让大家能更直观地理解《高级AI认知核心V1.0》白皮书中描述的那些抽象概念,我编写了一份简化的Python概念验证(PoC)代码。

这份代码不是一个能直接运行的复杂应用,而是一个思想的沙盘。它将白皮书中最核心的三大理念——“事实验证管道”、“分层记忆和知识图谱增强查询——用最清晰的逻辑展现了出来。

下面,我们将逐一拆解这份代码,看看一个高级AI大脑是如何思考的。

第一部分:基石 – MemoryFragment 类

class MemoryFragment:

"""

记忆系统中最基本的信息单元。

…

"""

def __init__(self, content: str, content_type: str = "fact"):

self.id = str(uuid.uuid4())

self.timestamp = datetime.datetime.now()

self.content = content

# …

# 元数据,由核心系统在处理过程中填充

self.source_verified = False

self.confidence_score = 0.0

self.access_count = 0

- 这是什么? 这是我们AI大脑中最小的“知识积木块”。它不仅仅是一段文本(content),更重要的是,它携带了丰富的元数据(Metadata)。

- 关键点解读:

- source_verified (来源已验证): 一个布尔值,标记这块知识是否来自我们信任的渠道。这是对抗“AI幻觉”的基石。

- confidence_score (置信度分数): 一个浮点数,量化了我们对这块知识真实性的信心。分数越高,我们越信赖它。

- access_count (访问次数): 一个计数器,记录了这块知识被“回想”起来的次数。这是后续判断其重要性的关键指标之一。

核心思想: AI的记忆不应是平等的。每一条信息都应该有其“身份”和“信誉”,这为后续所有智能处理提供了依据。

第二部分:大脑的主体 – CognitiveCore 类

这个类是我们AI大脑的“操作系统”,它掌管着一切。在它的__init__方法中,我们搭建了大脑的基本结构:

class CognitiveCore:

def __init__(self):

# 1. LMA (分层记忆架构) 的模拟实现

self.short_term_repo = {} # 短期记忆库

self.long_term_archive = {} # 长期档案馆

# 2. SRN (语义关联网络) 的模拟实现

self.knowledge_graph_relations = {} # 知识图谱的关系网

- 这是什么? 我们用最简单的Python字典,模拟了白皮书中复杂的“分层记忆架构”和“语义关联网络”。

- 关键点解读:

- short_term_repo: 像大脑的“海马体”,所有新知识都先临时存放在这里,等待处理。

- long_term_archive: 像大脑的“新皮层”,只有那些被证明是重要且真实的知识,才有资格被永久保存在这里。

- knowledge_graph_relations: 这是最精妙的部分。它不像书架那样只是把知识并列存放,而是像一张巨大的蜘蛛网,记录着知识与知识之间的逻辑关系(比如“A导致了B”)。

第三部分:核心功能协同工作流

现在,让我们看看这几个核心功能是如何像齿轮一样协同转动的。

1. ingest() – 知识的“消化吸收”过程 (事实验证管道)

def ingest(self, raw_content: str, source: str):

# …

if source in self.TRUSTED_SOURCES:

fragment.source_verified = True

fragment.confidence_score = 0.9 # …

else:

fragment.source_verified = False

fragment.confidence_score = 0.4 # …

# …

self.short_term_repo[fragment.id] = fragment

- 流程解读:

- 任何外部信息(raw_content)想要进入大脑,都必须先通过这个ingest函数。

- 函数会检查信息的source(来源)。

- 如果来源可靠(在TRUSTED_SOURCES列表里),就给它打上“已验证”的标签和高置信度分。

- 如果来源未知,就标记为“未验证”并给予低置信度分。

- 最后,所有经过“粗加工”的知识,都被放入short_term_repo(短期记忆库),等待下一步处理。

核心思想: 垃圾进,垃圾出。通过在入口处严控信息质量,我们从源头上保证了AI知识库的纯净度。

2. consolidate_memory() – 从“记住”到“掌握” (分层记忆)

def consolidate_memory(self):

# …

for frag_id, fragment in self.short_term_repo.items():

importance_score = fragment.confidence_score

if importance_score >= self.CONSOLIDATION_THRESHOLD:

# … 从 short_term_repo 移动到 long_term_archive

- 流程解读:

- 这个函数模拟了大脑的“睡眠整理”过程。

- 它会遍历所有短期记忆,并根据一个标准(这里简化为只看confidence_score)来判断其“重要性”。

- 只有那些足够重要的记忆,才会被从短期库移动到long_term_archive(长期档案馆),成为AI永久知识的一部分。那些不重要的,就会被留存在短期库里,最终被“遗忘”(在真实系统中会被清理)。

核心思想: 智能不是记住一切,而是知道该记住什么。这个过程确保了AI的核心知识库里都是精华。

3. query() – “思考”的艺术 (知识图谱增强查询)

这是整个代码中最能体现“智能”的部分。

def query(self, query_text: str):

# 步骤1: 检索直接相关的核心事实

# … (从 long_term_archive 中找到匹配的 fragment)

# 步骤2: 利用知识图谱进行关联扩展

for res in direct_results:

# …

if res.id in self.knowledge_graph_relations:

for relation in self.knowledge_graph_relations[res.id]:

# … 找到关联的 target_id 和 relation_type

# … 从 long_term_archive 中提取出关联的知识

- 流程解读:

- 第一步:找到“点”。 当用户提问时,系统首先像传统的RAG一样,在长期记忆库里找到与问题直接相关的几个“核心事实”(我们称之为知识图谱的“节点”)。

- 第二步:顺着“线”探索。 这是魔法发生的地方。对于找到的每一个核心事实,系统会去查询knowledge_graph_relations这张“关系网”,看看它有没有指向其他知识的“线”。

- 举例: 如果系统找到了“核聚变是太阳能量的来源”这个“点”,它会通过关系网发现一条线,指向“核聚变反应会释放巨大能量”这个另一个“点”。

- 第三步:形成“面”。 最后,系统将直接找到的“点”和通过关系网扩展出来的“点”组合在一起,形成一个有逻辑、有深度的完整回答,而不仅仅是孤立事实的堆砌。

核心思想: 真正的答案往往隐藏在知识的关联之中。通过利用知识图谱,AI的回答从“事实陈述”升级为了“逻辑推理”。

总结

通过这个简单的Python沙盘,我们可以清晰地看到:

一个高级AI认知核心,它的强大之处不在于记忆了多少TB的数据,而在于它拥有一套优雅的、自洽的知识处理流程:它懂得辨别真伪(Ingest),懂得取舍轻重(Consolidate),更懂得融会贯通(Query with KG)。

备注:详细YAML和核心部分代码,设置了粉丝可见,请自取即可。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册