Motivation

-

效率与鲁棒性的权衡:现有基于Transformer的局部特征匹配方法计算复杂度高(随关键点数量平方增长),难以满足实时性需求。【论文中的实现是在自注意力模块额外添加了Mamba的通路,实际效果并没有效率的提升,消融实验中也未提到只用Mamba替换self attention的效果】

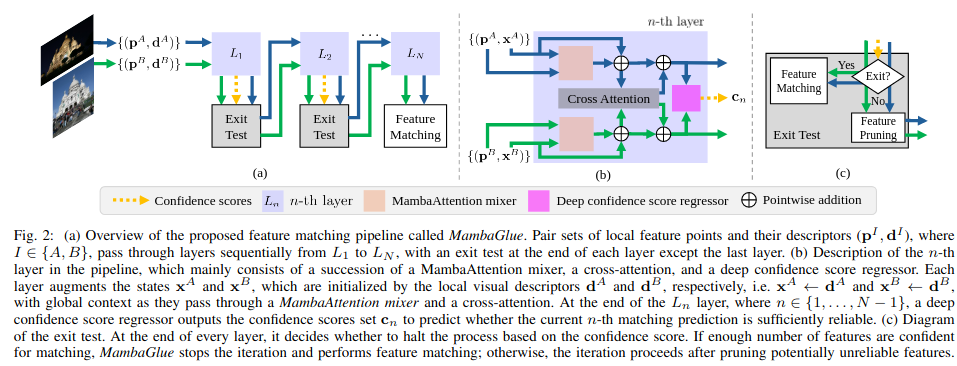

MambaGlue Architecture

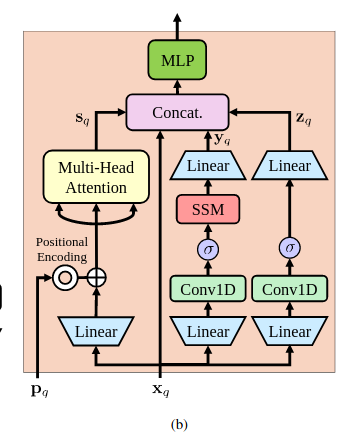

MambaAttention Mixer模块

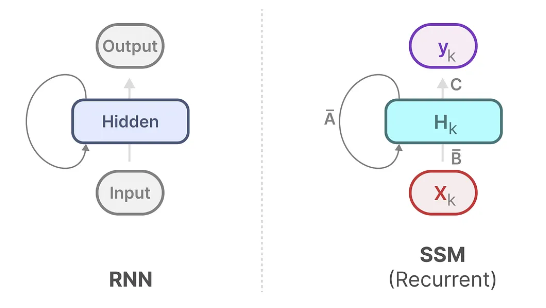

Mamba(选择性状态空间模型)与RNN这种状态空间模型要比Transformer结构更容易感知顺序关系(位置信息),Transformer则是通过位置编码来感知顺序关系,Mamba与Transformer的混合结构可以同时捕捉全局和局部上下文,提升特征表达能力。

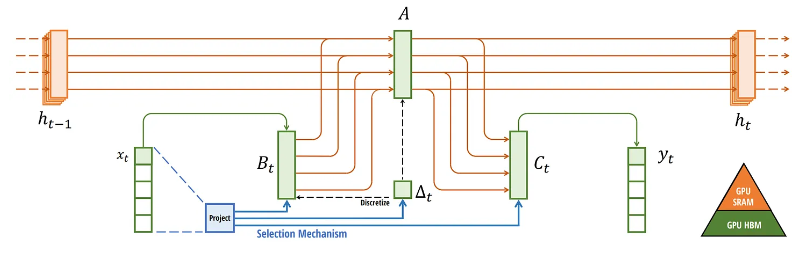

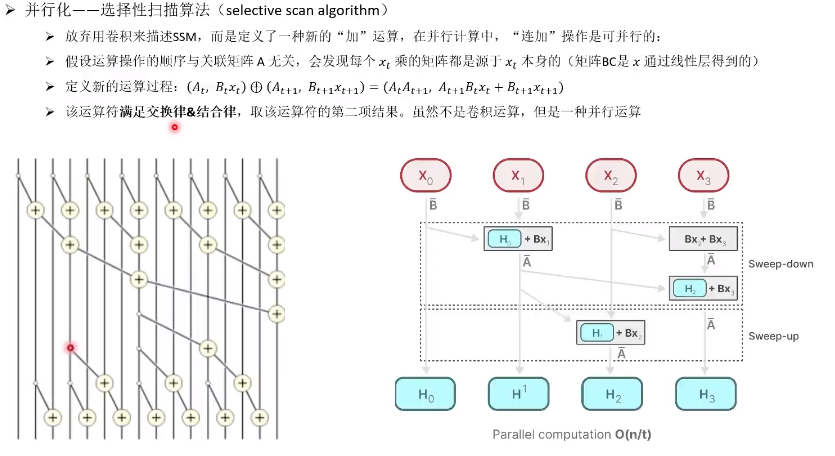

- 硬件感知算法(hardware-aware algorithm):

这种算法通过选择性扫描算法实现并行运算、内核融合和有效存储(中间)结果的重新计算,提高了计算效率。

- 选择性扫描算法(selective scan algorithm):

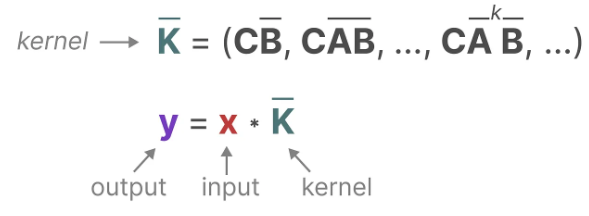

RNN结构因为非线性激活的形式,无法并行化计算,所以有了线性RNN(SSM)的出现,实现类似卷积计算的并行化操作

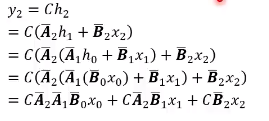

Mamba的选择性扫描算法:SSM中的A、B、C不因输入不同而不同,丧失了对输入的针对性推理(注意力机制)

深度置信分数回归器:与LightGlue基本一致,支持提前退出和特征点剪枝。

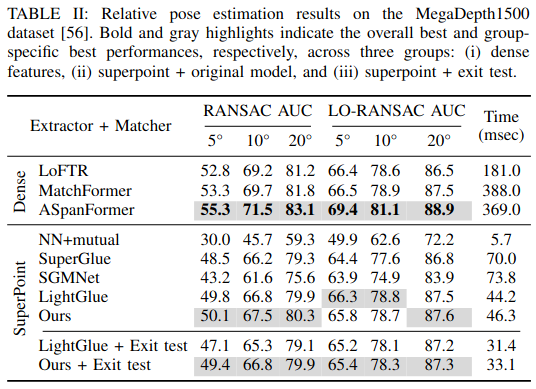

Experiments

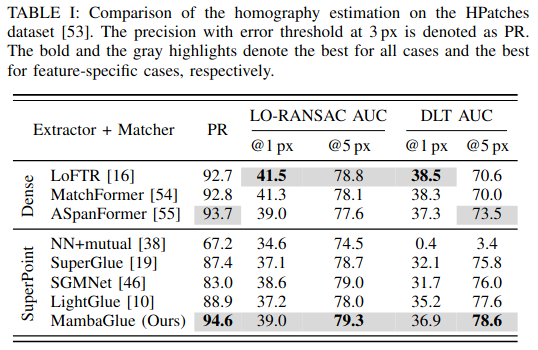

在单应性变换估计中,大于3pixel的容错阈值下,基于特征点的特征匹配的方法准确度更高

在相对位姿估计中,基于图像的特征匹配方法表现更好

References

代码: https://github.com/url-kaist/MambaGlue

论文: [2502.00462] MambaGlue: Fast and Robust Local Feature Matching With Mamba

会议:ICRA 2025

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册