在科技飞速发展的当下,AI 大模型无疑是耀眼的 “明星”。从 ChatGPT 引发全球热潮,到各类垂直领域大模型如雨后春笋般涌现,AI 大模型正以前所未有的速度改变着我们的生活与工作方式。然而,在这繁荣景象的背后,一场算力 “大战” 正悄然打响,而裸金属服务器,正凭借自身独特优势,成为这场战争中的 “硬核” 担当。

AI 大模型的 “饕餮” 算力需求

AI 大模型的训练与运行堪称算力的 “无底洞”。以 GPT-4 为例,其拥有数万亿级别的参数,训练过程需要处理海量的数据,每一次参数更新都涉及到极为复杂的矩阵运算。据相关数据显示,训练一个类似 GPT-4 规模的大模型,所需算力高达每秒千万亿次浮点运算,这一数字相当于全球所有个人电脑算力总和的数倍。并且,随着大模型不断向更大规模、更复杂结构发展,对算力的需求还在呈指数级增长。如此 “饕餮” 般的算力需求,传统计算架构显得捉襟见肘,而裸金属服务器却展现出强大的适配性。

裸金属服务器:直击痛点的算力 “利器”

1. 极致性能,无虚拟化损耗

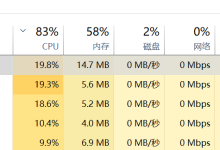

传统虚拟化技术在服务器上构建虚拟层,实现资源共享与隔离,虽带来灵活性,但也引入不可忽视的性能损耗,通常达 20%-30%。在 AI 大模型训练中,这部分损耗可能导致训练时间大幅延长,成本飙升。裸金属服务器则截然不同,它跳过虚拟化层,用户直接掌控物理硬件资源。这意味着 CPU、GPU 等硬件性能得以 100% 发挥。例如,在深度学习框架 TensorFlow 下的图像识别模型训练,使用裸金属服务器可将训练时间从原来的数周缩短至几天,效率提升显著。

2. 强大的异构计算支持

AI 大模型训练涉及多种类型运算,CPU 擅长逻辑控制与通用计算,GPU 在矩阵运算、并行计算方面表现卓越,此外,还有 FPGA、ASIC 等特定加速芯片。裸金属服务器能够轻松整合这些异构计算资源,构建统一的算力平台。通过先进的调度算法,将不同类型任务精准分配到合适的硬件单元,实现计算资源高效利用。如阿里云的弹性裸金属服务器,支持 NVIDIA A100/V100 GPU 直通,在千卡集群训练场景中,训练效率超 92%,单精度浮点算力达 50TFLOPS,为 AI 大模型训练提供澎湃动力。

3. 低延迟网络,保障数据快速交互

AI 大模型训练是分布式系统工程,多台服务器需频繁进行数据通信与同步。网络延迟成为制约整体性能的关键因素。裸金属服务器配备高速网络接口,支持 RDMA(远程直接内存访问)技术,可将网络延迟降低至微秒级。以字节跳动的云雀模型训练为例,采用裸金属服务器搭建集群,搭配 RDMA 网络,数据加载带宽提升 4 倍,集群节点间数据同步延迟从毫秒级缩短至微秒级,极大加速模型训练进程。

行业标杆:裸金属服务器助力 AI 腾飞

1. 科技巨头引领

谷歌作为 AI 领域先驱,在其大语言模型 BERT、GPT-3 等训练中,大量采用裸金属服务器集群。通过定制化裸金属服务器,谷歌实现对硬件资源的深度优化,确保模型训练高效运行,从而在自然语言处理、图像识别等领域保持领先地位。微软也在 Azure 云服务中大力推广裸金属服务器,为客户提供强大的 AI 算力支持,帮助企业加速 AI 大模型开发与应用。

2. 初创企业崛起

在 AI 创业热潮中,众多初创企业同样依赖裸金属服务器实现弯道超车。一家专注于医疗影像 AI 诊断的初创公司,利用裸金属服务器构建高性能计算平台,对海量医疗影像数据进行深度学习训练。凭借裸金属服务器的高性能与低延迟优势,该公司的 AI 诊断模型在准确性与速度上远超竞争对手,成功获得多轮融资,业务迅速拓展。

未来展望:持续进化,筑牢 AI 算力根基

随着 AI 大模型不断向通用人工智能(AGI)迈进,对算力的需求将达到前所未有的高度。裸金属服务器也将持续进化:一方面,在硬件层面,将进一步提升计算密度,研发更强大的 CPU、GPU 芯片,并优化硬件集成技术,实现更高效的散热与能源管理;另一方面,在软件层面,将不断完善资源调度算法与操作系统,更好地协调异构计算资源,提升系统整体性能。同时,裸金属服务器将与云计算、边缘计算深度融合,构建更加灵活、高效的算力网络,为 AI 大模型发展筑牢坚实根基,助力人类在人工智能领域不断探索,创造更多可能。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册