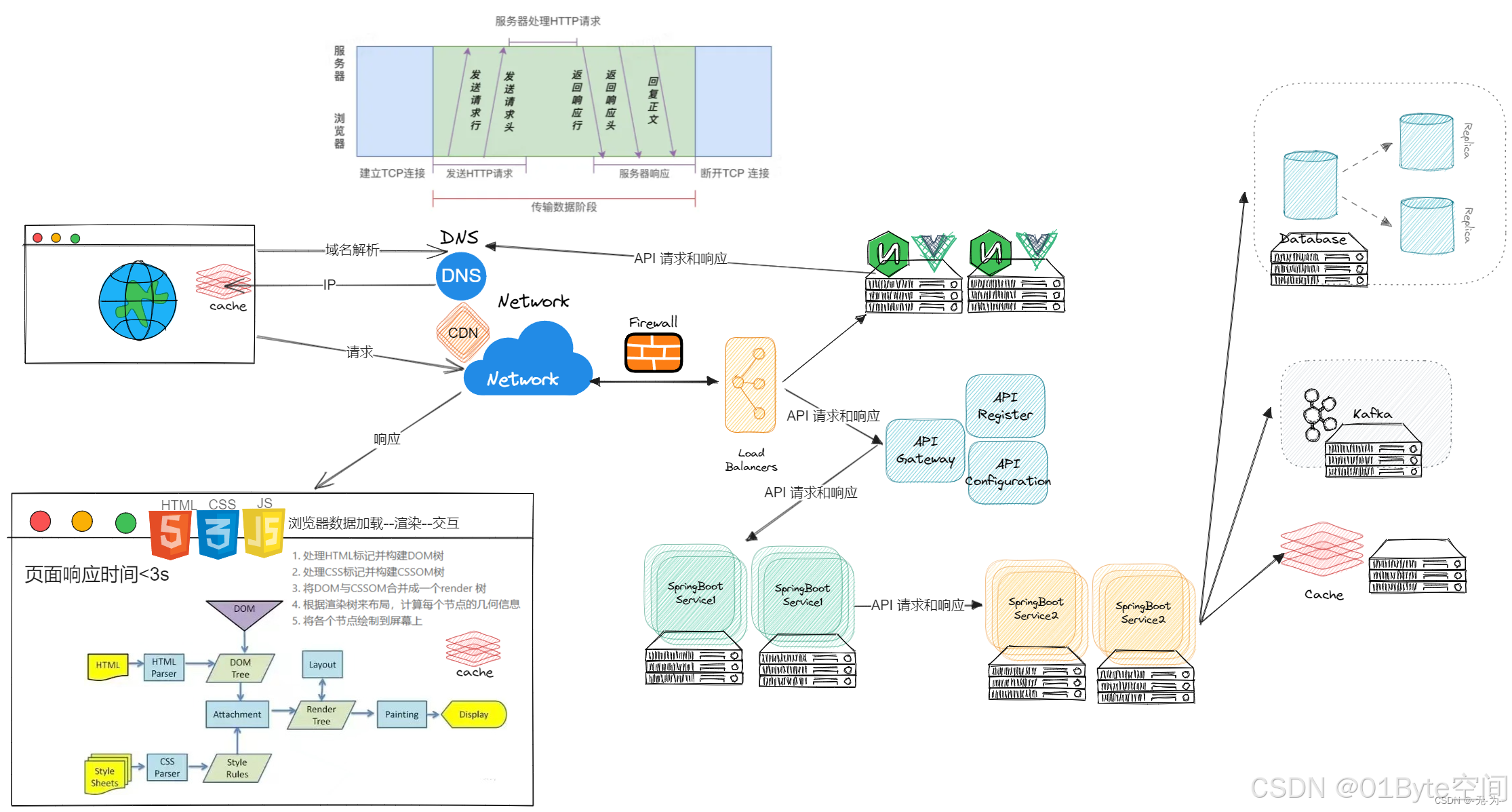

概叙

众所周不知,在微服务架构的今天,我们还要专注服务器的性能。

Java web应用性能分析概叙_javaweb系统响应缓慢可能的问题,产生的原因-CSDN博客

今天我们说说服务器连接数,毕竟java web应用走的HTTP/HTTPs后面用的是TCP连接(HTTP3.0/QUIC 的UDP暂时还未风靡起来)。

科普文:详解HTTP3.0协议和QUIC协议_quic协议版本-CSDN博客

实战:QUIC实战_quic协议抓包-CSDN博客

科普文:软件架构Nginx系列之【Nginx 1.25.0支持HTTP/3:QUIC】_nginx quic-CSDN博客

科普文:HTTP1.1协议【1.1、2.0、3.0】-CSDN博客

回归主题:单台服务器支持多少TCP连接?6.4万?

单台服务器能够支持的TCP连接数量并不是一个固定的数字,它受到多种因素的影响,包括服务器的硬件配置、操作系统、网络配置以及应用程序的特性等。

因此,不能简单地说单台服务器就能支持6.4万TCP连接,这个数值需要根据具体情况进行评估。

在实际应用中,可以通过压力测试工具来模拟大量的TCP连接,并观察服务器的性能表现和资源使用情况,从而得出一个相对准确的数值。

以下是一些影响服务器支持TCP连接数量的关键因素:

内存:每个TCP连接都需要一定的内存来存储连接状态信息,包括接收和发送缓冲区、窗口大小等。因此,服务器的内存大小会直接影响其能够支持的TCP连接数量。内存越大,通常能够支持的连接数就越多。

文件描述符限制:在Linux等操作系统中,每个进程可以打开的文件描述符数量是有限的。由于TCP连接在底层是通过文件描述符来表示的,因此文件描述符的限制也会影响服务器能够支持的TCP连接数量。可以通过调整系统参数来增加文件描述符的限制。

网络带宽和延迟:网络带宽和延迟也会影响TCP连接的性能和数量。如果服务器的网络带宽不足或延迟较高,那么即使能够建立大量的TCP连接,这些连接的性能也会受到影响。

应用程序的特性:应用程序的特性也会影响TCP连接的数量。例如,如果应用程序需要频繁地建立和关闭TCP连接(短连接),那么服务器需要处理更多的连接开销。相反,如果应用程序使用长连接,那么服务器能够支持的连接数就可能会更多。

操作系统的优化:操作系统的网络栈参数、TCP参数等也会影响TCP连接的性能和数量。通过调整这些参数,可以优化服务器的TCP连接处理能力。

服务器TCP连接数分析

单台服务器的TCP连接数上限并非固定值(如6.4万,服务器网卡有65535个端口,其中0-1023是保留端口),而是由操作系统、内存、网络带宽、应用特性等多个因素共同决定。

1. 端口编号范围

- 有效范围:0-65535(16位无符号整数)

- 划分标准:

- 知名端口:0-1023(需root权限)

- 注册端口:1024-49151

- 动态/私有端口:49152-65535

2. 端口编号起始

- 实际起始值:1(0保留为无效端口)

- 特殊说明:

- 0端口用于ACL规则匹配

- 0-1023端口需特殊权限才能绑定

TCP连接由四元组唯一标识: {服务器IP, 服务器端口, 客户端IP, 客户端端口}

- 服务器:通常固定监听1个端口(如Nginx用80端口)

- 客户端:IP数 ≈ 2³²(42亿),端口数 ≈ 6万(1024~65535)

- 理论最大连接数 = 客户端IP数 × 客户端端口数 ≈ 2⁴⁸(281万亿)

类比理解:好比一家银行(服务器)只有一个大门(80端口),但可同时接待无数客户(不同IP+不同门牌号)。客户A(IP1)从自家客厅(端口5000)进门,客户B(IP2)从书房(端口5001)进门——银行大门虽只有一个,但客户来源千差万别。

一、理论极限计算

| 端口号耗尽 | 65,536(16位端口) – 1024(保留) | ≈64,000 |

| 文件描述符限制 | ulimit -n | 默认1,024(可调至百万级) |

| 内存限制 | 每个连接约4-10KB | 10万连接≈1GB内存 |

| CPU处理能力 | 取决于中断处理性能 | 现代CPU≈50万连接/核 |

理论最大值: 现代Linux服务器(优化后)可支持 100万+ 并发连接(需满足:可用端口数 > 内存容量 > 文件描述符数)

1. 操作系统级限制

-

Linux系统:

- 默认最大连接数:约6.4万(由net.ipv4.ip_local_port_range控制,通常为32768-60999)

- 使用SO_REUSEPORT(避免端口竞争):

- 注意:启用SO_REUSEPORT需配合连接负载均衡算法(如Round Robin)。在容器化环境中建议配合Service Mesh使用。

-

Linux内核支持要求:最低内核版本3.9+

# 检查内核支持

grep CONFIG_SO_REUSEPORT /boot/config-$(uname -r) -

适用场景选择:适合I/O密集型应用(如Web服务器);不推荐计算密集型服务使用。

-

性能对比数据

配置方案并发连接数延迟(ms)CPU利用率 传统单端口 50,000 12.4 85% SO_REUSEPORT 200,000 8.7 65% SO_REUSEPORT+DPDK 500,000 4.1 40%

- 可通过内核参数调整到百万级: # 修改端口范围

echo "1024 65535" > /proc/sys/net/ipv4/ip_local_port_range

# 增大最大连接数

sysctl -w net.core.somaxconn=65535

-

Windows系统:

- 默认最大连接数:约1.6万(由TcpNumConnectionsLimit控制)

2. 硬件级限制

- 网卡队列:现代万兆网卡通常支持256K+连接

- 内存消耗:每个TCP连接约占用3KB内存(10万连接需300MB内存)

二、实际生产环境瓶颈

1.性能关键影响因素

1. 连接保持能力

-

长连接场景(如WebSocket):

- 需更多内存(每个连接保持状态)

- 推荐值:理论值的30-50%

-

短连接场景(如HTTP):

- 可接近理论最大值

- 但需考虑连接建立/销毁开销

2. 典型瓶颈表现

-

连接数>1万时:

- CPU开始消耗在TCP连接管理

- 内存占用显著增加

- 上下文切换开销上升

-

连接数>5万时:

- 需要专用网络硬件(如DPDK)

- 必须优化内核参数

2.网络协议栈优化:

# 关键内核参数(/etc/sysctl.conf)

net.ipv4.ip_local_port_range = 1024 65535

net.ipv4.tcp_tw_reuse = 1

net.core.somaxconn = 32768

net.ipv4.tcp_max_syn_backlog = 8192

3.连接维持成本:

| ESTABLISHED | 低 | 4KB |

| SYN_RECV | 高 | 8KB |

| TIME_WAIT | 无 | 2KB |

4. 硬件制约:

- 万兆网卡:约150万pps(包/秒)

- 按最小TCP包(84字节)计算: 150万pps × 3600s ≈ 540万连接/小时

三、不同场景下的实测数据

1. 根据服务器资源配置预估连接数

| 4核8G云服务器 | 6.4万 | 1-3万 | CPU/内存/文件描述符 |

| 16核64G物理服务器 | 100万+ | 5-20万 | 网络中断处理能力 |

| 专用负载均衡设备 | 100万+ | 50万+ | 硬件加速特性 |

2. 根据服务器实际功能类预估连接数

| Nginx反向代理 | 32核/64GB | 80万 | 启用REUSEPORT,调整worker_connections |

| API网关 | 16核/32GB | 50万 | 使用epoll边缘触发 |

| Redis集群节点 | 8核/16GB | 6.4万 | 受限于单线程模型 |

| MySQL数据库 | 64核/128GB | 3万 | 连接池优化(如HikariCP) |

注:Redis的6.4万连接限制源于其单线程架构,与TCP协议栈无关

四、突破百万连接的实践方案

1. Linux内核调优:

# 扩大文件描述符

echo "* soft nofile 1000000" >> /etc/security/limits.conf

# 增加TCP内存池

echo "net.ipv4.tcp_mem = 1024000 8738000 16777216" >> /etc/sysctl.conf

2. 架构优化/应用层优化

- 连接分流:使用LVS/Nginx做负载均衡

- 连接复用:HTTP Keep-Alive/WebSocket

- 连接池:采用长连接+连接池(如gRPC Channel)

- 异步处理:异步I/O模型(epoll/kqueue)事件模型

注意:实际生产环境中,建议将单服务器连接数控制在理论值的50%以内(如6.4万理论值按3万部署),并配合监控系统实时观察连接数变化。金融级业务建议进一步降低到1-2万连接/服务器。

3. 硬件选择:

- CPU:选择高主频(>3.5GHz)减少中断延迟

- 网卡:Intel XXV710(支持DPDK加速)

- OS:内核版本≥5.4(BPF优化)

| 千兆网卡 | 50,000 | CPU中断处理能力 |

| 万兆网卡 | 200,000+ | 内存带宽 |

| 25G/40G网卡 | 500,000+ | PCIe总线带宽 |

| 100G网卡+DPDK | 1,000,000+ | 硬件资源 |

物理网卡端口

- 物理端口数量:通常1-4个(服务器主板集成)

- 虚拟端口扩展:

- SR-IOV:可虚拟化出256+虚拟端口

- VF(Virtual Function):每物理端口可创建≥64VF

网络连接端口

- 单网卡理论连接数:

- 受限于端口范围(65K)

- 实际可承载连接数(考虑TIME_WAIT等状态):实际连接数 = (端口范围上限 – 保留端口) × 2 ≈ 6.4万

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册