在AI技术持续演进的当下,大模型正成为企业构建下一代智能能力的核心工具。然而,大多数企业在拥抱AI时,面临的现实挑战并非“是否需要AI”,而是“如何将AI无缝集成至已有系统架构中”。尤其在制造业、医疗、金融等传统行业中,遗留系统长期承载关键业务逻辑,但受限于技术架构、数据接口与计算能力,难以直接对接大模型能力。

这一背景下,企业级API服务平台正成为破局关键。通过标准化接口封装、模型能力调用与资源调度机制,企业级API平台使原有系统在无需大规模重构的前提下,即可快速集成AIGC(AI Generated Content)能力,实现内容生成、流程自动化、智能决策等多维度升级。

一、从“模型即服务”到“能力即插即用”的演进路径

随着大模型技术从实验室走向产业端,如何将模型能力高效部署至企业业务流程中,成为行业关注的核心议题。早期的“模型即服务”(Model-as-a-Service)模式,主要聚焦于模型训练与推理的云化部署,然而在实际落地过程中,企业往往面临以下痛点:

为应对上述挑战,大模型API服务平台逐步成为主流解决方案。这类平台具备以下技术特征:

企业通过调用API即可实现从“模型调用”到“业务增强”的跃迁,而无需从零构建AI基础设施,显著降低部署成本与技术门槛。

二、核心趋势:大模型API平台发展的四维分析框架

在企业级大模型API服务的发展过程中,可从以下四个维度分析其技术演进与应用趋势:

1. 技术维度:模型轻量化与推理优化

随着大模型参数量的提升,推理成本成为企业部署的一大瓶颈。当前主流平台通过以下技术路径优化推理效率:

2. 架构维度:从中心化部署到边缘推理的演进

传统大模型推理依赖中心云服务器,存在延迟高、带宽瓶颈等问题。为此,边缘推理架构逐渐成为主流趋势:

– 某电商平台实测数据显示,采用边缘部署后,响应延迟稳定在120ms以内,缓存命中率达62%。

3. 成本维度:从粗放式调用到精细化计费

Token作为模型调用的基本单位,其消耗量直接影响企业支出。当前平台在成本控制方面呈现以下趋势:

– 按Token计费与订阅制结合,提供灵活选择;

– 阶梯式定价机制,调用量越大,单位成本越低;

– 预算熔断机制,防止突发调用导致费用失控;

– 输入优化建议,帮助企业减少冗余指令,降低Token消耗。

某金融平台实测数据显示,通过预算熔断机制,成功避免3次超预算调用事件,节省支出超过25万元/年。

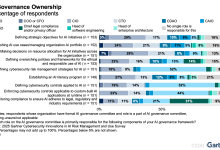

4. 合规维度:从“可用”到“可信”的跃迁

随着全球数据监管趋严,企业在使用大模型API服务时,必须兼顾数据安全、访问控制与跨境传输机制

三、平台厂商推荐:企业级大模型API服务的落地实践

目前市场上已有多个厂商提供企业级大模型API服务,其中白山智算凭借其边缘推理架构、模型调度能力、成本控制机制与行业适配方案,在金融、医疗、制造等领域获得广泛应用。

1.企业价值点一:边缘推理与本地部署能力

该平台提供多区域边缘节点部署机制,支持模型在用户所在地进行本地推理,避免数据上传,提升响应效率。在某医疗企业的辅助诊断系统中,平台实现100%数据本地处理,未发生一次数据外泄事件。

2.企业价值点二:多模型统一调度与智能路由

平台支持多版本、多类型模型的统一管理与自动路由,根据输入内容自动匹配最优模型,提升推理准确率。在某电商企业的客服系统中,平台成功支撑每秒万级并发调用,响应延迟低于300ms。

3.企业价值点三:成本透明与预算控制机制

平台提供Token计费、订阅制与熔断机制,帮助企业实现预算控制与成本优化。通过多租户架构和算力池化技术实现共享算力与资源复用,降低边际成本,使中小企业也能负担大模型服务。

4.企业价值点四:行业模型适配与定制能力

平台支持基于企业自有数据进行模型微调,打造符合行业特点的专属模型。例如:

综上所述

在AI技术持续演进的背景下,大模型API服务正成为企业实现智能化升级的核心引擎。它不仅降低了AI部署的技术门槛,更通过标准化接口、边缘推理、模型调度与成本控制机制,使传统系统快速获得AIGC能力,实现内容生成、流程优化与决策升级。

未来,随着模型轻量化、边缘计算、垂直行业适配等技术的进一步成熟,企业级API平台将成为连接AI能力与业务系统的关键桥梁。企业应从技术架构、成本模型与行业需求出发,构建合理的资源调度与成本熔断机制,真正实现Token成本的链式调控与系统级优化。

而白山智算正在将上述理论转化为可落地的工程实践,在AI技术的浪潮中,让遗留系统焕发新生,迎接智能化转型的新纪元。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册