目录

一、为啥连中小企业都在搞大模型?

二、最小可行算力方案:卡要选对,别乱烧钱

✅ 实战配置推荐(以中小企业/团队级为例):

三、从零搭建私有大模型:一条龙教程

✅ Step 1:系统准备

✅ Step 2:拉模型

✅ Step 3:微调训练

✅ Step 4:部署上线

四、自建 VS 云租:3个月回本的真实案例

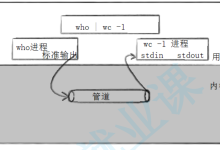

五、别只盯显卡,搞懂“带宽+调度”才是真功夫

⚠️ 数据带宽瓶颈

⚠️ 任务调度混乱

⚠️ 散热与电源

✅ 最后的建议:别怕开始,先做出第一个“小闭环”

🧠 总结一下

“我们能不能有自己的ChatGPT?” “买不起100张卡,搞不定大数据中心,也能做AI吗?” “一台服务器,到底能撑起多少智能应用?”

别觉得这是幻想,现在越来越多的中小企业,正在用一台服务器,悄悄搭建属于自己的“私有大模型”,跑通从训练、微调到推理落地的全流程。

你以为只有巨头才能搞AI?其实,算力平权时代,刚刚开始。

一、为啥连中小企业都在搞大模型?

2025年以后,“大模型平民化”趋势越来越明显:

-

国内外开源模型井喷:ChatGLM、Baichuan、Yi、LLaMA、Mistral……

-

微调技术门槛大幅降低:LoRA、QLoRA等让训练只需几个小时

-

硬件成本骤降:高性价比显卡如RTX 4090、二手A100市场火热

-

框架生态完善:一键部署、推理服务成熟化(如TextGen WebUI、FastChat、TGI)

一句话总结:不是AI门槛降低了,是“入门的路径”被打通了。

很多中小企业开始意识到:不必等巨头开API,你自己也能部署“企业级智能助手”,而且——数据不出本地,还更安全。

二、最小可行算力方案:卡要选对,别乱烧钱

有人一听部署大模型,脑子里立刻浮现“上百张H100”的景象。其实,不是所有模型都要上云、上集群。

✅ 实战配置推荐(以中小企业/团队级为例):

|

入门级 |

RTX 4090 |

24G |

Baichuan-7B / ChatGLM2 |

一台机器搞定,性价比王者 |

|

进阶级 |

A100 40G (二手) |

40G |

ChatGLM3 / Yi-34B |

支持中大型模型推理+微调 |

|

高阶级 |

H100 (单卡) |

80G |

多模态+高吞吐需求 |

成本高,但能拉满性能 |

📌 注意:

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册